2. 复旦大学 信息科学与工程学院, 上海 200433

2. School of Information Science and Technology, Fudan University, Shanghai 200433, China

开放科学(资源服务)标志码(OSID):

关系抽取是指从文本中发现与识别句子中已标记实体对之间的语义关系,这种语义关系常以三元组 < 头实体,关系,尾实体 > 的形式表达。关系抽取是信息抽取的关键技术,在知识图谱构建、智能问答和语义检索等方面被广泛应用。

在现有的实体关系抽取方法中,有监督方法的准确率较高,但缺点是费时费力,无法较好地完成大规模的关系抽取任务。为了能够自动获取高质量的标注数据,文献[1]提出了远程监督的方法,通过数据自动对齐远程知识库的方法解决开放域中大量无标签数据自动标注的问题。由于远程监督的关系抽取方法能够大幅减少标注成本,因此近年来受到研究者的广泛关注。

远程监督方法最大的问题在于通过知识库标注的句子往往存在噪声,如实体间存在多种关系,无法确定包含该实体对的句子具体表达哪种关系。此外,提取特征时引入的误差传播问题也会影响关系抽取的效果。针对这些问题,研究者提出多实例学习和多实例多标签学习的方法[2-3]来解决错误标注问题,并通过注意力机制对句子进行赋权。文献[4]将多实例学习与分段卷积神经网络模型(Piecewise Convolutional Neural Network,PCNN)相结合来进行远程监督的关系抽取,文献[5]在此基础上引入注意力机制,综合利用句包中所有语句的信息,为不同的句子赋予不同的权重,同时丢弃一些噪音数据,进一步提升了关系抽取模型的性能。

虽然很多关系抽取方法[6-8]都使用了注意力机制,但是这些工作所采用的注意力机制只是将每个关系当作独立的个体来看待,孤立地选取适用于每种关系的语句,没有充分利用关系之间存在的丰富关联信息。例如,在句子“我喜欢吃苹果”中,对于关系“喜欢”,此句就是高质量句子,那么相应地,可以认为对于关系“讨厌”,此句便为低质量句子。对于蕴含关联信息的关系,句子的表征也有一定的相关性。

此外,现有方法往往集中在探索句子的语义信息层面上,忽略了实体的描述信息对关系抽取效果的影响。在上述例句中,如果没有“苹果”是一种水果的信息,则很难判断该句表达的是哪种关系。在缺乏背景知识时,“苹果”可能是指电子设备,而句子并不表示关系“喜欢”。因此,实体本身的描述信息能够帮助改善关系抽取的效果。

本文提出一种结合实体描述信息的跨句包关系抽取模型(PC2SAD)。利用PCNN进行句编码,获得更多与实体相关的上下文信息。同时为减弱错误标签带来的噪声,使用跨关系跨句包注意力机制获取关系特征,弥补传统注意力机制孤立分析单个关系的不足,更好地从远程监督的噪声数据中鉴别有效的实例,从而学习到更准确的关系表示。此外,为在跨关系跨句包注意力模块中提供更好的实体表征,使用卷积神经网络(Convolutional Neural Network,CNN)从Freebase知识库与Wikipedia文本中提取实体的描述信息,补充关系抽取任务所需的背景知识。

1 相关工作实体关系抽取能够快速高效地从开放领域的文本中抽取出有效信息,是信息抽取的关键任务。现有的关系抽取方法主要分为有监督、半监督、弱监督、无监督和远程监督等方法[9-10],其中,有监督关系抽取方法和远程监督关系抽取方法是实体关系抽取的常用方法。

有监督的关系抽取旨在从大规模标注语料中获取表达实体间语义关系的有效特征,在已标注的数据基础上训练分类器,主要方法有基于规则、基于特征工程、基于核函数和基于深度模型的方法等。基于规则的方法[11-12]主要采用模板匹配的方式进行关系抽取,但是该方法依赖于专家经验,代价高且可移植性差,难以被推广使用。基于特征工程的方法[13-14]通过从句子中提取出相关词法、语法和句法信息获取有效特征。基于核函数的方法[15-16]通过构建结构树并计算关系距离以抽取关系实例,缓解了特性稀疏性问题。基于深度模型的方法能够自动学习句子特征,避免特征提取的错误传播问题,提升关系抽取的效果。虽然有监督的关系抽取方法准确率高,但是需要大量人工标注的语料,这限制了大规模的实体关系抽取。

为解决人工标注语料严重缺乏的问题,文献[1]提出一种不用人工标注的远程监督方法,其利用Freebase知识库与Wikipedia文本进行对齐,获取大量关系三元组。远程监督基于如下假设:如果已知两个实体间存在某种关系,那么所有包含这两个实体的句子都潜在地表达了该关系。因此,可以借助外部知识库将高质量的实体关系对应到大规模文本中,然后通过有监督的方法训练得到关系抽取模型。

文献[17]根据上述假设,将基于远程监督的关系抽取问题形式化为多实例单标签问题,只关注于句包体现了实体对间的哪些关系,选择使关系概率最大的实例语句作为实体对的表示,从而更契合于实际应用场景。文献[2-3]考虑到在一个实体对中可能有不止一种关系成立,在多实例学习的基础上,更进一步地将该问题形式化为多实例多标签学习问题。

文献[18]使用卷积神经网络进行关系抽取,输入句子中所有单词的词向量和位置向量,通过卷积和池化操作提取句子特征,缓解了使用自然语言处理工具进行特征提取可能导致的误差传播问题。文献[4]在卷积神经网络的基础上进一步提出PCNN模型,根据实体在句中的位置将句子分段进行池化,得到更多与实体相关的上下文信息,也有效解决了特征提取误差传播问题。PCNN虽然结合多实例学习方法提升了远程监督关系抽取的效果,但是多实例学习只给句包打标签,从包含实体对的句包的所有语句中只选择一个句子,这会导致丢失大量有用句子的信息。

文献[5]在文献[4]的基础上提出了基于注意力机制的多实例学习策略,使用关系向量作为注意力,对一个句包中的每个句子分配权重,以表示在该关系上不同句子的重要程度,并对句子向量进行加权求和得到句包嵌入向量,在此基础上直接对句包进行分类。

文献[19]提出双向长短时记忆网络来提取句子特征,同时应用注意力机制识别噪声句子。文献[20]指出句包中的假正例仍然是影响关系抽取效果的主要因素,并且识别错误标注的句子应该是决策问题而不是注意力的权重分配,在此基础上提出一种基于强化学习框架来训练关系抽取器。文献[21]提出的强化学习方法包含句子选择器和关系抽取器,句子选择器遍历句子并做出动作是否选择当前句子,关系抽取器用选择出来的句子做关系分类并给出奖励,该方法适用于句子级别的关系抽取而不是传统的包级别。

尽管远程监督关系抽取方法已经取得了显著的发展,但是仍然面临一些亟待解决的问题:首先,多数工作孤立地对每个关系建模,忽略了关系之间丰富的相关性;其次,现有的关系抽取方法只关注从文本中直接抽取实体之间的关系,忽略了实体描述所提供的有用的背景知识。为解决上述问题,本文利用关系之间丰富的相关信息减少噪音句子的影响,设计结合实体描述信息的跨关系、跨句包注意力机制,以期提高关系抽取性能。

2 跨句包关系抽取模型本文在PCNN模型基础上,提出一种结合实体描述信息的跨句包关系抽取模型PC2SAD,模型结构如图 1所示。首先利用PCNN进行句编码,提取句子中的实体关系;然后利用跨关系跨句包注意力机制获取关系特征,从而既充分利用关系的相关性,又减少知识库中未出现或者过时事实的影响,尤其减少整包句子均为噪声情况的影响;最后使用卷积神经网络模型从Freebase和Wikipedia中提取实体描述信息的特征向量,并通过增加对关系抽取模块目标函数的约束,使其接近相应的实体向量。

|

Download:

|

| 图 1 PC2SAD模型架构 Fig. 1 Architecture of PC2SAD model | |

传统的远程监督特征提取主要是利用自然语言处理工具进行数据集的特征提取,这会导致误差逐层传播,影响关系抽取的效果。本文选用PCNN模型进行句编码,根据实体所在的位置将句子切分成3段进行池化,从而得到更多与实体相关的上下文信息,以解决特征提取的误差传播问题。为方便表述模型内容,进行以下符号说明:

1) 将含有相同实体对的若干句子组成的句子集合称为句包

2) 句包

3) 对于句包

为充分获取句子的高维语义表示,解决句子特征提取的误差传播问题,PC2SAD模型利用PCNN模型将给定的句子转换成对应的特征向量,具体过程如下:

1) 对于句子

2) 对输入的

| $ {\boldsymbol{q}}_{i}={\boldsymbol{x}}_{i-l+1:i},1\le i\le n+l-1 $ | (1) |

卷积层的第

| $ {\boldsymbol{p}}_{i}=\left[f\right({\boldsymbol{x}}_{q}+\boldsymbol{b}\left)\right] $ | (2) |

其中,

经过卷积之后,传统的做法是直接进行池化操作,如最大池化,但是简单地进行最大池化并不能很好地捕捉实体词在句子中的结构信息,句法解析的准确性将会随着句长的增加而显著降低[17]。考虑到实体对在句子中存在一定的结构特征,即句包中的每个句子都被两个实体词分成三部分,利用这种内部结构信息将有助于捕捉实体间关系[4],因此,PCNN模型使用分段最大池化操作以保留更细粒度的信息,获取准确的句编码表示。

句子

| $ [{\boldsymbol{s}}_{1}{]}_{j}=\underset{1\le i\le {i}_{1}}{\mathrm{m}\mathrm{a}\mathrm{x}}[{\boldsymbol{p}}_{i}{]}_{j} $ |

| $ [{\boldsymbol{s}}_{1}{]}_{j}=\underset{{i}_{1}+1\le i\le {i}_{2}}{\mathrm{m}\mathrm{a}\mathrm{x}}[{\boldsymbol{p}}_{i}{]}_{j} $ | (3) |

| $ [{\boldsymbol{s}}_{1}{]}_{j}=\underset{{i}_{2}+1\le i\le n}{\mathrm{m}\mathrm{a}\mathrm{x}}[{\boldsymbol{p}}_{i}{]}_{j} $ |

此处,卷积层输出的结果被头实体和尾实体分成了三部分,

句子

| $ \boldsymbol{s}\text{'}=[{\boldsymbol{s}}_{1};{\boldsymbol{s}}_{2};{\boldsymbol{s}}_{3}] $ | (4) |

通过分段池化操作将低层特征组合成高层特征,能够在保留句子细粒度信息的同时,避免利用自然语言处理工具进行特征提取所导致的错误传播问题。

2.2 跨关系跨句包注意力机制在远程监督方法中,通过知识库标注的句子往往含有较多的噪声,包含实体对的许多句子可能并没有表达出该实体对的对应关系,这个问题会严重影响关系抽取的性能。本文在句编码的基础上,构建跨关系跨句包注意力机制,充分考虑和利用关系的相关性,以缓解错误标注句子对模型的影响。PC2SAD模型先利用跨关系注意力为每种关系计算句包特征,减少噪音句子或者不匹配句子的影响,再利用跨包注意力为每种关系构造一个关系包,使其能够更多地关注高质量的训练实例。

2.2.1 跨关系注意力在利用句编码将句包

| $ {S}_{i, j, k}=\frac{{\boldsymbol{s}}_{i, j}^{\mathrm{\text{'}}}\cdot {\boldsymbol{r}}_{k}}{\left|\right|{\boldsymbol{s}}_{i, j}^{\mathrm{\text{'}}}\left|\right|\left|\right|{\boldsymbol{r}}_{k}\left|\right|} $ | (5) |

其中,

为捕捉关系间的相关性,利用贝叶斯规则计算预期的注意力权重

| $ {\beta }_{j, k}=\frac{{\alpha }_{j, k}}{\sum \limits_{\tilde{j}=1}^{{n}_{\mathrm{b}}}{\alpha }_{\tilde{j}, k}} $ | (6) |

| $ {\alpha }_{j, k}=\frac{{\mathrm{e}}^{{S}_{i, j, k}}}{\sum \limits_{\tilde{k}=1}^{{n}_{\mathrm{r}}}{\mathrm{e}}^{{S}_{i, j, \tilde{k}}}} $ | (7) |

其中,

第

| $ {\boldsymbol{b}}_{j, k}=\sum \limits_{\tilde{j}=1}^{{n}_{\mathrm{b}}}{\beta }_{\tilde{j}, k}{s}_{i, \tilde{j}} $ | (8) |

依据句子与所有关系之间的相似度来计算跨关系注意力,最终得到每个关系对应的句包特征向量。

2.2.2 跨句包注意力句子级别的注意力基于以下假定:如果两个实体间存在某种关系,那么在所有这两个实体共同出现的句子中,至少有一句表达了这种关系。然而,由于远程监督中大量数据被错误标记,句包中存在过时事实或者不存在事实等噪音数据,甚至整个句包都为噪音数据。因此,PC2SAD利用关系包将注意力集中到更高质量的训练实例上。

相同关系的句包组成的集合称为关系包,其分布式表示向量称为关系包的特征向量。对于关系包

在跨关系注意力上,PC2SAD模型捕捉句子之间的相关性,同时为每个句包构建其特征向量。PC2SAD模型利用注意力机制将这些特征向量组合在一起。

关系包

| $ \boldsymbol{f}=\sum \limits_{i=1}^{{n}_{\mathrm{s}}}{\gamma }_{i}\cdot {\boldsymbol{b}}_{i, k} $ | (9) |

| $ {\gamma }_{i}=\frac{{\mathrm{e}}^{{S}_{({\boldsymbol{r}}_{k}, {\boldsymbol{b}}_{i}, k)}}}{\sum _\limits{j=1}^{s}{\mathrm{e}}^{{S}_{({\boldsymbol{r}}_{k}, {\boldsymbol{b}}_{j}, k)}}} $ | (10) |

其中,

多实例方法[4]只使用句包中一个句子的实例信息,未能充分利用包中的训练实例。本文提出的跨包注意力机制不仅能够解决这个问题,而且在综合利用包中所有训练实例信息的基础上,通过二次筛选和去除包中的无用信息,将关系相同的句子组合到一起,从而更好地改善远监督关系抽取的效果。

2.3 实体信息提取实体描述信息可以为句子中的实体提供丰富的背景知识。PC2SAD模型使用包含一个卷积层和一个池化层的CNN模型,从实体的描述信息中提取特征。

实体描述集合(实体,描述)定义为

在PC2SAD模型中,为使实体的向量接近描述的向量,将它们之间的误差定义为:

| $ L\left({\boldsymbol{w}}_{i}^{\mathrm{\text{'}}}\right)=\sum \limits_{i=1}^{\left|D\right|}\left|\right|{\boldsymbol{w}}_{i}^{\mathrm{\text{'}}}-{\boldsymbol{d}}_{i}|{|}_{2}^{2} $ | (11) |

基于TransE[22]思想,关系可以表示为尾实体减去头实体。例如,关系“/location/location/contains”可以表示为关系对应的实体对“Belle Harbor”与“Queens”之差:

理论上,对于同一关系,不同实体对的计算结果是相似的,并使用平均值表示关系。

实体描述信息来源于Freebase和Wikipedia,在Freebase中提取25 271个实体描述信息,在Wikipedia中提取14 257个实体描述信息。

在训练过程中,首先使用极大似然函数来训练跨关系跨句包注意力模块,然后再联合训练实体描述模块。

极大似然函数定义如下:

| $ {L}_{{\mathrm{C}}^{2}\mathrm{S}\mathrm{A}}=\sum \limits_{i=1}^{{n}_{\mathrm{s}\mathrm{b}}}\mathrm{l}\mathrm{n}\left({l}_{i}\right|{B}_{i}) $ | (12) |

其中,

联合训练的损失函数为:

| $ L={L}_{{\mathrm{C}}^{2}\mathrm{S}\mathrm{A}}+\lambda L\left({\boldsymbol{w}}_{i}^{\mathrm{\text{'}}}\right) $ | (13) |

在训练过程中采用随机梯度下降来最小化目标函数,从训练集中随机选择数据进行训练,不断迭代,直到损失函数收敛。

3 实验与结果分析为验证本文方法在缓解特征提取误差传播、减弱错误标签噪声数据影响以及补充实体背景信息方面的有效性,设计3组实验,分别从语料库、句子和句子数量层面验证PC2SAD模型的关系抽取效果。

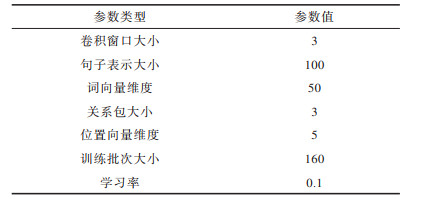

3.1 数据集和参数设置实验使用文献[2]所使用的数据集和NYT10数据集[17]。文献[2]所使用的数据集(本文中用NYT11表示)共包含395个人工标注的句子。NYT10数据集[17]共包含53种关系类型,其中,训练数据包含522 611个句子、281 270个实体对和18 252个关系事实,测试数据包含172 448个句子、96 678个实体对和1 950个关系事实。表 1列出了实验中使用的所有训练参数。

|

下载CSV 表 1 训练参数设置 Table 1 Setting of training parameters |

为证明PC2SAD模型的有效性,本文以PCNN模型作为句子编码器,在NYT10数据集上与以下模型进行比较:

1) PCNN:将PCNN作为远监督关系抽取的基线模型。

2) PCNN+ATT:以PCNN为句编码模块,结合普通注意力机制ATT,验证远监督关系抽取中注意力模块的有效性。

3) PCNN+C2SA:以PCNN为句编码模块,验证C2SA在关系抽取中的有效性。

实验采用准确率-召回率曲线对不同方法性能进行衡量,即通过对比测试集上每个句子在每个关系上概率的高低,逐一判断每个句子在该关系上的正确性,计算得到准确率-召回率曲线,如图 2所示。可以看出,PC2SAD在整个召回率范围内显著优于基于人工特征的方法,这表明人工特征无法简洁地表达句子的语义含义,同时,借助自然语言处理工具所带来的错误同样也会影响关系抽取的性能。相比之下,PC2SAD可以很好地表达关系抽取所需的句子语义信息。

|

Download:

|

| 图 2 不同关系抽取方法的准确率-召回率曲线 Fig. 2 Precision-recall curves of different relation extraction methods | |

对于PCNN+ATT模型,加入ATT方法可以使模型相比于原始的PCNN有更好的关系抽取效果,这表明加入ATT可以有效过滤对关系没有意义的句子,缓解远监督关系抽取中存在的错误标注问题。

对于PCNN+C2SA模型,图 2的准确率-召回率曲线验证了C2SA方法的有效性,这表明跨关系跨句包注意力模块对关系抽取的性能要优于普通注意力方法ATT,跨关系注意力确实能够提高实例选择的质量,而跨句包注意力对过滤知识库事实不匹配或者不存在的噪音数据也有一定的缓解效果。

对于PC2SAD模型,从图 2中可以看出,该模型的效果优于上述所有模型,这表明在PCNN作为句编码、C2SA进行实例权重选择基础上,加入实体描述信息,不仅为预测关系提供了更多的信息,同时也为注意力模块带来了更好的实体表征。

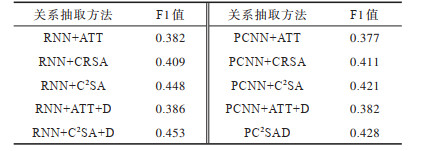

3.2.2 句子层面关系抽取方法比较为进一步验证PC2SAD中加入跨关系跨句包注意力机制和实体描述信息后整个模型在句子级关系抽取方面的性能优势,比较不同方法针对特定句子识别实体对的关系类型的性能。在文献[2]所使用的数据集上,分别以PCNN、循环神经网络(Recurrent Neural Network,RNN)为编码模块,替换普通注意力网络ATT、跨关系注意力CRSA、跨关系跨包注意力C2SA以及加入实体描述信息后的模型,以此进行实验对比,实验结果如表 2所示。

|

下载CSV 表 2 句子层面不同关系抽取算法的F1值比较 Table 2 F1 value comparison on the sentence-level relation extraction |

从表 2可以看出:

1) 以PCNN和RNN为句编码模块的关系抽取效果相当,而PC2SAD整体上优于其他模型。这一实验结果验证了实体描述信息在关系抽取任务中的有效性,其与ATT、C2SA、PCNN模型相结合后,关系抽取的效果得到了更好的提升。

2) PCNN+C2SA模型效果优于PCNN+ATT,这表明相比于ATT,C2SA不仅具备ATT已有的噪声数据权重更低的优势,更能充分利用关系的相关性,尤其是减少句包中所有句子均为噪声数据时对模型性能的影响。

3) RNN/PCNN+CRSA模型比PCNN+ATT效果要好,这表明跨关系注意力机制通过计算句子与所有关系之间的相似度,对于噪声数据或者错误标注的数据计算得到的权重会比较低,因此,可以降低错误标注的影响。而PCNN+C2SA模型的效果要更好,这表明句包中的句子有些是过时的或者是不存在的事实,跨包注意力将关系相同的句向量组合到一起,可以丢弃没有价值的信息,从而关注更高质量的训练实例。

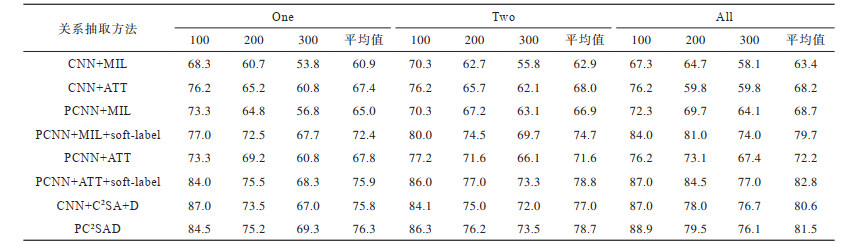

3.2.3 句子数量对关系抽取性能的影响在NYT10原始测试数据集中,有74 857个实体对仅对应于一个句子,在所有实体对上占比接近3/4。由于PC2SAD模型的优势在于能够处理包含多个句子实体对的情况,因此本文比较CNN/PCNN+MIL、采用注意力机制的CNN/PCNN+ATT和结合实体描述信息的PC2SAD在具有多个句子的实体对集合上的表现。此处,MIL是文献[4, 18]提出的多实例学习方法。

实验内容如下:

1) One:对于每个测试实体对,随机选择其对应的句子集合中的1个句子作为训练实例进行关系预测。

2) Two:对于每个测试实体对,随机选择其对应的句子集合中的2个句子作为训练实例进行关系预测。

3) All:对于每个测试实体对,选择其对应的句子集合中的所有句子作为训练实例进行关系预测。

实验结果如表 3所示,可以看出:

|

下载CSV 表 3 不同关系抽取方法的P@N值比较 Table 3 P@N value comparison for different relation extraction methods |

1) 随着实例数量的增加,所有方法的性能都会有所提高。这进一步表明,跨关系、跨句包注意力可以通过选择高质量的实例、丢弃无用实例来更好地利用句包信息。

2) 以PCNN为句编码模型要优于以CNN为句编码模型,这表明利用实体对将句子分成三部分进行分段最大池化操作是有益的。相比于CNN模型仅用单个最大池化操作,分段最大池化可以有效捕捉句子结构信息。同时加入MIL方法可以有更好的性能,这表明以PCNN为句编码模型可以一定程度缓解远监督中存在的噪音问题。加入ATT方法表明对每个句子赋予同等权重,同时也会从错误标注的数据中得到负面信息,进而损害关系抽取的性能。

3) 由于Freebase知识库不完整,导致NYT10数据集[17]中许多句子被错误标注。soft-label方法[6]是通过使用后验概率约束来校正可能不正确的句包关系类型,该方法可以从正确标注的实体对中挖掘语义信息,从而在训练过程中动态地纠正错误的标记。以PCNN为句编码模块加入MIL方法或ATT方法,再结合soft-label方法,比PCNN加入MIL方法或ATT方法效果要好,校正了错误标注后的关系抽取效果优于本就存在错误标注的NYT数据集,这表明错误标注确实影响了远监督关系抽取的效果。

4) 以PCNN为句编码模型的抽取效果优于以CNN为句编码模型的效果,这表明分段池化操作将低层特征组合成高层特征,既保留了句子中细粒度的信息,又避免了利用自然语言处理工具进行特征提取可能会导致的错误传播问题。PC2SAD模型的性能优于CNN+C2SA+D,则从整体上验证了分段池化操作在关系抽取时,考虑到句子的内部结构信息,能捕捉到更多与实体有关的上下文信息,缓解特征提取的误差传播问题。

5) PC2SAD模型的性能优势,进一步说明本文提出的模型可以充分利用实体描述所提供的有用的背景知识,有效过滤对关系抽取没有意义的句子,缓解错误标注带来的负面影响,改善关系抽取效果。

4 结束语本文研究远程监督的实体关系抽取方法,针对现有模型学习中只关注实例本身,没有关注到各个关系之间的关联信息,以及忽视实体描述信息的问题,构建结合实体描述信息的跨句包关系抽取模型PC2SAD。该模型引入跨关系跨句包注意力机制用于远程监督关系抽取,充分应用关系层次中所蕴含的相关性选择有效的实例,并进一步从Freebase与Wikipedia中提取实体的描述信息,补充关系抽取任务所需的背景知识,利用该实体描述信息支撑关系预测任务,同时为跨关系跨句包注意力模块提供更好的实体表示。在大规模基准数据集上的实验结果表明,本文模型能够充分利用实体描述所提供的背景知识过滤对关系抽取没有意义的句子,减小错误标注带来的负面影响,改善关系抽取效果。下一步将研究现有多种注意力机制的变种形式,在此基础上改进注意力模块,尝试利用强化学习进行模型训练。

| [1] |

MINTZ M, BILLS S, SNOW R, et al. Distant supervision for relation extraction without labeled data[C]//Proceedings of the Joint Conference of the 47th Annual Meeting of the ACL and the 4th International Joint Conference on Natural Language Processing of the AFNLP. New York, USA: ACM Press, 2009: 1003-1011.

|

| [2] |

HOFFMANN R, ZHANG C L, LING X, et al. Knowledge-based weak supervision for information extraction of overlapping relations[C]//Proceedings of the 49th Annual Meeting of the Association for Computational Linguistics: Human Language Technologies. [S.l.]: ACL, 2011: 541-550.

|

| [3] |

SURDEANU M, TIBSHIRANI J, NALLAPATI R, et al. Multi-instance multi-label learning for relation extraction[C]//Proceedings of 2012 Joint Conference on Empirical Methods in Natural Language Processing and Computational Natural Language Learning. New York, USA: ACM Press, 2012: 455-465.

|

| [4] |

ZENG Daojian, LIU Kang, CHEN Yubo, et al. Distant supervision for relation extraction via piecewise convolutional neural networks[C]//Proceedings of 2015 Conference on Empirical Methods in Natural Language Processing. [S.l.]: ACL, 2015: 1753-1762.

|

| [5] |

LIN Yankai, SHEN Shiqi, LIU Zhiyuan, et al. Neural relation extraction with selective attention over instances[C]//Proceedings of the 54th Annual Meeting of the Association for Computational Linguistics. [S.l.]: ACL, 2016: 2124-2133.

|

| [6] |

LIU Tianyu, WANG Kexiang, CHANG Baobao, et al. A soft-label method for noise-tolerant distantly supervised relation extraction[C]//Proceedings of 2017 Conference on Empirical Methods in Natural Language Processing. [S.l.]: ACL, 2017: 1790-1795.

|

| [7] |

HAN Xu, LIU Zhiyuan, SUN Maosong. Neural knowledge acquisition via mutual attention between knowledge graph and text[C]//Proceedings of AAAI Conference on Artificial Intelligence. [S.l.]: AAAI Press, 2018: 4832-4839.

|

| [8] |

LI Lingfeng, NIE Yuanping, HAN Weihong, et al. A multi-attention-based bidirectional long short-term memory network for relation extraction[C]//Proceedings of International Conference on Neural Information Processing. Berlin, Germany: Springer, 2017: 216-227.

|

| [9] |

E Haihong, ZHANG Wenjing, XIAO Siqi, et al. Survey of entity relationship extraction based on deep learning[J]. Journal of Software, 2019, 30(6): 1793-1818. (in Chinese) 鄂海红, 张文静, 肖思琪, 等. 深度学习实体关系抽取研究综述[J]. 软件学报, 2019, 30(6): 1793-1818. |

| [10] |

SUN Ziyang, GU Junzhong, YANG Jing. Chinese entity relation extraction method based on deep learning[J]. Computer Engineering, 2018, 44(9): 164-170. (in Chinese) 孙紫阳, 顾君忠, 杨静. 基于深度学习的中文实体关系抽取方法[J]. 计算机工程, 2018, 44(9): 164-170. |

| [11] |

MILLER S, FOX H, RAMSHAW L, et al. A novel use of statistical parsing to extract information from text[C]//Proceedings of the 1st North American Chapter of the Association for Computational Linguistics Conference. [S.l.]: ACL, 2000: 226-233.

|

| [12] |

JAYRAM T S, KRISHNAMURTHY R, RAGHAVAN S, et al. Avatar information extraction system[J]. IEEE Data Engineering Bulletin, 2006, 29(1): 40-48. |

| [13] |

JIANG Jing, ZHAI Chengxiang. A systematic exploration of the feature space for relation extraction[C]//Proceedings of Human Language Technology Conference of the North American Chapter of the Association of Computational Linguistics. [S.l.]: ACL, 2007: 113-120.

|

| [14] |

MIAO Qingliang, ZHANG Shu, ZHANG Bo, et al. Extracting and visualizing semantic relationships from Chinese biomedical text[C]//Proceedings of the 26th Pacific Asia Conference on Language, Information and Computation. Bali, Indonesia: [s. n. ], 2012: 99-107.

|

| [15] |

BUNESCU R C, MOONEY R J. A shortest path dependency kernel for relation extraction[C]//Proceedings of Conference on Human Language Technology and Empirical Methods in Natural Language Processing. New York, USA: ACM Press, 2005: 724-731.

|

| [16] |

ZHANG Min, ZHANG Jie, SU Jian, et al. A composite kernel to extract relations between entities with both flat and structured features[C]//Proceedings of the 21st International Conference on Computational Linguistics and the 44th Annual Meeting of the Association for Computational Linguistics. [S.l.]: ACL, 2006: 825-832.

|

| [17] |

RIEDEL S, YAO L M, ANDREW M. Modeling relations and their mentions without labeled text[C]//Proceedings of Joint European Conference on Machine Learning and Knowledge Discovery in Databases. New York, USA: ACM Press, 2010: 148-163.

|

| [18] |

ZENG Daojian, LIU Kang, LAI Siwei, et al. Relation classification via convolutional deep neural network[C]//Proceedings of the 25th International Conference on Computational Linguistics. Dublin, Ireland: [s. n. ], 2014: 2335-2344.

|

| [19] |

ZHOU Peng, SHI Wei, TIAN Jun, et al. Attention-based bidirectional long short-term memory networks for relation classification[C]//Proceedings of the 54th Annual Meeting of the Association for Computational Linguistics. [S.l.]: ACL, 2016: 207-212.

|

| [20] |

QIN P D, XU W R, WANG W Y. Robust distant supervision relation extraction via deep reinforcement learning[C]//Proceedings of the 56th Annual Meeting of the Association for Computational Linguistics. [S.l.]: ACL, 2018: 2137-2147.

|

| [21] |

FENG Jun, HUANG Minlie, ZHAO Li, et al. Reinforcement learning for relation classification from noisy data[C]//Proceedings of the 32nd AAAI Conference on Artificial Intelligence. [S.l.]: AAAI Press, 2018: 1-9.

|

| [22] |

BORDES A, USUNIER N, GARCIA-DURAN A, et al. Translating embeddings for modeling multi-relational data[C]//Proceedings of the 26th International Conference on Neural Information Processing Systems. New York, USA: ACM Press, 2013: 2787-2795.

|

2021, Vol. 47

2021, Vol. 47