2. 成都空御科技有限公司, 成都 610213;

3. 澳门科技大学 咨讯科技学院, 澳门 999078

2. Chengdu Sky Defence Technology Co., LTD., Chengdu 610213, China;

3. Faculty of Information Technology, Macau University of Science and Technology, Macau 999078, China

民用无人机因体型小、易操作、机动性强等特点已被广泛应用到消防、勘察、农业发展等领域, 但其也给群众隐私、公共设施和军事安全构成了巨大威胁[1]。因此, 有效的无人机检测方法对解决无人机“黑飞”问题具有重要意义。由于无人机体型小, 远处目标体现在图像中呈斑点状, 具有较少的外形信息, 且在自然场景下存在大量噪声和干扰, 如晃动的树叶和水波以及飞行的鸟类, 这些因素都给无人机检测带来巨大困难。目前, 基于可见光图像检测无人机的方法主要有深度学习方法和传统特征提取方法两大类。

深度学习方法已被广泛应用在无人机检测领域[2-3]。文献[4]利用残差网络和多尺度融合方法对原始的YOLOv3[5]网络进行优化, 提出了改进的YOLOv3网络, 实现了低空无人机的检测。文献[6]设计出具有多通道和多隐藏层的检测模型, 提取无人机图像的多尺度特征和深度信息用于无人机检测。文献[7]利用帧差法和区域生成法[8]检测移动目标, 然后运用卷积神经网络(Convolutional Neural Network, CNN)分类器识别目标图像。上述方法均要求无人机图像具有一定的外形信息, 而且基于深度学习的检测方法一般难以满足实时性要求[9]。

在图像分辨率低和目标特征不明显等情况下, 传统特征提取方法通常更适用于小目标检测。文献[10]利用全景图像实现360°全方位的小目标检测, 能够发现远处的点状无人机。文献[11]提取了图像中的天际线后, 运用图像差分法检测移动目标, 然后根据目标的运动特征和连通域信息来判别目标属性。文献[12]根据视觉注意机制, 将多特征融合成视觉显著图像, 实现了小目标无人机的检测。文献[13]通过聚类算法获取目标轨迹, 然后提取轨迹综合特征, 最后运用随机森林[14](Random Forest, RF)识别出无人机轨迹。以上方法能够检测出视频中的点状无人机, 但视频中有大量飞鸟的情况下容易产生误报。

针对无人机检测过程中易出现误报的问题, 本文根据飞鸟和无人机的轨迹和形态差异性, 提出一种基于轨迹和形态识别的无人机检测方法。

1 无人机检测追踪系统无人机检测追踪系统的硬件主要由相机、转台和无线电干扰器三部分组成, 如图 1所示。相机包含可见光镜头(帧率为25 frame/s)和红外镜头; 转台位于相机正下方, 能够联动相机追踪目标; 无线电干扰发射器位于转台两侧, 能够发射无线电波去干扰无人机信号。

|

Download:

|

| 图 1 硬件设备示意图 Fig. 1 Schematic diagram of hardware equipment | |

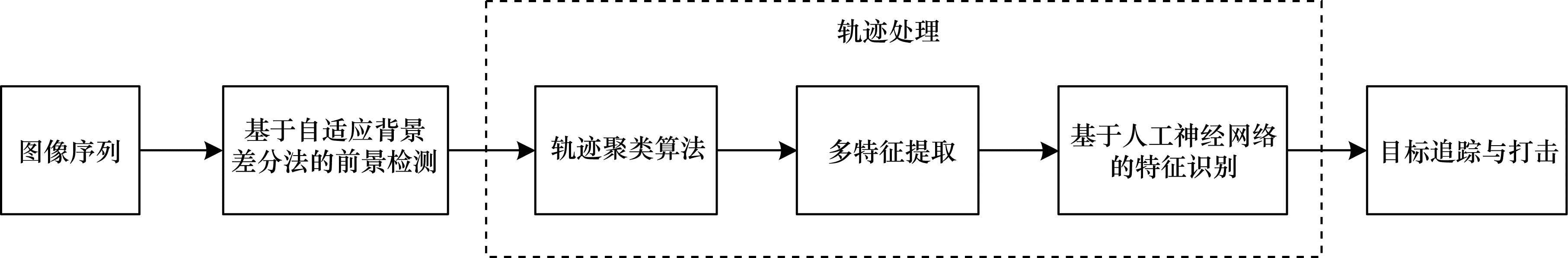

在静态背景下, 本文采用自适应背景更新算法检测移动物体, 若环境中存在物体干扰或非目标飞行物, 则该方法会在干扰物体附近和非目标飞行物处产生大量虚警。若目标图像中包含足够的细节信息, 可以运用图像识别方法[15]来排除干扰, 但是当目标图像呈点状时, 该方法并不适用。为解决上述问题, 本文提出的基于轨迹和形态识别的无人机检测方法能够有效抑制自然噪声, 并快速识别出无人机和飞鸟轨迹。首先利用自适应背景更新算法检测移动物体, 然后采用轨迹聚类算法获取潜在目标轨迹, 继而根据飞鸟和无人机飞行姿态的差异性提取轨迹特征和形态特征, 接着运用人工神经网络(Artificial Neural Network, ANN)识别目标, 最后利用小范围目标匹配算法跟踪无人机, 同时发射无线电定向干扰无人机的通信信号, 持续打击入侵无人机。系统结构如图 2所示。

|

Download:

|

| 图 2 无人机检测追踪系统结构 Fig. 2 Structure of UAV detection and tracking system | |

为加速图像处理, 本文采用自适应背景更新算法[16]检测移动物体。首先以视频前N帧图像建立平均背景模型bg, 并用bg初始化辅助背景sbg, 计算公式如式(1)所示:

| $ {\rm{bg }}(x,y) = \frac{1}{N}\sum\limits_{i = 0}^{N - 1} {{f_i}} (x,y) $ | (1) |

其中, fi(x, y)是第i帧图像(x, y)坐标处的灰度值, bg(x, y)是平均背景模型(x, y)处的灰度值, N是用于背景建模的帧数。其次当前图像f分别与bg和sbg做差, 若同时满足式(2)则为前景目标。

| $ {f_{{\rm{ dif }}}}(x,y) = \left\{ {\begin{array}{*{20}{l}} {1,}&{|f(x,y) - {\rm{bg}} (x,y)| > {\rm{ th, }}}\\ {}&{|f(x,y) - {\rm{sbg}} (x,y)| > {\rm{ ths }}}\\ {0,}&{{\rm{其他}}} \end{array}} \right. $ | (2) |

其中, fdif是差分图像, th和ths是检测阈值, 通常th < ths。最后分别用式(3)和式(4)更新sbg和bg:

| $ {\rm{sbg}}{ ^\prime }(x,y) = \left\{ {\begin{array}{*{20}{l}} {f(x,y),|f(x,y) - {\rm{bg}} (x,y)| < {\rm{ th }}}\\ { {\rm{sbg}} (x,y),{\rm{ 其他 }}} \end{array}} \right. $ | (3) |

| $ {\rm{bg}}{ ^\prime }(x,y) = (1 - \alpha ) {\rm{bg}} (x,y) + \alpha \times f(x,y) $ | (4) |

其中, α(0≤α≤1)是背景更新因子, α值越大则模型对背景变化的适应能力越强。

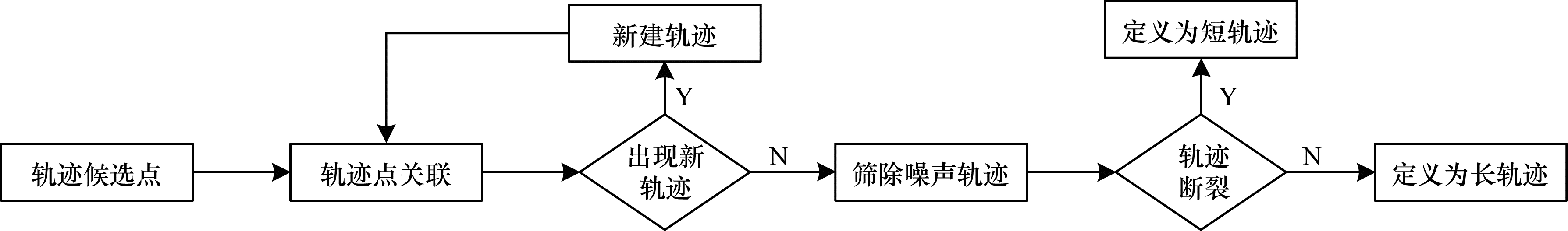

2.2 轨迹聚类算法轨迹聚类算法[17]是一种根据自然噪声与移动目标的时空特征差异性来聚合目标轨迹的算法。该算法以第1帧差分图像的所有前景检测点作为各条轨迹的起始点, 并根据一定规则把后续图像中符合条件的轨迹候选点加入轨迹序列, 然后筛除噪声轨迹, 最后获得连续的目标轨迹。

假设第n帧差分图像有若干轨迹候选点pi(i=0, 1, …, n), 且已经存在多条轨迹Ti(i=0, 1, …, n)。为加速轨迹聚类过程, 轨迹Ti仅在其搜索框Si(xi±w, yi±h)内搜索距离坐标(xi, yi)最近的候选点加入轨迹, 其中w和h分别是搜索框的宽和高。本文根据下面的3条规则完成轨迹聚类和噪声筛除, 最后获得潜在目标轨迹。

1) 无人机属于低空慢速目标, 在短时间(小于40 ms)内的位移较小, 因此本文将搜索框的宽和高均设定为3l, 其中l是轨迹段(长度为24)中两点间位移的平均值。在一次轨迹聚类过程中, 若某候选点最终未被关联到现有轨迹, 则以该候选点为起始点新建一条轨迹, 并参与下次轨迹聚类。

2) 与飞行物相比, 树枝和水波等干扰形成的噪声呈现出不规则运动, 其轨迹在水平方向上来回波动, 且轨迹段外接矩形的纵横比异于飞行物。如果轨迹段不满足条件Snum < 4或IFAR < IFARmin, 则该轨迹段为干扰轨迹, 其中Snum是轨迹段内横坐标来回波动的次数, IFAR是轨迹段外接矩形的纵横比, IFARmin是飞行物轨迹段外接矩形的最小纵横比。为增强干扰判断的鲁棒性, 本文对一条轨迹连续做10次判断, 若判断为干扰的次数超过4, 则将该轨迹从轨迹列表中删除。

3) 由于检测不稳定性和短时间遮挡等原因, 目标轨迹可能在连续多帧图像中关联不到候选点, 为增强轨迹的连续性, 本文将连续6帧没有关联到候选点的轨迹定义为短轨迹。

轨迹聚类流程如图 3所示。

|

Download:

|

| 图 3 轨迹聚类流程 Fig. 3 Procedure of trajectory clustering | |

鸟类在飞行时存在展翅动作, 而大部分无人机依靠四旋翼飞行, 由于飞行姿态的不同, 它们的飞行轨迹和形态变化存在较大差异, 因此本文从轨迹和形态两个方向提取特征。

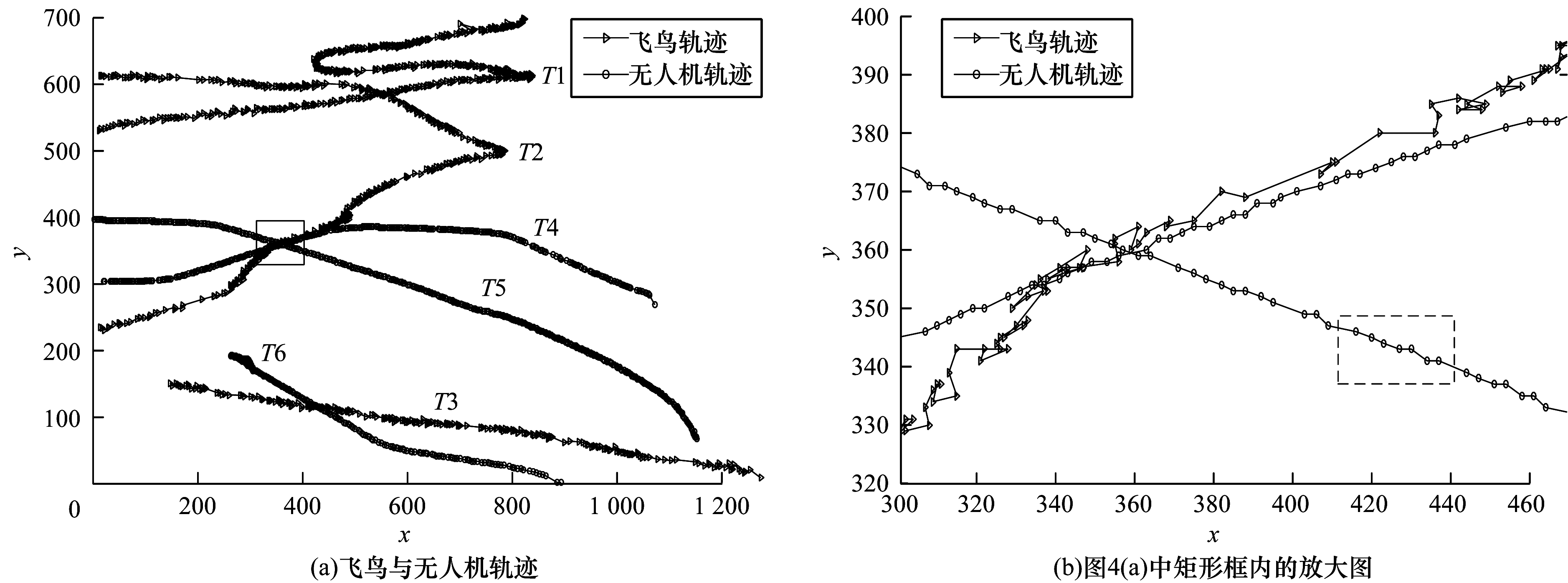

2.3.1 轨迹特征提取图 4(a)记录的是飞鸟和无人机的飞行轨迹, 其中, T1、T2、T3是飞鸟轨迹, T4、T5、T6是无人机轨迹, 图 4(b)是图 4(a)中矩形框的放大图, 圆点连线表示无人机轨迹, 三角连线表示飞鸟轨迹, 虚线框是轨迹段选取框。为加速轨迹特征提取, 本文把整条轨迹划分成若干轨迹段, 每段包含n个轨迹点, 其长度由轨迹选取框确定(见图 4(b)), 其中包含6个轨迹点。从图 4(b)可以看出, 与无人机轨迹相比, 飞鸟轨迹在水平方向(X方向)上间距分布不均, 竖直方向(Y方向)上存在较大波动, 且相邻三点构成的角度明显更加尖锐。为此, 本文根据上述3个差异性来提取轨迹特征。

|

Download:

|

| 图 4 轨迹特征提取结果 Fig. 4 Extraction results of trajectory characteristics | |

在X方向上, 特征f1和f2分别是相邻两点间水平距离的标准差和极值比:

| $ {{f_1} = \sqrt {{{({d_{{x_i}}} - \bar d)}^2}} } $ | (5) |

| $ {{f_2} = \frac{{\min ({d_{{x_i}}})}}{{\max ({d_{{x_i}}})}}} $ | (6) |

其中, i=1, 2, …, n-1, dxi=xi-xi-1是相邻两点间的水平位移, d是轨迹段内dxi的平均值。

为突出飞鸟轨迹短时间内在Y方向上的波动, 本文将长度为n的轨迹段拆分成k个长度为m的子轨迹, 然后运用最小二乘法[18]拟合子轨迹的直线方程, 最后以坐标点到拟合直线的垂直距离为基础提取Y方向特征:

| $ {{f_3} = \frac{{|\sum\limits_{j = 0}^{k - 1} {{r_j}} |}}{k}} $ | (7) |

| $ {{f_4} = \sum\limits_{j = 0}^{k - 1} {\sum\limits_{i = 0}^{m - 1} {{d_i}} } } $ | (8) |

| $ {{f_5} = \frac{1}{k}\sum\limits_{j = 0}^{k - 1} {\sum\limits_{i = 0}^{m - 1} {\frac{{{{(d_i^\prime - {\overline {d^\prime} })}^2}}}{{m - 1}}} } } $ | (9) |

其中:

| $ r = a\sqrt {\frac{{\sum\limits_{i = 0}^{m - 1} {{{({x_i} - \bar x)}^2}} }}{{\sum\limits_{i = 0}^{m - 1} {{{({y_i} - \bar y)}^2}} }}} $ | (10) |

| $ {{d_i} = \left| {\frac{{a{x_i} - {y_i} + b}}{{\sqrt {{a^2} + 1} }}} \right|} $ | (11) |

| $ {d_i^\prime = \left\{ {\begin{array}{*{20}{c}} {{d_i},a{x_i} + b \le {y_i}}\\ { - {d_i},a{x_i} + b > {y_i}} \end{array}} \right.} $ | (12) |

在式(7)~式(12)中, rj表示第j个子轨迹拟合直线的线性程度, 其绝对值越接近1, 拟合直线的线性关系越好, a和b分别为拟合直线的斜率和截距, di是子轨迹中第i个点到拟合直线的垂直距离。

假设轨迹中相邻三点构成夹角的角度为θ, 从图 4(b)可以看出, 短时间内无人机轨迹的角度波动较小, 飞鸟轨迹角度大部分小于无人机轨迹角度。因此, 使用θ的标准差f6来描述角度变化的稳定性, 并通过角度增强f7来突出飞鸟轨迹的差异性, 由此得到以下两个角度特征:

| $ {{f_6} = \sqrt {\frac{1}{{n - 2}}\sum\limits_{i = 0}^{n - 3} {{{({\theta _i} - \bar \theta )}^2}} } } $ | (13) |

| $ {{f_7} = \sum\limits_{i = 0}^{n - 3} {({\rm{ \mathsf{ π} }} - {\theta _i})} \times {\beta _i}} $ | (14) |

其中:

| $ {\beta _i} = \left\lfloor {\frac{{6{\kern 1pt} {\kern 1pt} {\theta _i}}}{{\rm{ \mathsf{ π} }}}} \right\rfloor + 1 $ | (15) |

在式(13)~式(15)中, βi是轨迹段内第i个夹角θi(0≤θi≤π)对应的放大系数, π是圆周率, θ是轨迹段的平均角度,

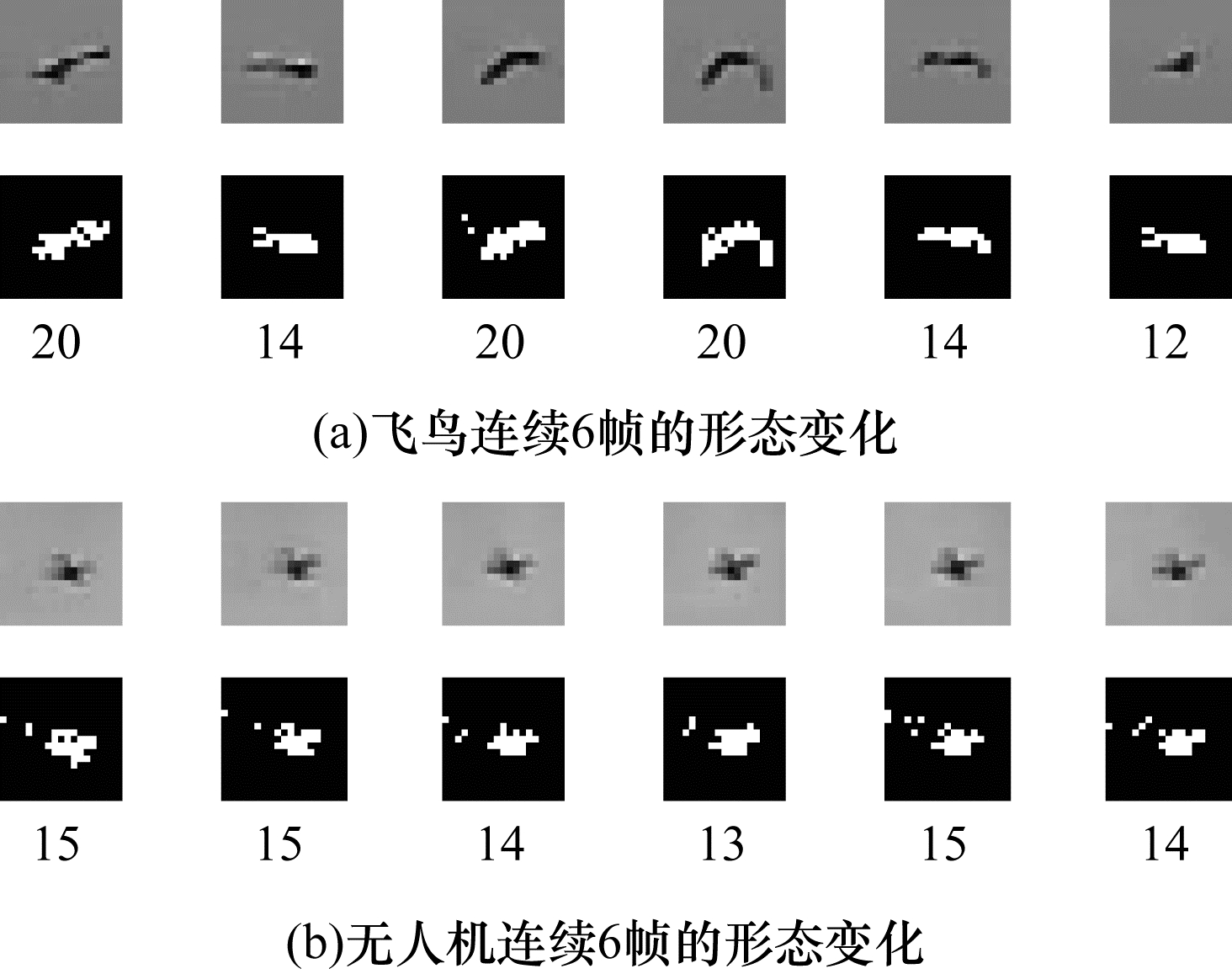

如图 5所示, 图 5(a)和图 5(b)分别是飞鸟和无人机连续6帧的形态变化, 其中数字表示相应连通域的像素点数(δ)。

|

Download:

|

| 图 5 飞鸟与无人机形态变化 Fig. 5 Morphologic changes of birds and UAVs | |

从图 5可以看出, 相比于无人机, 飞鸟的形态变化更加剧烈, 从而导致δ波动较大。因此, 本文采用δ的标准差(f8)来衡量目标形态变化的剧烈程度。

| $ {{f_8} = \sqrt {\frac{1}{{n - 1}}\sum\limits_{i = 0}^{n - 1} {{{({\delta _i} - \bar \delta )}^2}} } } $ | (16) |

| $ {\bar \delta = \frac{1}{{n - 1}}\sum\limits_{i = 0}^{n - 1} {{\delta _i}} } $ | (17) |

其中, δi表示轨迹段内第i个坐标点对应的连通域像素点数。

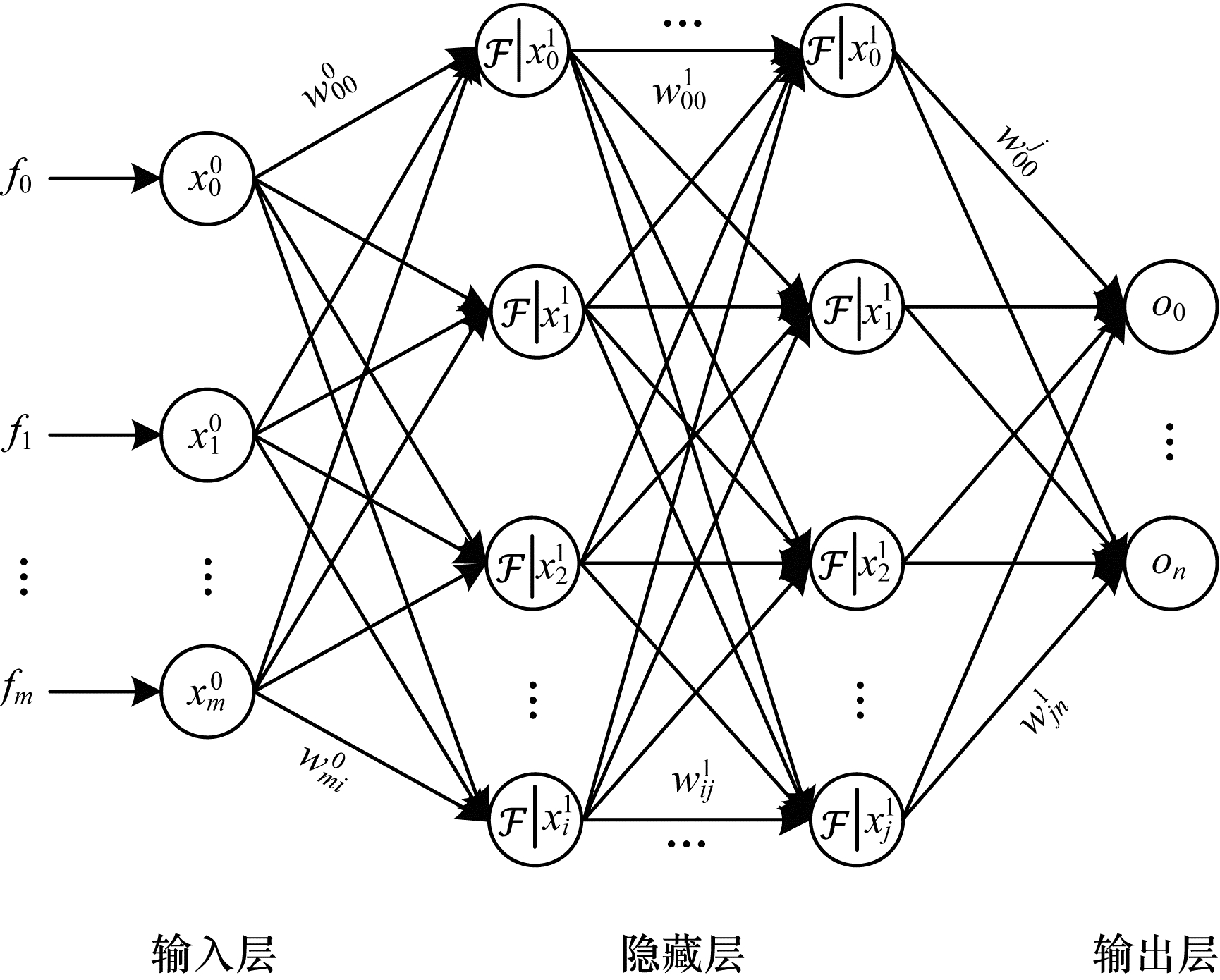

2.4 基于人工神经网络的轨迹识别人工神经网络[19]是一种模仿人类神经元结构发展而来的监督学习算法, 其结构主要有输入层、隐藏层和输出层3个部分, 如图 6所示, 每层由若干神经元组成。

|

Download:

|

| 图 6 人工神经网络结构 Fig. 6 Structure of artificial neural network | |

神经元节点将其所有输入分别与不同权重相乘, 然后相加并做一次偏移运算, 最后通过非线性运算得到该神经元的输出:

| $ x_j^l = \mathcal{F}\left( {\sum\limits_i {\omega _{ij}^{l - 1}} x_i^{l - 1} + b} \right) $ | (18) |

其中, xjl是第l层第j个神经元的输出值, F表示激活函数, ωijl-1是第l-1层第i个神经元到下一层第j个神经元之间的权重, b是偏移量。通过上述计算方法, 网络将计算结果向后逐层传递, 在最后一层由逻辑回归函数计算得到预测结果:

| $ g(x) = \frac{1}{{1 + {{\rm{e}}^{ - {\mathit{\boldsymbol{W}}^{\rm{T}}}x}}}} $ | (19) |

其中, WT是权重向量的转置。为评估网络训练效果, 网络采用对数损失函数计算预测值与期望值的偏差:

| $ \begin{array}{*{20}{l}} { {\rm{cost}} (g(x),y) = - y{\kern 1pt} {\rm{lo}}{{\rm{g}}_a}(g(x) - 1) - }\\ {{\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} (1 - y){\rm{lo}}{{\rm{g}}_a}(1 - g(x))} \end{array} $ | (20) |

其中, y是输入实例x的真实类别。

如果偏差值大于预期值, 则利用反向传播算法(Back Propagation, BP) [20]更新网络的权重矩阵W, 经过若干次迭代后得到轨迹分类模型。

2.5 目标追踪和打击为预防目标飞出相机视场, 系统会根据目标坐标自动调节转台追踪目标, 使目标保持在屏幕中心附近。根据生物视觉机制原理[12], 短时间内无人机的形态和灰度信息相对稳定, 且偏移量较小, 所以本文采用小范围目标搜索算法来追踪目标, 算法步骤如下:

1) 根据图像灰度梯度变化来检测R′区域内的高频信号, 然后以高频信号的极值点作为候选目标坐标。

2) 根据高频信号外接矩大小初步筛除噪声点。

3) 以候选坐标为中心截取相同大小区域用于统计灰度直方图, 然后对候选直方图和目标直方图进行归一化, 通过计算巴氏距离[21]来衡量它们的相似性, 最后得出目标坐标。

4) 更新目标坐标、外接矩大小和灰度直方图。

2015年3月, 工业和信息化部规定了在国内生产或进口到国内销售的无人机的无线电频段范围[22], 这极大地促进了我国的民用无人机监管和发展, 同时也为无人机防御提供了一种可靠的途径。因此, 本文根据不同频段定制了相应的干扰无线电, 并利用干扰无线电迫使入侵无人机返航或迫降, 从而达到防御的目的。

3 实验结果与分析 3.1 数据处理和实验参数本文实验的数据来源是20个包含飞鸟和无人机的视频, 它们均由固定相机拍摄得到, 拍摄环境是存在较多飞鸟的湖面, 天气包含阴天(能见度约300 m)和晴天(能见度约800 m)。其中12个视频包含8 900帧1 280像素×720像素分辨率图像, 记录了大疆无人机(型号:DJI Phantom 3)在不同距离下的各种飞行状态, 其他8个视频包含9 205帧1 280像素×720像素分辨率图像, 记录了各种飞鸟在自然环境下的飞行状态。

在获取视频后, 采用2.1节描述的自适应背景更新算法检测前景目标, 设置背景更新阈值th和ths分别为10和15, 背景更新因子α为0.7。然后根据轨迹聚类算法得到3 516个无人机轨迹段和3 805个飞鸟轨迹段, 并对其进行人工标注(标签为0表示飞鸟轨迹, 标签为1表示无人机轨迹)。由于轨迹特征和形态特征不属于同一量纲, 为提高特征的识别率和加速计算, 本文实验对所有特征集做均值为0方差为1的归一化处理。最后随机抽取70%特征集作为训练样本, 30%作为测试样本。

根据特征维度大小, 本文实验设置网络输入层节点数为8, 包含3个隐藏层, 每层有64个节点, 采用Relu[23]作为激活函数, 网络的初始学习率为0.000 1, 正则化系数为0.001, 一阶和二阶矩向量的指数衰减速率分别为0.9和0.999, 采用Adam[24]优化算法训练神经网络, 最后经过约150次迭代计算后得到轨迹预分类模型。

3.2 结果分析本文主要通过精准率(Precision, PR)、召回率(Recall, RE)和综合评价指标(F1_score, F1_s)3个指标来衡量识别表现, 计算公式如下:

| $ {{\rm{PR}} = \frac{{{\rm{TP}}}}{{{\rm{TP + FP}}}}} $ | (21) |

| $ {{\rm{RE}} = \frac{{{\rm{TP}}}}{{{\rm{TP + FN}}}}} $ | (22) |

| $ {{\rm{F1\_s}} = \frac{{{\rm{2 \times PR \times RE}}}}{{{\rm{PR + RE}}}}} $ | (23) |

其中, 真正例(True Positive, TP)是预测为正的正样本, 假正例(False Positive, FP)是预测为正的负样本, 假负例(False Negative, FN)是预测为负的正样本。

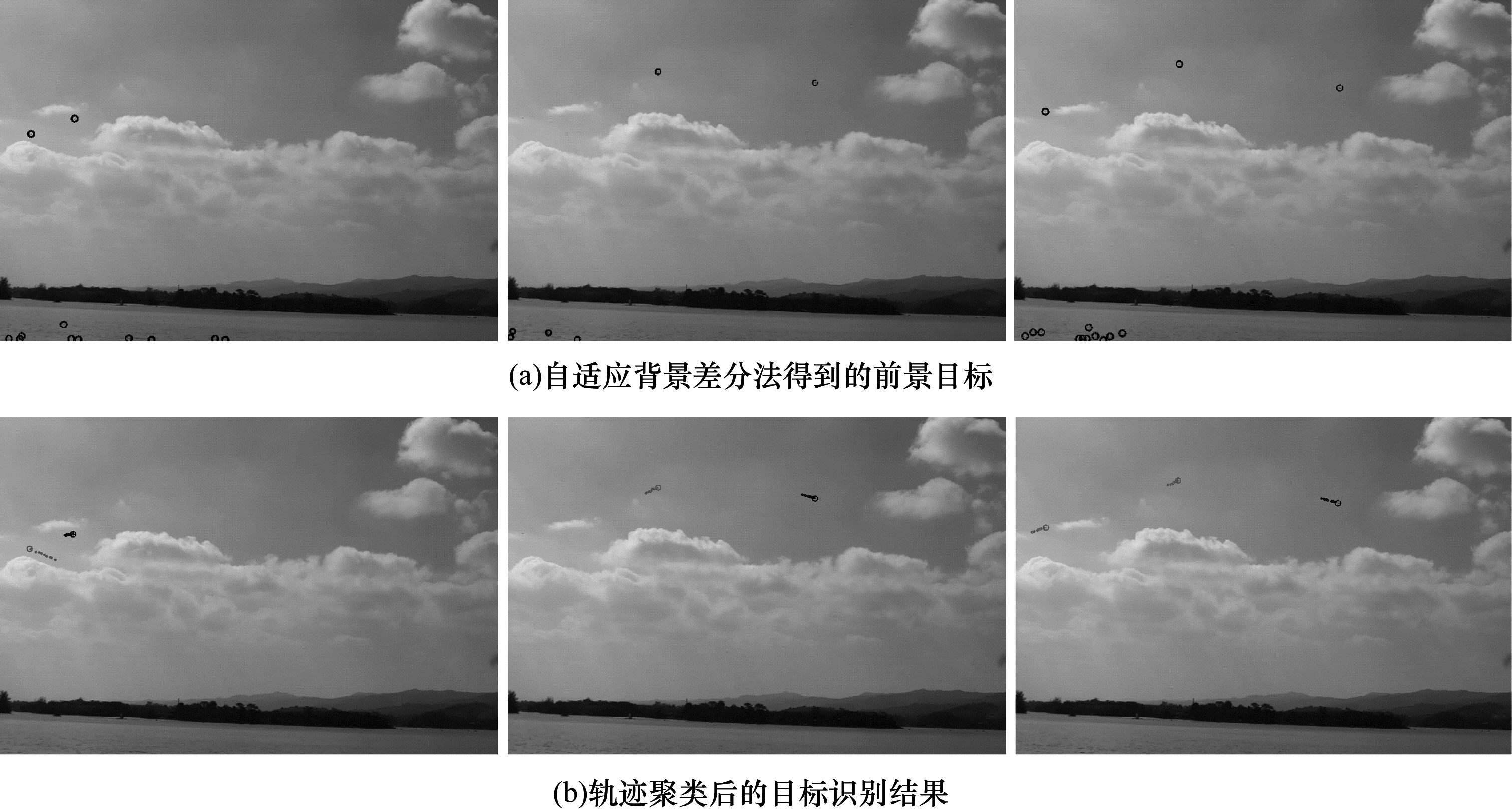

图 7是视频中第57帧(左)、第364帧(中)、第379帧(右)的目标检测结果, 其中图 7(a)是自适应背景更新算法检测得到的前景目标, 可以看出, 除了包含飞行物目标外还存在大量噪声; 图 7(b)是经过轨迹聚类和目标识别后的结果, 可以看出, 原来的噪声点已经被全部清除, 而且准确地识别出图中的无人机和飞鸟, 其中深色圈表示无人机, 浅色圈表示飞鸟。

|

Download:

|

| 图 7 目标检测结果 Fig. 7 Result of target detection | |

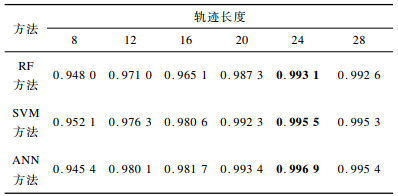

轨迹长度和分类器模型的不同可能会给识别准确率带来影响。在相同计算环境下, 分别用随机森林、支持向量机(Support Vector Machine, SVM)[25]和人工神经网络对不同长度轨迹的特征进行训练和测试。表 1记录了各分类器对不同长度的无人机轨迹的测试结果, 表中数据是6次测试结果的F1_s均值, 加粗数据是当前行的最大值。从表 1可以看出, 轨迹长度达到24之前, 随着长度的增长各分类器模型的F1_s分数逐渐增加, 当长度为24时表现最好, F1_s分数均达到0.993 1。但是, 随着长度的继续增长, F1_s分数并没有明显提升, 反而略微下降, 其原因可能是随着长度增加某些特征对识别效果产生负面影响。总体而言, ANN的表现略优于其他两种方法, 当轨迹长度为24时F1_s分数达到了0.996 9。

|

下载CSV 表 1 各分类器对不同长度轨迹的识别结果 Table 1 Recognition results of different length trajectories by each classifier |

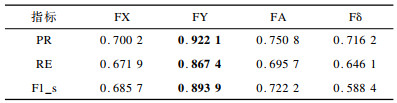

表 2记录了以ANN为识别模型时, 不同特征集对长度为24时的无人机轨迹判别表现, 其中FX(f1, f2)是X方向特征集, FY(f3, f4, f5)是Y方向特征集, FA(f6, f7)是角度特征集, Fδ(f8)是形态特征, 加粗数据是当前行的最大值。从表 2可以看出, FY特征集3项指标值最大, 表现明显优于其他特征集, Fδ特征集的F1_s和RE最小, 表现最差。这说明飞鸟和无人机轨迹的差异性主要体现在Y方向的波动, 而形态特征表现差的原因可能是某些点状目标的像素点数波动不明显。

|

下载CSV 表 2 不同特征集识别结果的定量分析 Table 2 Quantitative analysis of recognition result of different feature sets |

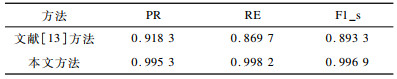

为进一步说明本文方法的有效性, 本文还与文献[13]方法进行性能对比实验。实验采用相同视频获取无人机和飞鸟轨迹, 轨迹段长度设定为24。表 3是文献[13]方法与本文方法的性能对比, 可以看到, 本文方法在PR、RE、F1_s这3项指标上分别提高了0.077 0、0.128 5、0.103 6。

|

下载CSV 表 3 本文方法与文献[13]方法的性能对比 Table 3 Performance comparison between the proposed method and the literature[13] method |

本文实验在Windows 10系统计算机上完成, 其配置为Inter®CoreTMi7-8550U CPU, 8 GB内存。算法实现环境是Microsoft Visual Studio 2015, 算法实现语言是C++。通过实验验证, 本文算法处理一帧1 280像素×720像素图像的平均时间约为27.7 ms。

4 结束语本文针对在复杂环境下通过图像序列难以发现小目标无人机的问题, 提出一种基于轨迹和形态识别的无人机检测方法, 并搭建无人机检测追踪系统。通过轨迹聚类算法排除自然物干扰, 根据飞鸟和无人机飞行轨迹和形态的差异性提取判别特征, 并运用神经网络进行判别。实验结果表明, 该检测系统准确率达到99.53%, 能准确检测出视频中的点状无人机, 且在发现无人机后, 系统控制转台追踪目标, 同时运用无线电定向干扰无人机的通信信号, 从而达到反制目的。该系统综合检测、识别、追踪和反制于一体, 能够在复杂环境下迅速发现远处的无人机, 具有较好的应用前景。虽然本文方法能较早发现远处的无人机, 但检测距离和效果容易受到天气影响, 且飞鸟在滑翔状态下飞行轨迹和形态变化与无人机很相似, 容易导致误判, 下一步将引入图像识别模块确认目标的属性, 从而降低误判率。

| [1] |

ZHOU Jian.How does civil aviation counter uavs?[N].CAAC News, 2017-05-11.(in Chinese) 周舰.应对"黑飞", 民航如何反制无人机?[N].中国民航报, 2017-05-11. |

| [2] |

CHEN Yu, MENG Hongbing, WEN Xinling, et al. Classification methods of a small sample target object in the sky based on the higher layer visualizing feature and transfer learning deep networks[J]. EURASIP Journal on Wireless Communications and Networking, 2018(1): 127. |

| [3] |

AKER C, KALKAN S.Using deep networks for drone detection[C]//Proceedings of the 14th IEEE International Conference on Advanced Video and Signal Based Surveillance.Washington D.C., USA: IEEE Press, 2017: 1-6.

|

| [4] |

MA Qi, ZHU Bin, ZHANG Hongwei, et al. Low-altitude UAV detection and recognition method based on optimized YOLOv3[J]. Laser & Optoelectronics Progress, 2019, 56(20): 279-286. (in Chinese) 马旗, 朱斌, 张宏伟, 等. 基于优化YOLOv3的低空无人机检测识别方法[J]. 激光与光电子学进展, 2019, 56(20): 279-286. |

| [5] |

REDMON J, FARHADI A.Yolov3: an incremental improvement[EB/OL].[2019-09-10].https://arxiv.org/pdf/1804.02767.pdf.

|

| [6] |

WANG Jingyu, WANG Xianyu, ZHANG Ke, et al. Small UAV target detection model based on deep neural network[J]. Journal of Northwestern Polytechnical University, 2018, 36(2): 258-263. (in Chinese) 王靖宇, 王霰禹, 张科, 等. 基于深度神经网络的低空弱小无人机目标检测研究[J]. 西北工业大学学报, 2018, 36(2): 258-263. |

| [7] |

SOMMER L, SCHUMANN A, MVLLER T, et al.Flying object detection for automatic UAV recognition[C]//Proceedings of the 14th IEEE International Conference on Advanced Video and Signal Based Surveillance.Washington D.C., USA: IEEE Press, 2017: 1-6.

|

| [8] |

REN S, HE K, GIRSHICK R, et al.Faster r-CNN: towards real-time object detection with region proposal networks[C]//Proceedings of NIPS'15.New York, USA: ACM Press, 2015: 91-99.

|

| [9] |

PARK J, KIM D H, SHIN Y S, et al.A comparison of convolutional object detectors for real-time drone tracking using a PTZ camera[C]//Proceedings of the 17th International Conference on Control, Automation and Systems.Washington D.C., USA: IEEE Press, 2017: 696-699.

|

| [10] |

XI Yuding, YU Yong, DING Yuanyuan, et al. An optoelectronic system for fast search of low slow small target in the air[J]. Opto-Electronic Engineering, 2018, 45(4): 58-67. (in Chinese) 奚玉鼎, 于涌, 丁媛媛, 等. 一种快速搜索空中低慢小目标的光电系统[J]. 光电工程, 2018, 45(4): 58-67. |

| [11] |

HU S, GOLDMAN G H, BOREL-DONOHUE C C. Detection of unmanned aerial vehicles using a visible camera system[J]. Applied Optics, 2017, 56(3): 214-221. |

| [12] |

WANG Xiaojua, ZHANG Cong, LI Cong, et al. Unmanned aerial vehicles target detection based on bio-inspired visual attention[J]. Aeronautical Science & Technology, 2015, 26(11): 78-82. (in Chinese) 王晓华, 张聪, 李聪, 等. 基于仿生视觉注意机制的无人机目标检测[J]. 航空科学技术, 2015, 26(11): 78-82. |

| [13] |

LIU Yang, DU Huajun, YUE Zihan, et al. Unmanned aerial vehicle detection method based on random forest[J]. Computer Engineering and Applications, 2019, 55(7): 162-167. (in Chinese) 刘阳, 杜华军, 岳子涵, 等. 基于随机森林的无人机检测方法[J]. 计算机工程与应用, 2019, 55(7): 162-167. |

| [14] |

LIAW A, WIENER M. Classification and regression by random forest[J]. R News, 2002, 2(3): 18-22. |

| [15] |

UNLU E, ZENOU E, RIVIERE N. Using shape descriptors for UAV detection[J]. Electronic Imaging, 2018(9): 1-5. |

| [16] |

SUN Wenhua. Background subtraction moving target detection algorithm based on adaptive Surendra background updating[J]. Journal of Nanchang Institute of Technology, 2018, 37(3): 60-64. (in Chinese) 孙文华. 基于自适应Surendra背景更新的背景差分运动目标检测算法[J]. 南昌工程学院学报, 2018, 37(3): 60-64. |

| [17] |

YANG Qingyu, WANG Zengfu. Moving point target detection and tracking under the condition of complex background[J]. Pattern Recognition and Artificial Intelligence, 2004, 17(3): 342-346. (in Chinese) 杨擎宇, 汪增福. 复杂背景下运动点目标的检测和跟踪[J]. 模式识别与人工智能, 2004, 17(3): 342-346. |

| [18] |

TIAN Long, LIU Zongtian. Least-squares method piecewise linear fitting[J]. Computer Science, 2012, 39(S1): 482-484. (in Chinese) 田垅, 刘宗田. 最小二乘法分段直线拟合[J]. 计算机科学, 2012, 39(S1): 482-484. |

| [19] |

HOPFIELD J J. Artificial neural networks[J]. IEEE Circuits and Devices Magazine, 1988, 4(5): 3-10. |

| [20] |

LECUN Y, BOSER B E, DENKER J S, et al.Handwritten digit recognition with a back-propagation network[C]//Proceedings of NIPS'90.New York, USA: ACM Press, 1990: 396-404.

|

| [21] |

ZHU Zhengwei, ZHU Lei, RAO Peng. Gesture recognition based on BS-HMM and Bhattacharyya distance[J]. Computer Applications and Software, 2019, 36(6): 163-166, 253. (in Chinese) 朱正伟, 祝磊, 饶鹏. 基于BS-HMM和巴式距离的手势识别技术研究[J]. 计算机应用与软件, 2019, 36(6): 163-166, 253. |

| [22] |

SHUAI Bo, HU Xinchi. Radio monitoring:a new tool for uav control[J]. Shanghai Informatization, 2018(6): 38-41. (in Chinese) 帅博, 胡欣驰. 无线电监测:无人机管控新利器[J]. 上海信息化, 2018(6): 38-41. |

| [23] |

GLOROT X, BORDES A, BENGIO Y.Deep sparse rectifier neural networks[C]//Proceedings of the 14th International Conference on Artificial Intelligence and Statistics.Fort Lauderdale, USA: [s.n.], 2011: 315-323.

|

| [24] |

KINGMA D P, BA J.Adam: a method for stochastic optimization[EB/OL].[2019-09-10].https://arxiv.org/pdf/1412.6980.pdf.

|

| [25] |

SUYKENS J A K, VANDEWALLE J. Least squares support vector machine classifiers[J]. Neural Processing Letters, 1999, 9(3): 293-300. |

2020, Vol. 46

2020, Vol. 46