2. 中国科学院自动化研究所 智能感知与计算研究中心, 北京 100190

2. Center for Research on Intelligent Perception and Computing, Institute of Automation, Chinese Academy of Sciences, Beijing 100190, China

开放科学(资源服务)标志码(OSID):

近年来,随着深度学习技术的发展,人脸操控和合成技术取得了较大进展,但是它们在给影视等行业提供便利的同时也给社会公共安全领域带来了隐患。自2017年起,各类换脸视频及软件层出不穷,其中,深度伪造(Deepfake)技术备受关注,该技术使用机器学习来生成逼真的图像和视频,信息内容“以假乱真”,进而达到欺骗受众的目的。Deepfake技术可以篡改生成虚假视频,不法分子经常使用该技术来制造虚假证据,如散播谣言、编造虚假新闻等,严重影响了公安机关正常执法办案,甚至因此产生许多冤假错案。因此,对Deepfake进行检测具有重要的现实意义。

2020年,Facebook等机构为鼓励研究人员开发更有效的Deepfake检测方法,发起一项名为Deepfake Detection Challenge的比赛。与此同时,各国也在立法层面实施相应的应对方案:美国两党议员分别在众议院、参议院同时提出《2019年深度伪造报告法案》[1],该法案反映了目前美国立法者在防范Deepfake技术风险中所作的努力;欧盟方面主要通过个人信息保护和虚假信息治理等法律法规来从法律层面限制人工智能造假技术的应用;中国于2019年印发了《网络音视频信息服务管理规定》[2],该规定指出如果相关人员利用Deepfake视频造成严重危害并构成犯罪,司法机关将依法追究刑事责任。上述一系列举措在一定程度上限制了Deepfake视频的传播。

目前,为了能够有效地检测以Deepfake为代表的深度伪造视频,研究人员提出了许多检测方法,但是,其中多数检测方法依赖于数据驱动,在跨压缩率、跨分辨率方面并不具有鲁棒性。尽管MATERN等[3]对伪造图像中人眼可见的一些痕迹(如眼睛颜色、人脸对齐不准)所产生的伪影进行手工建模,但其只在特定的生成方法下效果较好,因为人的面部特征具有多样性,导致该方法不能很好地进行建模,即存在不能有效提取伪造特征的问题。

本文将篡改伪影特征引入卷积神经网络中,建立一种基于篡改伪影的双流检测模型。通过对FF++(FaceForensics++)[4]中Deepfakes数据集进行分析,可以看出该数据集所使用的算法在生成伪造视频的过程中会在换脸部位遗留相应的伪影。因此,本文对人脸部区域进行有效遮挡,凸显出脸部伪影,并使用卷积神经网络提取伪影特征,从而提升模型的抗压缩能力。在此基础上,构建一种基于Xception[5]的双流检测网络,使模型在检测时不仅利用全局空域特征,还可以关注相应的伪影特征,从而提高模型对Deepfake视频的检测效果。

1 相关工作 1.1 Deepfake生成原理Deepfake是Deep learning和Fake的组合,主要指使用深度神经网络制造的虚假视频或图片。2017年,一位名为“Deepfakes”的Reddit用户上传了一段用该技术制作的色情视频,从此Deepfake技术不断涌现。Deepfake使用自编解码架构(Encoder-Decoder),与传统自编码器不同,Deepfake采用1个编码器(Encoder)和2个解码器(Decoder A和Decoder B),其原理如图 1所示,分别构建2个自编码器,两者共享1个编码器,而解码器用于重构另一个人的脸,共享1个编码器是为了能同时提取A与B的脸部特征。在模型训练阶段,首先将A与B的人脸图片输入到网络中,然后输出相应的人脸图片,同时使用监督学习的方法最小化输入输出之间的差异。Deepfake的图像生成过程就是恢复A和B人脸的过程,在图 1中,将A人脸送入自编码器中进行编码和解码,最终得到伪造视频。

|

Download:

|

| 图 1 Deepfake技术的基本原理 Fig. 1 The basic principle of Deepfake technology | |

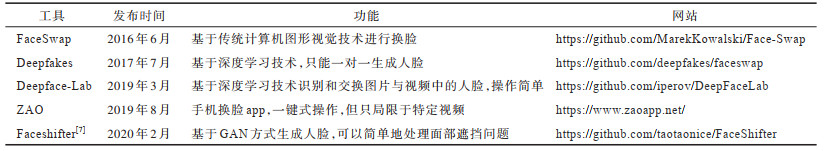

换脸技术既可以促进影视行业的发展,如进行视觉特效制作、实现替身演员脸部替换等,同时也可能造成一些严重危害,如恶搞明星政要、损害公众人物形象以及其他违法犯罪活动。据sensity安全公司最新统计结果[6]显示,截止2020年6月,YouTube等主流网站上的造假视频多达49 081个,同比增加330%左右,可见造假视频已达到泛滥程度。为促进视频检测领域的发展,本文总结当前具有代表性的一些换脸开源工具,如表 1所示。

|

下载CSV 表 1 具有代表性的Deepfake生成工具 Table 1 Representative Deepfake generation tools |

在Deepfake检测领域,研究人员已经提出了多种取证技术[8],根据检测目标不同,这些技术可以分为基于图像检测和基于视频检测两大类。在图像检测方面,主要分为传统手工设计和深度神经网络2个部分。在传统手工设计方面,YANG等[9]指出在伪造过程中Deepfake很难伪造一个人的讲话方式,因此,该文利用面部姿势和头部姿势等生物特征进行统计建模,将建模后提取的特征送入SVM分类器以获得检测结果。YUE等[10]通过检测眨眼信息来判断视频的真假,但由于现在伪造技术的改进,导致该方法已无法伪造视频进行有效检测。MATERN等[3]对眼睛颜色、牙齿、人脸对齐不准所产生的伪影等重点区域设计手工特征并进行分类,但他们使用简单的分类器,存在不能有效提取伪造特征的情况。在基于深度神经网络的图像检测方面,ZHOU等[11]提出一种双流网络用于深度换脸检测,其分别用2个网络学习局部噪声残差和相机特征以及人脸篡改痕迹,但该网络鲁棒性不佳。AFCHAR等[12]为了更好地提取人脸的伪造特征,提出Meso-4网络用于换脸检测。NGUYE[13]使用胶囊网络来检测伪造图像和视频。LI等[14]构建一个取证数据集FaceForensics++,其促进了假脸检测领域的发展,同时该文使用Xception网络结构对换脸图片进行检测,其能达到较好的效果。GUERA等[15]通过高斯模糊等后处理方法来模拟伪造视频,并使用卷积神经网络进行检测,其能取得较好的效果,但是,基于深度学习生成的伪造视频与其模拟视频之间仍然存在一定差异。

相比于图片,视频中包含的信息更多,具有更大的危害性。针对视频检测,经典的取证思路是将视频对象转化为图片对象,从视频中随机选择一些帧并对这些帧进行检测,通常使用最大或平均分数作为最终分数对视频真假进行预测。如果一个视频只有部分关键帧被篡改,那么使用这种检测方式容易出现误报或者漏检情况。文献[15-16]将卷积神经网络和长短期记忆(LSTM)网络相结合,用于视频序列检测:首先使用卷积神经网络提取视频帧中的特征;然后使用这些特征训练RNN,以提取相应的时序信息。此外,有研究人员基于生物信号进行检测,如CIFTCI等[17]通过检测心跳在面部产生的细微差别来区分视频真假。

总体来看,关于深度造假检测的研究工作仍处于初步发展阶段,造假技术和检测技术是一个相互博弈的过程,目前的检测方法都有一定的局限性,在遇到跨压缩率、跨分辨率、跨数据集等情况时缺乏足够的泛化性。同时,在实际案件中,违法人员也会针对这些问题对视频进行各种后处理,从而提高了检测难度。

2 基于Xception的双流Deepfake检测模型 2.1 Xception网络模型本文模型基于Xception网络构建,Xception由输入层、中间层、输出层3个主要部分组成,共包含36个卷积层。作为Inceptionv3的改进,Xception引入了深度可分离卷积,在几乎不增加网络复杂度的前提下提高了模型效果。与普通卷积核相比,深度可分离卷积可以有效分离空间以及通道间的相关性。

2.2 双流Deepfake检测模型设计由于造假视频在换脸过程中受限于Deepfake生成算法,因此会留下相应的伪影,这些伪影主要包括面部扭曲、不同分辨率、边界色差等特征,具体表现为以鼻子为中心的区域成像质量相对较好,该区域以外的区域则伪影明显。本文据此设计一种双流网络,分别用来学习造假图片的全局信息和伪影特征。在特征提取网络选择方面,由于文献[4]中指出Xception对于Deepfake视频检测能取得优秀效果,同时该网络模型在DFDC、CAAD等虚假人脸识别中被广泛应用,因此本文选择Xception作为模型的基准网络。在伪影特征方面,首先根据人脸关键点信息生成相应的Mask以掩盖中心区域,以此突出相应的伪影痕迹;其次由于造假视频中的人物背景发生变化,因此利用Xception网络来有效提取相应的伪影特征。本文网络模型结构如图 2所示。

|

Download:

|

| 图 2 本文网络模型结构 Fig. 2 Network model structure in this paper | |

如图 2所示,本文首先使用FFmpeg对Deepfake视频进行分帧,然后利用人脸检测器MTCNN获取人脸图片。上分支

| $ P\left(x\right)=\partial {F}_{\mathrm{r}\mathrm{g}\mathrm{b}}\left(x\right)+\left(1-\partial \right){F}_{\mathrm{m}\mathrm{a}\mathrm{s}\mathrm{k}} $ | (1) |

其中:

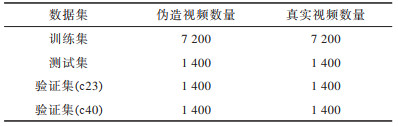

FF++[4]是当前较为主流的视频数据库之一,该数据库于2019年被推出,是原始FaceForensics[18]数据库的扩展。FF++包含1 000张真实视频,视频均来自YouTube。为证明本文算法的有效性,使用FF++中的Deepfakes数据集,Deepfakes数据集共包括1 000个假视频,其中,训练集有720个,测试集和验证集均为140个。同时,为了模拟现实情况,使用H.264编解码器压缩,生成Raw(c0)、HQ(c23)、LQ(c40)这3种压缩视频。视频压缩会丢掉部分关键伪造特征,使检测精度降低,同时导致模型在跨压缩率中表现较差。本文选择c23和c40这2种压缩方式的数据并进行抗压缩实验,以验证本文算法的有效性。实验中共制作11 400张图片,其中,c40作为跨压缩率测试的图片,共2 800张。本文实验的训练集、测试集、验证集具体信息如表 2所示。

|

下载CSV 表 2 数据集信息 Table 2 Datasets information |

在本文实验中,数据集制作主要包含4个步骤:1)按照官方划分格式进行划分;2)抽取视频帧;3)对视频帧图像进行人脸截取和关键点保存;4)制作人脸Mask区域。官方给定的划分格式是json文件,其中包括数据集的划分方法以及原视频和篡改视频的对应关系。本文根据json文件将对应的视频划分为Original和Manipulated两组,每组又划分为训练集、测试集、验证集,然后使用FFmpeg将每个Deepfake视频等间隔截取10帧,使用MTCNN[19]获取人脸框,以人脸框为中心向外扩张0.3倍并保存,同时根据人脸关键点信息进行人脸对齐,最后使用人脸关键点信息生成相应的Mask区域,以此遮挡鼻子所在的中心区域。

3.2 实验环境配置本文实验硬件配置为Intel®Xeon®CPUE5-2650v4@2.20 GHz,内存164 GB,GPU为TITAN X(Pascal),软件配置为Linux,CUDA9.2,CUDNN7.5.1。深度学习算法框架使用Pytorch1.2。本文实验平台基于Pytorch深度学习框架搭建,为了提高模型的分类性能,使用ImageNet上的预训练模型。损失函数BCEWithLogitsLoss、实验参数在模型训练过程中使用Adam学习率调整,超参数设置为:LearningRate=0.000 2,WeightDecay(权重衰减)=0.001,batchsize=40,总计训练10个epoch,每个epoch验证5次,最终取在测试集上表现最好的模型用于验证。在实验测试阶段,每个支路的权重系数都为0.5,图片的判断阈值设置为0.5,即得分大于0.5的图片认为是伪造图片。

3.3 实验评价指标可以将Deepfake检测问题看作一个二分类真假问题。本文使用Logloss和Acc这2个评价指标,两者计算公式分别如下:

| $ {A}_{\mathrm{A}\mathrm{c}\mathrm{c}}=\frac{{R}_{\mathrm{r}\mathrm{i}\mathrm{g}\mathrm{h}\mathrm{t}}}{{A}_{\mathrm{a}\mathrm{l}\mathrm{l}}} $ | (2) |

| $ {L}_{\mathrm{L}\mathrm{o}\mathrm{g}\mathrm{L}\mathrm{o}\mathrm{s}\mathrm{s}}=-\frac{1}{n}\sum\limits _{i=1}^{n}\left[{y}_{i}\mathrm{l}\mathrm{n}\left({y}_{i}'\right)+\left(1-{y}_{i}\right)\mathrm{l}\mathrm{n}\left(1-{y}_{i}'\right)\right] $ | (3) |

其中:Rright为输出概率大于0.5的样本数量;Aall为总样本数量;n为测试图片的数量;

为了更好地验证模型效果,本文还使用ROC曲线下面积AUC值作为评测指标。ROC曲线是以TPR(真阳性率)为纵坐标、FPR(假阳性率)为横坐标而绘制,ROC曲线可以更直观地反映不同模型的优劣程度。

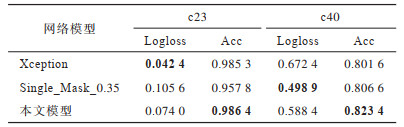

3.4 结果分析 3.4.1 与单流网络的对比由于视频压缩会使伪造视频丢掉很多特征信息,使得模型检测能力下降,同时,在当今的互联网中,很多社交软件会自动地压缩视频,其中最常见的是CRF压缩方式。在同一压缩率下进行测试,模型检测精度高达98%,但是在面对压缩情况时,准确率会大幅下降,可见后处理对于Deepfake检测的影响。在实际案件中,公安机关无法获得高质量的原视频,很容易发生错检情况,从而影响侦查方向。因此,在同一压缩率下进行对比,意义并不是很大。本文为了检验模型是否学习到篡改图像的伪影特征,选择跨压缩率测试,即在Deepfakes中的c23上进行训练,在c40版本上进行验证。为了证明本文网络和伪影特征的有效性,测试Mask单流、Full_face和双流网络在不同压缩率下的性能,实验结果如表 3所示,最优结果加粗表示。

|

下载CSV 表 3 本文模型与单流网络的对比 Table 3 Comparison between this model and single stream network |

从表 3可以看出,在同一压缩率下进行测试,单流和双流网络检测精度都很高,这与数据分布有关,同时伪影特征取得了0.957 8的精度,证明该特征在Deepfake伪造视频检测中具有有效性。但是,在跨压缩率测试中,模型精度大幅降低,可见视频压缩对于检测结果具有较大影响。

不同模型的ROC曲线和AUC值如图 3所示。从图 3可以看出,本文通过对网络结构进行设计,使得模型在训练过程中学习伪影特征,在跨压缩率方面有一定性能提升,验证了本文方法的有效性。

|

Download:

|

| 图 3 不同模型在验证集上的ROC曲线和AUC值 Fig. 3 ROC curves and AUC values of different models on the validation set | |

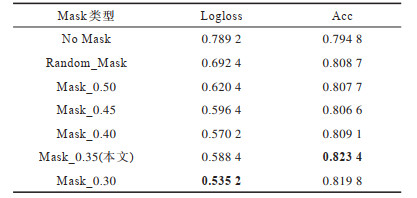

本文通过对脸部区域添加相应的Mask,以使网络更好地学习伪造特征。如图 4所示,为了探究不同Mask比例对于实验结果的影响,本文使用MTCNN所保留的人脸框信息,对人脸框进行不同程度的缩放,将缩放后的区域像素值变为0,保留其余区域的像素值,目的是遮盖掉中心区域,突出四周的伪影痕迹。本文将MTCNN所检测的人脸框比例设置为1,使用该坐标值进行比例缩放,进而生成相应的Mask区域。由于Deepfake伪造视频只针对部分面部区域进行伪造,因此比例值大于0.5会掩盖掉伪造区域,而当比例值小于0.3时,无法有效覆盖鼻子等中心区域。为保证实验结果的科学性,在实验过程中,本文固定Full_face流,只更改Mask流,实验结果如表 4所示。从表 4可以看出:当Mask比例为0.35时,检测效果最好;当Mask较大时,检测精度与单流网络一致,原因可能是Mask掩盖了过多的伪影痕迹,如眼睛、嘴巴等,这些区域可能受限于生成算法,留下了较多的伪造特征。为进一步证明本文方法的有效性,避免模型集成带来的影响,重新训练Full_face流,并将Mask流换成Full_face流,即将2个全局信息进行融合。实验结果表明,2个Full_face流会导致检测精度降低,这可能是由于单模型之间的一致性和精度较高,在集成过程中,另一个Full_face流并不能很好地起到辅助监督的作用。通过与Xception结果进行对比可以看出,本文模型在跨压缩率上体现出一定的优越性。

|

Download:

|

| 图 4 不同Mask比例下的人脸图像效果 Fig. 4 Face image effects under different Mask ratios | |

|

下载CSV 表 4 不同Mask比例对于跨压缩率实验结果的影响 Table 4 The impact of different Mask ratios on the results of cross-compression experiments |

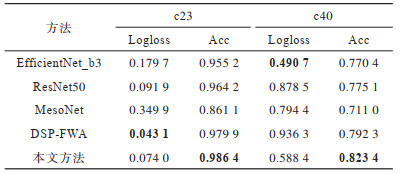

随着国内外学者对Deepfake检测研究的深入,出现了很多经典方法,其中,EfficientNet[20]、Xception、ResNet[21]被广泛应用。为了验证本文方法的有效性,选取常见的检测方法作为对比进行实验,结果如表 5所示。从表 5可以看出,多数特征提取网络都可以达到很好的检测结果,Xception作为该领域主流的取证网络,具有明显优势,在跨压缩率方面,本文方法检测精度比其他方法高出2~10个百分点,同时,模型在ROC曲线和AUC值方面都有不错表现。图 5所示结果进一步说明了本文方法的有效性,但是,跨压缩率的模型精度只有0.823 4,仍然存在大量漏检和错检的情况,也从侧面证明了跨压缩率仍然是伪造视频检测中的难点和重点。

|

下载CSV 表 5 本文方法与其他经典方法的对比 Table 5 Comparison between this method and other classical methods |

|

Download:

|

| 图 5 不同方法在验证集上的ROC曲线和AUC值 Fig. 5 ROC curves and AUC values of different methods on the validation set | |

从早期的伪造色情视频到现在的政治安全问题,犯罪分子精心设计的Deepfake视频会对警察执法办案以及司法审判带来巨大影响。本文提出一种基于Xception的双流检测模型,通过在面部中心区域添加相应的Mask来提升模型对于伪影特征的提取能力。在Deepfakes数据集上的实验结果表明,本文模型的检测精度高达0.986 4,同时在跨压缩率检测方面相对ResNet50、DSP-FWA等方法也有明显的性能提升。下一步将对不同伪造方式下的伪影特征进行研究,提高特征在跨压缩率方面的鲁棒性,从而提升模型的检测准确率。

| [1] |

2019年深度伪造报告法案[EB/OL]. [2020-12-02]. https://www.congress.gov/bill/116th-congress/house-bill/3600/. Deepfakes Report Act of 2019[EB/OL]. [2020-12-02]. https://www.congress.gov/bill/116th-congress/house-bill/3600/. (in Chinese) |

| [2] |

网络音视频信息服务管理规定[EB/OL]. [2020-12-02]. http://www.cac.gov.cn/2019-11/29/c_1576561820967678.htm. Regulations on Management of Network Audio and Video Information Service[EB/OL]. [2020-12-02]. http://www.cac.gov.cn/2019-11/29/c_1576561820967678.htm. (in Chinese) |

| [3] |

MATERN F, RIESS C, STAMMINGER M. Exploiting visual artifacts to expose Deepfakes and face manipulations[C]//Proceedings of 2019 IEEE Winter Applications of Computer Vision Workshops. Washington D.C., USA: IEEE Press, 2019: 83-92.

|

| [4] |

ROSSLER A, COZZOLINO D, VERDOLIVA L, et al. FaceForensics++: learning to detect manipulated facial images[C]//Proceedings of 2019 IEEE/CVF International Conference on Computer Vision. Washington D.C., USA: IEEE Press, 2019: 209-215.

|

| [5] |

CHOLLET F. Xception: deep learning with depthwise separable convolutions[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Washington D.C., USA: IEEE Press, 2017: 1251-1258.

|

| [6] |

Visual threat intelligence platform[EB/OL]. [2020-12-02]. https://sensity.ai/.

|

| [7] |

LI L, BAO J, YANG H, et al. FaceShifter: towards high fidelity and occlusion aware face swapping[EB/OL]. [2020-12-02]. https://arxiv.org/pdf/1912.13457.pdf.

|

| [8] |

ROCHA A, SCHEIRER W, BOULT T, et al. Vision of the unseen: current trends and challenges in digital image and video forensics[J]. ACM Computing Surveys, 2011, 43(4): 1-42. |

| [9] |

YANG X, LI Y, LÜ S. Exposing deep fakes using inconsistent head poses[C]//Proceedings of 2019 IEEE International Conference on Acoustics, Speech and Signal Processing. Washington D.C., USA: IEEE Press, 2019: 8261-8265.

|

| [10] |

LI Y, CHANG M C, LÜ S. In Ictu Oculi: exposing AI created fake videos by detecting eye blinking[C]//Proceedings of 2018 IEEE International Workshop on Information Forensics and Security. Washington D.C., USA: IEEE Press, 2018: 1-7.

|

| [11] |

ZHOU P, HAN X, MORARIU V I, et al. Two-stream neural networks for tampered face detection[C]//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. Washington D.C., USA: IEEE Press, 2017: 1831-1839.

|

| [12] |

AFCHAR D, NOZICK V, YAMAGISHI J, et al. MesoNet: a compact facial video forgery detection network[C]//Proceedings of 2018 IEEE International Workshop on Information Forensics and Security. Washington D.C., USA: IEEE Press, 2018: 10-17.

|

| [13] |

NGUYEN H H, YAMAGISHI J, ECHIZEN I. Capsule-forensics: using capsule networks to detect forged images and videos[C]//Proceedings of 2019 IEEE International Conference on Acoustics, Speech and Signal Processing. Washington D.C., USA: IEEE Press, 2019: 2307-2311.

|

| [14] |

LI Y, LÜ S. Exposing deepfake videos by detecting face warping artifacts[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Washington D.C., USA: IEEE Press, 2019: 46-52.

|

| [15] |

GUERA D, DELP E J. Deepfake video detection using recurrent neural networks[C]//Proceedings of 2018 IEEE International Conference on Advanced Video and Signal Based Surveillance. Washington D.C., USA: IEEE Press, 2018: 1-6.

|

| [16] |

SABIR E, CHENG J, JAISWAL A, et al. Recurrent convolutional strategies for face manipulation detection in videos[J]. Interfaces, 2019, 3(1): 10-15. |

| [17] |

CIFTCI U A, DEMIR I, YIN L. FakeCatcher: detection of synthetic portrait videos using biological signals[EB/OL]. [2020-12-02]. https://arxiv.org/pdf/1901.02212v1.pdf.

|

| [18] |

RÖSSLER A, COZZOLINO D, VERDOLIVA L, et al. Faceforensics: a large-scale video dataset for forgery detection in human faces[EB/OL]. [2020-12-02]. https://arxiv.org/pdf/1803.09179.pdf.

|

| [19] |

ZHANG K, ZHANG Z, LI Z, et al. Joint face detection and alignment using multitask cascaded convolutional networks[J]. IEEE Signal Processing Letters, 2016, 23(10): 1499-1503. DOI:10.1109/LSP.2016.2603342 |

| [20] |

TAN M, LE Q. EfficientNet: rethinking model scaling for convolutional neural networks[C]//Proceedings of International Conference on Machine Learning. [S. l.]: PMLR, 2019: 6105-6114.

|

| [21] |

贾瑞明, 李阳, 李彤, 等. 多层级特征融合结构的单目图像深度估计网络[J]. 计算机工程, 2020, 46(12): 207-214. JIA R M, LI Y, LI T, et al. Monocular image depth estimation network with multiple level feature fusion structure[J]. Computer Engineering, 2020, 46(12): 207-214. (in Chinese) |

2021, Vol. 47

2021, Vol. 47