2. 电子信息控制重点实验室, 成都 610000

2. Key Laboratory of Electronic Information Control, Chengdu 610000, China

开放科学(资源服务)标志码(OSID):

在海量数据的支撑下,机器学习尤其是深度学习算法在计算机视觉、自然语言处理等领域得到广泛应用并取得了较大成功。机器学习的理想应用场景是有大量带标记的训练实例,并且训练数据与测试数据具有相同的分布。然而,在许多现实应用中,收集足够的带标记训练数据通常耗时、代价昂贵甚至无法实现。同时,在机器学习被使用的诸多领域中,数据独立同分布的假设往往并不成立。数据分布存在差异导致传统的机器学习算法训练得到的模型往往不能在相似的新领域中取得预期结果,这限制了机器学习模型的泛化能力和知识复用能力。

迁移学习和领域自适应技术可以改善机器学习模型在跨领域任务中的性能。当目标领域中无法获得大量带标签数据用于训练具有良好性能的机器学习模型时,可以考虑在不同但相关的有大量带标签数据可以被获取的辅助领域进行模型预训练,然后对训练好的模型进行调整并应用于目标领域,这克服了实际应用中目标域难以获取带标签数据的困境。然而,跨域的数据分布差异成为了模型迁移的障碍。领域自适应旨在学习一个模型使得在辅助领域获取的知识能够在目标领域较好地得到泛化,引入领域自适应技术可以减小辅助领域与目标领域的数据分布差异,从而实现领域不变知识的跨域迁移和复用。领域自适应是机器学习与计算机视觉范畴内的前沿研究方向之一,在生物信息学等方面有极大的应用前景。迁移学习和领域自适应技术有望处理目标领域标注数据稀缺的问题,避免从头进行模型训练的高额成本,从而提高机器学习模型的普适性和知识迁移复用的能力,因此,迁移学习与领域自适应具备较大的理论研究价值和广阔的应用前景。

本文总结国内外学者对领域自适应技术的研究现状,介绍领域自适应的相关概念、算法分类、代表性方法、典型应用以及目前存在的挑战,在此基础上,对领域自适应技术的发展趋势及未来研究方向进行展望。

1 研究现状迁移学习试图让机器学习人类的类比学习和“举一反三”的能力,迁移学习受到人类可以智能地应用以前学习到的知识来更快更好地解决新问题这一事实的启发。1995年,NIPS关于“学会学习”的研讨会讨论了机器学习领域的迁移学习基本动机,自1995年之后,迁移学习以“学会学习”“知识迁移”“终生学习”“多任务学习”“归纳迁移”“增量学习”等不同的名称出现,逐渐引起人们的关注。2005年,美国国防部高级研究计划局(DARPA)的信息处理技术办公室(IPTO)对迁移学习进行新的定义:一个系统对先前学习到的知识或技能进行识别并将其运用于新任务的能力。2010年发表于TKDE(IEEE Transactions on Knowledge and Data Engineering)的综述论文A Survey on Transfer Learning系统阐述了迁移学习的研究历程,提出迁移学习的形式化定义及分类,并将领域自适应对应于迁移学习的子领域之一。

在随后的理论研究中,浅层域适应的常用算法主要分为基于实例的DA和基于特征的DA[1]。文献[1]将深度DA分为基于差异、基于对抗和基于重建三大类。文献[2]将其分为基于实例、基于映射、基于网络和基于对抗四大类。文献[3-4]从数据和模型的角度对迁移学习和领域自适应的多种代表性方法进行概述。文献[5]关注单源无监督的域适应场景,特别是该设定下的深度域适应方法,根据域偏移损失和生成/判别设定的不同,将深度域适应方法归类为基于差异的方法、基于对抗生成的方法、基于对抗判别的方法和基于自监督的方法四类。文献[6-7]侧重于从特征选择、特征空间对齐的角度对域适应算法进行研究,文献[8-9]基于对抗学习的思想进行算法的拓展和改进。文献[10]结合元学习、对抗学习、正则化的思想,提出基于元学习的权重时序正则化域对抗网络。文献[11]从领域分布差异、对抗、重构和样本生成4个角度对深度域适应方法进行综述,并对跨域标签空间不同的复杂场景进行概述。

在域适应的应用方面,文献[12]总结域适应在诸如图像分类、目标检测、语义分割、姿态估计、视频动作检测等计算机视觉领域中的应用,文献[3]总结域适应方法在医学影像与计算机辅助诊断、生物序列分析、交通场景识别、推荐系统等领域的应用。此外,域适应在文本分类、情感分析、相关性提取、机器翻译等自然语言处理领域也得到了广泛应用[13]。

本文在上述研究的基础上,围绕域适应的概念、分类、代表方法、典型应用、现存挑战等方面进行研究和分析。

2 领域自适应 2.1 问题定义与基础理论参考文献[14],本文先给出域、任务、迁移学习这3个相关概念的定义,随后给出领域自适应的形式化定义。

定义1(领域

定义2(任务

进一步定义源域

定义3(迁移学习) 给定一个源域

定义4(领域自适应) 在迁移学习的设定中,假定2个域待解决的任务相同,即

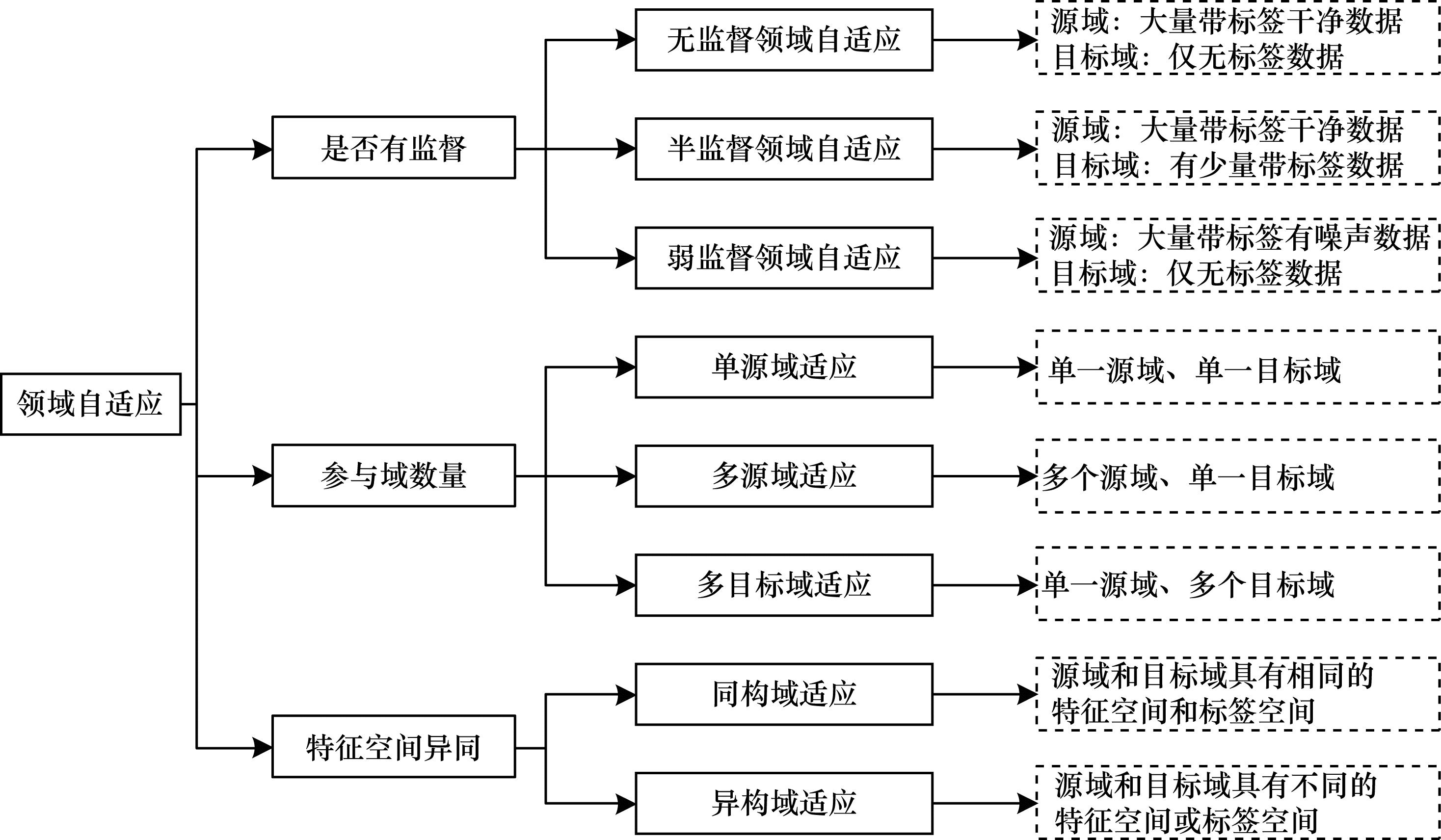

领域自适应的研究场景可按照不同维度进行划分,本文将从数据标签是否可获取、参与域的数量、跨域数据特征空间的构成3个维度对域适应算法进行分类,并简要介绍与域适应相关的其他领域。图 1所示为算法分类的整体框架。

|

Download:

|

| 图 1 领域自适应算法分类整体框架 Fig. 1 Overall framework of domain adaptation algorithms classification | |

根据源域和目标域数据标签是否可获取及其质量,可将域适应分为无监督域适应(Unsupervised Domain Adaptation,UDA)、半监督域适应(Semi-Supervised Domain Adaptation,SSDA)和弱监督域适应(Weakly-Supervised Domain Adaptation,WSDA)3类,具体如下:

1)无监督领域自适应目前得到广泛研究,其主要研究源域有大量带标签的干净数据、目标域仅有标签不可获取的少量数据的情景,即

2)半监督领域自适应研究源域有丰富的带标签数据、目标域有标签不可获取的数据和少量带标签数据的情况,即

3)弱监督领域自适应考虑源域数据不纯净、存在噪声的情况,其基本设定仍为

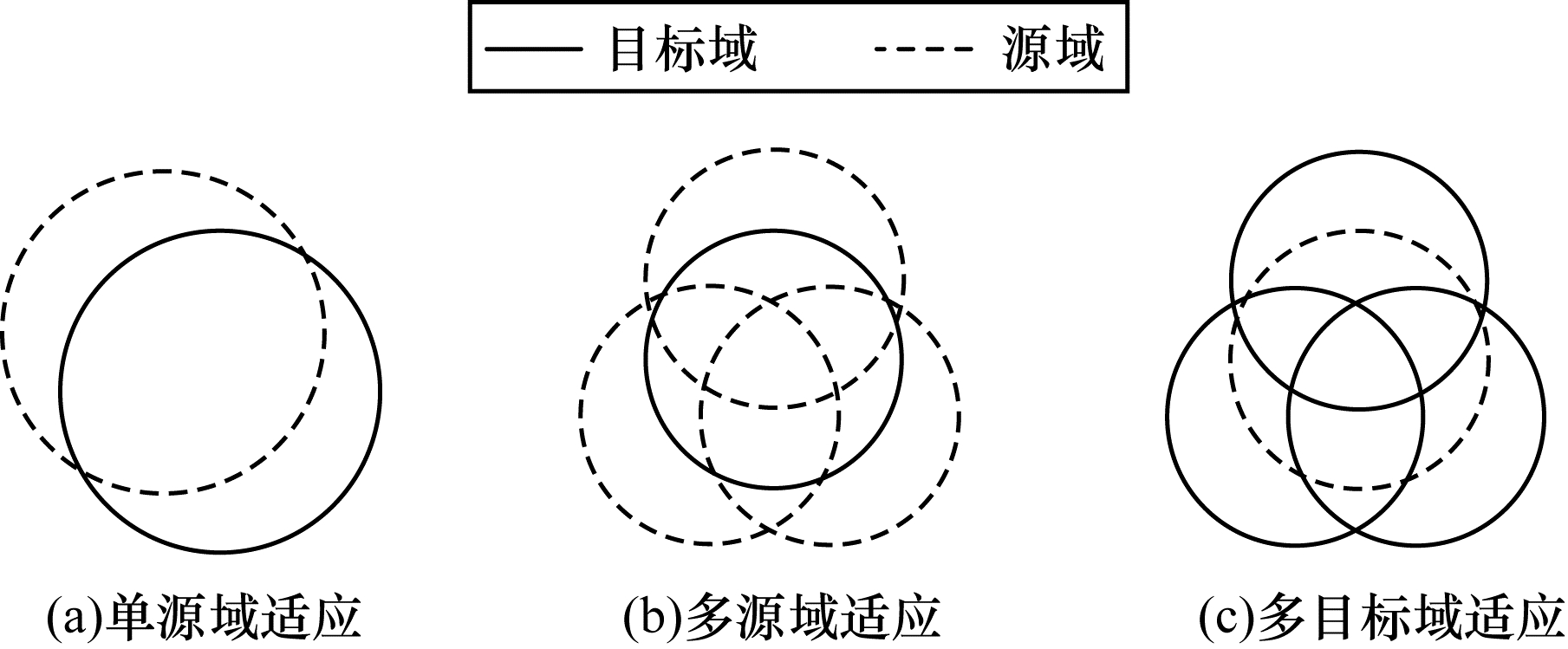

按照源域和目标域的数量,可以将域适应分为单源域适应、多源域适应和多目标域适应3类,如图 2所示。

|

Download:

|

| 图 2 域适应分类示意图 Fig. 2 Schematic diagram of domain adaptation classification | |

单源域适应只关注将单一源域的知识迁移到单一目标域的情景。传统的无监督、半监督领域自适应大多属于这一类别。

多源域适应指带标签的数据来源于多个不同的源域,不仅存在源域和目标域数据分布的差异,同时多个源域之间的数据分布也可能不同。文献[19]提出一种分布加权组合的规则,用多个源域分布的加权组合来构建目标分布。DCTN(Deep Cocktail Network)将这一规则用于对抗设置[20]。文献[21]使用多源域自适应的矩匹配网络(M3SDA)来对齐多个源域和目标域之间的分布差异等。

多目标域适应研究将源域的知识迁移到多个无标签目标域的情况,且设定源域和目标域之间、不同的目标域之间均存在数据分布的差异。针对这一设定,文献[22]提出模型参数自适应的方法,文献[23]使用信息论的方法找到所有域的特征共享子空间,以实现源域知识在多个目标域上的迁移。

2.2.3 同构异构分类根据源域和目标域数据的特征空间是否相同,可将域适应分为同构领域自适应和异构领域自适应两类。

同构领域自适应指源域和目标域样本具有相同的特征空间和标签空间,即

异构领域自适应指源域和目标域具有不同的特征空间,通常也不重叠,源域和目标域不共享特征/标签,其维度也可能不同,即

本节介绍领域泛化和小样本学习2个与领域自适应相关的概念。

领域泛化的目标是在目标域不可见的情况下,利用多个源域的带有类别标签和域标签的数据训练得到一个领域泛化的模型[25],其与领域自适应的区别在于,领域泛化在训练阶段不可获取目标域的样本,而领域自适应在训练阶段可以获取无标签的目标域样本。

小样本学习旨在根据给定的少量带标签样本和带标签的基类学习新的类别[15]。小样本学习和半监督领域自适应问题具有不同的假设:小样本学习不使用无标签的数据,其目标是获取关于新类别的知识;半监督领域自适应问题使用目标域无标签的样本用于训练,并且其目标是对新的领域中具有相同类别的样本进行适配。

2.3 基于距离度量的方法为了减少源域和目标域的数据分布差异,可以基于某种差异度量指标将源域和目标域特征映射到一个公共的再生核希尔伯特空间(RKHS)中,通过最小化域间分布差异的度量指标学习特征变换,实现源域和目标域的分布对齐,这便是基于距离度量的方法的基本思想。度量域间分布差异的指标包括KL散度、最大均值差异(MMD)、Wasserstein距离等。基于距离度量的典型方法及其特征总结如表 1所示。

|

下载CSV 表 1 基于距离度量的方法 Table 1 Methods based on distance measurement |

KL散度是两个概率分布间差异的非对称性度量。给定两个概率分布

| $ {D}_{\mathrm{K}\mathrm{L}}\left(P\Vert Q\right)=\sum\limits_{i=1}^{k}P\left(i\right)\mathrm{l}\mathrm{n}\left(\frac{P\left(i\right)}{Q\left(i\right)}\right) $ | (1) |

文献[26]中使用KL散度的对称形式,即

文献[27]将KL散度与原型网络的思想相结合,提出可迁移原型网络(Transferrable Prototypical Networks,TPN),用于解决无监督领域自适应问题,其基本思想是:首先将目标域中的每个样本与源域中最近的原型进行匹配,并为其分配“伪标签”;随后在仅基于源域数据、仅基于目标域数据、基于源域和目标域数据3种情况下分别计算得到各个类的原型;接着进行端到端的训练,同时最小化不同设定下类原型的差异以及每个样本在三种类原型下分类的类别概率分布差异。在TPN中,可以使用MMD度量类原型的差异,通过KL散度度量样本在不同类原型下分类的概率分布差异。

2.3.2 最大均值差异最大均值差异(MMD)是度量跨域分布差异时被广泛使用的度量指标。给定源域和目标域的数据分布

| $ \begin{array}{l}{d}_{\mathcal{H}}^{2}\left({\mathcal{D}}^{S}, {\mathcal{D}}^{T}\right)={M}_{\mathrm{M}\mathrm{M}\mathrm{D}}\left({X}^{S}, {X}^{T}\right)=\\ \;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;{‖\frac{1}{{n}^{S}}\sum\limits_{i=1}^{{n}^{S}}\phi \left({x}_{i}^{S}\right)-\frac{1}{{n}^{T}}\sum\limits_{j=1}^{{n}^{T}}\phi \left({x}_{j}^{T}\right)‖}_{\mathcal{H}}^{2}\end{array} $ | (2) |

其中,

在浅层域适应方法中,文献[28]提出迁移成分分析方法(TCA)[28]。TCA以MMD来度量边缘分布的差异,以散点矩阵作为约束条件来学习一个从经验核特征空间到低维特征空间的线性映射。此外,文献[29]在TCA的基础上引入MMD和流形学习的思想,提出局部保留联合分布适配的方法LPJT。LPJT期望训练得到一个特征变换矩阵,将两个域的样本映射到一个低维特征空间,并在这个特征空间中同时实现边缘概率分布和条件概率分布的最小化。

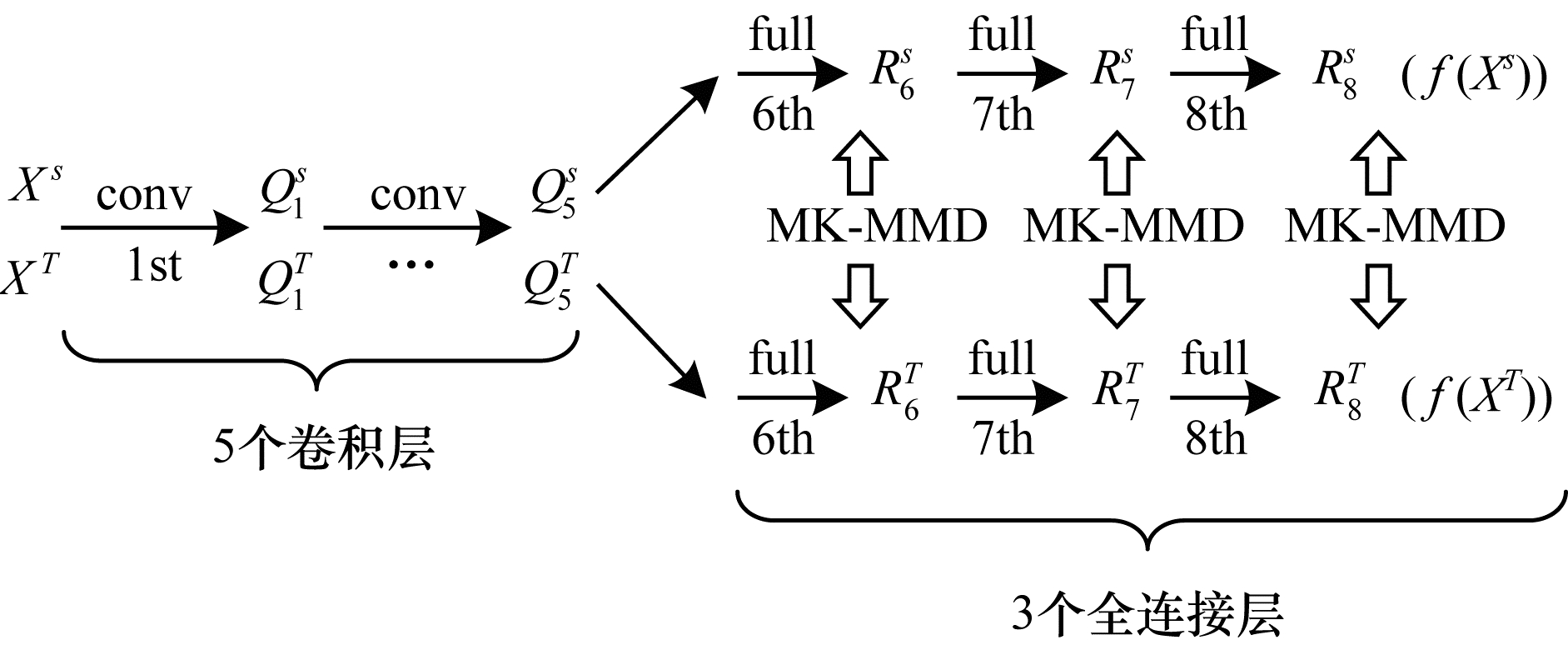

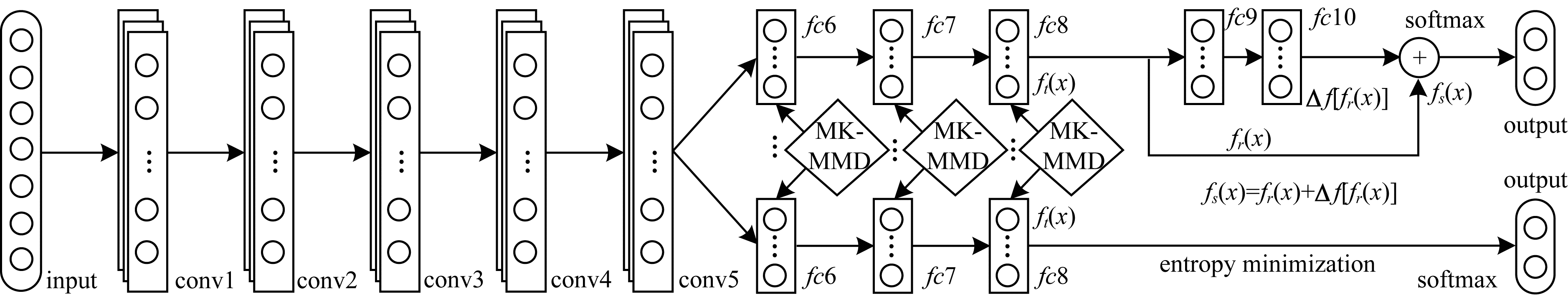

在深度域适应中,文献[30]提出深度适应网络(DAN),在假设条件概率分布保持不变的前提下,在AlexNet网络的后3层全连接层上添加对域间分布差异的度量,将最大均值差异(MMD)度量延展为多核最大均值差异(MK-MMD)度量,其网络架构如图 3所示。

|

Download:

|

| 图 3 深度适应网络架构 Fig. 3 Architecture of deep adaptation network | |

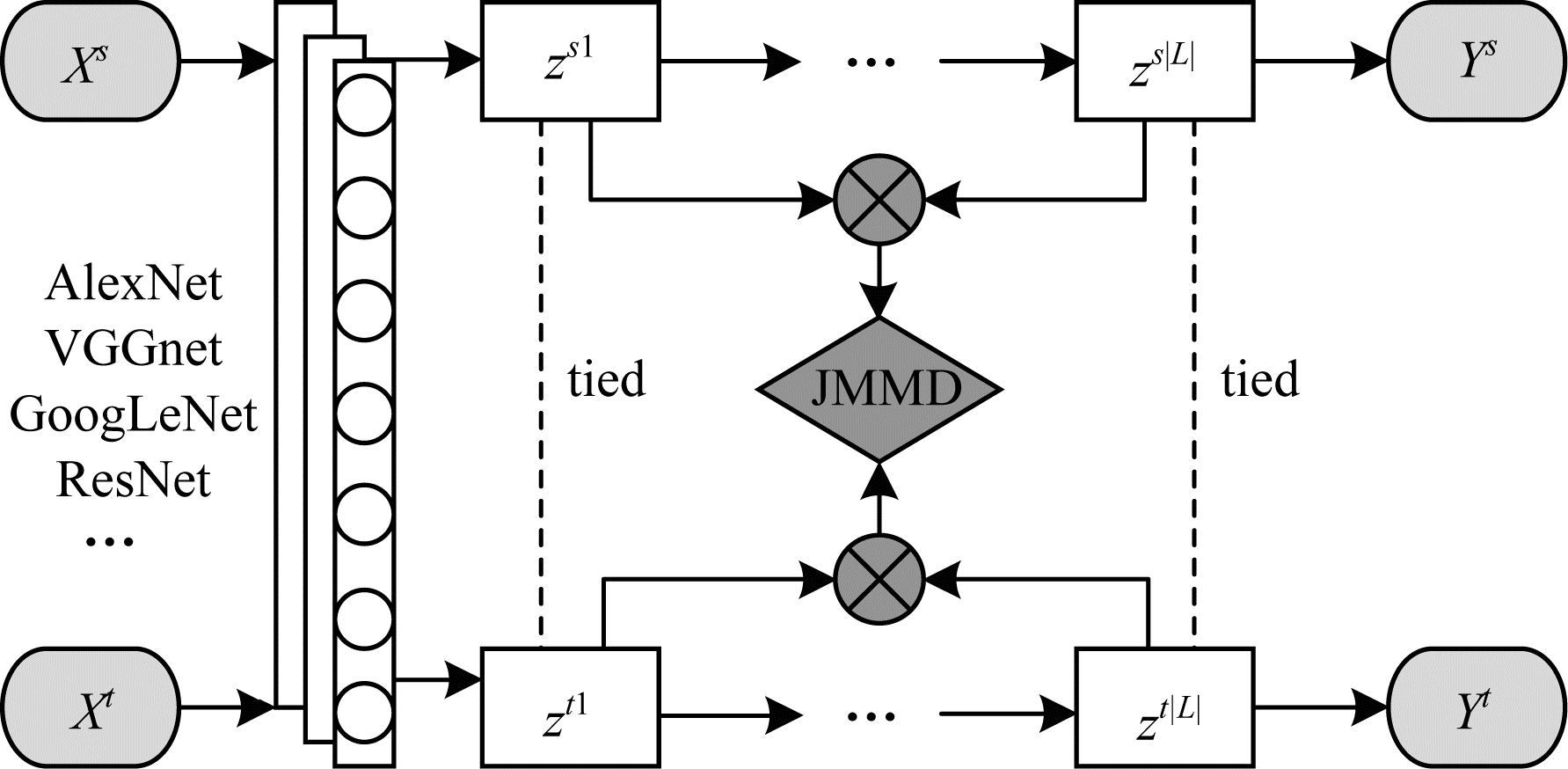

进一步考虑条件分布的偏移,联合适配网络(JAN)[31]根据联合最大平均差异(JMMD)度量,对输入特征和输出标签的联合分布差异在多个领域特定层中进行适配。JAN网络架构如图 4所示。

|

Download:

|

| 图 4 JAN网络架构 Fig. 4 Architecture of JAN network | |

文献[32]提出基于MMD对边缘分布和条件分布进行适配的DTN。除了使用MMD进行特征的适配外,残差迁移网络(RTN)[33]还添加了残差模块用于分类器的自适应。RTN网络架构如图 5所示。

|

Download:

|

| 图 5 RTN网络架构 Fig. 5 Architecture of RTN network | |

相比于KL散度、JS散度等分布差异度量指标,Wasserstein距离考虑概率空间的基本几何性质,并且能够比较无重叠的分布之间的差异。两种分布

| $ W\left({P}_{S}, {P}_{T}\right)=\underset{\gamma \in \pi \left({P}_{S}, {P}_{T}\right)}{{I}_{\mathrm{i}\mathrm{n}\mathrm{f}}}{E}_{\left(x, y\right)\sim \gamma }\left[\left|\left|x-y\right|\right|\right] $ | (3) |

其中,

| $ W\left({P}_{S}, {P}_{T}\right)=\underset{{\left|\left|f\right|\right|}_{L}\le 1}{{S}_{\mathrm{s}\mathrm{u}\mathrm{p}}}{E}_{x \sim {P}_{S}}\left[f\left(x\right)\right]-{E}_{x \sim {P}_{T}}\left[f\left(x\right)\right] $ | (4) |

其中,

文献[35]提出一种基于Wasserstein距离减小跨域特征分布差异的领域不变特征学习方法,命名为Wasserstein距离引导下的表示学习(WDGRL)。WDGRL训练一个领域评价网络,以估计源特征表示与目标特征表示之间的经验Wasserstein距离,同时以对抗的方式训练特征提取网络以最小化经验Wasserstein距离。通过迭代对抗训练,最终学习到跨域的领域不变特征表示。文献[36]提出分层Wasserstein差异(SWD),旨在捕获特定于某一任务的分类器的输出之间自然的差异性概念,其基于几何理论,提出检测远离源域支持的目标样本的方法,并能够以端到端的可训练方式进行有效的分布对齐。

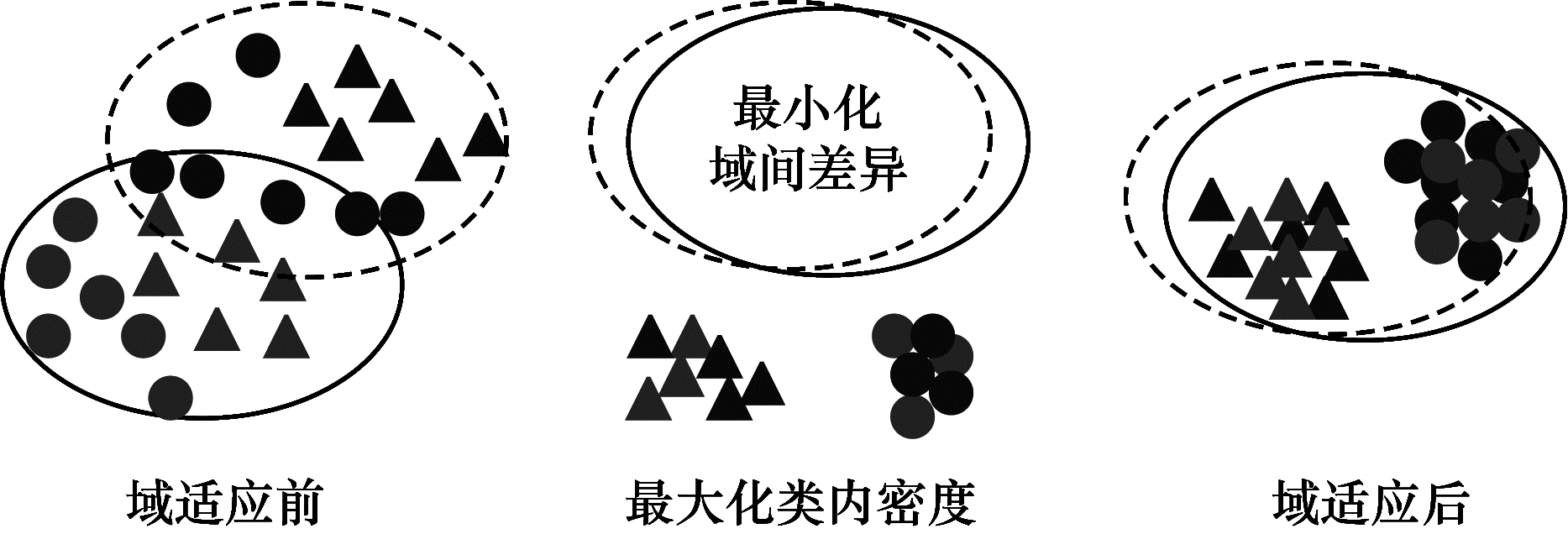

2.3.4 最大密度差异给定源域

| $ \begin{array}{l}{M}_{\mathrm{M}\mathrm{D}\mathrm{D}}\left(P, Q\right)=\\ {\mathbb{E}}_{{X}_{S} \sim P, {X}_{T} \sim Q}\left[{‖{X}_{S}-{X}_{T}‖}_{2}^{2}\right]+{\mathbb{E}}_{{\mathrm{X}}_{\mathrm{S}}, {X}_{S}^{\text{'}} \sim P}\left[{‖{X}_{S}-{X}_{S}^{\text{'}}‖}_{2}^{2}\right]+\\ {\mathbb{E}}_{{X}_{T}\mathrm{ }, {X}_{T}^{\text{'}} \sim Q}\left[{‖{X}_{T}-{X}_{T}^{\text{'}}‖}_{2}^{2}\right]\end{array} $ | (5) |

其中,

|

Download:

|

| 图 6 最大密度差异示意图 Fig. 6 Schematic diagram of maximum density difference | |

文献[37]提出最大密度差异(MDD)的概念,并将其简化后加入到对抗性领域自适应的框架中,提出一种既具有对抗性训练又具有度量学习能力的对抗性紧密匹配(ATM)领域自适应方法。

2.3.5 其他差异度量方法文献[38]提出利用阶矩差来匹配概率分布的高阶中心矩,利用矩序列对概率分布的等效表示定义一个新的距离函数,称为中心矩差异(CMD)。文献[39]使用高阶统计量(主要是三阶和四阶统计量)进行域匹配,提出一种高阶矩匹配方法(HoMM),并将其进一步扩展到再生核希尔伯特空间中。

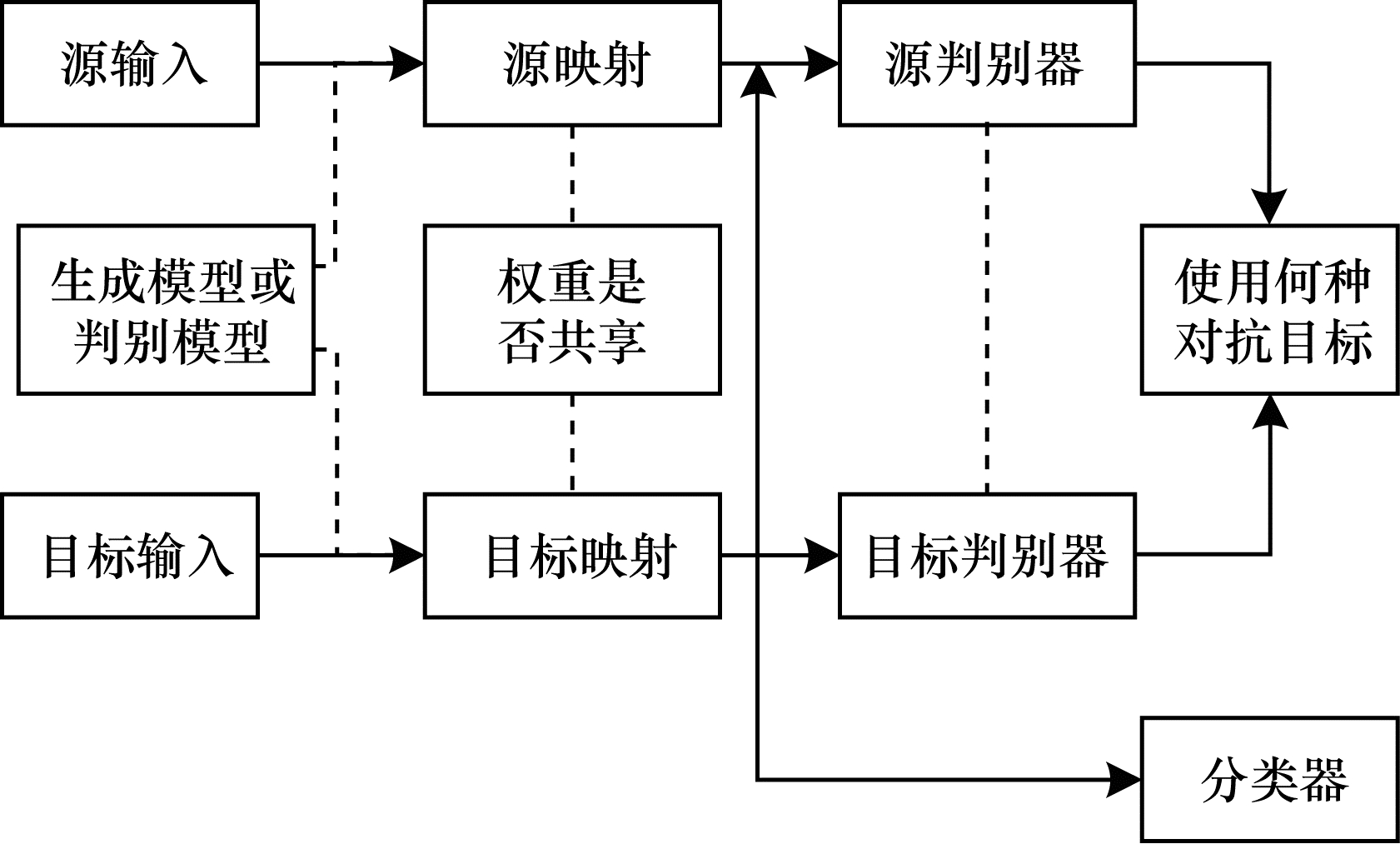

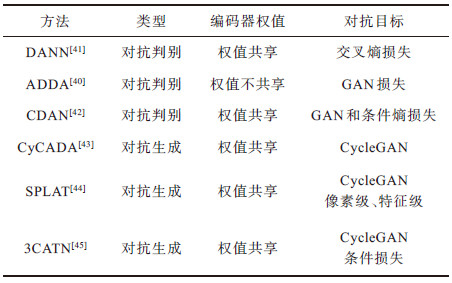

2.4 基于对抗学习的方法借鉴生成式对抗网络的思想,可以在深度方法中引入对抗的思路来进行领域自适应。基于对抗的方法可分为对抗性判别和对抗性生成两类。文献[40]从所使用损失函数的类型、是否进行权值共享以及所基于的模型为生成式模型还是判别式模型3个角度,对基于对抗学习的域适应方法进行归类,并提出一个通用的框架,如图 7所示。基于对抗学习的典型方法及其特征总结如表 2所示。

|

Download:

|

| 图 7 基于对抗学习的域适应方法通用框架 Fig. 7 General framework of domain adaptation methods based on confrontation learning | |

|

下载CSV 表 2 基于对抗学习的方法分类 Table 2 Classification of methods based on confrontation learning |

基于对抗性判别的域适应方法虽然使用了不同的对抗策略,但其基本思想都是在域鉴别器上施加一个对抗性目标将域间分布差异的度量转化为在潜在特征空间中进行领域混淆,以此对特征提取器进行训练从而实现特征级的领域自适应。

用

| $ \left\{\begin{array}{l}\underset{{\theta }_{C}\mathrm{ }, {\theta }_{F}}{\mathrm{m}\mathrm{i}\mathrm{n}}\mathrm{ }{\mathcal{L}}_{C}\left({\mathcal{D}}_{S}\mathrm{ }, {\mathcal{Y}}_{S};{\theta }_{C}\mathrm{ }, {\theta }_{F}\right)-\lambda {\mathcal{L}}_{D}\left({\mathcal{D}}_{S}\mathrm{ }, {\mathcal{D}}_{T}\mathrm{ }, {\theta }_{D};{\theta }_{F}\right)\\ \underset{{\theta }_{D}}{\mathrm{m}\mathrm{i}\mathrm{n}}\mathrm{ }{\mathcal{L}}_{D}\left({\mathcal{D}}_{S}\mathrm{ }, {\mathcal{D}}_{T}\mathrm{ }, {\theta }_{F}\mathrm{ };{\theta }_{D}\right)\end{array}\right. $ | (6) |

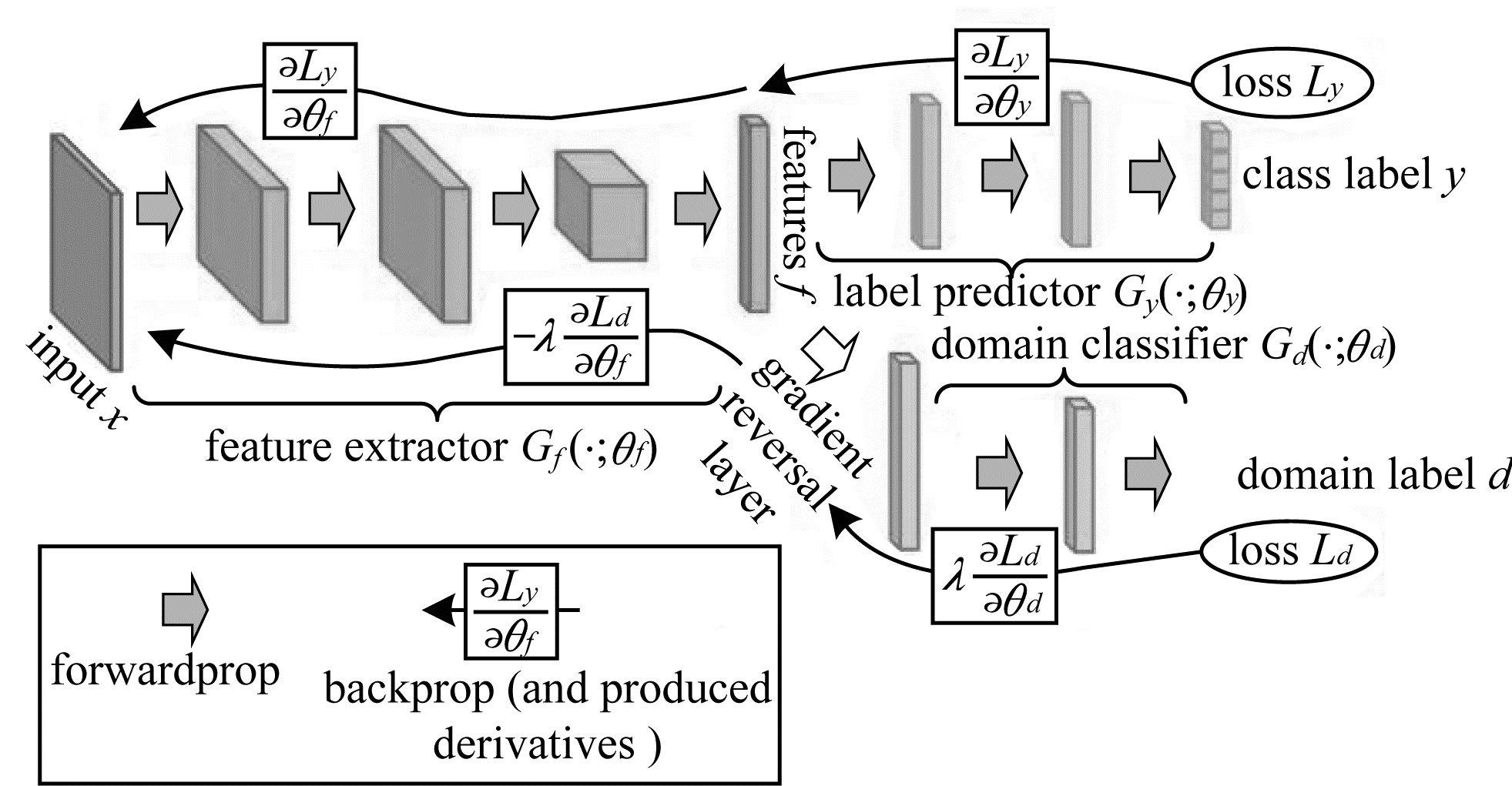

域对抗网络(DANN)[41]基于上述的通用框架而提出,其架构由一个特征提取器、一个分类器和一个领域鉴别器构成,如图 8所示。DANN中融入了GAN的生成对抗思想,其训练可以通过插入特定的梯度反转层(GRL)来实现。

|

Download:

|

| 图 8 DANN网络架构 Fig. 8 Architecture of DANN network | |

文献[40]提出对抗判别域适应(Adversarial Discriminative Domain Adaptation,ADDA)方法,使用一个标签翻转的GAN损失将优化过程分为生成器和判别器两个独立的目标,其目标函数设置为:

| $ \begin{array}{l}\underset{{M}_{s}\mathrm{ }, C}{\mathrm{m}\mathrm{i}\mathrm{n}}\mathrm{ }{\mathcal{L}}_{\mathrm{c}\mathrm{l}\mathrm{s}}\left({X}_{s}\mathrm{ }, {Y}_{s}\right)=\\-{\mathbb{E}}_{\left({x}_{s}\mathrm{ }, {y}_{s}\right) \sim \left({X}_{s}\mathrm{ }, {Y}_{s}\right)}\sum\limits_{k=1}^{K}{1}_{\left[k={y}_{s}\right]}\mathrm{l}\mathrm{o}{\mathrm{g}}_{a}C\left({M}_{S}\left({x}_{s}\right)\right)\\ \underset{D}{\mathrm{m}\mathrm{i}\mathrm{n}}\mathrm{ }{\mathcal{L}}_{\mathrm{a}\mathrm{d}{\mathrm{v}}_{D}}\left({X}_{s}\mathrm{ }, {X}_{t}\mathrm{ }, {M}_{s}\mathrm{ }, {M}_{t}\right)=\\-{\mathbb{E}}_{{x}_{s} \sim {X}_{s}}\left[\mathrm{l}\mathrm{o}{\mathrm{g}}_{a}D\left({M}_{s}\left({x}_{s}\right)\right)\right]-\\ {\mathbb{E}}_{{x}_{t} \sim {X}_{t}}\left[\mathrm{l}\mathrm{o}{\mathrm{g}}_{a}\left(1-D\left({M}_{t}\left({x}_{t}\right)\right)\right)\right]·\\ \underset{{M}_{t}}{\mathrm{m}\mathrm{i}\mathrm{n}}\mathrm{ }{\mathcal{L}}_{\mathrm{a}\mathrm{d}{\mathrm{v}}_{M}}\left({X}_{s}\mathrm{ }, {X}_{t}\mathrm{ }, D\right)=\\ -{\mathbb{E}}_{{x}_{t} \sim {X}_{t}}\left[\mathrm{l}\mathrm{o}{\mathrm{g}}_{a}D\left({M}_{t}\left({x}_{t}\right)\right)\right]\end{array} $ | (7) |

其中,

除了对齐边缘分布外,文献[42]提出条件对抗域适应方法(CDAN),考虑对齐条件概率分布来促进两个域间的域适应。在DANN的基础上,将分类器的预测g作为特征表示f所依赖的条件,通过联合变量h=(f,g)引入分类预测g来对域判别器

基于GAN的生成式方法属于像素级的领域自适应,生成从源域到目标域的图像,并通过训练使得生成的图像与从目标域分布中采样得到的图像相同,从而实现领域的混淆。此外,基于CycleGAN的损失,学者们提出了一些有效的域适应方法。

HOFFMAN等[43]提出循环一致对抗域适应方法(CyCADA),在保证语义一致性的同时,在像素级和特征级都进行跨域适配。在适应过程中使用循环一致性损失匹配结构和语义一致性,并基于特定的视觉识别任务来实现语义损失。语义损失既指导总体表示具有判别性,又在映射前后保证了跨域的语义一致性。类似地,TZENG等[44]使用像素级对齐和特征级对齐对目标检测任务执行领域自适应。

LI等[45]扩展了先前基于CycleGAN的研究,将条件对抗域适应方法与循环一致性损失相结合,提出循环一致条件对抗迁移网络(3CATN)方法来对齐两个域。利用特征与对应的类别预测的协方差来部署条件域判别器,以捕获嵌入在数据中的复杂多峰结构,同时考虑到域不变特征变换由两个域共享,可以相互表示的特性,训练两个特征转换器,一个将特征从源域转换到目标域,另一个将特征从目标域转换到源域,并基于两个特征转换器来计算循环一致性损失,由此在捕获数据复杂多峰结构的同时,避免由于条件不正确而造成的负面影响。

2.5 其他代表性方法 2.5.1 基于重构的方法文献[46]设计基于重构的思想解决领域自适应问题的代表性方法,其提出了深度重构分类网络(DRCN),这是一种联合学习有监督地预测源域标签和无监督地对目标域数据进行重构的卷积网络。DRCN的编码参数在两个任务之间共享,而解码参数彼此分离,目的是使所学的标签预测函数能够很好地对目标区域内的样本进行分类,从而将数据重构视为支持标签预测自适应的辅助任务。

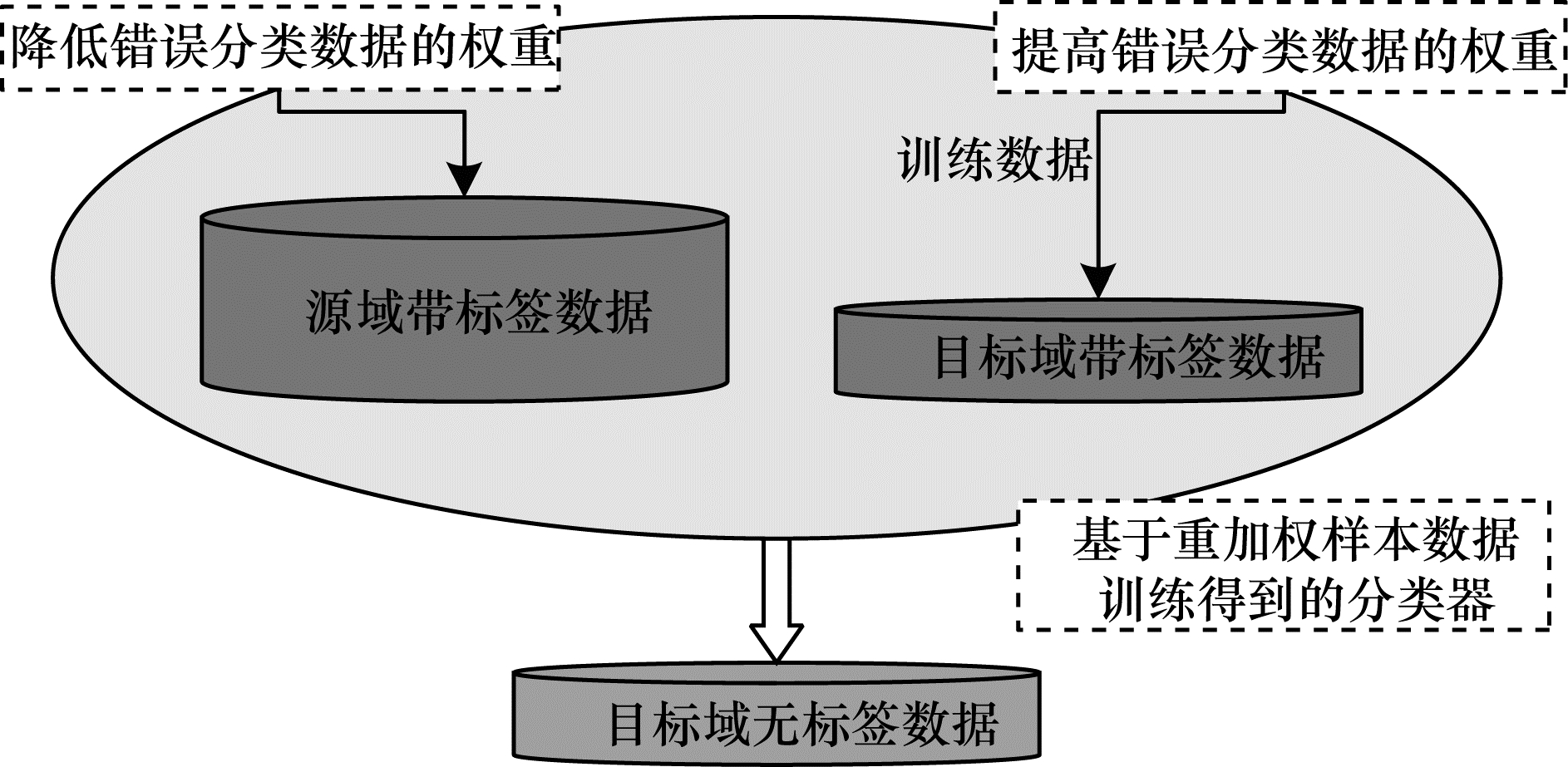

2.5.2 基于样本选择的方法在早期的浅层域适应方法中,对实例进行重加权来克服两个域间数据边缘概率分布的偏差从而实现领域自适应,这是最常见的方法之一,其核心思想是计算一个样本实例归属于源域实例或目标域实例的似然比,用这一比例来对样本进行赋权。

通过计算两个域间数据分布的最大均值差异(MMD)来对数据样本加权是常用的方法。此外,基于AdaBoost的迁移自适应增强方法(TrAdaBoost)[47]也是实例权重法的典型代表,其训练过程如图 9所示,在训练目标分类器的过程中,与传统的AdaBoost方法相同,提高目标域中错误分类实例的权重,同时降低源域中错误分类实例的权重,从而缓解其对训练过程的影响,然后在权重更新后的实例上继续进行目标分类器的训练,如此迭代地更新源域和目标域的实例权重。

|

Download:

|

| 图 9 TrAdaBoost方法原理说明 Fig. 9 Principle explanation of TrAdaBoost method | |

考虑部分域适应的设定,即目标域的类别少于源域的类别(

本节介绍被广泛用于度量不同方法在跨域自适应任务中性能表现的标准数据集,并对代表性方法在典型任务中的实验结果进行总结。

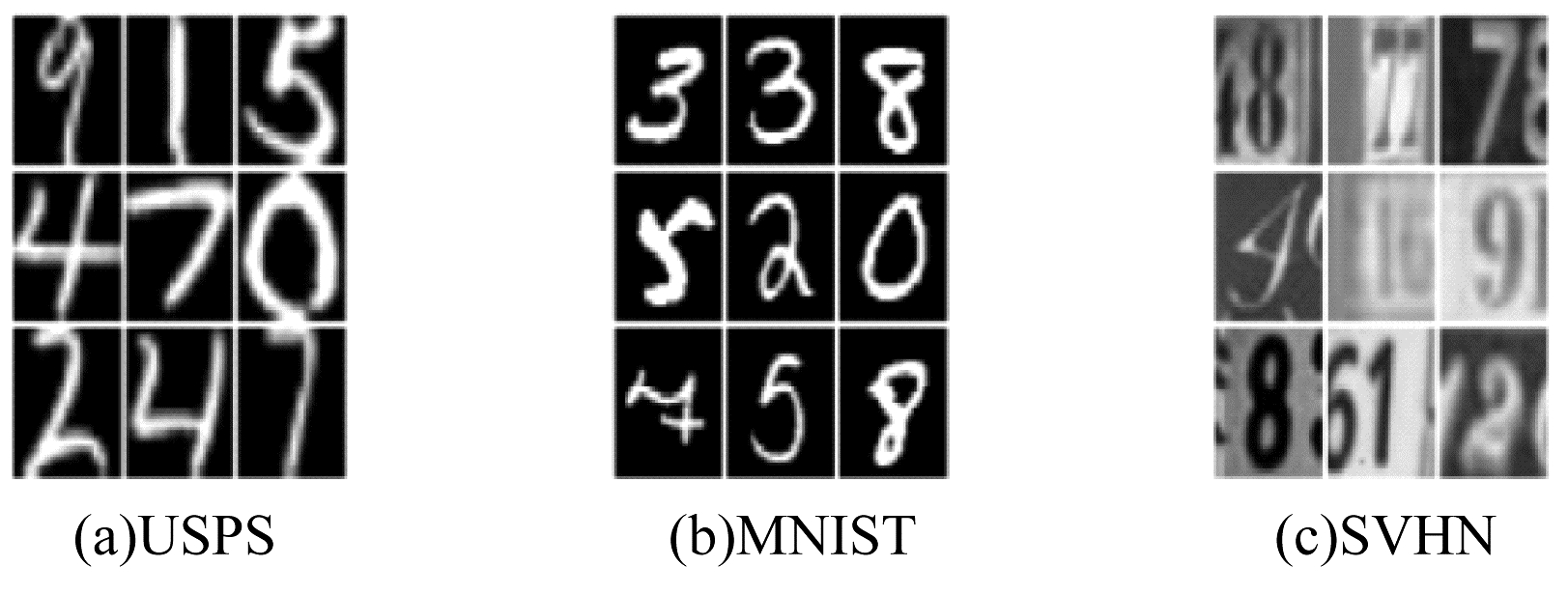

2.6.1 数据集Digits数字数据集包含MNIST[50]、USPS、SVHN[51]3个数据集,MNIST、USPS为包含0~9共10个数字的具有不同分布的手写数字数据集,MNIST包含共70 000张28×28的灰度图像,其中,60 000张作为训练数据,10 000张用于测试。USPS包含尺寸为16×16的7 291张和2 007张灰度图像分别用于训练和测试。SVHN为街景数字图像数据集,其中的数字图像包含更为复杂的街景背景,该数据集共包含73 257张尺寸为32×32的彩色图像用于训练,以及26 032张图像用于测试。上述3个数据集图片样例如图 10所示。

|

Download:

|

| 图 10 Digits数据集图片样例 Fig. 10 Image examples of Digits dataset | |

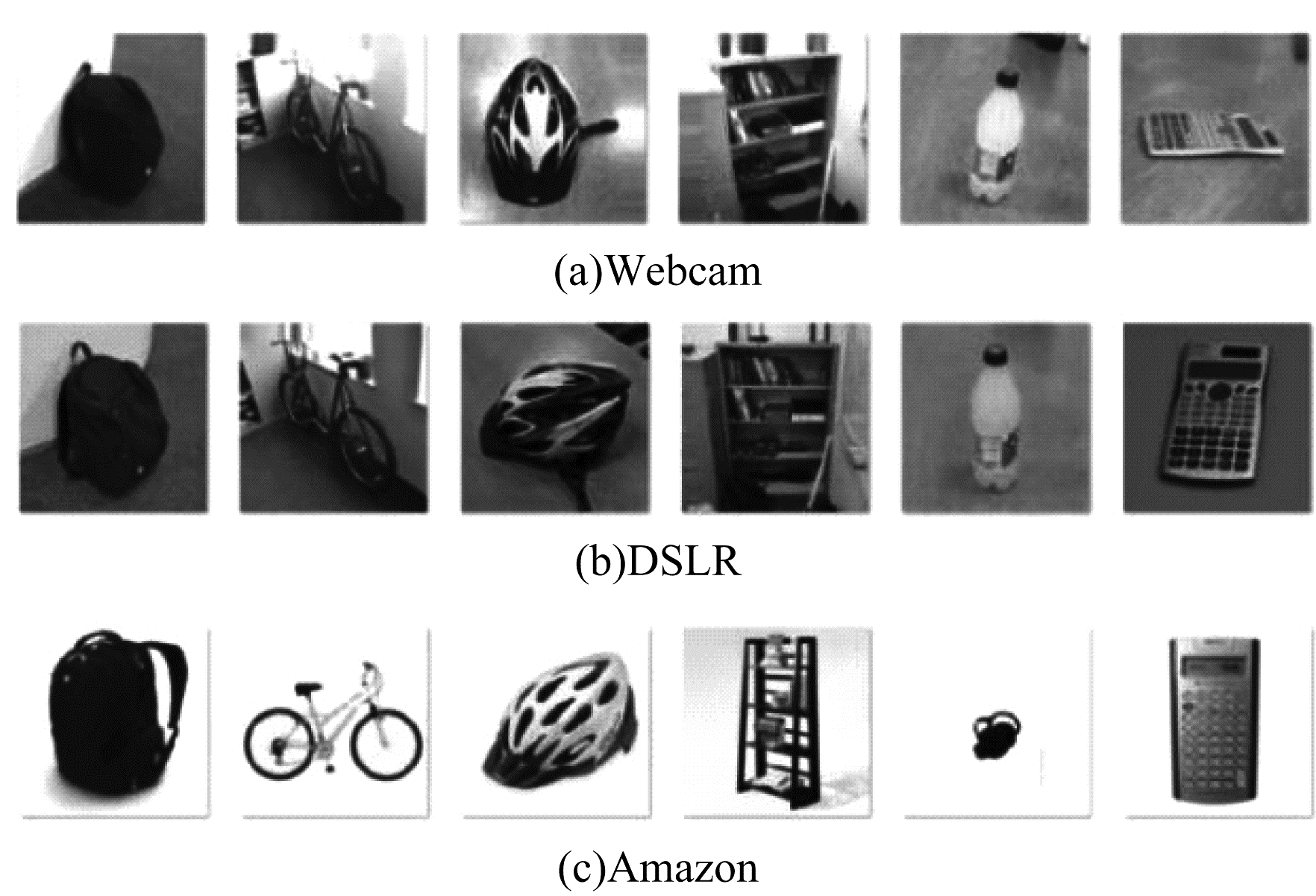

Office-31数据集[52]是经典的视觉域适应基准数据集,包含来自Amazon(A)、DSLR(D)和Webcam(W)三个不同的域、涵盖31个类别的4 110张图片,其中,Amazon(A)为电商网站中的展示图片,DSLR(D)为数码单反相机拍摄的图片,Webcam(W)为图像处理软件处理后的图片。A、D、W数据集的样本数量分别为2 817、498和795,数据集图片示例如图 11所示。

|

Download:

|

| 图 11 Office-31数据集图片示例 Fig. 11 Image examples of Office-31 dataset | |

Office-Home数据集是一个相对较新的基准,包含来自4个领域65个类别的15 585张图片。4个领域具体如下:

1)艺术(Ar):以素描、绘画、装饰等形式对物体进行的艺术描绘。

2)剪贴画(Cl):剪贴画图像的收集。

3)产品(Pr):没有背景的对象图像,类似于Office数据集中Amazon类别的图像。

4)真实世界(RW):用普通相机捕捉到的对象图像。

Ar、Cl、Pr和RW域中分别包含2 421、4 379、4 428和4 357张图像[53]。

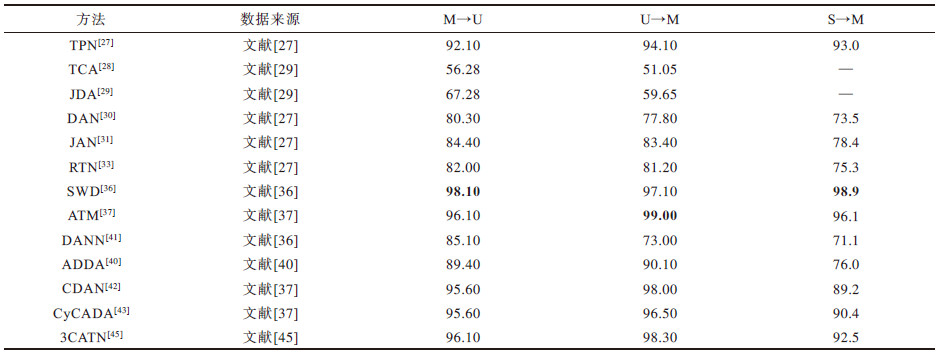

2.6.2 实验结果在结果评测中,均采用目标域数据样本分类正确率作为算法性能的度量指标。表 3所示为Digits数据集上几种代表性方法在MNIST→USPS(M→U)、USPS→MNIST(U→M)、SVHN→MNIST(S→M)3个域适应任务中的测试结果,其中最优结果加粗表示。

|

下载CSV 表 3 不同方法在Digits数字数据集上的性能对比 Table 3 Performance comparison of different methods on Digits digital dataset |

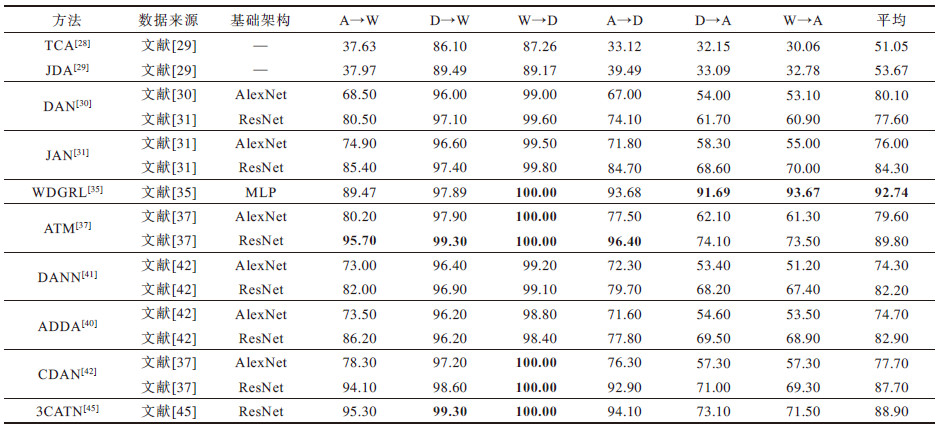

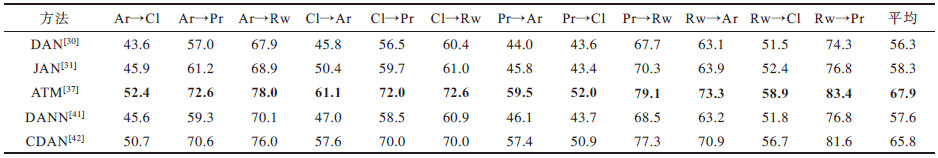

表 4所示为在Office-31数据集上构建的A→D、A→W、D→A、D→W、W→A、W→D 6个域适应任务中各代表性方法的性能表现。表 5所示为Office-Home数据集上12个跨域适配任务中各方法的性能表现。

|

下载CSV 表 4 不同方法在Office-31数据集上的性能对比 Table 4 Performance comparison of different methods on Office-31 dataset |

|

下载CSV 表 5 不同方法在Office-Home数据集上的性能对比 Table 5 Performance comparison of different methods on Office-Home dataset |

图像分类是计算机视觉应用的基本任务,上述大多数领域自适应算法[32-33]在最初提出时都是用来解决图像分类问题的,并在诸如Digits、Office-31、Office-Home、VisDA-2017等标准数据集的跨域图像分类任务中测试算法性能。

2.7.2 目标检测近年来,基于候选区域的卷积神经网络(R-CNNs、Fast R-CNNs和Faster R-CNNs)在目标检测方面取得了重要进展,然而,训练每个类别检测窗口需要大量带标签的数据,考虑到窗口选择机制与领域无关,深度域适应的方法可用于分类器的跨域适应。大规模自适应检测(LSDA)[54]对目标域的分类层进行训练,然后使用预先训练好的源模型和输出层自适应技术直接更新目标分类参数。文献[55]基于Faster R-CNNs方法,从特征图和区域自适应两个角度切入,提出改进的域适应多场景目标检测模型,并将其应用于多场景道路车辆检测中。此外,文献[56-58]也致力于研究领域自适应在目标检测领域的应用。

2.7.3 自然语言处理领域自适应技术已经在自然语言处理领域得到了广泛应用,包括情感分析[59]、文本分类[60]、关系提取[61]、问答系统[62]和机器翻译[63]等方面。

2.7.4 推荐系统传统的推荐系统通常依赖于用户与项目交互矩阵来进行推荐和预测,这些方法通常需要大量的训练数据才能得出准确的建议。然而,诸如用户的历史交互数据在现实场景中往往稀少。领域自适应技术可以利用来自其他推荐系统(即源域)的数据来帮助在目标域中构建推荐系统。在基于实例的方法中,文献[64]利用源域不确定评级作为约束条件,帮助完成目标域上的评级矩阵分解任务。在基于特征的方法中,文献[65]提出一种称为“坐标系统迁移(CST)”的方法,同时利用用户侧和物品侧的潜在特征。文献[66]基于矩阵分解技术生成用户和物品的特征表示,然后使用深度神经网络来学习跨域的特征映射。此外,文献[67-68]也研究了域适应方法在跨域推荐系统中的应用。

3 现存挑战及未来研究方向目前已有的领域自适应方法主要分为基于距离度量的方法和基于对抗学习的方法。基于距离度量的方法多使用已有的几种距离度量指标,如MMD等,通过变换形式不断重复使用,但是对度量指标本身的研究非常有限。已有的研究结果表明,仅使用现有的距离度量指标,很难取得令人满意的迁移学习效果。基于对抗学习的方法虽然在近年来得到广泛应用与关注,但是对抗网络中存在泛化和均衡等固有挑战,使得基于对抗学习的方法难以保证模型的泛化能力。

3.1 流式数据与在线持续迁移学习在已有算法研究中,通常认为可在同一时刻获取大量的源域带标签数据,并且这些数据具有相似的分布,但是在现实应用中,源域的数据往往以流式形态而不断产生,并不能在某一时刻获得大量的数据,同时不同时间产生的源域数据也可能具有不同的数据分布。如何识别源域数据中的概念漂移以及进行增量域适应和在线域适应是有待研究的问题。同时,当数据以不断进化的方式产生时,如何处理不同时期的模型灾难性遗忘问题也成为迁移学习中的难点。当前已有一些学者针对持续学习展开研究,今后可将持续学习和迁移学习相结合,以应对流式数据中存在的挑战。

3.2 语义分歧与开放集迁移学习目前大多领域自适应算法研究封闭集中的跨域知识迁移,即通常假设源域和目标域共享类别标签,但是在现实场景中,源域和目标域具有相同的类别标签空间这一假设往往并不成立,存在源域数据类别多于目标域、目标域数据类别多于源域等情况。针对前者,文献[48-49]尝试对源域实例加权来增强跨域共享标签实例的重要性;针对后者,可以通过零样本学习、小样本学习的技术学习关于新类别的知识[69-71]。目前,针对开放集的跨域迁移仍有待进一步研究。

3.3 数据隐私与数据访问受限的迁移学习目前的领域自适应方法大多假设带标签的源域数据可以不受限制地获取,在现实场景中,与目标域相关的源域或辅助领域数据可能来自于另外的机构和个人,可能无法访问数据的全部信息。在此类情况下,如何在进行跨域知识迁移的同时保护数据的隐私是一个重要问题。开发基于模型参数而非数据特征的域适应技术以及开发基于加密数据的域适应技术是可供选择的研究方向。此外,领域泛化为目标域数据访问受限的迁移学习提供了一些思路。

3.4 负迁移负迁移是领域自适应中被广泛讨论的挑战之一。领域自适应的目标是使用源域的知识来提升目标任务的性能,但是在有些情况下存在引入源域的知识会带来目标模型性能下降的问题,即产生负迁移现象,其原因是源域和目标域具有较低的相关性,相关性越小,则可供迁移的领域不变知识越少,学习到的跨领域噪声越多。如何衡量跨域的可迁移性以及避免负迁移仍是该领域的一个重要问题,未来可设计对应的相关性量化指标。

4 结束语模型的迁移能力和泛化能力是通用人工智能所面临的两大挑战。领域自适应技术为当前人工智能迈向通用人工智能提供了可行方案,也是在有限标记数据的情况下最大化数据利用率的有效方法。本文针对基于度量学习的方法和基于对抗学习的方法,对领域自适应进行总结,阐述领域自适应的产生背景及国内外研究现状,给出相关概念和领域自适应的形式化定义,并从不同的视角对相关研究领域和方法进行分类。在此基础上,围绕基于距离度量学习的方法和基于对抗学习的方法介绍该领域代表性算法的技术细节,并分析域适应在学界和业界不同领域中的应用情况以及现存的挑战。今后将对领域自适应研究中的现实鸿沟、语义鸿沟、数据隐私和负迁移问题进行分析。

| [1] |

WANG M, DENG W. Deep visual domain adaptation: a survey[J]. Neurocomputing, 2018, 312: 135-153. DOI:10.1016/j.neucom.2018.05.083 |

| [2] |

TAN Chuanqi, SUN Fuchun, KONG Tao, et al. A survey on deep transfer learning[C]//Proceedings of International Conference on Artificial Neural Networks. Berlin, Germany: Springer, 2018: 270-279.

|

| [3] |

ZHUANG Fuzhen, LUO Ping, HE Qing, et al. Research progress of transfer learning[J]. Journal of Software, 2015, 26(1): 26-39. (in Chinese) 庄福振, 罗平, 何清, 等. 迁移学习研究进展[J]. 软件学报, 2015, 26(1): 26-39. |

| [4] |

LIU Jianwei, SUN Zhengkang, LUO Xionglin. Research progress of domain adaptation learning[J]. Acta Automatica Sinica, 2014, 41(8): 1576-1600. (in Chinese) 刘建伟, 孙正康, 罗雄麟. 域自适应学习研究进展[J]. 自动化学报, 2014, 41(8): 1576-1600. |

| [5] |

ZHAO S, YUE X, ZHANG S, et al. A review of single-source deep unsupervised visual domain adaptation[EB/OL]. [2020-12-20]. https://arxiv.org/pdf/2009.00155.pdf.

|

| [6] |

XU Hao, LI Zongyin, GUO Weibin. Multi-level and step-by-step domain adaptation in image classification[J]. Journal of Chinese Computer Systems, 2019, 40(9): 1921-1925. (in Chinese) 许浩, 李宗印, 郭卫斌. 多层面的分步领域适应图像分类算法[J]. 小型微型计算机系统, 2019, 40(9): 1921-1925. DOI:10.3969/j.issn.1000-1220.2019.09.020 |

| [7] |

BI Chaoyang. Research on domain adaptation method based on feature selection[D]. Guangzhou: South China University of Technology, 2019. (in Chinese) 毕朝阳. 基于特征选择的领域自适应方法研究[D]. 广州: 华南理工大学, 2019. |

| [8] |

WANG Gege, GUO Tao, YU You, et al. Unsupervised domain adaptation classification model based on generative confrontation network[J]. Chinese Journal of Electronics, 2019, 48(6): 1190-1197. (in Chinese) 王格格, 郭涛, 余游, 等. 基于生成对抗网络的无监督域适应分类模型[J]. 电子学报, 2019, 48(6): 1190-1197. |

| [9] |

MAO Xiaofeng. Research on deep vision domain adaptation method based on adversarial learning[D]. Harbin: Harbin Engineering University, 2019. (in Chinese) 毛潇锋. 基于对抗学习的深度视觉域适应方法研究[D]. 哈尔滨: 哈尔滨工程大学, 2019. |

| [10] |

CHEN Di. Research on domain adaptation algorithm based on confrontation and regularization method[D]. Chendu: University of Electronic Science and Technology of China, 2020. (in Chinese) 陈迪. 基于对抗和正则化方法的域适应算法研究[D]. 成都: 电子科技大学, 2020. |

| [11] |

FAN Cangning, LIU Peng, XIAO Ting, et al. A review of depth domain adaptation: general and complex situations[J]. Acta Automatica Sinica, 2020, 47(3): 515-548. (in Chinese) 范苍宁, 刘鹏, 肖婷, 等. 深度域适应综述: 一般情况与复杂情况[J]. 自动化学报, 2020, 47(3): 515-548. |

| [12] |

CSURKA G. Domain adaptation for visual applications: a comprehensive survey[EB/OL]. [2020-12-20]. https://arxiv.org/pdf/1702.05374.pdf.

|

| [13] |

WILSON G, COOK D J. A survey of unsupervised deep domain adaptation[J]. ACM Transactions on Intelligent Systems and Technology, 2020, 11(5): 40-46. |

| [14] |

PAN S J, YANG Q. A survey on transfer learning[J]. IEEE Transactions on Knowledge and Data Engineering, 2009, 22(10): 1345-1359. |

| [15] |

SAITO K, KIM D, SCLAROFF S, et al. Semi-supervised domain adaptation via minimax entropy[C]//Proceedings of IEEE International Conference on Computer Vision. Washington D.C., USA: IEEE Press, 2019: 8050-8058.

|

| [16] |

KIM T, KIM C. Attract, perturb, and explore: learning a feature alignment network for semi-supervised domain adaptation[C]//Proceedings of European Conference on Computer Vision. Berlin, Germany: Springer, 2020: 591-607.

|

| [17] |

LIU F, LU J, HAN B, et al. Butterfly: a panacea for all difficulties in wildly unsupervised domain adaptation[EB/OL]. [2020-12-20]. https://arxiv.org/pdf/1905.07720v2.pdf.

|

| [18] |

SHU Y, CAO Z, LONG M, et al. Transferable curriculum for weakly-supervised domain adaptation[C]//Proceedings of AAAI Conference on Artificial Intelligence. New York, USA: ACM Press, 2019: 4951-4958.

|

| [19] |

MANSOUR Y, MOHRI M, ROSTAMIZADEH A. Domain adaptation with multiple sources[J]. Advances in Neural Information Processing Systems, 2008, 21: 1041-1048. |

| [20] |

XU R, CHEN Z, ZUO W, et al. Deep cocktail network: multi-source unsupervised domain adaptation with category shift[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Washington D.C., USA: IEEE Press, 2018: 3964-3973.

|

| [21] |

PENG X, BAI Q, XIA X, et al. Moment matching for multi-source domain adaptation[C]//Proceedings of IEEE International Conference on Computer Vision. Washington D.C., USA: IEEE Press, 2019: 1406-1415.

|

| [22] |

YU H, HU M, CHEN S. Multi-target unsupervised domain adaptation without exactly shared categories[EB/OL]. [2020-12-20]. https://arxiv.org/pdf/1809.00852.pdf.

|

| [23] |

GHOLAMI B, SAHU P, RUDOVIC O, et al. Unsupervised multi-target domain adaptation: an information theoretic approach[J]. IEEE Transactions on Image Processing, 2020, 29: 3993-4002. DOI:10.1109/TIP.2019.2963389 |

| [24] |

LI J, LU K, HUANG Z, et al. Heterogeneous domain adaptation through progressive alignment[J]. IEEE Transactions on Neural Networks and Learning Systems, 2018, 30(5): 1381-1391. |

| [25] |

MATSUURA T, HARADA T. Domain generalization using a mixture of multiple latent domains[C]//Proceedings of AAAI Conference on Artificial Intelligence. New York, USA: ACM Press, 2020: 11749-11756.

|

| [26] |

ZHUANG F, CHENG X, LUO P, et al. Supervised representation learning: transfer learning with deep autoencoders[C]//Proceedings of the 24th International Joint Conference on Artificial Intelligence. Washington D.C., USA: IEEE Press, 2015: 15-28.

|

| [27] |

PAN Y, YAO T, LI Y, et al. Transferrable prototypical networks for unsupervised domain adaptation[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Washington D.C., USA: IEEE Press, 2019: 2239-2247.

|

| [28] |

PAN S J, TSANG I W, KWOK J T, et al. Domain adaptation via transfer component analysis[J]. IEEE Transactions on Neural Networks, 2010, 22(2): 199-210. |

| [29] |

LI J, JING M, LU K, et al. Locality preserving joint transfer for domain adaptation[J]. IEEE Transactions on Image Processing, 2019, 28(12): 6103-6115. DOI:10.1109/TIP.2019.2924174 |

| [30] |

LONG M, CAO Y, WANG J, et al. Learning transferable features with deep adaptation networks[EB/OL]. [2020-12-20]. http://ise.thss.tsinghua.edu.cn/~mlong/doc/deep-adaptation-networks-icml15.pdf.

|

| [31] |

LONG M, ZHU H, WANG J, et al. Deep transfer learning with joint adaptation networks[C]//Proceedings of the 34th International Conference on Machine Learning. Washington D.C., USA: IEEE Press, 2017: 2208-2217.

|

| [32] |

LI J, LU K, HUANG Z, et al. Transfer independently together: a generalized framework for domain adaptation[J]. IEEE Transactions on Cybernetics, 2018, 49(6): 2144-2155. |

| [33] |

LI J, ZHAO J, LU K. Joint feature selection and structure preservation for domain adaptation[C]//Proceedings of International Joint Conference on Artificial Intelligence. Washington D.C., USA: IEEE Press, 2016: 1697-1703.

|

| [34] |

XU P, GURRAM P, WHIPPS G, et al. Wasserstein distance based domain adaptation for object detection[EB/OL]. [2020-12-20]. https://arxiv.org/pdf/1909.08675.pdf.

|

| [35] |

SHEN J, QU Y, ZHANG W, et al. Wasserstein distance guided representation learning for domain adaptation[EB/OL]. [2020-12-20]. https://arxiv.org/pdf/1707.01217v2.pdf.

|

| [36] |

LEE C Y, BATRA T, BAIG M H, et al. Sliced wasserstein discrepancy for unsupervised domain adaptation[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Washington D.C., USA: IEEE Press, 2019: 10285-10295.

|

| [37] |

LI J, CHEN E, DING Z, et al. Maximum density divergence for domain adaptation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2020, 35(3): 12-35. |

| [38] |

ZELLINGER W, GRUBINGER T, LUGHOFER E, et al. Central moment discrepancy for domain-invariant representation learning[EB/OL]. [2020-12-20]. https://arxiv.org/pdf/1702.08811.pdf.

|

| [39] |

CHEN C, FU Z, CHEN Z, et al. HoMM: higher-order moment matching for unsupervised domain adaptation[J]. Order, 2020, 1(10): 20-21. |

| [40] |

TZENG E, HOFFMAN J, SAENKO K, et al. Adversarial discriminative domain adaptation[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Washington D.C., USA: IEEE Press, 2017: 7167-7176.

|

| [41] |

GANIN Y, USTINOVA E, AJAKAN H, et al. Domain-adversarial training of neural networks[J]. The Journal of Machine Learning Research, 2016, 17(1): 2096-2030. |

| [42] |

LONG M, CAO Z, WANG J, et al. Conditional adversarial domain adaptation[EB/OL]. [2020-12-20]. https://arxiv.org/pdf/1705.10667.pdf.

|

| [43] |

HOFFMAN J, TZENG E, PARK T, et al. Cycada: cycle-consistent adversarial domain adaptation[C]//Proceedings of International Conference on Machine Learning. Washington D.C., USA: IEEE Press, 2018: 1989-1998.

|

| [44] |

TZENG E, BURNS K, SAENKO K, et al. SPLAT: semantic pixel-level adaptation transforms for detection[EB/OL]. [2020-12-20]. https://www.researchgate.net/publication/329387982_SPLAT_Semantic_Pixel-Level_Adaptation_Transforms_for_Detection.

|

| [45] |

LI J, CHEN E, DING Z, et al. Cycle-consistent conditional adversarial transfer networks[C]//Proceedings of the 27th ACM International Conference on Multimedia. New York, USA: ACM Press, 2019: 747-755.

|

| [46] |

GHIFARY M, KLEIJN W B, ZHANG M, et al. Deep reconstruction-classification networks for unsupervised domain adaptation[C]//Proceedings of European Conference on Computer Vision. Berlin, Germany: Springer, 2016: 597-613.

|

| [47] |

DAI W, YANG Q, XUE G R, et al. Boosting for transfer learning[C]//Proceedings of the 24th International Conference on Machine learning. Washington D.C., USA: IEEE Press, 2007: 193-200.

|

| [48] |

ZHANG J, DING Z, LI W, et al. Importance weighted adversarial nets for partial domain adaptation[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Washington D.C., USA: IEEE Press, 2018: 8156-8164.

|

| [49] |

CAO Z, LONG M, WANG J, et al. Partial transfer learning with selective adversarial networks[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Washington D.C., USA: IEEE Press, 2018: 2724-2732.

|

| [50] |

LECUN Y, BOTTOU L, BENGIO Y, et al. Gradient-based learning applied to document recognition[J]. Proceedings of the IEEE, 1998, 86(11): 2278-2324. DOI:10.1109/5.726791 |

| [51] |

NETZER Y, WANG T, COATES A, et al. Reading Digits in natural images with unsupervised feature learning[EB/OL]. [2020-12-20]. https://www.researchgate.net/publication/266031774_Reading_Digits_in_Natural_Images_with_Unsupervised_Feature_Learning.

|

| [52] |

SAENKO K, KULIS B, FRITZ M, et al. Adapting visual category models to new domains[C]//Proceedings of European Conference on Computer Vision. Berlin, Germany: Springer, 2010: 213-226.

|

| [53] |

ZHANG L. Transfer adaptation learning: a decade survey[EB/OL]. [2020-12-20]. https://arxiv.org/pdf/1903.04687.pdf.

|

| [54] |

HOFFMAN J, GUADARRAMA S, TZENG E S, et al. LSDA: large scale detection through adaptation[J]. Advances in Neural Information Processing Systems, 2014, 27: 3536-3544. |

| [55] |

WANG Ling. Research and application of domain adaptation algorithm[D]. Nanjing: Nanjing University of Aeronautics and Astronautics, 2019. (in Chinese) 王翎. 域适应算法研究及应用[D]. 南京: 南京航空航天大学, 2019. |

| [56] |

CHEN Y, LI W, SAKARIDIS C, et al. Domain adaptive Faster R-CNN for object detection in the wild[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Washington D.C., USA: IEEE Press, 2018: 3339-3348.

|

| [57] |

HOFFMAN J, WANG D, YU F, et al. FCNs in the wild: pixel-level adversarial and constraint-based adaptation[EB/OL]. [2020-12-20]. https://arxiv.org/pdf/1612.02649.pdf.

|

| [58] |

INOUE N, FURUTA R, YAMASAKI T, et al. Cross-domain weakly-supervised object detection through progressive domain adaptation[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Washington D.C., USA: IEEE Press, 2018: 5001-5009.

|

| [59] |

ZHANG Y, BARZILAY R, JAAKKOLA T. Aspect-augmented adversarial networks for domain adaptation[J]. Transactions of the Association for Computational Linguistics, 2017, 5: 515-528. DOI:10.1162/tacl_a_00077 |

| [60] |

LIU P, QIU X, HUANG X. Adversarial multi-task learning for text classification[EB/OL]. [2020-12-20]. https://arxiv.org/pdf/1704.05742.pdf.

|

| [61] |

FU L, NGUYEN T H, MIN B, et al. Domain adaptation for relation extraction with domain adversarial neural network[C]//Proceedings of the 8th International Joint Conference on Natural Language Processing. New York, USA: ACM Press, 2017: 425-429.

|

| [62] |

YANG Z, HU J, SALAKHUTDINOV R, et al. Semi-supervised QA with generative domain-adaptive nets[EB/OL]. [2020-12-20]. https://arxiv.org/pdf/1702.02206.pdf.

|

| [63] |

BRITZ D, LE Q, PRYZANT R. Effective domain mixing for neural machine translation[C]//Proceedings of the 2nd Conference on Machine Translation. Washington D.C., USA: IEEE Press, 2017: 118-126.

|

| [64] |

PAN W, XIANG E W, YANG Q. Transfer learning in collaborative filtering with uncertain ratings[C]//Proceedings of AAAI Conference on Artificial Intelligence. Washington D.C., USA: IEEE Press, 2012: 662-668.

|

| [65] |

PAN W, XIANG E W, LIU N N, et al. Transfer learning in collaborative filtering for sparsity reduction[C]//Proceedings of AAAI Conference on Artificial Intelligence. Washington D.C., USA: IEEE Press, 2010: 230-235.

|

| [66] |

LI J, LU K, HUANG Z, et al. On both cold-start and long-tail recommendation with social data[J]. IEEE Transactions on Knowledge and Data Engineering, 2019, 33(1): 194-208. |

| [67] |

LI J, LU K, HUANG Z, et al. Two birds one stone: on both cold-start and long-tail recommendation[C]//Proceedings of the 25th ACM International Conference on Multimedia. New York, USA: ACM Press, 2017: 898-906.

|

| [68] |

ZHUANG F, ZHENG J, CHEN J, et al. Transfer collaborative filtering from multiple sources via consensus regularization[J]. Neural Networks, 2018, 108: 287-295. DOI:10.1016/j.neunet.2018.08.022 |

| [69] |

LI J, JING M, ZHU L, et al. Learning modality-invariant latent representations for generalized zero-shot learning[C]//Proceedings of the 28th ACM International Conference on Multimedia. New York, USA: ACM Press, 2020: 1348-1356.

|

| [70] |

LI J, JING M, LU K, et al. Leveraging the invariant side of generative zero-shot learning[C]//Proceedings of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Washington D.C., USA: IEEE Press, 2019: 7402-7411.

|

| [71] |

LI J, JING M, LU K, et al. From zero-shot learning to cold-start recommendation[C]//Proceedings of AAAI Conference on Artificial Intelligence. Washington D.C., USA: IEEE Press, 2019: 4189-4196.

|

2021, Vol. 47

2021, Vol. 47