开放科学(资源服务)标志码(OSID):

随着科技的飞速发展,网络成为人们获取信息的有效途径。然而,面对这些海量的网络信息,人们从中挑选出真正感兴趣的信息变得异常困难。作为信息抽取[1]的重要组成部分,事件抽取的研究具有重要的现实意义。事件抽取[2]技术的主要作用是为用户抽取结构化信息,从而提高用户的工作效率。事件抽取在自动文摘[3]、信息检索[4]、自动问答[4]、情报收集[5]等领域有着广泛的应用。在事件抽取任务中触发词抽取的研究很有必要,因为触发词直接引起事件发生,事件类型主要由触发词决定。触发词抽取的步骤就是先判断出触发词,然后划分出触发词属于的事件类别。

近年来,事件抽取得到了许多研究机构和研究者越来越多的关注。作为事件抽取领域最具有影响力的评测会议,自动内容抽取(Automatic Content Extraction,ACE)评测会议对事件[6]的定义如下:事件是指发生了的事情,包含直接引起事件发生的触发词和事件的参与者。以S1为例阐述触发词抽取任务,如在S1中,包含Life_Die和Conflict_Attack 2种事件,其对应的触发词分别为died和fired。

S1:In Baghdad,a cameraman died when an American tank fired on the Palestine Hotel.(在巴格达,当一架美国坦克向巴勒斯坦酒店开火时,一名摄影师死亡。)

作为信息抽取领域的重要研究方向,事件抽取在近年来得到了人们的关注,国内外研究人员也纷纷展开了对事件抽取的研究。AHN等[4]提出的MaxEnt方法采用最大熵模型进行事件抽取,将事件抽取任务分为若干串行的子任务;LIAO等[7]提出基于跨事件推理的事件抽取模型;HONG等[8]提出采用跨实体推理的方法进行事件触发词的抽取;LI等[9]提出在基于结构化感知机的基础上,将触发词识别和元素识别相结合,利用多种局部特征和全局特征,从而更有效地提高了抽取的效果。以上这些方法在特征提取过程中过分依赖自然语言处理工具,容易出现错误传播和数据稀疏的问题。

随着词向量在自然语言处理领域的成功应用,词向量技术吸引了事件抽取研究者的关注,并在事件抽取任务中运用词向量技术。NGUYEN等[10]使用CNN自动挖掘隐含特征,取得了良好的效果;CHEN等[11]提出一种DMCNN模型,该模型增加一个动态多池化层,使得模型能够抽取到多个事件,达到较好的抽取效果。除CNN的特征学习模型外,还有研究者采用循环神经网络(RNN)对文本中的序列信息进行建模。NGUYEN等[12]设计一种双向循环神经网络的联合框架,实现了触发词与元素的联合抽取模型,并探究了多种不同的记忆特征;陈斌等[13]提出一种事件触发词抽取方法,该方法将卷积神经网络和长短期记忆网络相结合进行事件触发词抽取;LIU等[14]分别利用多种有监督和无监督机制挖掘实体信息,在测试集元素未知和元素已知的条件下,研究对触发词抽取产生的作用。

将CNN和BiGRU模型融合在很多关联领域或其他领域都有应用。郑巧夺等[6]提出用双层CNN-BiGRU-CRF模型进行事件因果关系的抽取;王丽亚等[15]提出在CNN-BiGRU模型中引入注意力机制来进行文本情感分析,都取得了较好的效果。因此,将CNN和BiGRU模型进行融合是完全具有必要性和可行性的。

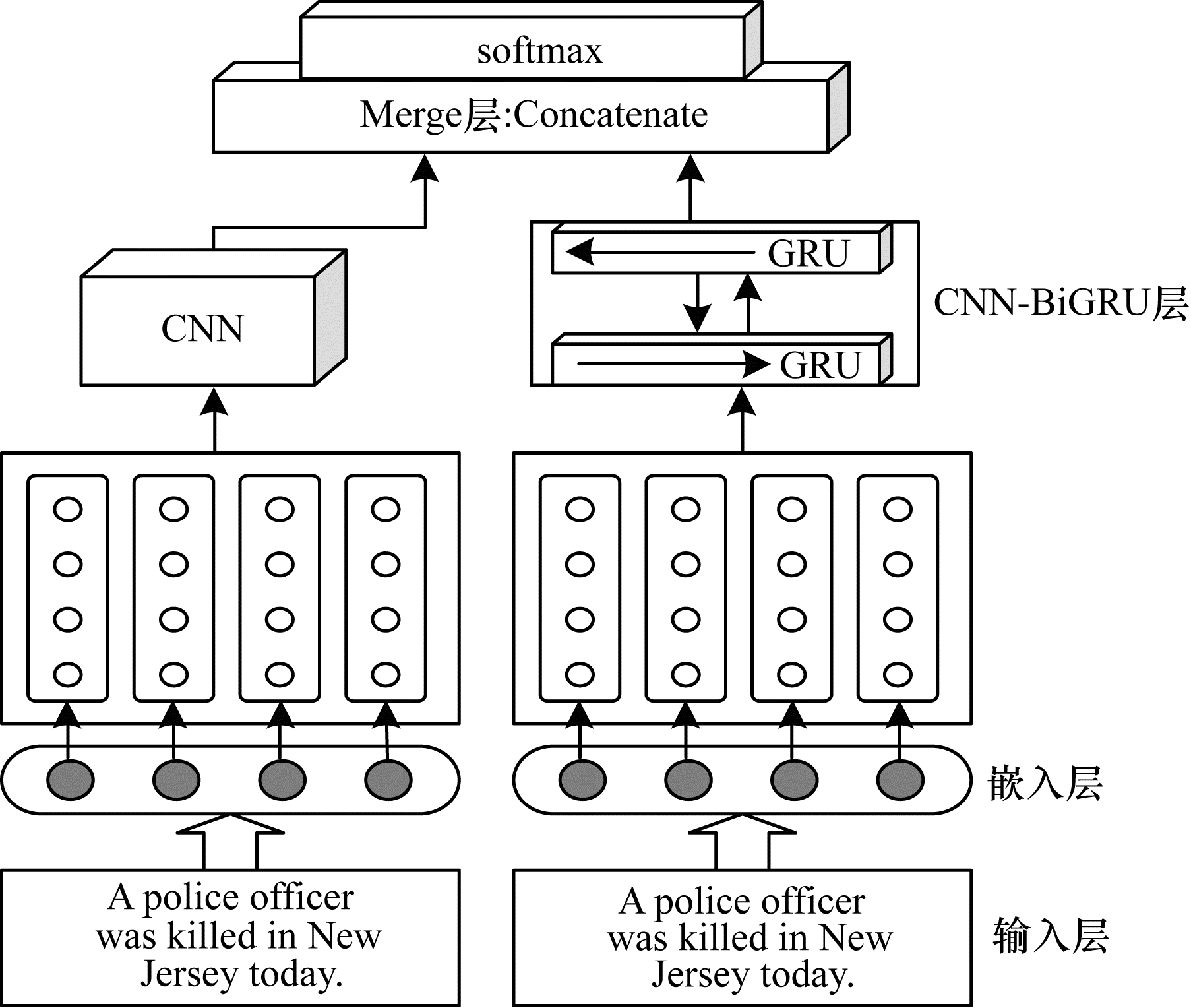

本文提出双向门控循环单元(CNN-BiGRU)模型并运用于事件触发词抽取任务中。该模型通过CNN提取词级别特征,利用BiGRU获取文本上下文语义信息得到句子级别特征,对词级别特征和句子级别特征进行拼接,最后通过softmax层对提取出的事件相关特征进行分类,识别触发词并预测触发词所属事件类别。

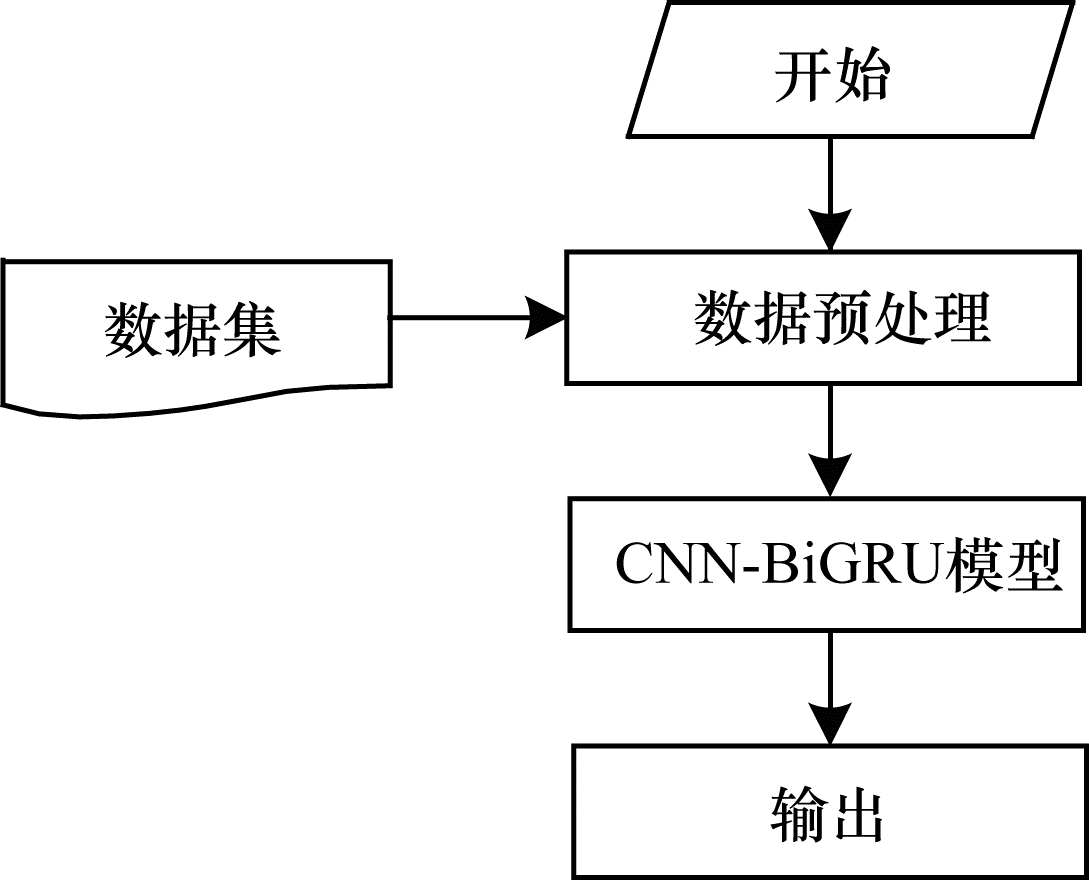

1 CNN-BiGRU模型本节介绍一种新的事件触发词抽取模型CNN-BiGRU。该模型通过融合CNN和BiGRU进行事件触发词抽取,模型流程结构如图 1所示。

|

Download:

|

| 图 1 CNN-BiGRU模型整体流程 Fig. 1 Overall procedure of CNN-BiGRU model | |

输入映射层是将句子序列中的每个词转换为向量表达,将文本数据表示为计算机能够理解的方式。一个句子序列可表示为:

| $ S=\{{W}_{1}, {W}_{2}, \cdots , {W}_{n}\} $ | (1) |

其中:n表示句子的长度,即S中单词的个数;Wi表示句子中第i个单词,本文将每个单词Wi转化为实值向量Xi,Xi由词向量和位置向量拼接而成。

一个长度为n的句子序列可表示为:

| $ \boldsymbol{X}=\{{\boldsymbol{X}}_{1}, {\boldsymbol{X}}_{2}, \cdots , {\boldsymbol{X}}_{n}\} $ | (2) |

其中:Xi表示X中每个单词的特征向量。

本文将句子的最大长度设置为50,因为在CNN中一般会将输入向量设定为固定的长度。如果句子长度大于50,则截取前50个单词作为该句子;如果句子长度小于50,则采用补零的方式将句子补齐。

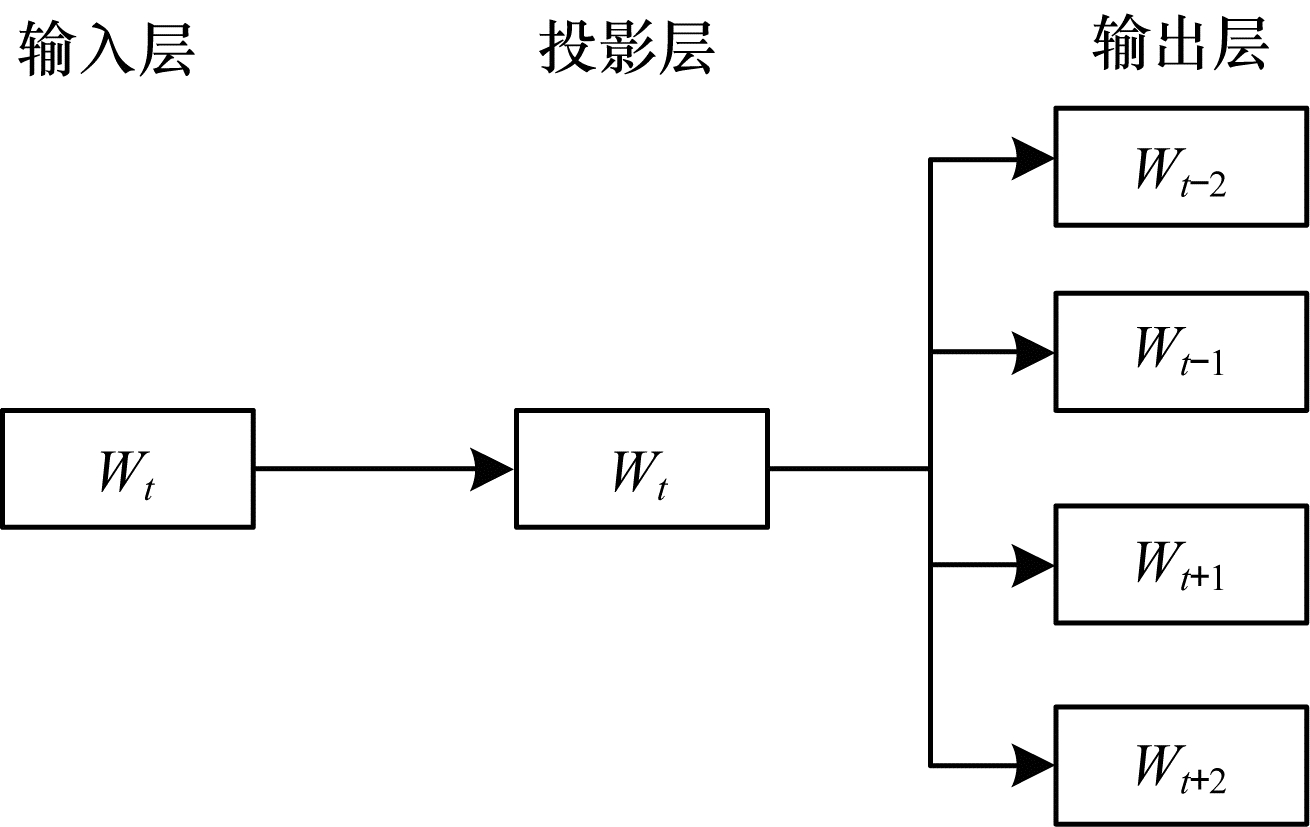

1.1.1 词向量词向量是表示词语特征的最常用方式,具有良好的语义特征,是把深度学习相关模型引入到自然语言处理领域的一个关键技术。本文的实验采用谷歌预训练的Word2vec词向量表进行初始化。Word2vec技术包括CBOW和Skip-gram 2种模型。CBOW模型是已知当前词的上下文,对当前词进行预测;Skip-gram模型恰恰相反,是已知当前词的情况下对其上下文进行预测。本文的训练方式采用Skip-gram模型,其模型结构如图 2所示。本文采用300维的词向量来表示词语特征,单词Wi的词向量表示为V(Wi)。

|

Download:

|

| 图 2 skip-gram模型结构 Fig. 2 Structure of skip-gram model | |

位置向量[16]形成的方式是通过随机初始化,它代表上下文单词在窗口中的相对位置。本文采用50维的位置向量来表示位置特征,单词Wi的位置向量表示为V(pei)。

综上所述,单词Wi的特征向量Xi可表示为:

| $ {\boldsymbol{X}}_{i}=\boldsymbol{V}\left({W}_{i}\right)\oplus \boldsymbol{V}\left(p{e}_{i}\right) $ | (3) |

其中:表示将词向量和位置向量拼接,

本文通过CNN和BiGRU将词级别特征与句子级别特征相结合提高触发词的抽取效果。

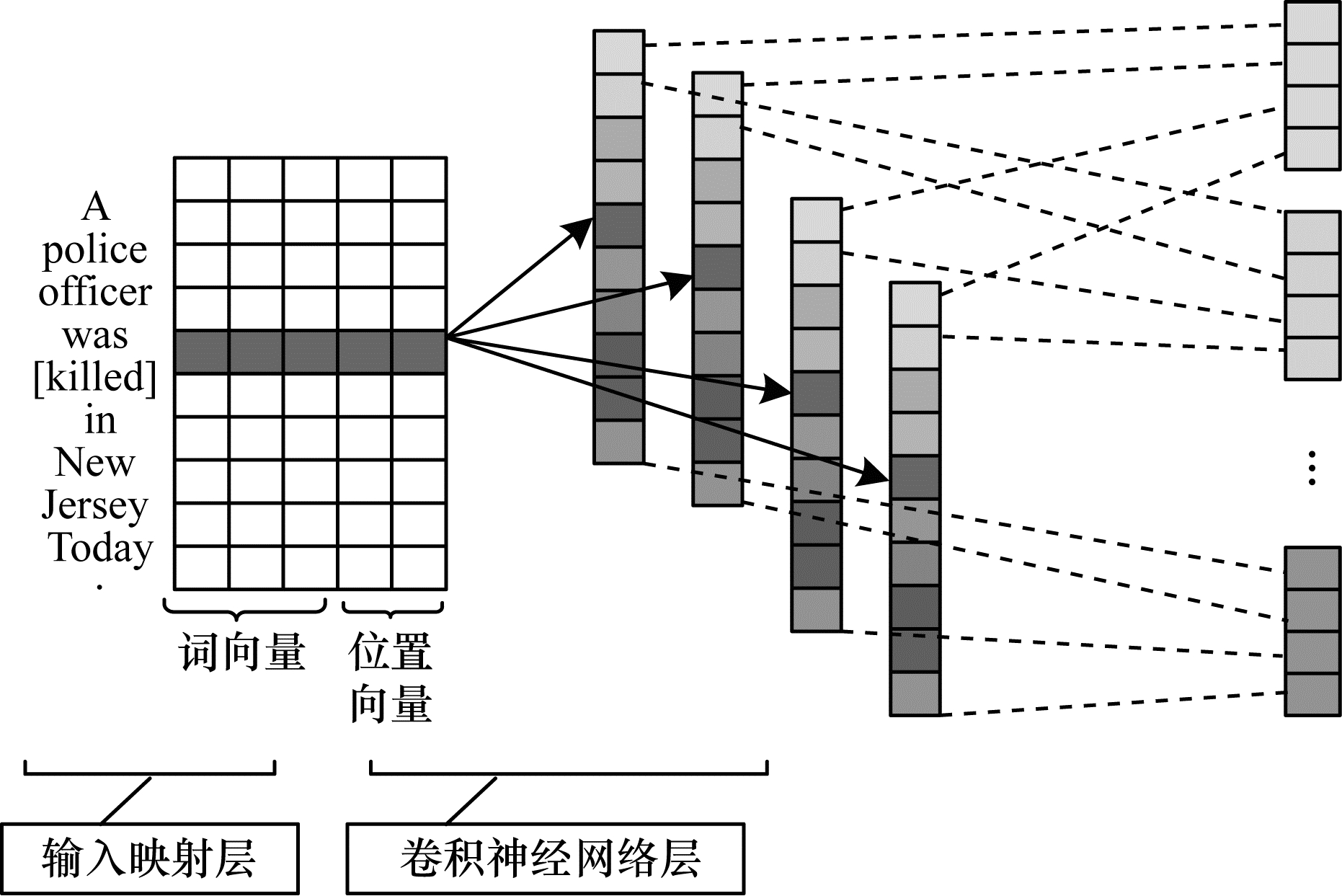

1.2.1 CNN词级别特征提取CNN[17]是一种前馈神经网络,本文主要利用卷积神经网络的特性,对句子中的每个词提取局部特征,最后以特征图的形式表现出来。触发词抽取是一个由序列到标签的分类问题,卷积就相当于采用卷积核在输入矩阵上滑动进行乘积求和的一个过程。

卷积过程如图 3所示,给定句子的向量表示

|

Download:

|

| 图 3 基于卷积的词级别特征提取 Fig. 3 Lexical-level feature extraction based on convolution | |

设计一个

| $ {\boldsymbol{c}}_{i}=f(u\cdot {X}_{i-k/2:i+k/2}+b) $ | (4) |

其中:Xi-k/2:i+k/2表示单词Wi周围k个单词的特征;f表示一个非线性激活函数;b表示一个偏置量;ci代表单词Wi通过卷积操作得到的局部特征。

将卷积核扫描句子中的每个单词,最终可得到整个句子的特征图:

| $ g=[{c}_{1}, {c}_{2}, \cdots , {c}_{n}] $ | (5) |

其中:

本文设计一个卷积集合

| $ \boldsymbol{C}=[{g}_{1}, {g}_{2}, \cdots , {g}_{m}] $ | (6) |

其中:

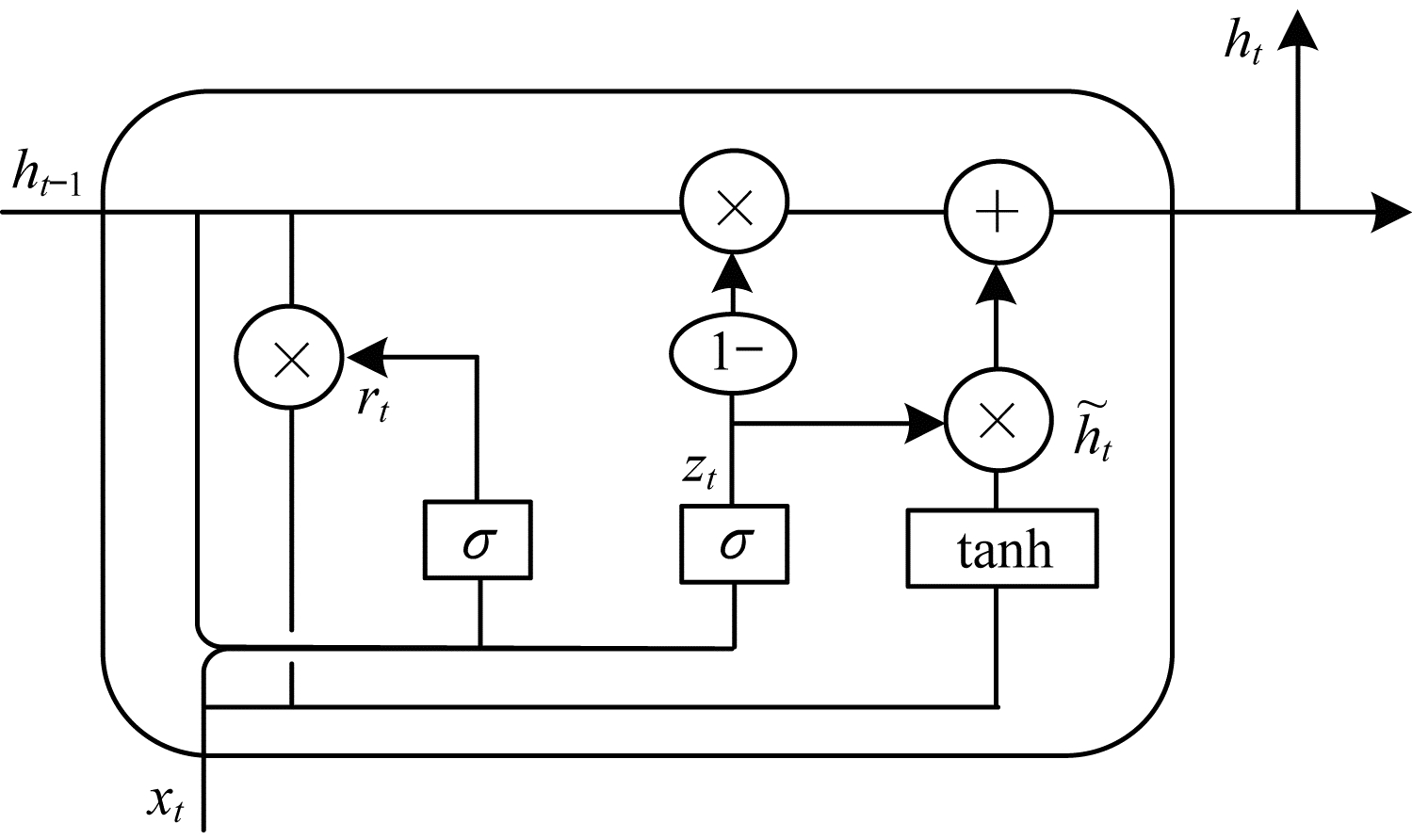

循环神经网络容易产生梯度消失和长期依赖等问题,因为随着输入的逐渐增多,RNN较难学习到连接之间的关系。为解决该问题,研究人员先后提出了LSTM和GRU这2个扩展模型。本文选择GRU[7],GRU在各种任务中表现出的性能与LSTM类似,但GRU结构较为简单,相较于LSTM少了一个门,参数也比较少,因此收敛速度比LSTM更快,更加适合触发词抽取的任务。

GRU是由CHO等提出的,GRU不使用单独的存储器单元,而是使用门控机制来跟踪序列的状态。GRU有重置门r和更新门z2种类型的门,它们共同负责更新信息的方式。GRU的单元结构如图 4所示。

|

Download:

|

| 图 4 GRU单元结构 Fig. 4 GRU unit structure | |

在图 4中,zt为更新门,用于控制保留过去的信息量,以及被添加的新信息量;rt为重置门,用于控制前一时刻状态有多少信息被写入到当前候选集

在t时刻,GRU计算新状态如式(7)~式(10)所示:

| $ {z}_{t}=\sigma ({w}_{z}\cdot [{h}_{t-1}, {X}_{t}\left]\right) $ | (7) |

| $ {r}_{t}=\sigma ({w}_{r}\cdot [{h}_{t-1}, {X}_{t}\left]\right) $ | (8) |

| $ {\tilde{h}}_{t}=\mathrm{t}\mathrm{a}\mathrm{n}\mathrm{h}(w\cdot [{r}_{t}\times {h}_{t-1}, {X}_{t}\left]\right) $ | (9) |

| $ {h}_{t}=(1-{z}_{t})\times {h}_{t-1}+{z}_{t}\times {\tilde{h}}_{t} $ | (10) |

其中:Wz、Wr、W为权重参数;Xt为t时刻GRU的输入;

在GRU对文本序列建模时,不考虑反向上下文,不能将上下文信息全部利用起来,因此增加反向输入的GRU。双向GRU利用了2个并行通道,使得模型既能获得正向的累积依赖信息,又能获得反向的未来的累积依赖信息。通过这种方式,使得提取的特征信息更加丰富。在训练过程中,假设BiGRU将隐藏层的数量设定为s,那么BiGRU的输出结果如式(11)所示:

| $ \boldsymbol{H}=[{h}_{1}, {h}_{2}, \cdots , {h}_{n}] $ | (11) |

其中:

由上文可知,

| $ y=\boldsymbol{C}\oplus \boldsymbol{H} $ | (12) |

其中:

| $ O=\mathrm{s}\mathrm{o}\mathrm{f}\mathrm{t}\mathrm{m}\mathrm{a}\mathrm{x}({\boldsymbol{W}}_{1}y+{b}_{1}) $ | (13) |

其中:W1表示连接权重矩阵;b1表示偏置。

CNN-BiGRU模型如图 5所示。

|

Download:

|

| 图 5 CNN-BiGRU模型 Fig. 5 CNN-BiGRU model | |

本文使用的数据集是ACE2005英文语料库和中文突发事件语料库CEC,它们是事件触发词抽取任务中最常使用的数据集。

ACE2005英文语料库是事件抽取任务一直被广泛采用的数据集,该语料库包含599篇文档,内容涉及新闻、广播、对话、博客、论坛和电话录音等。ACE评测会议的主要目标是识别出新闻语料中的实体、关系和事件。在ACE2005英文语料库中,事件被分为8个大类和33个子类,本文把识别子类作为主要任务。本文随机选取校验集30篇,测试集40篇,再将训练集选取为剩下的529篇。

中文突发事件语料库CEC[18]是上海大学开源的数据集,该数据集共包括地震、食物中毒、恐怖袭击、火灾以及交通事故5类新闻报道。CEC事件语料库的标注格式是XML语言,该语料库对事件、事件元素以及环境等全面标注,总共包含11 908个事件。本文实验设定训练集、校验集和测试集的比例为7∶1∶2。

2.2 实验评价标准事件触发词识别/分类:触发词被正确识别

本文与大多数事件抽取研究的评价方法一致,将准确率(precision)、召回率(recall)和F1值(F1-measure)作为衡量事件抽取模型好坏的指标。precision表示系统正确标注结果的总数与系统标注结果总数的比值;recall表示系统正确标注结果的总数与语料中标注结果的总数的比值;F1是precision值和recall值的一个综合度量。具体计算公式如下:

| $ \mathrm{F}1=\frac{2\times {p}_{\mathrm{p}\mathrm{r}\mathrm{e}\mathrm{c}\mathrm{i}\mathrm{s}\mathrm{i}\mathrm{o}\mathrm{n}}\times {r}_{\mathrm{r}\mathrm{e}\mathrm{c}\mathrm{a}\mathrm{l}\mathrm{l}}}{{p}_{\mathrm{p}\mathrm{r}\mathrm{e}\mathrm{c}\mathrm{i}\mathrm{s}\mathrm{i}\mathrm{o}\mathrm{n}}+{r}_{\mathrm{r}\mathrm{e}\mathrm{c}\mathrm{a}\mathrm{l}\mathrm{l}}} $ | (14) |

事件抽取模型的性能通常通过F1值来综合判断,F1值越大,模型性能越好。

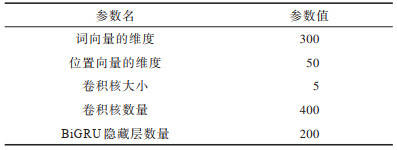

2.3 实验参数设置在训练过程中,采用softmax函数作为分类器,进而预测出触发词类型的概率矩阵,触发词类型的判断是通过argmax函数、损失函数为交叉熵代价(cross-entropy error)函数,将Adam优化算法作为梯度下降算法。本文模型实验参数的设置如表 1所示。

|

下载CSV 表 1 超参数设置 Table 1 Hyperparameters setting |

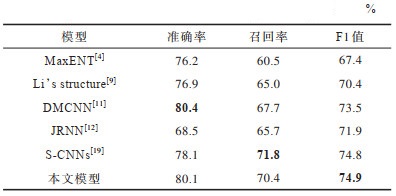

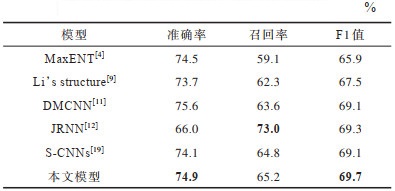

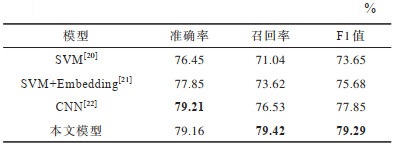

为验证本文模型对于实验的有效性,采用多种模型与本文模型进行对比。表 2、表 3分别展示了在ACE2005英文语料库上不同模型触发词抽取性能和触发词分类性能的对比;表 4展示了在中文突发事件语料库CEC上不同模型触发词抽取性能的对比(粗体为最优结果)。

|

下载CSV 表 2 ACE2005英文语料库上触发词抽取性能对比 Table 2 Comparison of trigger word extraction performance on ACE2005 English corpus |

|

下载CSV 表 3 ACE2005英文语料库上触发词分类性能对比 Table 3 Comparison of trigger word classification performance on ACE2005 English corpus |

|

下载CSV 表 4 中文突发事件语料库CEC上触发词抽取性能对比 Table 4 Comparison of trigger word extraction performance on Chinese emergencies corpus CEC |

由表 2可知,传统的事件触发词抽取方法表现出来的效果普遍不如基于神经网络的事件触发词抽取方法效果。在触发词抽取性能中,本文模型准确率虽然较DMCNN低0.3个百分点,但召回率却提升2.7个百分点,F1值提升1.4个百分点;S-CNNs模型召回率比本文模型高1.4个百分点,准确率却比本文模型低2个百分点,F1值比本文模型低0.6个百分点。总体来讲,在触发词抽取性能对比中,本文提出的模型表现最好。

由表 3可知,在触发词分类性能对比中,JRNN的事件抽取方式虽然召回率的提高非常显著,但是它的准确率却较本文模型低8.9个百分点,F1值较本文低0.4个百分点。综上所述,在触发词抽取这一任务中,本文提出的模型是目前所有模型中效果最好的。

分析表 4可知,本文提出的模型达到的抽取效果是最好的,相比起现有表现最好的模型F1值提高1.44个百分点。虽然本文模型准确率比CNN[22]模型低0.05个百分点,但召回率却比CNN[22]模型高出2.89个百分点,整体表现出的抽取效果也是最好的。

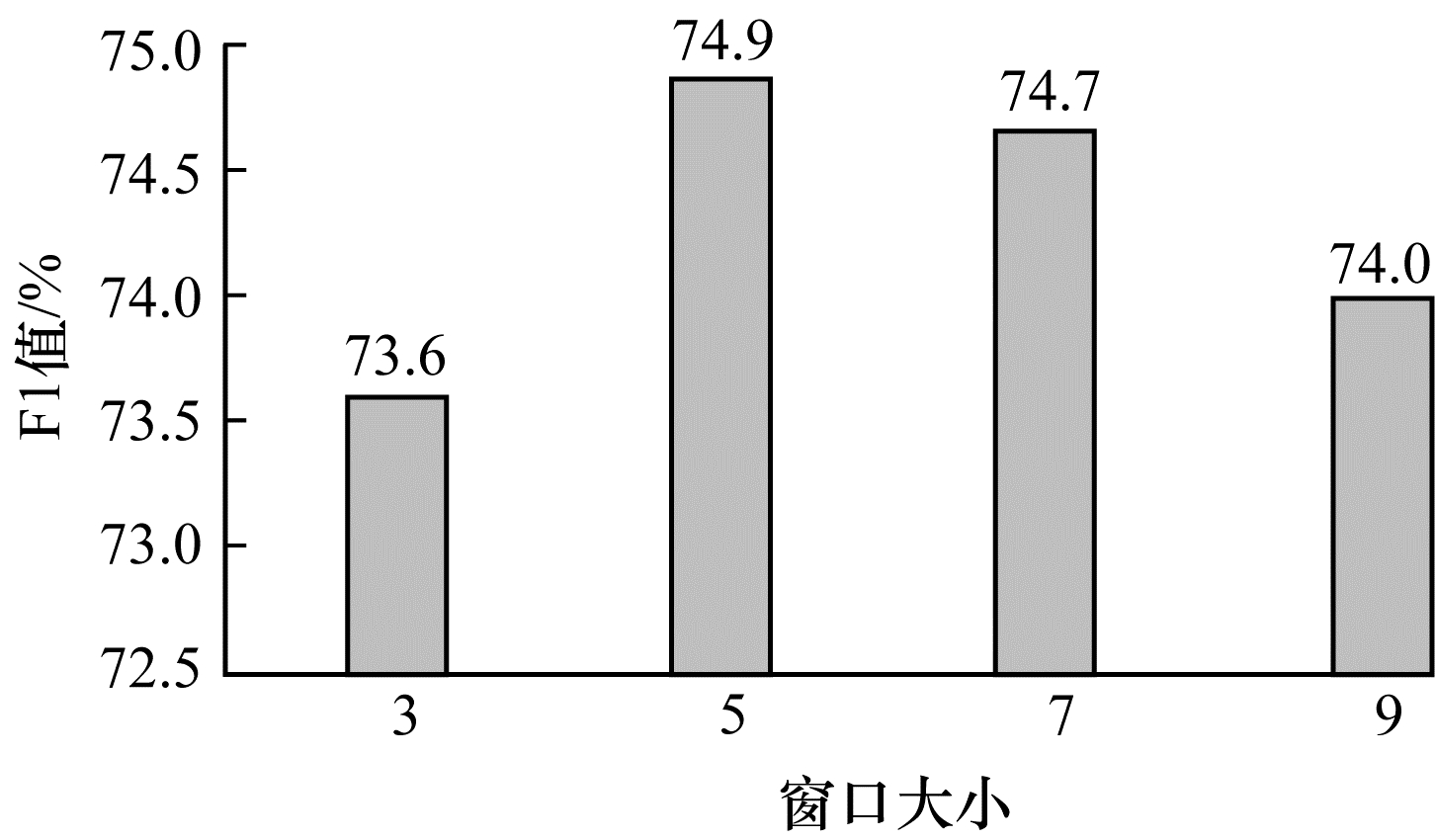

本文研究了调整CNN重要参数对模型的影响。实验结果如图 6所示。

|

Download:

|

| 图 6 窗口大小对模型的影响 Fig. 6 Effect of window size on the model | |

由图 6可知,当把其他参数设为定值,卷积窗口的大小设定为5时,可使得模型的F1值达到最大,效果达到最好。分析可知,当CNN卷积窗口过小时,不能充分利用上下文语义进行特征提取,对应的F1值较小;当卷积窗口过大时,也不能达到最好的特征抽取效果,由于当窗口过大时,不利于提取句子的局部特征,因此参数的选取对于实验非常重要。

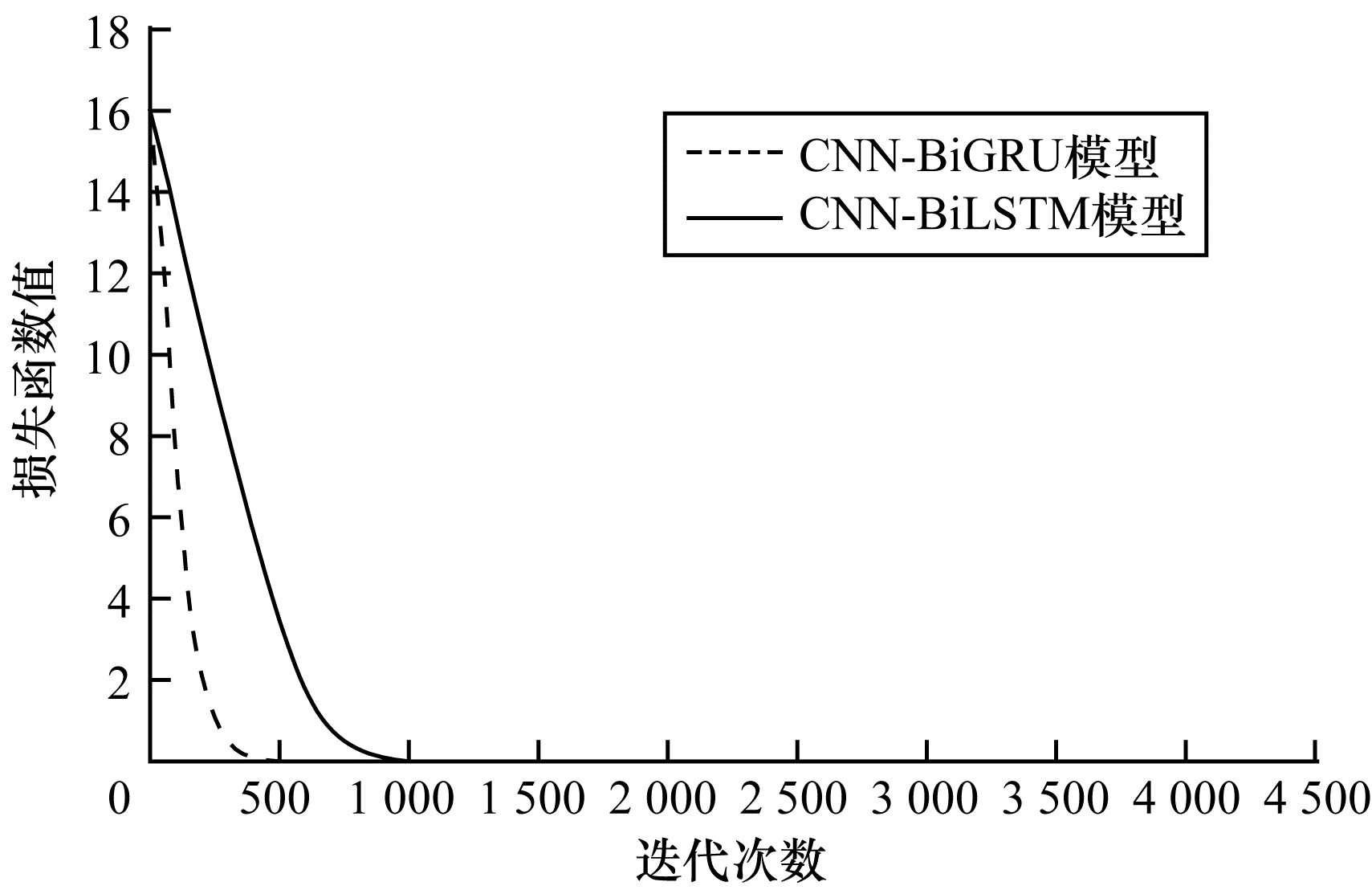

2.5 模型收敛特性本文提出的CNN-BiGRU模型具有很好的事件触发词抽取效果,因为该模型特征提取相当充分。同时本文模型也具有很好的收敛特性,收敛情况对比如图 7所示。

|

Download:

|

| 图 7 收敛情况对比 Fig. 7 Convergence comparison | |

由图 7可知,本文提出的模型迭代次数达到500次左右就可收敛,而CNN-BiLSTM模型迭代次数达到1 000次左右才可收敛。分析可知,BiGRU在事件触发词抽取任务上的表现比BiLSTM效果更好,能更快地达到收敛,本质是因为BiGRU网络结构相对BiLSTM更加简单,所需参数少,能有效缩短模型训练时间。

3 结束语本文提出一种基于CNN-BiGRU模型的事件触发词抽取方法。通过卷积神经网络提取词级别特征,并根据BiGRU提取句子级别特征,提高触发词效果。同时BiGRU所需参数较少,可缩短模型的训练时间。实验结果表明,相比现有事件触发词抽取方法,本文模型的抽取效果有明显提升。下一步将考虑引入更多的有效特征作为输入来提高模型的抽取性能。另外,由于主题事件抽取是未来的发展方向,因此可尝试将模型扩展到主题事件抽取任务中。

| [1] |

ZHU M Y J, BAO B K, XU C S. Research progress on the development and construction of knowledge graph[J]. Journal of Nanjing University of Information Science & Technology(Natural Science Edition), 2017, 9(6): 575-582. (in Chinese) 朱木易洁, 鲍秉坤, 徐常胜. 知识图谱发展与构建的研究进展[J]. 南京信息工程大学学报(自然科学版), 2017, 9(6): 575-582. |

| [2] |

GAO L Z, ZHOU G, LUO J Y, et al. Review of research on meta-event extraction[J]. Computer Science, 2019, 46(8): 9-15. (in Chinese) 高李政, 周刚, 罗军勇, 等. 元事件抽取研究综述[J]. 计算机科学, 2019, 46(8): 9-15. |

| [3] |

SUN P P, LIAO T, LIU Z T. Automatic abstract extraction based on event arguments[J]. Computer and Digital Engineering, 2015, 43(10): 1829-1833. (in Chinese) 孙佩佩, 廖涛, 刘宗田. 基于事件要素的自动文摘抽取[J]. 计算机与数字工程, 2015, 43(10): 1829-1833. DOI:10.3969/j.issn.1672-9722.2015.10.024 |

| [4] |

AHN D. The stages of event extraction[C]//Proceedings of Workshop on Annotating and Reasoning About Time and Events. Cambridge, USA: MIT Press, 2006: 1-8.

|

| [5] |

QI G L, GAO H, WU T X. Research progress of knowledge graph[J]. Journal of Information Engineering, 2017, 3(1): 4-25. (in Chinese) 漆桂林, 高桓, 吴天星. 知识图谱研究进展[J]. 情报工程, 2017, 3(1): 4-25. |

| [6] |

ZHENG Q D, WU Z D, ZOU J Y. Event causality extraction method based on two-layer CNN-BiGRU-CRF model[J]. Computer Engineering, 2021, 47(5): 58-64, 72. (in Chinese) 郑巧夺, 吴贞东, 邹俊颖. 基于双层CNN-BiGRU-CRF模型的事件因果关系抽取方法[J]. 计算机工程, 2021, 47(5): 58-64, 72. |

| [7] |

LIAO S, GRISHMAN R. Using document level cross-event inference to improve event extraction[C]//Proceedings of the 48th Annual Meetings of the Association for Computational Linguistics. Cambridge, USA: MIT Press, 2010: 789-797.

|

| [8] |

HONG Y, ZHANG J, MA B, et al. Using cross-entity inference to improve event extraction[C]//Proceedings of the 49th Annual Meeting of the Association for Computational Linguistics: Human Language Technologies. Cambridge, USA: MIT Press, 2011: 1127-1136.

|

| [9] |

LI Q, JI H, HUANG L. Joint event extraction via structured prediction with global features[C]//Proceedings of Meeting of the Association for Computational Linguistics. Cambridge, USA: MIT Press, 2013: 73-82.

|

| [10] |

NGUYEN T H, GRISHMAN R. Event detection and domain adaptation with convolutional neural network[C]//Proceedings of the 53rd Annual Meeting of the Association for Computational Linguistics and the Association for Computational Linguistics and the 7th International Joint Conference on Natural Language Processing. Stroudsburg, USA: ACL Press, 2015: 365-371.

|

| [11] |

CHEN Y, XU L, LIU K, et al. Event extraction via dynamic multi-pooling convolutional neural networks[C]//Proceedings of Meeting of the Association for Computational Linguistics. Cambridge, USA: MIT Press, 2015: 167-176.

|

| [12] |

NGUYEN T H, CHO K, GRISHMAN R. Joint event extraction via recurrent neural networks[C]//Proceedings of Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies. Cambridge, USA: MIT Press, 2016: 300-309.

|

| [13] |

CHEN B, ZHOU Y, LIU B. Event trigger extraction based on convolutional bidirectional long short term memory network[J]. Computer Engineering, 2019, 45(1): 153-158. (in Chinese) 陈斌, 周勇, 刘兵. 基于卷积长短期记忆网络的事件触发词抽取[J]. 计算机工程, 2019, 45(1): 153-158. DOI:10.3969/j.issn.1007-130X.2019.01.020 |

| [14] |

LIU S L, CHEN Y B, LIU K, et al. Exploiting argument information to improve event detection via supervised attention mechanisms[C]//Proceedings of the 55th Annual Meeting of the Association for Computational Linguistics. Stroudsburg, USA: ACL Press, 2017: 1789-1798.

|

| [15] |

WANG L Y, LIU C H, CAI D B, et al. Sentiment analysis of Chinese text with attention mechanism introduced in CNN-BiGRU network[J]. Computer Applications, 2019, 39(10): 2841-2846. (in Chinese) 王丽亚, 刘昌辉, 蔡敦波, 等. CNN-BiGRU网络中引入注意力机制的中文文本情感分析[J]. 计算机应用, 2019, 39(10): 2841-2846. |

| [16] |

LIU Y T, LI P F. Event trigger word extraction based on local entity features[J]. Computer Engineering, 2019, 45(11): 213-217, 224. (in Chinese) 柳亦婷, 李培峰. 基于局部实体特征的事件触发词抽取[J]. 计算机工程, 2019, 45(11): 213-217, 224. DOI:10.3778/j.issn.1002-8331.1811-0389 |

| [17] |

WU W T, LI P F, ZHU Q M. A joint extraction method of entities and events based on hybrid neural network[J]. Journal of Chinese Information Processing, 2019, 33(8): 77-83. (in Chinese) 吴文涛, 李培峰, 朱巧明. 基于混合神经网络的实体和事件联合抽取方法[J]. 中文信息学报, 2019, 33(8): 77-83. DOI:10.3969/j.issn.1003-0077.2019.08.011 |

| [18] |

YI S X, YIN H P, ZHENG H Y. Public safety event trigger word recognition based on BiLSTM[J]. Journal of Engineering Science, 2019, 41(9): 1201-1207. (in Chinese) 易士翔, 尹宏鹏, 郑恒毅. 基于BiLSTM的公共安全事件触发词识别[J]. 工程科学学报, 2019, 41(9): 1201-1207. |

| [19] |

ZHANG Z, XU W, CHEN Q. Joint event extraction based on skip-window convolutional neural networks[C]//Proceedings of International Conference on Computer Processing of Oriental Languages. Berlin, Germany: Springer, 2016: 324-334.

|

| [20] |

PYYSALO S, OHTA T, MIWA M, et al. Event extraction across multiple levels of biological organization[J]. Bioinformatics, 2012, 28(18): 575-586. DOI:10.1093/bioinformatics/bts407 |

| [21] |

ZHOU D Y, ZHONG D Y, HE Y L. Event trigger identification for biomedical events extraction using domain knowledge[J]. Bioinformatics, 2014, 30(11): 1587. DOI:10.1093/bioinformatics/btu061 |

| [22] |

WANG J, LI H L, AN Y, et al. Biomedical event trigger detection based on convolutional neural network[J]. International Journal of Data Mining and Bioinformatics, 2016, 15(3): 195. DOI:10.1504/IJDMB.2016.077067 |

2021, Vol. 47

2021, Vol. 47