2. 西安工业大学 计算机科学与工程学院, 西安 710021;

3. 西安工业大学 基础学院, 西安 710021

2. School of Computer Science and Engineering, Xi'an Technological University, Xi'an 710021, China;

3. School of Science, Xi'an Technological University, Xi'an 710021, China

开放科学(资源服务)标志码(OSID):

深度学习的不断发展使得神经网络具有接收与处理多模态信息的能力,如图像描述[1]、图像文本匹配[2]、视觉问答[3-5]等模态间交互转换的视觉任务都取得了较大的进展。与传统多模态表征任务相比,视觉问答(Visual Question Answering,VQA)更具挑战性,其目标是训练一个能够实现对多模态输入和视觉语言高层语义全面理解的模型,并将图像中的视觉特征和问题中的语义特征联系起来,使算法模型能够针对自然语言问题生成符合人类思维的答案。

早期的研究主要介绍图像和问题的联合表示学习,使用卷积神经网络(Convolutional Neural Network,CNN)作为视觉特征提取器[6-8],问题特征则使用循环神经网络(Recurrent Neural Network,RNN)编码[9-10]。从视觉特征编码器中获得一组稀疏图像区域后,应用多模态融合嵌入来学习每个区域与文本特征之间的联合表示,然后采用全局特征输入答案分类器中预测问题答案。

上述框架是有效且合理的,但在图像和自然语言之间仍然存在很大的语义鸿沟。例如,给定一个男孩拿着三明治的图像,问:图像中男孩左手中拿的是什么?模型可能会丢失关键视觉位置信息与核心问题语义信息,无法正确定位局部区域中的物体,因此,采用联合嵌入方法训练的VQA模型存在缺陷,且有局限性。为更好地检测到图像中与自然问题相关的部分并提升跨模态间的聚合能力,受人类视觉注意力和深度学习相关技术的启发,在视觉问答模型中加入注意力机制[11]。

然而,多数方法所采用的注意力机制是根据自然语言问题,聚焦图像中与文本特征密切相关的区域[5, 12-13]。这类方法经过不断迭代训练,通过处理图像区域中各个空间信息权重来选择性地关注CNN中隐层特征,但却忽略了模态间的动作语义和位置依赖关系。如给定两只长颈鹿并列站的图片,模型能识别长颈鹿的耳朵和身上的斑块,但不能识别斑块来自哪个长颈鹿。很难回答“最左边的长颈鹿是小长颈鹿吗?”或“长颈鹿都在吃树叶吗?”等问题。一种好的VQA网络不仅要能识别对象“长颈鹿”和环境中的“树叶”,同时需识别图像和问题中关于动作“吃”和位置“最左边”的语义。

为捕获图像中对象间动作关系和局部位置信息,模型不仅要在单纯的目标检测上融入语言信息,还应通过解释图像中对象之间的交互作用来加强对高层语义信息的理解,以缩小多模态之间的语义鸿沟;同时,网络需将注意力集中在相关视觉区域并丢弃对自然语言问题无用的信息,通过较好地学习整个场景以解决多模态表征问题。为此,一种解决方案是学习对象之间的语义依赖关系来捕捉视觉场景中的动态交互,根据自然文本序列特征进行关系推理来生成高质量答案;另一种方案是级联图像和问题特征的注意力模块,使问题适应对象间特征来丰富图像表示,以提高VQA性能。

基于上述两种方案,本文构建一个多模块协同注意网络(Muti-Module Co-Attention Network,MMCAN),分别使用Faster R-CNN[14]和门控循环单元(Gated Recurrent Unit,GRU)生成多模态特征,将每个区域的卷积特征输入图注意力网络(Graph Attention Network,GAT)[15],自适应感知图像中对象间的动态语义关系,进而提供整体场景解释来回答语义复杂的问题。此外,受机器翻译中Transformer模型[16]的启发,设计自注意力(Self-Attention,SA)和引导注意力(Guided-Attention,GA)这2个注意力单元,通过注意力单元的模块化组合提取特征,关注物体层级的视觉语义信息。最后将关系感知视觉特征和问题嵌入输入到多模态融合模块中,得到问题和图像特征的联合表示,用于生成最终答案。

1 相关工作 1.1 注意力机制注意力机制已成功地应用于单模态任务(如视觉[17]、语言[18]和语音[19])以及简单多模态任务。文献[11]从VQA的输入问题中学习图像区域的视觉注意力,使用注意力结构将问题嵌入视觉空间,并构造一个卷积核来搜索图像中所注意到的区域,有效促进了模型的表征能力;随后很多研究[5, 7-8, 12-13, 20]介绍了利用视觉注意力来提取特征,并通过注意力机制减少图像和文本信息中冗余特征的干扰;此外,文献[21-22]则利用不同的多模态双线性池化方法,将图像空间中的网格视觉特征与问题中的文本特征相结合预测答案。研究结果表明,学习视觉和文本模态的注意力有助于增强图像和问题的细粒度表示,从而有效提升模型精确度。但是,这些粗糙的注意力模型不能推断出图像中区域和问题词之间的相关性,并且难以识别图像中对象间的语义关系,导致在自动视觉问答中性能较差。

VQA过程不但需要理解图像的视觉内容,而且对自然语言问题的协同语义还需要予以更多关注,因此,通过学习双模态间的协同注意力能有效提高VQA结果。文献[23]建立一个协同注意力学习框架,交替学习图像注意力和问题注意力。文献[24]将协同注意力方法简化为两个步骤,首先将问题输入到自注意力机制学习问题词间的依赖关系,然后在问题引导注意力模块中搜寻最相关的视觉区域。同时,文献[25]提出双线性注意网络,基于先前注意到的记忆特征来细化注意力。

虽然上述模型能学习到不同注意力分布,但忽略了每个问题与对应图像区域之间的语义逻辑关系,成为理解多模式特征表示的瓶颈。为解决该问题,本文提出视觉关系嵌入的协同注意模型,使得每个问题词和对应图像区域之间能够动态交互。与传统注意力模型相比,该关系推理模型具有更好的VQA性能。

1.2 视觉关系推理VQA中注意力机制能聚焦文本关键词和视觉对象,但还需对整体内容有充分理解,对复杂问题则需基本常识和特定关系实例等先验知识的辅助推理。因此,一些研究[26-27]利用图像中的高级语义信息,如属性、字幕、视觉关系等加强学习,使模型更加强大并易于解释[28-29]。然而,文献[30]构建VQA关系数据集,探索VQA特定的事实关系,为模型提供额外的语义信息。同时,文献[10]引入MuRel单元的双线性融合方法,用于图像和问题两两关系的建模,研究如何对于复杂的问题进行推理,这些关系在多模态任务中被证明是有效的。

此外,一些文献介绍了结合问题的图关系表示[31-38]。文献[31]在VQA中使用图卷积神经网络(Graph Convolutional Network,GCN)[39],将问题的依赖性分析和抽象场景的场景图表示相结合,探索结构关系在表示学习中的重要作用,但其只在抽象场景数据集上有效。文献[32]直接引入一个空间图学习模块,该模块以问题表征为条件,使用成对注意力和空间图卷积来计算视觉表示,但其忽略了图像对象之间关系的多样性。文献[34]提出一个关系感知图注意网络模型,该方法将图像编码成一个代表视觉对象之间的关系图,在视觉基因组数据集上进行训练。文献[35]构建一种基于对象差异的图学习器,通过计算对象间的差异来学习语义关系。文献[36]使用预先提取的视觉关系作为先验知识来建模对象及其交互,但其推理过程高度依赖于先验关系。受图形中建模实体及其关系性质的启发,文献[40]使用基于知识图的GCN来回答事实问题,该模型主要关注图像和知识图中提取的实体关系图,严重依赖于外部知识图。文献[41]则通过GAT建模图像物体间的关系来推理答案,但其不能有效关注与问题相关的视觉对象。

与上述方法相比,本文VQA体系结构利用图像的丰富信息,无需任何先验知识或预先训练,直接建模对象及其关系,其所学到的视觉关系特征是对先前研究的补充。同时,在图表示学习中给相同领域的节点分配不同的重要性,通过问题自适应性对象间关系来过滤掉与问题无关的关系,使用多层消息传递来执行关系推理,具有问题自适应性,能动态地捕获与问题最相关的视觉对象关系。

本文工作主要有2个贡献:1)基于Transformer协同注意单元来提升模态间的聚合能力,使模型集中注意在问题与图像特征交融部分,抑制无关信息;2)基于GAT学习视觉对象之间的语义关系,语义关系具有问题自适应性,可以动态地关注每个问题的特定关系。

2 多模块协同注意模型本文多模块协同注意模型如图 1所示。其中,SA为自注意单元,GA对应引导注意单元,att为建模两两对象间关系的图注意力,AttEn表示注意力增强模块,BCE Loss为二元交叉熵损失函数。模型主要包括图像编码、问题编码、图关系编码和协同注意学习和注意力增强。在图像编码中,使用自底向上注意力机制提取图像中64维的几何特征和2 048维视觉特征[5];在问题编码中,使用GRU进行问题词特征提取,所提取的特征为1 024维。首先将双模态特征输入关系编码模块中建模对象间语义关系,关系编码后的视觉语义特征与初始视觉特征以残差方式融合,送入协同注意模块,接着通过自注意单元SA与引导注意力单元GA联合学习两者的丰富信息,最后经注意力后以简单的哈达玛乘积方式融合两者特征,送入分类器预测答案。

|

Download:

|

| 图 1 多模块协同注意力网络 Fig. 1 Multi-module collaborative attention network | |

模型输入一张图像

| $ \widehat{a}=\underset{a\in A}{\mathrm{a}\mathrm{r}\mathrm{g}\mathrm{m}\mathrm{a}\mathrm{x}} \ \ {p}_{\theta }(a|v, q) $ | (1) |

其中:

对于输入问题,首先将每个问题词进行标记并使用600维的词嵌入编码序列特征(包括300维GloVe词嵌入[43]),问题中每一个词进一步转化为向量。在每一个时间步将单词序列送入双向GRU中编码得到问题特征

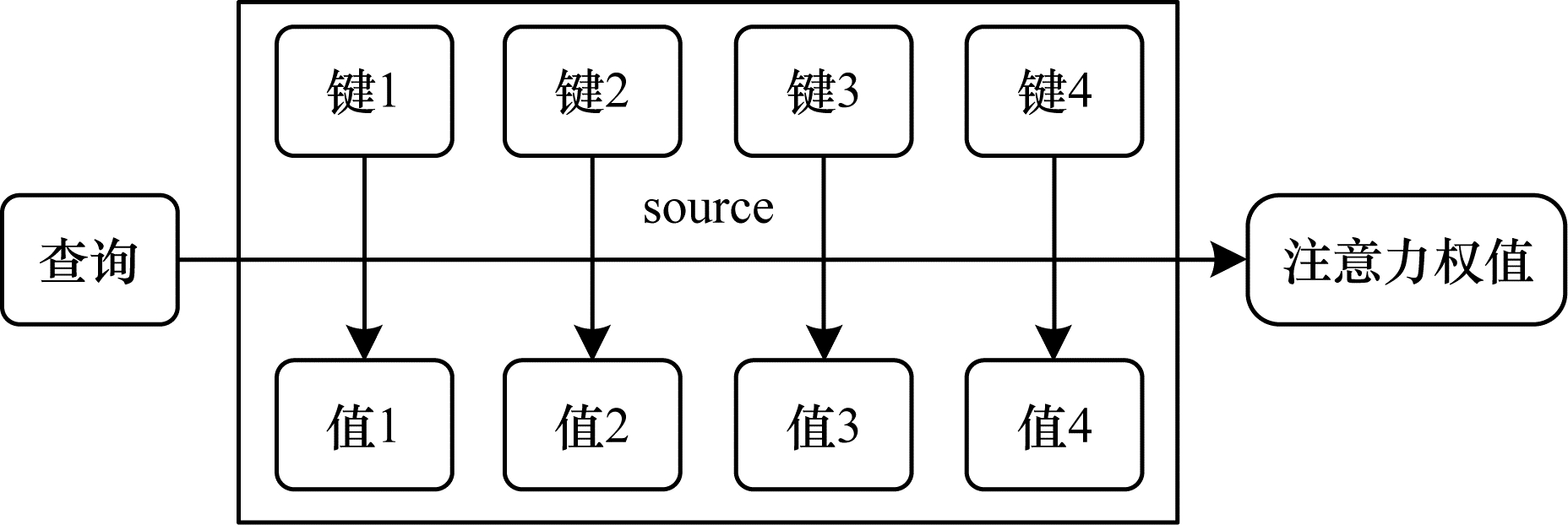

如图 2所示的注意力机制是图关系模块的核心,其输入由维度为

|

Download:

|

| 图 2 自注意力机制 Fig. 2 Self-attention mechanism | |

给定一个“查询”

| $ {\boldsymbol{V}}^{\mathrm{o}\mathrm{u}\mathrm{t}}=A(\boldsymbol{Q}, \boldsymbol{K}, \boldsymbol{V}) \ =\mathrm{s}\mathrm{o}\mathrm{f}\mathrm{t}\mathrm{m}\mathrm{a}\mathrm{x}\left(\frac{\boldsymbol{Q}\boldsymbol{K}}{\sqrt{{d}_{k}}}\right)\boldsymbol{V} $ | (2) |

在关系编码之前,首先构建一个全连通无向图编码器

图关系编码器能动态捕获图像中目标对象间的动态关系,对于VQA任务,不同问题类型可能有不同类型关系。因此,本文将问题嵌入特征

| $ {\boldsymbol{F}}_{A}\left(i\right)= \ \left[{v}_{i}\right|\left|q\right] \ , i=1, \ 2, \cdots , N $ | (3) |

其中:

| $ {\boldsymbol{F}}_{\boldsymbol{R}}^{\boldsymbol{r}}\left(i\right) \ =\sum\limits _{\boldsymbol{j}\in {N}_{i}}{\omega }^{ij}\cdot ({\boldsymbol{W}}_{V}\cdot {\boldsymbol{F}}_{A}\left(j\right)), r=1, \ 2, \ \cdots , {N}_{r} $ | (4) |

式(4)通过不同注意力系数

| $ {\omega }^{ij}=\frac{{\omega }_{G}^{ij}\cdot \mathrm{e}\mathrm{x}\mathrm{p}\left({\omega }_{A}^{ij}\right)}{\sum\limits _{k}{\omega }_{G}^{ik}\cdot \mathrm{e}\mathrm{x}\mathrm{p}\left({\omega }_{A}^{ik}\right)} $ | (5) |

式(5)中类似于式(2)点乘操作的关系特征权重

| $ {\omega }_{A}^{ij}=\frac{\mathrm{d}\mathrm{o}\mathrm{t}\left({\boldsymbol{W}}_{K}{\boldsymbol{F}}_{A}\right(i), {\boldsymbol{W}}_{Q}{\boldsymbol{F}}_{A}(j\left)\right)}{\sqrt{{d}_{k}}} $ | (6) |

其中:dot表示向量点积;矩阵

在式(5)中,可以通过

| $ {\omega }_{G}^{ij}= \ \mathrm{m}\mathrm{a}\mathrm{x}\left\{0\text{,}{\boldsymbol{W}}_{G}\cdot {\varphi }_{G}\left({\boldsymbol{p}}_{\mathrm{p}\mathrm{o}\mathrm{s}}\right)\right\} $ | (7) |

为满足平移和尺度变换不变性,使用

| $ {\varphi }_{G}\left({\boldsymbol{p}}_{\mathrm{p}\mathrm{o}\mathrm{s}}\right)=\mathrm{C}\mathrm{o}\mathrm{n}\mathrm{c}\mathrm{a}\mathrm{t}[\mathrm{P}{\mathrm{E}}_{({\boldsymbol{p}}_{\mathrm{p}\mathrm{o}\mathrm{s}}, 2l)}, \ \mathrm{P}{\mathrm{E}}_{({\boldsymbol{p}}_{\mathrm{p}\mathrm{o}\mathrm{s}}, \ 2l+1)}] $ | (8) |

其中:Concat[]拼接操作用来聚合正弦波与余弦波;PE表示不同频率的信号,该信号的几何波长变化范围为

| $ \mathrm{P}{\mathrm{E}}_{({\boldsymbol{p}}_{\mathrm{p}\mathrm{o}\mathrm{s}}, 2l)}=\mathrm{s}\mathrm{i}\mathrm{n} \ ({\boldsymbol{p}}_{\mathrm{p}\mathrm{o}\mathrm{s}}/{10}_{}{000}^{2l/{d}_{\mathrm{m}\mathrm{o}\mathrm{d}\mathrm{e}\mathrm{l}}}) $ | (9) |

| $ \mathrm{P}{\mathrm{E}}_{({\boldsymbol{p}}_{\mathrm{p}\mathrm{o}\mathrm{s}}, 2l+1)}=\mathrm{c}\mathrm{o}\mathrm{s} \ ({\boldsymbol{p}}_{\mathrm{p}\mathrm{o}\mathrm{s}}/{10}_{}{000}^{2l/{d}_{\mathrm{m}\mathrm{o}\mathrm{d}\mathrm{e}\mathrm{l}}}) $ | (10) |

其中:

| $ {\boldsymbol{p}}_{\mathrm{p}\mathrm{o}\mathrm{s}}={\left(\mathrm{l}\mathrm{o}{\mathrm{g}}_{a}\left(\frac{{x}_{i}-{x}_{j}}{{w}_{i}}\right), \ \mathrm{l}\mathrm{o}{\mathrm{g}}_{a}\left(\frac{{y}_{i}-{y}_{j}}{{h}_{i}}\right), \ \mathrm{l}\mathrm{o}{\mathrm{g}}_{a}\left(\frac{{w}_{i}}{{w}_{j}}\right), \ \mathrm{l}\mathrm{o}{\mathrm{g}}_{a}\left(\frac{{h}_{i}}{{h}_{j}}\right)\right)}^{\mathrm{T}} $ | (11) |

将嵌入特征通过

采用多头注意力机制[15]增强图注意力学习,得到图关系编码器的输出。分别执行独立的自注意力,将子关系特征拼接起来得到输出关系特征

| $ {\boldsymbol{F}}_{R}^{r}\left(i\right)=\mathrm{C}\mathrm{o}\mathrm{n}\mathrm{c}\mathrm{a}\mathrm{t}\left[{\boldsymbol{F}}_{R}^{1}\left(i\right), {\boldsymbol{F}}_{R}^{2}\left(i\right), \cdots , {\boldsymbol{F}}_{R}^{{N}_{r}}\left(i\right)\right] $ | (12) |

其中:Concat[]拼接用于聚合

| $ {\boldsymbol{V}}_{R}\left(i\right)=\boldsymbol{V}\left(i\right)+{\boldsymbol{F}}_{R}^{r}\left(i\right) $ | (13) |

在设计的关系模块中,允许从问题中输入语义信息到关系网络,为每个问题相关的关系分配更高的权重。因此,由关系编码器学习的特征不仅捕获到图像中的关系特征,而且能获得文本特征中的语义线索,动态地关注到问题中特定的关系类型和实例。图注意力机制编码如算法1所示,运算过程如图 3所示,图中虚线表示3头图注意力。

|

Download:

|

| 图 3 图注意力机制关系编码 Fig. 3 Relationship encoding of graph attention mechanism | |

算法1 图注意力机制编码

输入

输出 带有关系属性的视觉特征

1.for

2.从式(7)求得几何特征权值

3.从式(6)求得视觉特征权值

4.从式(5)求得图注意力系数

5.从式(4)求得关系特征

6.end for

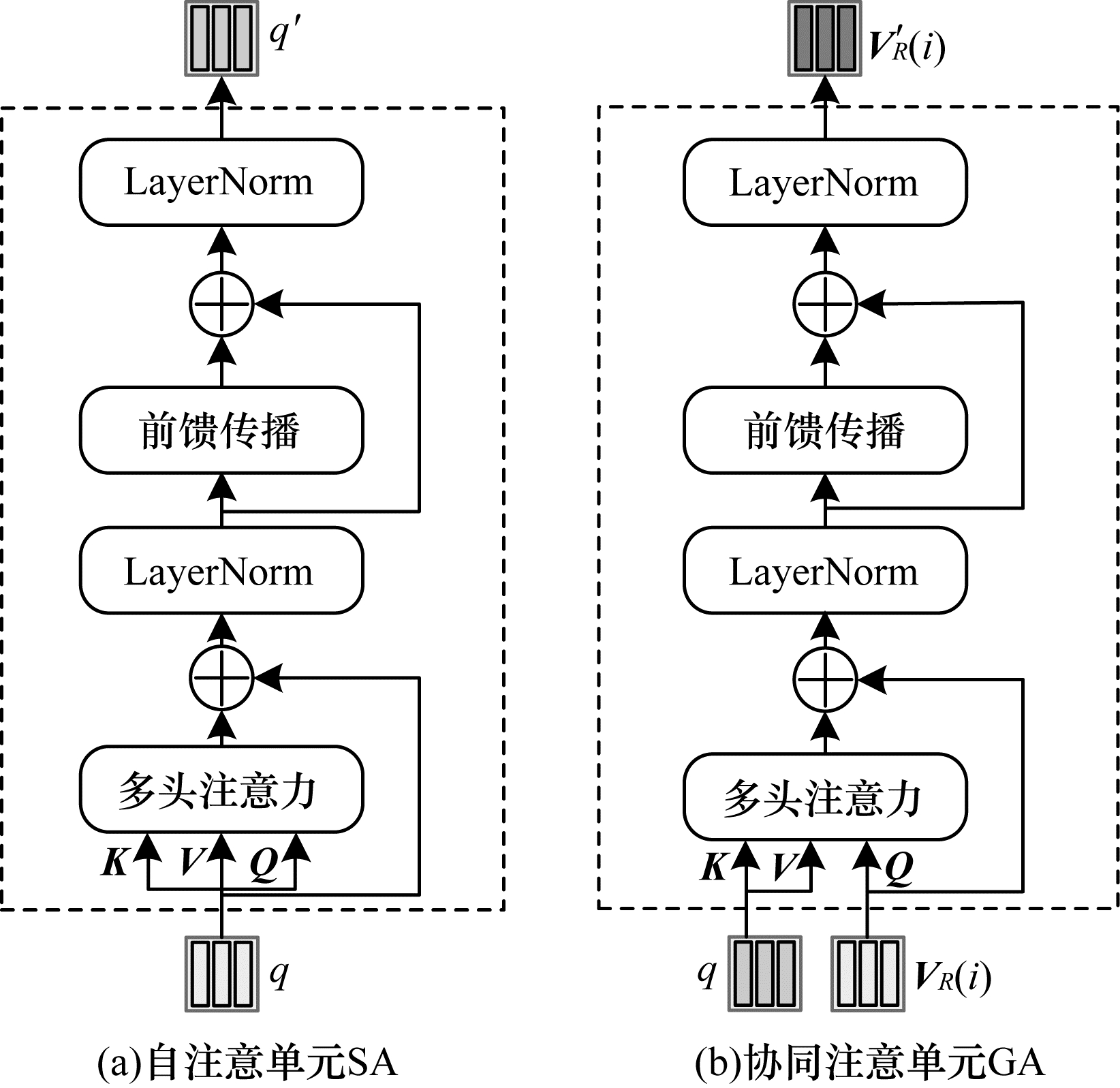

2.3 协同注意力协同注意力模块由自注意单元SA和协同注意单元GA组成,用来处理VQA的多模态输入特征。其中,SA单元由多头注意力、LayerNorm[44]和前馈传播模块构成,对于多头注意力模块,先执行式(2)的“点乘”注意力,其输入中“查询”、“键”和“值”使用相同数据,即

| $ f=\mathrm{M}\mathrm{A}(\boldsymbol{Q}, \boldsymbol{K}, \boldsymbol{V})={\boldsymbol{W}}_{O}\left[\mathrm{h}\mathrm{e}\mathrm{a}{\mathrm{d}}^{1}, \mathrm{h}\mathrm{e}\mathrm{a}{\mathrm{d}}^{2}, \cdots , \mathrm{h}\mathrm{e}\mathrm{a}{\mathrm{d}}^{h}\right] $ | (14) |

| $ \mathrm{h}\mathrm{e}\mathrm{a}{\mathrm{d}}^{h}=A(\boldsymbol{Q}{\boldsymbol{W}}_{Q}^{h}, \boldsymbol{K}{\boldsymbol{W}}_{K}^{h}, \boldsymbol{V}{\boldsymbol{W}}_{V}^{h}) $ | (15) |

其中:

给定一组输入

GA单元内部构成与SA单元一致,不同的是GA单元有维度分别为

协同注意力模块中

|

Download:

|

| 图 4 协同注意力模块 Fig. 4 Collaborative attention module | |

经协同注意力学习后,输出图像特征

| $ \alpha =\mathrm{s}\mathrm{o}\mathrm{f}\mathrm{t}\mathrm{m}\mathrm{a}\mathrm{x}\left({M}_{\mathrm{M}\mathrm{L}\mathrm{P}}\right({\boldsymbol{V}}_{R}'\left(i\right)\left)\right)\text{,}i=1, \ 2, \cdots , N $ | (16) |

| $ {\boldsymbol{V}}_{\boldsymbol{R}}''\left(i\right)=\sum\limits _{i=1}^{\boldsymbol{n}}{\alpha }_{i}{\boldsymbol{V}}_{R}'\left(i\right) $ | (17) |

其中:

将注意力增强模块的输出

| $ \boldsymbol{U}=\mathrm{L}\mathrm{a}\mathrm{y}\mathrm{e}\mathrm{r}\mathrm{N}\mathrm{o}\mathrm{r}\mathrm{m}({\boldsymbol{W}}_{x}{\boldsymbol{V}}_{R}''(i) \ \otimes {\boldsymbol{W}}_{y}q'') $ | (18) |

其中:

最后将融合特征

| $ {\boldsymbol{p}}_{a}=\mathrm{s}\mathrm{i}\mathrm{g}\mathrm{m}\mathrm{o}\mathrm{i}\mathrm{d}({\boldsymbol{W}}_{u}\boldsymbol{U}+{\boldsymbol{b}}_{u}) $ | (19) |

其中:

在VQA v2.0数据集中,每个训练问题都与一个或多个答案相关联,可以预先确定的是:输出候选答案词表中出现9次以上的为正确答案(3 129类)。因此,将视觉问答视为一项多分类标签任务,使用二元交叉熵损失函数来优化模型,在融合特征的基础上训练一个多分类器。

3 实验视觉问答通常被定义为多类别分类问题,其类别标签为预定义的候选答案集合。数据集的创建者设立了一个公开的评估服务器对测试集上候选答案进行盲测,使用一种投票机制来计算准确率,准确率的评估指标如下:

| $ \mathrm{A}\mathrm{c}\mathrm{c}\left(\mathrm{a}\mathrm{n}\mathrm{s}\right)=\mathrm{m}\mathrm{i}\mathrm{n}\left(1, \frac{\#\mathrm{h}\mathrm{u}\mathrm{m}\mathrm{a}\mathrm{n}\mathrm{s} \ \mathrm{p}\mathrm{r}\mathrm{o}\mathrm{v}\mathrm{i}\mathrm{d}\mathrm{e}\mathrm{d} \ \mathrm{a}\mathrm{n}\mathrm{s}}{3}\right) $ | (20) |

其中:#humans provided ans表示问题的准确答案数;ans为问答模型的预测答案。本文在VQA 2.0[45]和VQA-CP v2[46]数据集上训练并使用相同评估指标。

3.1 数据集VQA 2.0数据集由MSCOCO[47]中的自然图像组成,在训练集、验证集和测试集划分上与MSCOCO一致,是VQA任务中公开的大规模数据集。训练集包含80K幅图像和444K个问题答案对,验证集包含40K幅图像和214K个问题答案对,测试集包含80K幅图像和448K个问题。另外,测试集被分成了4个大致均匀的部分,分别是test-dev、test-standard、test-challenge和test-reserve,用于防止模型的过拟合且使研究人员更灵活地测试开发的VQA系统。其中test-dev子集用于在线调试和验证实验,test-standard子集默认为视觉问答比赛中评估模型性能的测试数据。对于每个图像,平均生成3个问题,问题分为4类:“总体”,“是/否”,“计数”和“其他”,标注答案由人类提供,每个图像问题对收集10个答案,并选择出现次数最多的答案作为正确答案。数据集中问题有开放式和多选题两种,本文以开放式任务为重点,在执行过程中选择可能性最大的答案作为预测答案。

VQA-CP v2数据集是VQA 2.0数据集的派生,引入CP版本是为了减少VQA 2.0数据集中问题的偏差。在数据集中图像与VQA 2.0相同并且为验证集提供答案注解,但图像对应的问题和问题答案分布不同。

3.2 训练细节及参数设置实验基于Linux Ubuntu 18.04系统,网络模型采用Pytorch 1.0.1框架实现,使用英伟达GeForce GTX 1080显卡进行训练。迭代优化方案使用Adamax优化器,其中,

在图注意网络中,隐藏层中图像和问题特征维度

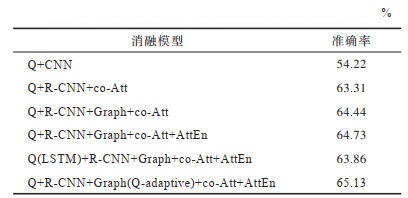

为了分析模型中每个部分的贡献和作用,本文对提出的完整模型进行大量消融实验,评估每个模块的作用并展示每个部分的有效性。如表 1、表 2所示(加粗字体为最优结果),各个部分的消融模型如下:

|

下载CSV 表 1 在VQA 2.0上进行消融实验的准确率 Table 1 Accuracy of ablation experiments on VQA 2.0 |

|

下载CSV 表 2 在VQA 2.0上多模态特征融合方法的比较 Table 2 Comparison of multimodal feature fusion methods on VQA 2.0 |

Q+CNN:没有任何注意力的基准模型。

Q+R-CNN+co-Att:使用一个全连接层代替图 2中的图网络建模,仅用协同注意力对双模态特征进行建模,是没有图关系编码的模型。

Q+R-CNN+Graph+co-Att:加图关系编码注意力模型。

Q+R-CNN+Graph+co-Att+AttEn:带注意力增强问题和自适应图关系编码的注意力模型。

Q(LSTM)+R-CNN+Graph+co-Att+AttEn:Q(LSTM)表示问题编码使用长短期记忆神经网络(LSTM)的注意力模型,本文其他消融模型中问题编码默认使用双向循环GRU网络。

Q+R-CNN+Graph(Q-adaptive)+co-Att+AttEn(MMCAN):多模块协同注意力模型。

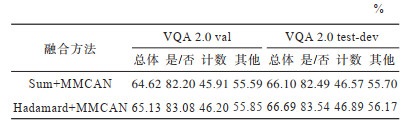

Sum+MMCAN:特征融合采用加和方式的协同注意力模型。

Hadamard+MMCAN:特征融合采用哈达玛乘积方式的协同注意力模型,是本文采用的多模态特征融合方式。

表 1中展示了消融模型在VQA 2.0验证集上的性能,模型分数为“总体”类问题的准确率。除第一行基准模型使用ResNet-152的卷积特征外,其余模型均采用Faster R-CNN提取物体层级的特征。在相同的实验环境下,与没有任何注意力的基准模型相比,本文完整模型准确率的提高10.91个百分点。第2行~第6行为本文模型不同模块的消融,可以看出,其中加图关系推理比简单注意力模型的准确率提高1.13个百分点,证明在视觉问答任务中使用图关系编码目标对象间关系的优势;增加注意力增强后模型又获准确率提高0.29个百分点,表明多模态融合时跨模态信息交互的重要性;同时,第5行验证了本文模型的文本序列适用于GRU编码;在最后一行,使用问题自适应辅助图像关系推理,准确率又提高0.40个百分点,表明自适应问题的图像关系特征编码有助于模型学习到更多跨模态的知识,有助于提升模型的表征能力。

表 2中在val和test-dev验证子集上对比了两种多模态特征融合方法。其中,Sum+MMCAN表示将两个模态特征进行简单的加和操作,Hadamard+MMCAN则将双模态输出特征进行乘积操作。无论哪种问题类型,哈达玛乘积方式的准确率均高于加和方式,尤其在回答“是/否”类型的问题时准确率分别提高0.72、1.05个百分点,表明本文采用Hadamard融合方式的优势。

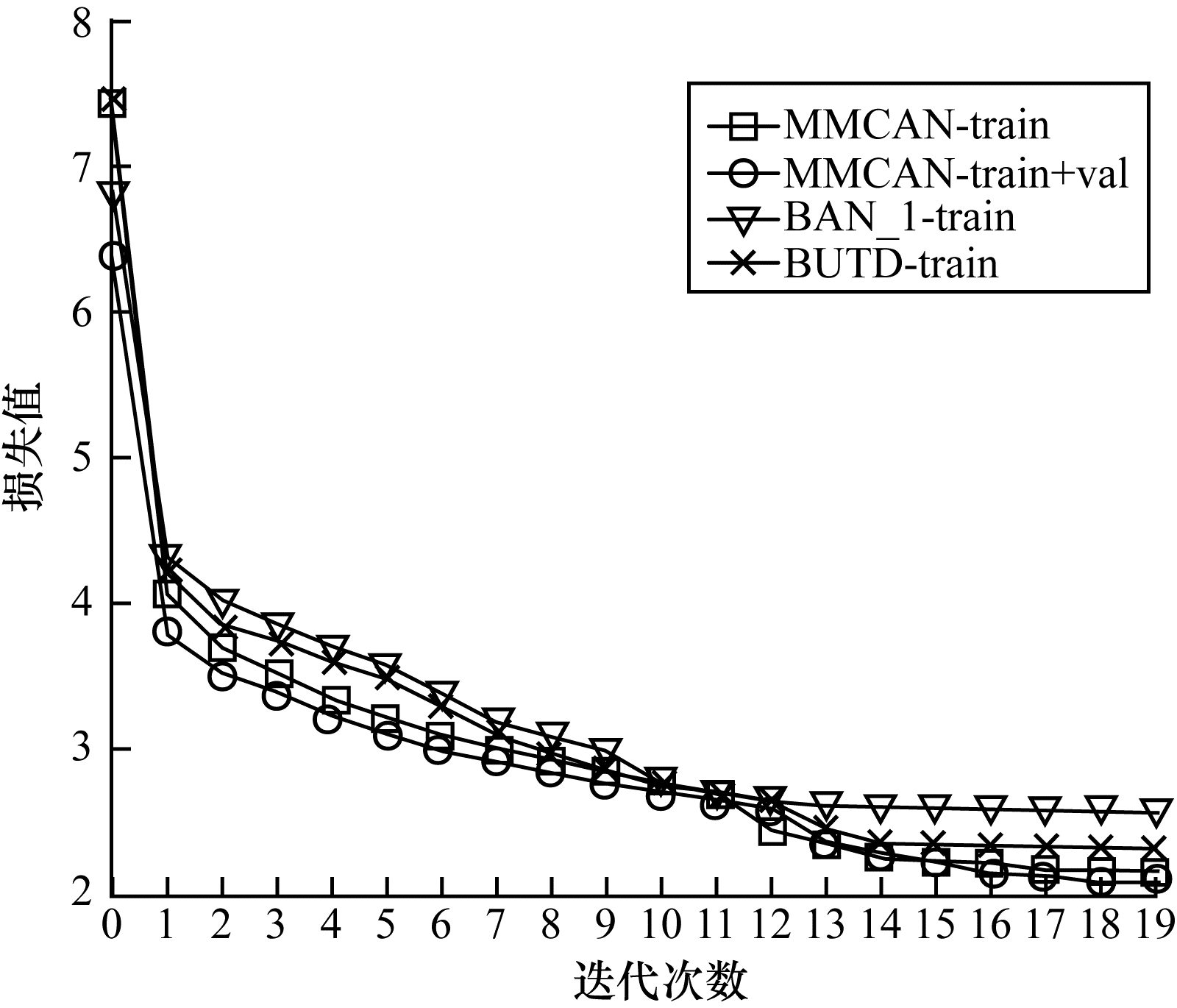

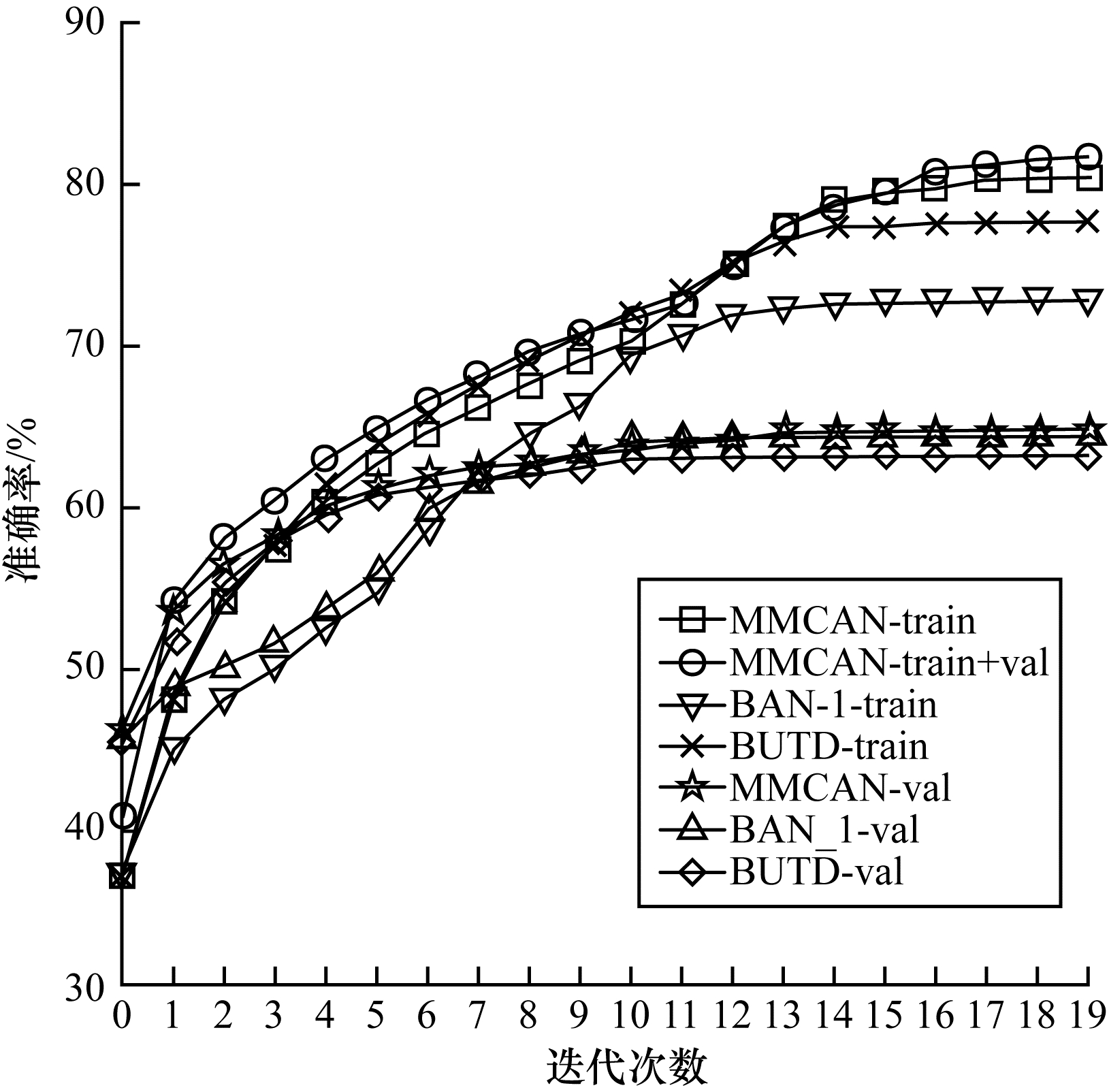

3.4 收敛性分析图 5和图 6分别展示了在模型训练过程中损失值和准确率的可视化情况。图 5结尾为train表示模型仅在训练集上训练,为train+val表示模型同时在训练集和验证集上训练。图 6结尾为val表示验证集上的精确度,下文中train和train+val均表示相同含义。本节选用自下而上注意力模型[5]BUTD和一阶双线性注意力模型[25]BAN_1作为基线模型。

|

Download:

|

| 图 5 训练过程中的损失变化曲线 Fig. 5 Loss change curve during training | |

|

Download:

|

| 图 6 训练过程中的准确率变化曲线 Fig. 6 Accuracy change curve during training | |

在图 5中,损失值随着迭代次数的不断增加保持下降趋势,在第1、12轮处由于学习率变化导致损失曲线波动明显变化;在训练首轮,数据量扩充明显增强了模型的拟合能力;从第14轮开始,损失函数值逐渐趋于稳定。在整体上,本文模型的收敛能力优于基线注意力模型。在图 6中,同样在损失明显下降处带来准确率的显著提升。随着训练轮次的增加,准确率逐渐增加,从14轮处验证集精确度逐步趋于平稳,当epoch值等于20时,模型准确率最高。根据损失函数和准确率变化曲线,MMCAN模型拟合能力和表示能力均优于其他模型。

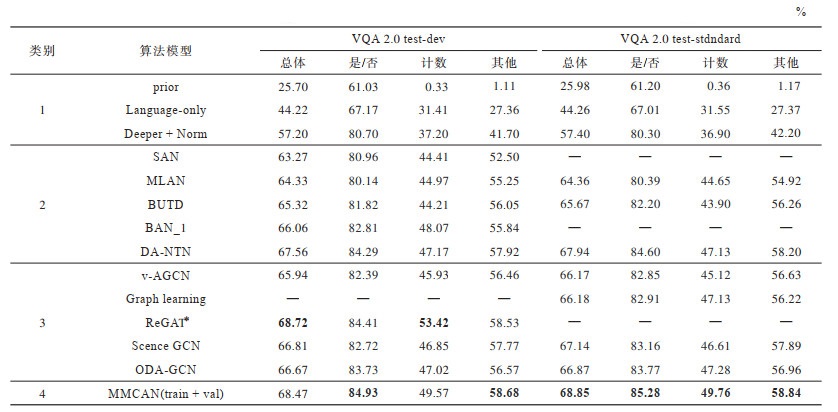

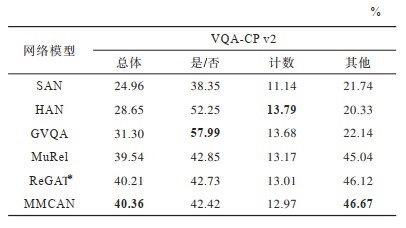

3.5 定性分析本文在VQA 2.0和VQA-CP v2数据集上比较了MMCAN模型和当前具有代表性的视觉问答模型,VQA 2.0上的实验结果如表 3所示,在VQA-CP v2上的实验结果如表 4所示。其中,加粗字体为最优结果,—表示数据为空,∗ 表示重新执行的结果。为公平起见,仅报告单模型在各种设置下的性能。表 3中将对比模型按照不同方法分为4个类别,类别1不使用任何注意力机制,类别2使用不同的注意力机制,类别3使用图关系推理,类别4为MMCAN模型。

|

下载CSV 表 3 不同模型在VQA 2.0测试子集test-dev和test-standard上的性能比较 Table 3 Performance comparison of different models on test-dev and test-standard of VQA 2.0 |

|

下载CSV 表 4 不同模型在VQA-CP v2上的性能比较 Table 4 Performance comparison of different models on VQA-CP v2 |

与早期没有任何注意力基线模型prior、language-only和Deeper + Norm相比[3],本文模型获得大幅提高,在test-dev上“总体”精确度分别提升42.67%、24.25%和11.27%,在test-standard上有42.87%、24.59%和11.45%的提高。与使用不同注意力机制的算法SAN[12]、MLAN[13]、BUTD[8]、BAN_1[25]和DA-NTN[9]相比,本文模型在test-dev上“总体”精确度分别提升5.20、4.14、3.45、2.41和0.91个百分点;在test-standard上,相比MLAN、BUTD和DA-NTN,MMCAN分别提升4.49、3.18和0.91个百分点。结果表明,通过图注意力网络自适应建模视觉对象间语义关系,动态地关注到每个问题的特定关系,有效提升视觉问答的准确率。值得注意的是,深度注意神经张量网络的性能接近MMCAN模型,DA-NTN是基于张量的切片式注意模块来选择最具区分性的对象间关系进行建模,这与本文的图关系模块类似,但其运算代价更大。

与使用图网络建模关系的算法v-AGCN[32]、Scence GCN[35]和ODA-GCN[34]相比,模型在test-dev上“总体”精确度分别提高2.53、1.66和1.80个百分点;与v-AGCN、Graph learning[33]、Scence GCN和ODA-GCN相比,在test-standard上MMCAN分别提高2.68、2.67、1.71和1.98个百分点。结果表明,采用简单的GCN对图像关系建模,本文模型采用图注意力机制,更好地捕获到视觉场景中对象间的语义依赖关系,通过自适应问题多样性来丰富动态的关系表示,较好地理解与问题相关的场景。在相同条件下,MMCAN没有使用额外VG数据集辅助训练,但总体性能与单模型的ReGAT性能相当,并在“是/否”与“其他”类问题上提升0.52和0.15个百分点。结果表明,本文模型充分发挥图网络与协同注意模块的作用,有效融合了问题与图像特征。

同时,本文在派生数据集VQA-CP v2上进行实验,表 4展示了测试集上不同问题类型的评估结果。无论是否使用关系推理,本文模型在“总体”和“其他”两类问题上都优于以往的工作,如SAN、HAN[49]、GVQA[46]、MuRel[10]和ReGAT。与两个基线算法SAN和GVQA相比,本文模型性能分别提高15.40%、11.91%和25.03%、26.34%,与具备关系推理的模型MuRel和ReGAT相比,分别提高0.82、1.63和0.15、0.55个百分点。可以看出,本文模型充分发挥了图注意网络和协同注意力的作用。协同注意力加强了双模态信息的交互,使模型集中注意在文本序列和视觉特征交融部分,减少冗余信息的干扰;图注意力机制能够聚焦于感知目标在图像中的区域位置,使模型根据问题动态捕获目标对象间关系,表明关系推理结构在视觉问答中有正向作用。实验结果证明了GVQA网络重点关注“是/否”类问题的优势。

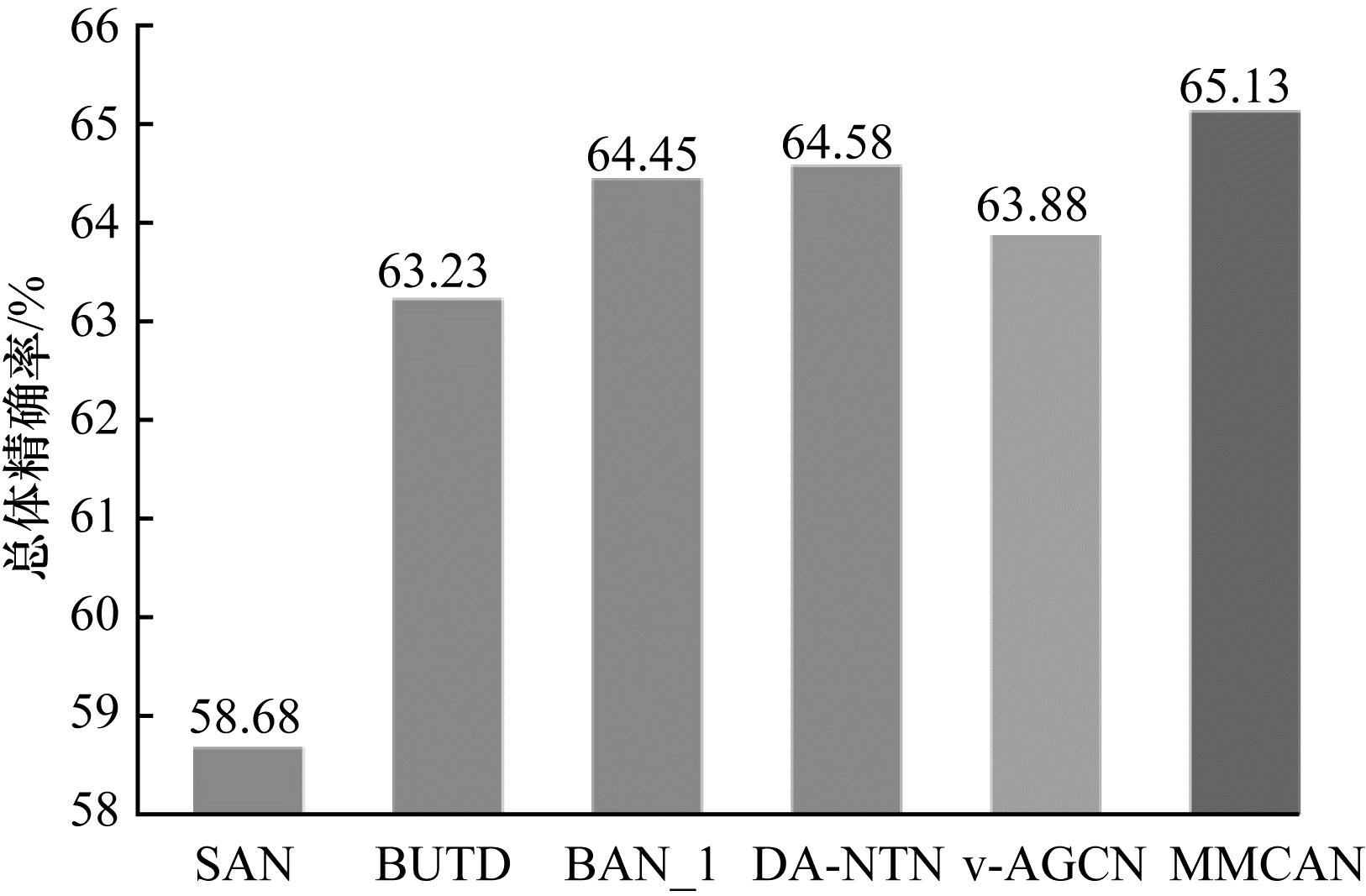

为进一步验证本文模型的有效性,本文在VQA 2.0验证集上与表 3中的注意力模型和图关系推理模型进行对比。如图 7所示,MMCAN模型的总体准确率为65.13%;与注意力模型SAN、BUTD、BAN_1和DA-NTN相比,MMCAN的总体精确度分别提高6.45、1.90、0.68和0.55个百分点;与图结构模型v-AGCN相比,MMCAN的总体精确度提高0.93个百分点。由于MLAN、Graph learning和Scence GCN并未报告其在VQA 2.0上的性能,因此没有进行比较。可以看出,MMCAN在验证集上的性能同样优于表 3中的模型。

|

Download:

|

| 图 7 不同模型在VQA 2.0验证集上的精确度 Fig. 7 Accuracy of different models on VQA 2.0 validation sets | |

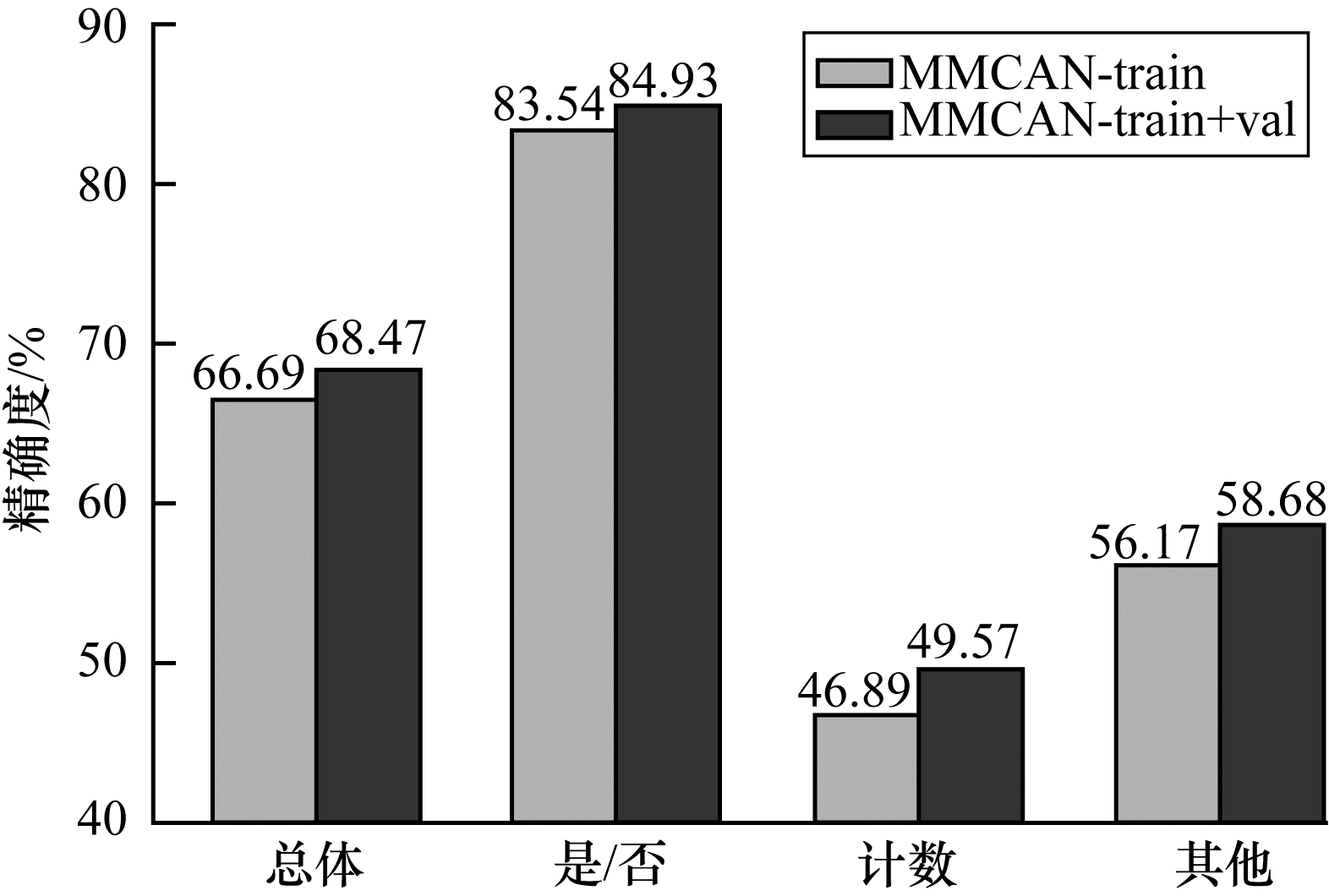

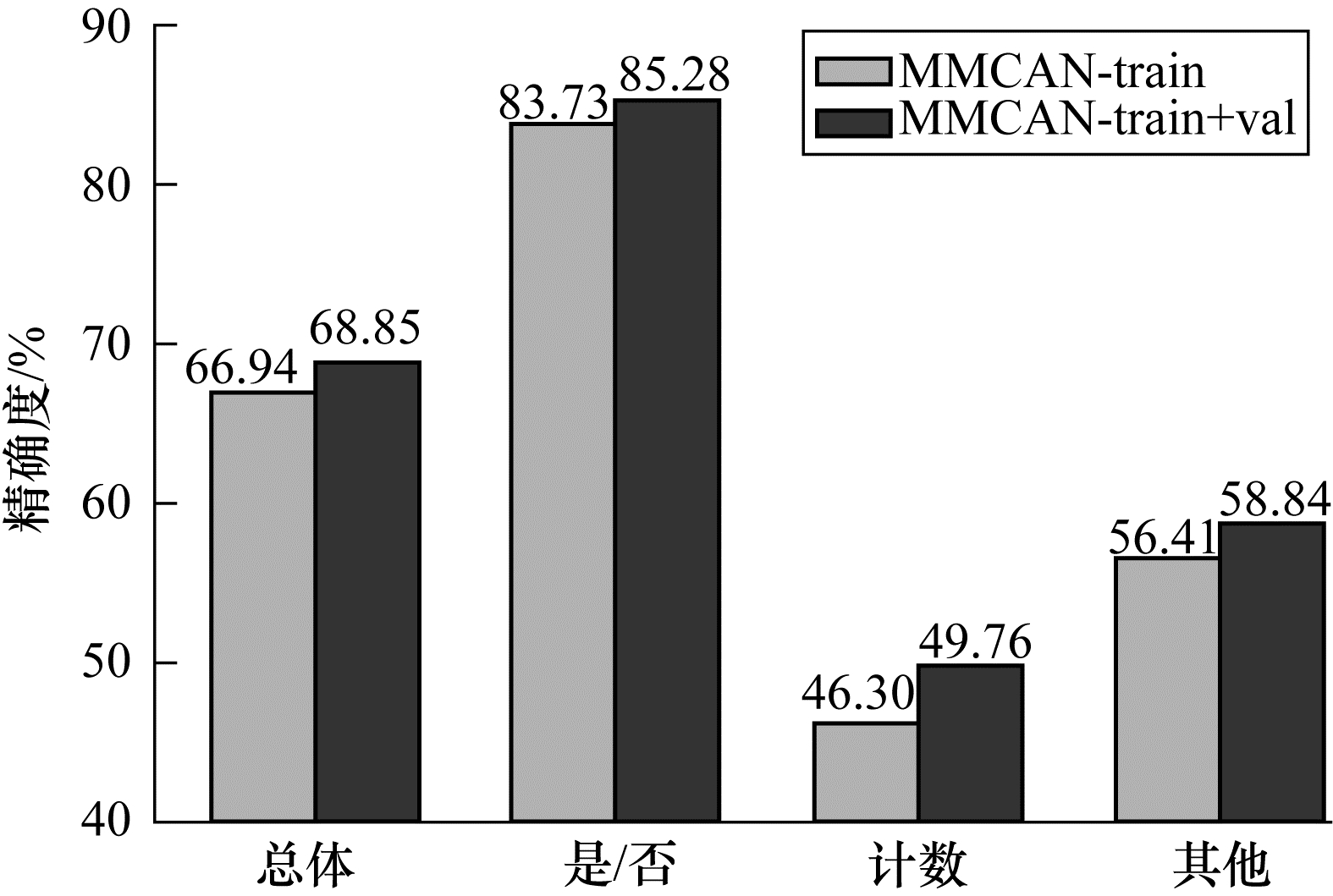

为对算法进行补充说明,将最优模型提交到VQA 2.0在线服务器上评估,由于服务器资源的限制,这里仅测试MMCAN模型。如图 8所示,在test-dev测试子集上,MMCAN-tarin关于“总体”、“是/否”、“计数”和“其他”4类问题的精确度分别为66.69%、83.54%、46.89%和56.17%,MMCAN-tarin+val的精确度分别为68.47%、84.93%、49.57%和58.68%。在图 9中,test-standard测试子集上MMCAN-tarin关于“总体”、“是/否”、“计数”和“其他”4类问题精确度为66.94%、83.73%、46.30%和56.41%,MMCAN-tarin+val分别为68.85%、85.28%、49.76%和58.84%。结果表明,在两个测试子集上,同时使用验证集辅助模型训练的精确度均优于单训练集,证明通过扩充数据集能有效提升模型性能。

|

Download:

|

| 图 8 不同问题在VQA 2.0 test-dev上的精确度 Fig. 8 Accuracy of different problems on VQA 2.0 test-dev | |

|

Download:

|

| 图 9 不同问题在VQA 2.0 test-standard上的精确度 Fig. 9 Accuracy of different problems on VQA 2.0 test-standard | |

本文提出一种面向视觉问答的多模块协同注意力网络(MMCAN)。MMCAN由一系列模块化组件构成,通过自适应问题图注意力机制对多种类型的视觉对象关系进行建模,以协同方式模拟单模态内和多模态间的动态交互作用,学习与问题最相关的视觉特征,进而提供完整的场景解释,实现对复杂问题的有效回答。实验结果表明,本文算法能够有效利用区域级视觉对象间相关辅助答案的推理,在推理答案过程中使用问题语义特征使模型聚焦于相关的图像区域,促进视觉问答准确率的提升。尽管本文算法在视觉问答各种子任务上获得优良性能,但在“计数”和“其他”类复杂问题上的精确度相对较低。下一步将研究如何有效缩减多模态间的语义鸿沟,例如基于先验知识对不存在显式关系的边进行剪枝、增强图网络的关系编码能力等,同时还将预训练一个视觉语言模型,专注于解决视觉问答中的某些子问题,如物体计数、基于常识的推理等。

| [1] |

ZHENG Q T, WANG Y P. Graph self-attention network for image captioning[C]//Proceedings of the 17th International Conference on Computer Systems and Applications. Washington D.C., USA: IEEE Press, 2020: 1-8.

|

| [2] |

XU X, WANG T, YANG Y, et al. Cross-modal attention with semantic consistence for image-text matching[J]. IEEE Transactions on Neural Networks and Learning Systems, 2020, 31(12): 5412-5425. |

| [3] |

ANTOL S, AGRAWAL A, LU J, et al. VQA: visual question answering[C]//Proceedings of IEEE International Conference on Computer Vision. Santiago, Chile: IEEE Press, 2015: 2425-2433.

|

| [4] |

JIANG H, MISRA I, ROHRBACH M, et al. In defense of grid features for visual question answering[C]//Proceedings of IEEE Computer Society Conference on Computer Vision and Pattern Recognition. Washington D.C., USA: IEEE Press, 2020: 10264-10273.

|

| [5] |

ANDERSON P, HE X, BUEHLER C, et al. Bottom-up and top-down attention for image captioning and visual question answering[C]//Proceedings of 2018 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. Washington D.C., USA: IEEE Press, 2018: 6077-6086.

|

| [6] |

ZHOU B, TIAN Y, SUKHBAATAR S, et al. Simple baseline for visual question answering[EB/OL]. [2021-02-10]. http://arxiv.org/abs/1512.02167v2.

|

| [7] |

FUKUI A, PARK D H, YANG D, et al. Multimodal compact bilinear pooling for visual question answering and visual grounding[C]//Proceedings of International IEEE Conference on Empirical Methods in Natural Language Processing. Washington D.C., USA: IEEE Press, 2016: 457-468.

|

| [8] |

TENEY D, ANDERSON P, HE X, et al. Tips and tricks for visual question answering: learnings from the 2017 Challenge[C]//Proceedings of 2018 IEEE Computer Society conference on Computer Vision and Pattern Recognition. Washington D.C., USA: IEEE Press, 2018: 4223-4232.

|

| [9] |

BAI Y, FU J, ZHAO T, et al. Deep attention neural tensor network for visual question answering[C]//Proceedings of European Conference on Computer Vision. Berlin, Gwemany: Springer, 2018: 21-37.

|

| [10] |

CADENE R, BEN-YOUNES H, CORD M, et al. MUREL: multimodal relational reasoning for visual question answering[C]//Proceedings of 2019 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. Washington D.C., USA: IEEE Press, 2019: 1989-1998.

|

| [11] |

CHEN K, WANG J, CHEN L C, et al. ABC-CNN: an attention based convolutional neural network for visual question answering[EB/OL]. [2021-02-10]. http://arxiv.org/abs/1511.05960.

|

| [12] |

YANG Z C, HE X, GAO J, et al. Stacked attention networks for image question answering[C]//Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition. Washington D.C., USA: IEEE Press, 2016: 21-29.

|

| [13] |

YU D, FU J, TIAN X, et al. Multi-source multi-level attention networks for visual question answering[C]//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. College Park, USA: IEEE Press, 2017: 4709-4717.

|

| [14] |

REN S, HE K, GIRSHICK R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149. DOI:10.1109/TPAMI.2016.2577031 |

| [15] |

VELICKOVIC P, CASANOVA A, LIO P, et al. Graph attention networks[C]//Proceedings of the 6th International Conference on Learning Representations. Vancouver, Canada: [s. n.], 2018: 1-12.

|

| [16] |

VASWANI A, SHAZEER N, PARMAR N, et al. Attention is all you need[C]//Proceedings of NIPSʼ17. Cambridge, USA: MIT Press, 2017: 5999-6009.

|

| [17] |

MNIH V, HEESS N, GRAVES A, et al. Recurrent models of visual attention[C]//Proceedings of NIPSʼ14. Cambridge, USA: MIT Press, 2014: 2204-2212.

|

| [18] |

BAHDANAU D, CHO K H, BENGIO Y. Neural machine translation by jointly learning to align and translate[C]//Proceedings of the 3rd International Conference on Learning Representations. San Diego, USA: IEEE Press, 2015: 1-15.

|

| [19] |

CHOROWSKI J K, BAHDANAU D, SERDYUK D, et al. . Attention-based models for speech recognition[C]//Proceedings of NIPSʼ15. Cambridge, USA: MIT Press, 2015: 577-585.

|

| [20] |

闫茹玉, 刘学亮. 结合自底向上注意力机制和记忆网络的视觉问答模型[J]. 中国图象图形学报, 2020, 25(5): 993-1006. YAN R Y, LIU X L. Visual question answering model based on bottom-up attention and memory network[J]. Journal of Image and Graphics, 2020, 25(5): 993-1006. (in Chinese) |

| [21] |

KIM J H, ON K W, LIM W, et al. Hadamard product for low-rank bilinear pooling[C]//Proceedings of the 5th International Conference on Learning Representations. Toulon, France: [s. n.], 2017: 1-14.

|

| [22] |

BEN-YOUNES H, CADENE R, CORD M, et al. MUTAN: multimodal tucker fusion for visual question answering//Proceedings of IEEE International Conference on Computer Vision. Washington D.C., USA: IEEE Press, 2017: 2631-2639.

|

| [23] |

LU J, YANG J, BATRA D, et al. Hierarchical question-image co-attention for visual question answering[C]//Proceedings of the 30th Conference on Neural Information Processing Systems. Barcelona, Spain: [s. n.], 2016: 289-297.

|

| [24] |

YU Z, YU J, XIANG C, et al. Beyond bilinear: generalized multimodal factorized high-order pooling for visual question answering[J]. IEEE Transactions on Neural Networks and Learning Systems, 2018, 29(12): 5947-5959. DOI:10.1109/TNNLS.2018.2817340 |

| [25] |

KIM J H, JUN J, ZHANG B T. Bilinear attention networks[EB/OL]. [2021-02-10]. http://arxiv.org/abs/1805.07932v2.

|

| [26] |

WANG P, WU Q, SHEN C, et al. The VQA-machine: learning how to use existing vision algorithms to answer new questions[C]//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. College Park, USA: IEEE Press, 2017: 3909-3918.

|

| [27] |

白亚龙. 面向图像与文本的多模态关联学习的研究与应用[D]. 哈尔滨: 哈尔滨工业大学, 2018. BAI Y L. Research and application of image-text multimodal association learning[D]. Haerbing: Harbin Institute of Technology, 2018. (in Chinese) |

| [28] |

TANG K H, ZHANG H W, WU B Y, et al. Learning to compose dynamic tree structures for visual contexts[C]//Pressings of 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Washington D.C., USA: IEEE Press, 2019: 6612-6621.

|

| [29] |

HU Z, WEI J L, HUANG Q B, et al. Graph convolutional network for visual question answering based on fine-grained question representation[C]//Pressings of the 5th IEEE International Conference on Data Science in Cyberspace. Washington D.C., USA: IEEE Press, 2020: 218-224.

|

| [30] |

LU P, JI L, ZHANG W, et al. R-VQA: learning visual relation facts with semantic attention for visual question answering[C]//Proceedings of ACM SIGKDD International Conference on Knowledge Discovery and Data Mining. Boston, USA: ACM Press, 2018: 1880-1889.

|

| [31] |

TENEY D, LIU L, VAN DEN H A. Graph-structured representations for visual question answering[C]//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. College Park, USA: IEEE Press, 2017: 3233-3241.

|

| [32] |

NORCLIFFE-BROWN W, VAFEIAS E, PARISON S. Learning conditioned graph structures for interpretable visual question answering[C]//Proceedings of NIPSʼ18. Cambridge, USA: MIT Press, 2018: 8334-8343.

|

| [33] |

YANG Z Q, QIN Z, YU J, et al. Multi-modal learning with prior visual relation reasoning[EB/OL]. [2021-02-10]. http://arxiv.org/abs/1812.09681v1.

|

| [34] |

LI L J, GAN Z, CHENG Y, et al. Relation-aware graph attention network for visual question answering[C]//Proceedings of 2019 IEEE/CVF International Conference on Computer Vision. Washington D.C., USA: IEEE Press, 2019: 10312-10321.

|

| [35] |

ZHU X, MAO Z D, CHEN Z N. Object-difference drived graph convolutional networks for visual question answering[J]. Multimedia Tools and Applications, 2020, 12: 1-19. |

| [36] |

YANG Z Q, QIN Z C, YU Jet al. Prior visual relationship reasoning for visual question answering[C]//Proceedings of 2020 IEEE International Conference on Image Processing. Washington D.C., USA: IEEE Press, 2020: 1411-1415.

|

| [37] |

CAO Q X, LIANG X D, WANG K Z, et al. Linguistically driven graph capsule network for visual question reasoning[EB/OL]. [2021-02-10] http://arxiv.org/abs/2003.10065.

|

| [38] |

HUANG D, CHEN P H, ZENG R H, et al. Location-aware graph convolutional networks for video question answering[EB/OL]. [2021-02-10]. http://arxiv.org/abs/2008.09105.

|

| [39] |

KIPF T N, WELLING M. Semi-supervised classification with graph convolutional networks[C]//Proceedings of the 5th International Conference on Learning Representations. Toulon, France: [s. n.], 2017: 1-14.

|

| [40] |

NARASIMHAN M, LAZEBNIK S, SCHWING A G. Out of the box: reasoning with graph convolution nets for factual visual question answering[EB/OL]. [2021-02-10]. https://arxiv.org/pdf/1811.00538.pdf.

|

| [41] |

于东飞. 基于注意力机制与高层语义的视觉问答研究[D]. 合肥: 中国科学技术大学, 2019. YU D F. Attention mechanism and high-level semantics for visual question answering[D]. Hefei: University of Science and Technology of China, 2019. (in Chinese) |

| [42] |

KRISHNA R, ZHU Y, GROTH O, et al. Visual genome: connecting language and vision using crowdsourced dense image annotations[J]. International Journal of Computer Vision, 2017, 123(1): 32-73. |

| [43] |

PENNINGTON J, RICHARD S C D M. GloVe: global vectors for word representation[C]//Proceedings of Conference on Empirical Methods in Natural Language Processing. Doha, Qatar: IEEE Press, 2014: 1532-1543.

|

| [44] |

JIMMY B, KIROS J, HINTON G E. Layer normalization[EB/OL]. [2021-02-10]. http://arxiv.org/abs/1607.06450.

|

| [45] |

GOYAL Y, KHOT T, AGRAWAL A, et al. Making the V in VQA matter: elevating the role of image understanding in visual question answering[J]. International Journal of Computer Vision, 2017, 127(4): 398-414. |

| [46] |

AGRAWAL A, BATRA D, PARIKH D, et al. Don't just assume; Look and answer: overcoming priors for visual question answering[C]//Proceedings of 2018 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. Salt Lake City, USA: IEEE Press, 2018: 4971-4980.

|

| [47] |

LIN T Y, MAIRE M, BELONGIE S, et al. Microsoft COCO: common objects in context[C]//Proceedings of PARTʼ14. Zurich, Switzerland: Springer, 2014: 740-755.

|

| [48] |

GOYAL P, DOLLAR P, GIRSHICK R, et al. Accurate, large minibatch SGD: training imagenet in 1 hour. [EB/OL]. [2021-02-10]. http://arxiv.org/abs/1706.02677.

|

| [49] |

MALINOWSKI M, DOERCH C, SANTORO A, et al. Learning visual question answering by bootstrapping hard attentiont[C]//Proceedings of LNCS'18. Zurich, Switzerland: Springer, 2018: 3-20.

|

2022, Vol. 48

2022, Vol. 48

,

,