2. 上海健康医学院 医疗器械学院, 上海 201318;

3. 上海计算机软件技术开发中心, 上海 200235

2. School of Medical Devices, Shanghai University of Medicine and Health Sciences, Shanghai 201318, China;

3. Shanghai Computer Software Technology Development Center, Shanghai 200235, China

开放科学(资源服务)标志码(OSID):

北方城市在秋冬季多会出现雾霾、沙尘等视觉障碍现象,这是由大气中悬浮的细微水滴、灰尘、硫酸、烟雾等粒子急剧增加所造成。由于介质粒子吸收物体光照,散射大气光,使得摄像系统拍摄到的图像多呈现灰白色,饱和度和对比度均有所损失,难以分辨图像中的物体。图像去雾能够为后续高级计算机视觉任务如语义分割[1]、目标追踪和识别[2]、智能交通监控等带来更加理想的结果。

随着计算机硬件快速发展,基于神经网络的学习方法被广泛应用于图像处理领域。研究人员采用深度学习方法获得端到端的图像映射模型,其均为难以用数学公式精确表达的物理模型。计算机视觉高级任务对图像去雾后图像的视觉感知和细节纹理要求极高,深度学习的应用缓解了量化指标无法大幅提升的瓶颈。生成对抗网络[3]具有强大的图像重建能力,在无监督学习上的表现优异,一经提出就受到国内外研究人员的广泛关注。

本文将生成对抗网络引入到循环卷积神经网络中,迭代重建出清晰图像。利用生成网络中密集反馈模块的反馈连接实现反馈机制,引导整个网络有导向地学习成雾原理,逐步提高网络的重建能力。通过解码模块融合编码模块的特征,快速准确地恢复出纹理精细的残差特征图。此外,在判别网络中根据Wasserstein距离确定最后的去雾图像。

1 相关工作经过多年的研究,研究人员提出了许多图像去雾方法。传统的图像去雾方法主要从以下2个处理方向着手:

1)直接通过增强图像的饱和度、对比度、清晰度等来增加雾图中物体的视觉效果;

2)运用大气散射模型原理,通过优化估计的透射率或大气光,提高图像去雾性能。图像增强是从图像本身特性出发,突出其中的景物来达到图像去雾的目的,主要有直方图均衡化[4]、同态滤波[5]、Retinex理论[6]、小波变换[7-8]等方法。但这些方法并不是针对雾的形成原理所提出的方法,没有明确的去雾目的。图像去雾后效果参差不一,对浓雾图像复原效果差,且易出现噪声。

针对雾的形成原因,许多研究人员利用先验知识对大气散射[9]模型重新反向推演,求得清晰的去雾图像,大气散射模型可表示为:

| $ I\left(x\right)=J\left(x\right)t\left(x\right)+A(1-t(x\left)\right) $ | (1) |

其中:

随着深度学习在计算机视觉上的广泛运用,CAI等[14]采用学习的方法,利用卷积神经网络计算透射率图。ZHANG等[15]采用双分支网络分别学习透射率图和大气光强度,并在网络中嵌入大气散射模型。此类方法的求解原理仍然是从大气散射模型出发,但有雾图像与清晰图像之间的映射关系并非与大气散射模型完全适配。显然,深度学习可以更加准确地学习有雾图像与清晰图像之间的统计关系。CHEN等[16]提出一种端到端的平滑扩张卷积的全局跳跃残差网络,可以恢复出较为清晰的图像。LIU等[17]借助语义分割的方法,提出拥有注意力机制的GridDehazeNet,解决了跨尺度信息交换的问题,缓解了信息交互的瓶颈。DENG等[18]提出可将雾图分为无雾层和有雾层,利用多个模型融合方法,提高去雾性能。

循环神经网络RNN已成功用于计算机视觉[19],受到上述方法的启发,本文提出一种针对图像去雾的端到端循环生成对抗网络算法。借助对抗生成网络,在循环神经网络RNN的框架下实现迭代过程,并在RNN的隐藏状态下实现信息的反馈。在此基础上,损失绑定会使网络在每次迭代时重建清晰图像,且判别网络能够确定是否恢复出高质的图像。

2 循环生成对抗网络生成对抗网络由GOODFELLOW等[3]提出后,被引入图像处理方向[20-21]。其基本结构包含一个生成器

| $ \underset{G}{\mathrm{m}\mathrm{i}\mathrm{n}}\left\{\underset{D}{\mathrm{m}\mathrm{a}\mathrm{x}}\underset{x\sim {\mathbb{P}}_{r}}{\mathbb{E}}\left[\mathrm{l}\mathrm{o}{\mathrm{g}}_{a}D\left(x\right)\right]+\underset{z\sim {\mathbb{P}}_{g}}{\mathbb{E}}\left[\mathrm{l}\mathrm{o}{\mathrm{g}}_{a}(1-D(G\left(z\right)\left)\right)\right]\right\} $ | (2) |

其中:

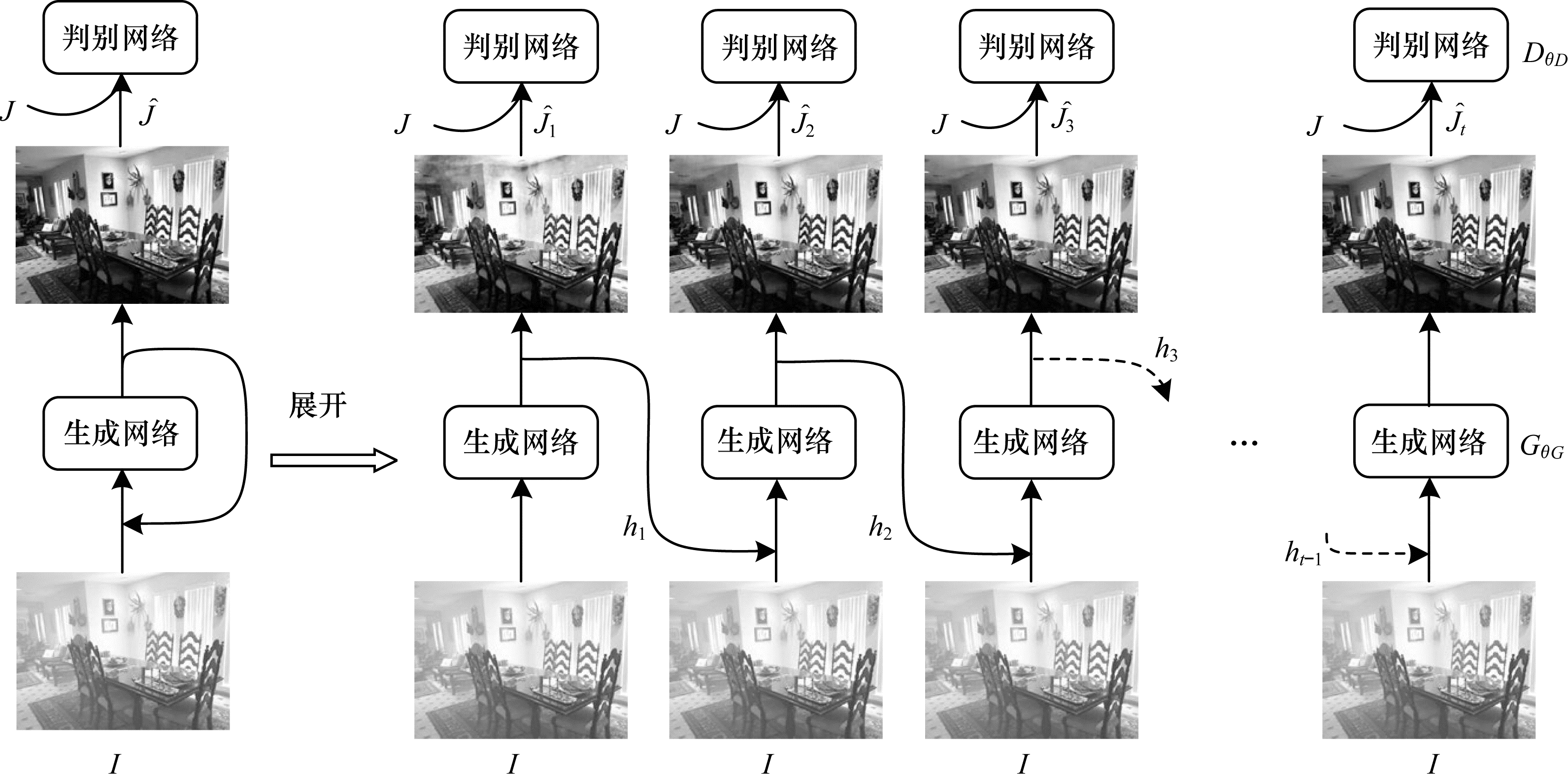

本文算法宏观整体结构如图 1所示,输入雾图首先进入生成网络,生成阶性去雾图像,随后和真实清晰图像一起进入判别网络,得到它们之间的差异。网络可以展开为

|

Download:

|

| 图 1 循环生成对抗网络的整体结构 Fig. 1 Overall structure of recurrent generative adversarial network | |

|

Download:

|

| 图 2 循环生成对抗网第t次迭代后的结构 Fig. 2 The t-th iteration structure of recurrent generative adversarial network | |

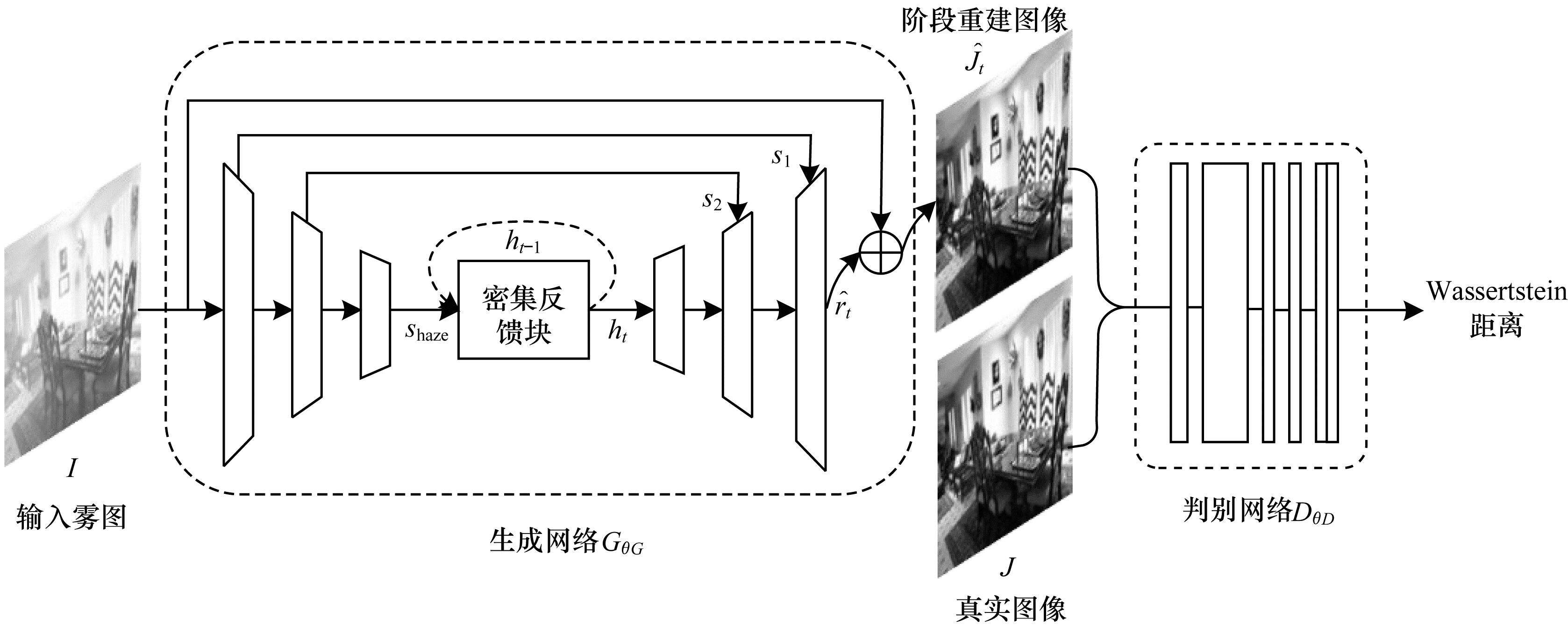

生成网络

|

Download:

|

| 图 3 相邻2次迭代后生成的网络结构 Fig. 3 Network structure generated after two adjacent iterations | |

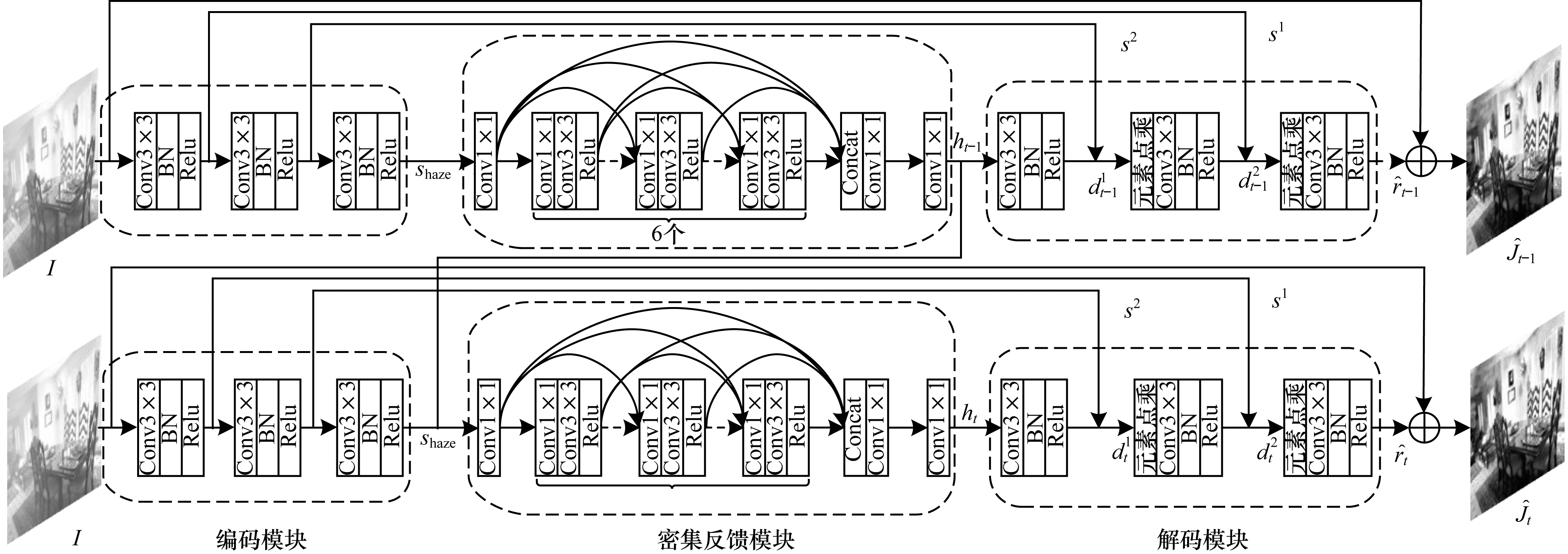

编码模块由3个卷积单元组成,每个卷积单元分别包含一个3×3卷积操作、一个归一化层和一个ReLU激活函数层,由卷积单元提取出浅层的低维雾图特征信息。密集反馈模块首先经过1个卷积核大小为1×1的卷积层,将参数信息整合后继续向后传输。接着有6个卷积单元,每个卷积单元间以密集连接的方式连接,卷积单元包含1个1×1的卷积操作,1个3×3的卷积操作以及1个归一化操作。卷积单元中的1×1卷积是为了获得参数并提高计算效率,减少信息的冗余度。之后将各个卷积单元的信息拼接进行特征融合,并通过1×1卷积操作加深高维特征融合的程度。

在解码模块中,利用所获得的高维度特征信息阶段性地恢复有雾图像与清晰图像间的残差图

以相邻的第

| $ {s}^{1}={F}_{E}\left(I\right)=f\left({B}_{\mathrm{B}\mathrm{N}}\right({W}_{E1}\times I+{B}_{E1}\left)\right) $ | (3) |

其中:

| $ f\left(x\right)=\mathrm{m}\mathrm{a}\mathrm{x}(0, x) $ | (4) |

本文将1次卷积单元操作抽象为编码模块操作

| $ {s}_{\mathrm{h}\mathrm{a}\mathrm{z}\mathrm{e}}={F}_{E}\left({F}_{E}\right({F}_{E}\left(I\right)\left)\right)={F}_{\mathrm{e}\mathrm{c}\mathrm{o}\mathrm{d}\mathrm{e}\mathrm{r}}\left(I\right) $ | (5) |

其中:第

| $ {h}_{t}={F}_{\mathrm{D}\mathrm{F}\mathrm{B}}({s}_{\mathrm{h}\mathrm{a}\mathrm{z}\mathrm{e}}, {h}_{t-1}) $ | (6) |

其中:

| $ {d}_{t}^{1}={F}_{D}\left({h}_{t}\right)=f\left({B}_{\mathrm{B}\mathrm{N}}\right({W}_{D1}\times {h}_{t}+{B}_{D1}\left)\right) $ | (7) |

其中:

| $ {d}_{t}^{2}={F}_{D}({d}_{t}^{1}\odot {s}^{2})=f\left({B}_{\mathrm{B}\mathrm{N}}\right({W}_{D2}\times ({d}_{t}^{1}\odot {s}^{2})+{B}_{D2}\left)\right) $ | (8) |

其中:

| $ {\hat{r}}_{t}={F}_{D}({d}_{t}^{2}\odot {s}^{1})=f\left({B}_{\mathrm{B}\mathrm{N}}\right({W}_{D3}\times ({d}_{t}^{2}\odot {s}^{1})+{B}_{D3}\left)\right) $ | (9) |

同样,将3次反卷积单元操作抽象为解码模块操作

| $ {\hat{r}}_{t}={F}_{D}\left({F}_{D}\right({F}_{D}\left({h}_{t}\right)\odot {s}^{2})\odot {s}^{1})={F}_{\mathrm{d}\mathrm{e}\mathrm{c}\mathrm{o}\mathrm{d}\mathrm{e}\mathrm{r}}({h}_{t}, {s}^{2}, {s}^{1}) $ | (10) |

最后,

| $ {\hat{J}}_{t}=I+{\hat{r}}_{t} $ | (11) |

将单次迭代中的式(5)、式(6)、式(10)具体为生成网络

| $ {\hat{J}}_{t}={G}_{\theta G}\left(I\right) $ | (12) |

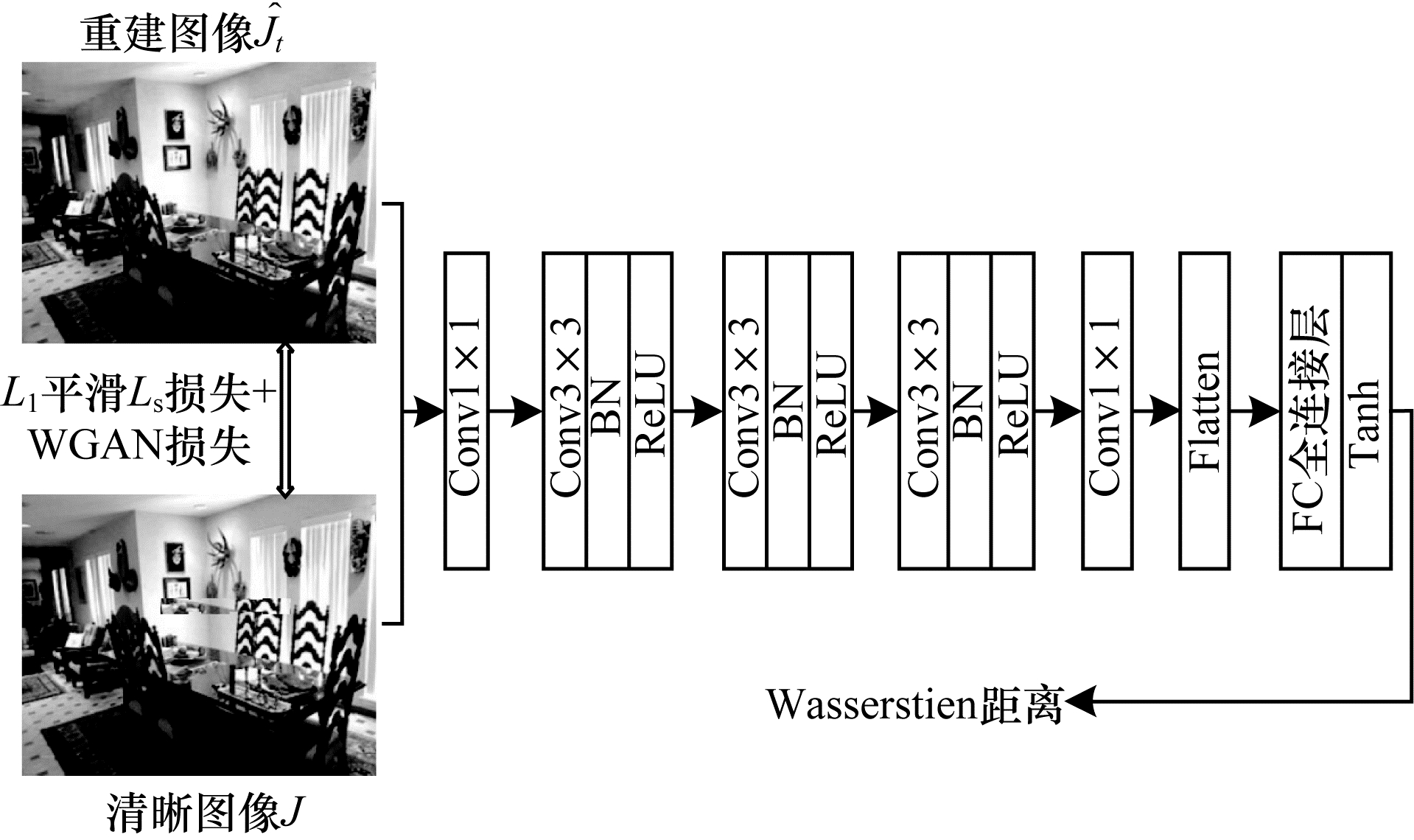

判别网络

|

Download:

|

| 图 4 判别网络结构 Fig. 4 Discriminant network structure | |

激活函数的表达式为:

| $ \mathrm{T}\mathrm{a}\mathrm{n}\mathrm{h}\left(x\right)=\frac{{\mathrm{e}}^{x}-{\mathrm{e}}^{-x}}{{\mathrm{e}}^{x}+{\mathrm{e}}^{-x}} $ | (13) |

原始GAN的结果是针对二分类的非真即假,而WGAN[22]输出的则是Wasserstein距离,用于回归任务,表示生成分布与真实分布间的距离,当生成去雾图像越接近真实清晰图像时,Wasserstein距离会越小。Wasserstein距离是人为定义的针对数据分布

| $ W({\mathbb{P}}_{r}, {\mathbb{P}}_{g})=\underset{\gamma \in \Pi ({\mathbb{P}}_{r}, {\mathbb{P}}_{g})}{\mathrm{i}\mathrm{n}\mathrm{f}}{}_{(\hat{J}, J)\sim \gamma }\left[‖\hat{J}-J‖\right] $ | (14) |

其中:

本文使用联合损失函数优化整个网络,相对于

| $ {L}_{S}=\frac{1}{t}\sum\limits _{i=1}^{t}{F}_{S}\left({\hat{J}}_{i}\right(x)-J(x\left)\right) $ | (15) |

其中:

| $ {F}_{S}\left(e\right)=\left\{\begin{array}{cc}0.5{e}^{2}, \left|e\right| < 1& \\ \left|e\right|-0.5, \mathrm{其}\mathrm{他}& \end{array}\right. $ | (16) |

本文使用WGAN损失作为对抗损失,可表示为:

| $ {L}_{\mathrm{G}\mathrm{A}\mathrm{N}}=\sum\limits _{i=1}^{t}-{D}_{\theta D}\left({G}_{\theta G}\right(I\left)\right) $ | (17) |

网络总的损失函数由

| $ {L}_{\mathrm{t}\mathrm{o}\mathrm{a}\mathrm{l}}=\lambda \times {L}_{S}+{L}_{\mathrm{G}\mathrm{A}\mathrm{N}} $ | (18) |

将参数

为客观公正地与对比算法做性能比较,本文使用公共的RESIDE[23]数据集来训练网络。另外,使用了在真实世界中有雾图像的数据集[24]验证几种对比方法的视觉效果。RESIDE数据集包含成对的有雾图像和相应的清晰图像,由3部分组成:室内训练集(ITS),综合客观测试集(SOTS)和混合主观测试集(HSTS)。这些数据集均借助大气散射模型所生成。NYU2[25]和Middlebury Stereo[26]是包含室内深度信息的数据集,从中选出1 399个图像,搭配不同的大气光A和散射系数β,生成ITS的13 990张有雾图像,A和β分别在区间[0.7,1.0]和[0.6,1.8]2个区间里均匀随机地选取。1张清晰的图像搭配使用不同的参数A和β,生成10个相应的有雾图像。测试数据集STOS选择了来自NYU2的50张清晰图像(未与训练集中的清晰图像重复),以相同的方式生成500张有雾图像。HSTS包含10个合成的室外有雾图像和10个真实世界的有雾图像。RESIDE室外补充训练数据集RESIDE-β包含296 695个有雾图像也是按照相同的方法生成的。本文仅使用SOTS作为测试数据集。

3.2 实验参数设置为充分使用有雾图像的上下文信息并加快训练速度,本文首先将有雾图像划分为60×60大小相等的的图像块,然后将分割后的有雾图像块输入网络进行训练,最后将经过处理的图像块重新组合在一起,并输出去雾清晰图像。每次迭代(最后一次迭代除外)的输出视为阶段性结果,最后一次网络迭代的输出是最终的去雾结果。网络训练的Batch Size设置为16,使用与文献[29]相同的方式初始化网络参数,总共训练500个迭代周期,本文使用初始学习率为0.000 2的ADAM优化器优化网络,网络每经过100个迭代周期后,学习率将降低为上一次学习率的1/2。实验使用Linix系统下NVIDIA 1080 Ti型号的GPU,并基于Pytorch1.0框架的环境进行。

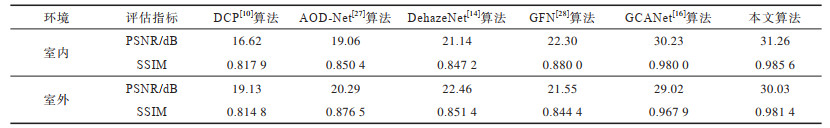

3.3 实验结果分析尽管文献[23]提出多种方法来评估图像的去雾效果,但平均峰值信噪比(PSNR)和结构相似性(SSIM)仍是最广泛使用的图像去雾效果评估指标。本文采用主流的平均PSNR和SSIM值用作为定量评估,PSNR和SSIM的值越高,表示图像的去雾效果越优秀。表 1中给出了6种不同去雾算法的实验结果。DCP[10]是基于暗通道先验的传统物理模型去雾算法。AOD-Net[27]、DehazeNet[14]、GFN[28]、GCANet[16]网络是数据驱动的学习算法,均使用到神经网络。其中,DehazeNet仍基于大气散射模型原理得到去雾图像,而获得透射率图和大气光强度是必要条件。由表 1可知,本文算法的室内和室外PSNR和SSIM指标均高于其他5种算法,且本文算法相较于GCANet,在SOTS室内的PSNR值提高了3.41%,SSIM值提高了0.57%,室外的PSNR值提高了3.48%,SSIM值提高了1.39%,本文提出的网络算法的性能优于其他5种图像去雾算法的性能。

|

下载CSV 表 1 不同算法的实验结果对比 Table 1 Comparison of experimental results of different algorithms |

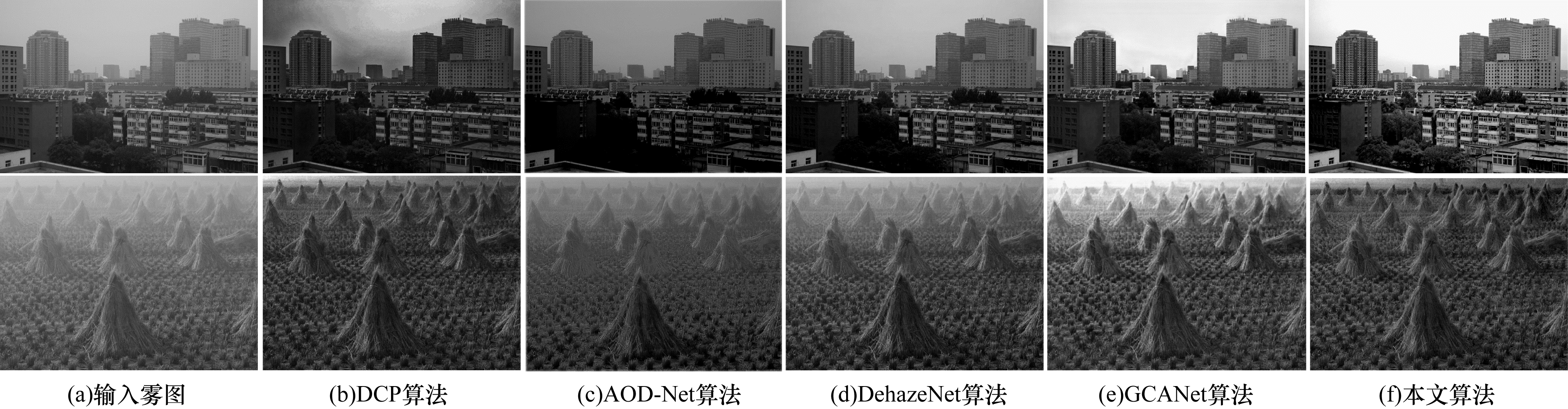

图 5展示了在SOTS数据集中2组室内图像和2组室外图像的去雾结果。在视觉上,可以清楚地观察到DCP算法处理后的图像亮度变暗,且经过去雾处理后图像的颜色与真实图像的颜色相差太大,出现严重失真现象。使用AOD-Net算法去雾过后的图像,仍有少量的雾气残留,导致图像的整体亮度略有下降。与DCP算法的处理结果相反,DehazeNet算法使得经过去雾处理后图像的亮度高于真实清晰图像的亮度。GFN算法可以有效去雾并减少伪影,但当去除较浓的雾时,图像上仍有少量余雾。尽管GCANet算法可以很好地消除图像中的雾气,但在细节处理上并不完美。如图 6所示,在处理真实世界的数据上,本文算法处理后的图像色彩饱和、纹理清晰,图像上没有余雾的残留,有很好的泛化性,与GCANet算法相比,能更好地处理图像细节和纹理,且去雾图像的亮度更接近于真实图像。

|

Download:

|

| 图 5 不同算法在SOTS数据集上的去雾效果对比 Fig. 5 Comparison of defogging effects of different algorithms on SOTS data set | |

|

Download:

|

| 图 6 不同算法在真实世界数据集上的去雾效果对比 Fig. 6 Comparison of defogging effects of different algorithms on real-word date set | |

选取2幅有雾图像,本文算法去雾后,用YOLOv3对4张图像进行目标检测。检测结果如图 7所示。

|

Download:

|

| 图 7 有雾图像和去雾图像的目标检测对比结果 Fig. 7 Comparison results of object detection between hazy images and dehazed images | |

将识别物体的准确率和正确识别物体的数目作为目标检测结果有效性的衡量。在误差允许范围

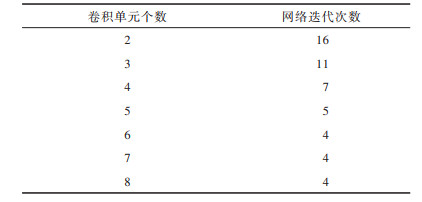

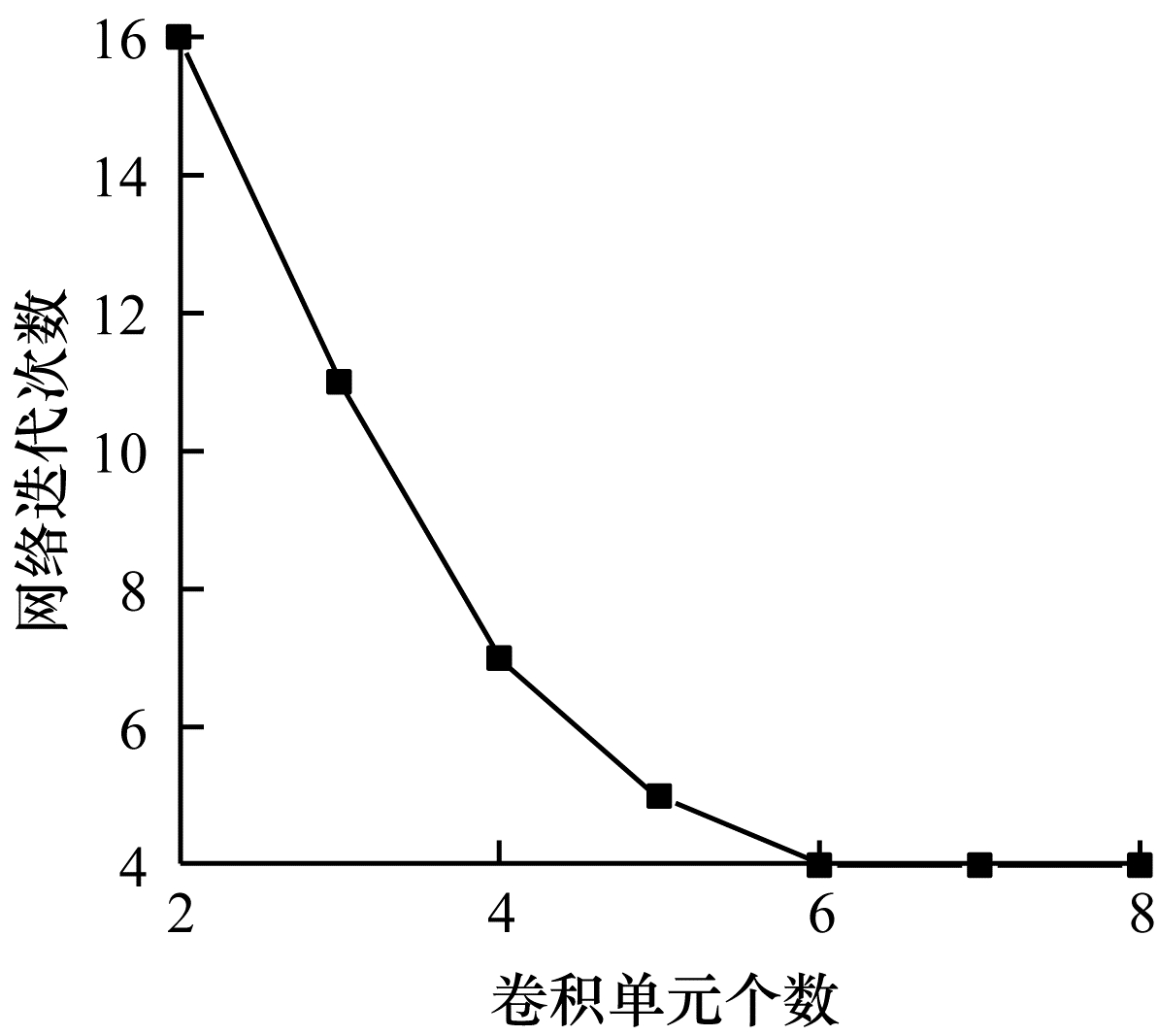

本文验证了生成网络中密集反馈模块的卷积单元个数N是否为影响网络表达性能的因素。在实验中设置不同数目的卷积单元,保持同样的密集连接,并将网络的其他参数均保持一致,以最后网络迭代的次数T作为衡量结果。实验结果如表 2所示,当卷积单元个数为2~6时,网络迭代次数随着卷积单元数目的增加不断减少;当卷积单元个数大于6个卷积块时,网络的迭代次数保持4次不变。迭代次数少,表示网络的表达能力强,可以快速地学习到特征信息;迭代次数多,表示网络的表达能力较弱,需经过多次学习才能学到等量的特征信息。

|

下载CSV 表 2 密集反馈模块卷积单元与迭代次数关系表 Table 2 The relationship between the number of convolution units of the dense feedback module and iterations |

将表 2绘制为图 8,可以清晰地观察到,密集反馈模块中卷积单元个数为6时,折线已达到最低值,网络性能最优,之后再增加卷积单元数目,网络性能并不会提升。

|

Download:

|

| 图 8 密集反馈模块卷积单元个数与迭代次数的关系 Fig. 8 Relationship between the number of convolution units of the dense feedback module and iterations | |

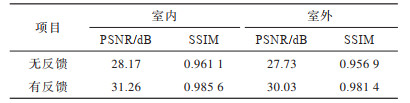

为进一步检测算法反馈连接的作用,本文进行了有反馈连接和无反馈连接的网络对比实验,无反馈连接的网络由有反馈的网络退化形成,各次迭代间没有相互联系。为公正地比较去雾结果,设置无反馈网络迭代次数与有反馈网络的迭代次数相等,在室内和室外数据集上测试了PSNR和SSIM值。如表 3所示,具有反馈机制的网络无论是在室内还是室外测试得到的PSNR和SSIM的平均值均高于没有反馈机制的网络,可以得出网络中的反馈机制可以提高图像去雾的效果。网络的迭代循环机制,实现了参数共享,且网络参数量减少到约为3 847K,平均单幅图像的计算时间仅为0.18 s。

|

下载CSV 表 3 网络在数据集上的有/无反馈连接实验结果对比 Table 3 Comparison of experimental results of the network with/without feedback connection on SOTS date set |

本文提出一种将循环神经网络与对抗生成网络相融合的单幅图像去雾算法。通过反馈信息引导生成网络中的浅层特征信息,从而丰富深层特征信息。利用全局跳跃连接学习残差特征图,并使用迭代循环结构减少误差累积效应,增强图像去雾效果。实验结果表明,本文算法所得到的去雾图像的色彩接近于真实图像,且纹理更精细,在PSNR和SSIM指标上优于其他去雾算法。由于真实世界中的雾图没有对应的清晰图像,因此,下一步将继续基于GAN网络向无监督学习方向扩展,提出无配对清晰图像的去雾学习算法,实现无标签的去雾图像重建,从而减少运算时间。

| [1] |

刘尚旺, 崔智勇, 李道义. 基于Unet网络多任务学习的遥感图像建筑地物语义分割[J]. 国土资源遥感, 2020, 32(4): 74-83. YANG L S W, CUI Z Y, LI D Y. Semantic segmentation of building features in remote sensing images based on unet multi-task learning[J]. Remote Sensing for Land and Resources, 2020, 32(4): 74-83. (in Chinese) |

| [2] |

董鹏曙, 向龙, 谢幼才, 等. 基于运动补偿的动目标检测处理方法[J]. 探测与控制学报, 2020, 42(6): 29-34. DONG P S, XIANG L, XIE Y C, et al. MTD process metrology based on motion compensation[J]. Journal of Detection and Control, 2020, 42(6): 29-34. (in Chinese) |

| [3] |

GOODFELLOW I, POUGET-ABADIE J, MIRZA M, et al. Generative adversarial nets[C]//Proceedings of the 27th International Conference on Neural Information Processing Systems. New York, USA: ACM Press, 2014: 2672-2680.

|

| [4] |

JU M Y, DING C, ZHANG D Y, et al. Gamma-correction-based visibility restoration for single hazy images[J]. IEEE Signal Processing Letters, 2018, 25(7): 1084-1088. DOI:10.1109/LSP.2018.2839580 |

| [5] |

董静薇, 赵春丽, 海博. 融合同态滤波和小波变换的图像去雾算法研究[J]. 哈尔滨理工大学学报, 2019, 24(1): 66-70. DONG J W, ZHAO C L, HAI B. Research on image De-fog algorithm based on fusion homomorphic filtering and wavelet transform[J]. Journal of Harbin University of Science and Technology, 2019, 24(1): 66-70. (in Chinese) |

| [6] |

LI M D, LIU J Y, YANG W H, et al. Structure-revealing low-light image enhancement via robust retinex model[J]. IEEE Transactions on Image Processing, 2018, 27(6): 2828-2841. DOI:10.1109/TIP.2018.2810539 |

| [7] |

WANG W C, YUAN X H, WU X J, et al. Fast image dehazing method based on linear transformation[J]. IEEE Transactions on Multimedia, 2017, 19(6): 1142-1155. DOI:10.1109/TMM.2017.2652069 |

| [8] |

刘策, 杨燕. 基于自适应小波融合的单幅图像去雾算法[J]. 光电子·激光, 2020, 31(3): 318-325. LIU C, YANG Y. Single image dehazing algorithm based on adaptive wavelet fusion[J]. Journal of Optoelectronics·Laser, 2020, 31(3): 318-325. (in Chinese) |

| [9] |

MCCARTNEY E J. Optics of the atmosphere: scattering by molecules and particles[J]. John Wiley and Sons, 1976, 10(2): 461-470. |

| [10] |

HE K M, SUN J, TANG X O, et al. Single image haze removal using dark channel prior[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2010, 33(12): 2341-2353. |

| [11] |

BERMAN D, TREIBITZ T, AVIDAN S. Non-local image dehazing[C]//Proceedings of IEEE Conference on Computer Vsion and Pattern Recognition. Washington D. C., USA: IEEE Press, 2016: 1674-1682.

|

| [12] |

于坤, 焦青亮, 刘子龙, 等. 基于中智学的非局部先验图像去雾算法[J]. 光学技术, 2020, 46(4): 476-482. YU K, JIAO Q L, LIU Z L, et al. Non-local prior image dehazing algorithm based on neutrosophy[J]. Optical Technique, 2020, 46(4): 476-482. (in Chinese) |

| [13] |

王殿伟, 闫伟超, 刘颖, 等. 基于暗原色先验的快速单幅图像去雾算法[J]. 计算机应用研究, 2018, 35(12): 3836-3840. WANG D W, YAN W C, LIU Y, et al. Fast single image dehazing algorithm based on dark channel prior[J]. Application Research of Computers, 2018, 35(12): 3836-3840. (in Chinese) |

| [14] |

CAI B L, XU X M, JIA K, et al. Dehazenet: an end-to-end system for single image haze removal[J]. IEEE Transactions on Image Processing, 2016, 25(11): 5187-5198. DOI:10.1109/TIP.2016.2598681 |

| [15] |

ZHANG H, PATEL V M, et al. Densely connected pyramid dehazing network[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Washington D. C., USA: IEEE Press, 2018: 3194-3203.

|

| [16] |

CHEN D D, HE M M, FAN Q N, et al. Gated context aggregation network for image dehazing and deraining[C]//Proceedings of 2019 IEEE Winter Conference on Applications of Computer Vision. Washington D. C., USA: IEEE Press, 2019: 1375-1383.

|

| [17] |

LIU X H, MA Y R, SHI Z H, et al. Griddehazenet: attention-based multi-scale network for image dehazing[C]//Proceedings of IEEE International Conference on Computer Vision. Washington D. C., USA: IEEE Press, 2019: 7314-7323.

|

| [18] |

DENG Z J, Z L, HU X W, et al. Deep multi-model fusion for single-image dehazing[C]//Proceedings of IEEE International Conference on Computer Vision. Washington D. C., USA: IEEE Press, 2019: 2453-2462.

|

| [19] |

任敏敏. 图像融合的循环神经网络去雾算法[J]. 小型微型计算机系统, 2020, 41(7): 1513-1518. REN M M. Recurrent network for Image Dehazing based on image fusion scheme[J]. Journal of Chinese Mini-Micro Computer Systems, 2020, 41(7): 1513-1518. (in Chinese) |

| [20] |

刘波宁, 翟东海. 基于双鉴别网络的生成对抗网络图像修复方法[J]. 计算机应用, 2018, 38(12): 3557-3562, 3595. LIU B N, ZHAI D H. Image completion method of generative adversarial networks based on two discrimination networks[J]. Journal of Computer Applications, 2018, 38(12): 3557-3562, 3595. (in Chinese) |

| [21] |

斯蒋芸, 谭宁, 张海, 等. 基于条件生成对抗网络的咬翼片图像分割[J]. 计算机工程, 2019, 45(4): 223-227. SI J Y, TAN N, ZHANG H, et al. Bitewing radiography image segmentation based on conditio-nal generative adversarial network[J]. Computer Engineering, 2019, 45(4): 223-227. (in Chinese) |

| [22] |

ARJOVSKY M, CHINTALA S, BOTTOU L. Wasserstein gan[EB/OL]. [2020-10-01]https://arxiv.org/abs/1701.07875v3.

|

| [23] |

LI B Y, REN W Q, FU D P, et al. Benchmarking single-image dehazing and beyond[J]. IEEE Transactions on Image Processing, 2018, 28(1): 492-505. |

| [24] |

FATTAL R. Dehazing using color-lines[J]. ACM Transactions on Graphics, 2014, 34(1): 1-14. |

| [25] |

SILBERMAN N, HOIEM D, KOHLI P, et al. Indoor segmentation and support inference from RGBD images[C]//Proceedings of European Conference on Computer Vision. Berlin, Germany: Springer, 2012: 746-760.

|

| [26] |

SCHARSTEIN D, SZELISKI R. High-accuracy stereo depth maps using structured light[C]//Proceedings of 2003 IEEE Computer Society Conference on Computer Vision and Pattern Recognition, Washington D. C., USA: IEEE Press, 2003: 11-17.

|

| [27] |

LI B Y, PENG X L, WANG Z Y, et al. Aod-net: all-in-one dehazing network[C]//Proceedings of IEEE International Conference on Computer Vision, Washington D. C., USA: IEEE Press, 2017: 4770-4778.

|

| [28] |

REN W Q, MA L, ZHANG J W, et al. Gated fusion network for single image dehazing[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Washington D. C., USA: IEEE Press, 2018: 3253-3261.

|

| [29] |

HE K M, ZHANG X Y, REN S Q, et al. Delving deep into rectifiers: surpassing human-level performance on imagenet classification[C]//Proceedings of IEEE International Conference on Computer Vision. Washington D. C., USA: IEEE Press, 2015: 1026-1034.

|

2022, Vol. 48

2022, Vol. 48