开放科学(资源服务)标志码(OSID):

人脸属性迁移可以看成是一类图像域到图像域的任务[1],其主要应用于数据预处理、辅助人脸识别、娱乐社交等领域。生成对抗网络[2]作为当前人脸属性迁移的主流架构,结合零和博弈的思想,在判别器和生成器协同对抗训练中不断提高生成图像的真实性和质量。相比使用配对图像训练数据集的有监督图像迁移方法[3],无监督图像迁移方法可以通过非配对图像数据集完成图像域迁移,具有更广泛的应用场景[4]。

根据训练过程中建立的源图像域和目标图像域的映射关系,无监督图像迁移分为单图像域迁移和多图像域迁移[5]。针对单图像域之间的映射关系,文献[6]提出DFI方法,根据线性特征空间假设直接从源图像域特征空间学习目标图像的属性特征,以实现单图像域人脸属性的迁移。文献[7]提出cycleGAN方法,引入循环重构一致性约束,采用两个生成器和判别器在另外一个生成器中对生成的迁移图像进行重构,从而更好地建立图像域之间的映射关系。文献[8]在cycleGAN的基础上,通过引入自注意力机制建立像素间远近距离的依赖性,以更好地还原图像的细节信息,并通过谱规范化提升模型的稳定性,从而提高迁移图像的真实性。但是无监督的单图像域人脸属性迁移只能在单个人脸属性图像域之间进行,如果进行多个图像域迁移,需分别对每个图像域进行单独训练,增大了训练的难度。

多图像域人脸属性迁移是单图像域迁移的拓展,其目标是在一次训练过程中完成多个图像域之间的迁移。文献[9]提出IcGAN方法,使用标签完成人脸图像重构以及多图像域迁移,采用两个编码器分别提取图像中的内容信息和属性标签信息,再通过CGAN[10]生成指定的迁移图像。文献[11]在UNIT[12]基础上提出MUNIT方法,基于图像可以分解成固定的内容编码和样式编码的假设,利用自适应实例归一化融合两个编码器,并分别提取内容编码和样式编码,从而完成多图像域的迁移任务。文献[1]提出的ELEGANT方法,通过提取图像中各个属性的内容信息来建立每个属性和隐层编码特征向量的位置关系,以指导多图像域人脸属性迁移。同样,文献[13]提出的StarGAN方法,在生成器网络中引入目标图像域标签信息,通过循环重构一致性约束保证迁移图像域前后的一致性,并结合分类损失函数指导建立源图像域和目标标签的映射关系,从而完成多图像域人脸属性迁移。文献[14]在StarGAN基础上提出StarGAN v2,利用映射网络生成样式编码信息,生成器将源域输入图像和生成的样式编码信息迁移成目标域图像,以增加迁移图像域的多样性。文献[15]基于Attgan[16]提出STGAN方法,利用选择性传输单元(Selective Transfer Units,STU)将编码器提取的图像内容特征根据差分属性标签选择性传输到解码器,以降低跳跃连接对图像分辨率的影响,从而减少无关图像域的变化,且提升多图像域人脸属性迁移的质量。

当前多图像域人脸属性迁移方法能够较好地建立目标标签与迁移图像域之间的对应关系,但仍存在图像域表达形式多样性差、无关迁移图像域变化较大和判别器准确度低的问题,通过类别标签指导的多图像域人脸属性迁移直接输入离散形式的目标标签,一方面无法明确迁移目标图像域和源图像域之间的差异,另一方面造成图像域表达方式多样性的损失。下采样的卷积操作导致图像分辨率降低和图像迁移细节失真。单个判别器的鉴别能力无法准确定位迁移的图像域,导致判定准确度低,从而降低生成图像的协调性与真实性。在寻找纳什均衡解的过程中,判别器未能很好地使用输入数据(一半是真一半是假)的先验知识,导致目标图像域定位不够准确,且指定图像域的迁移效果欠佳。

为改进多图像域人脸属性迁移的视觉效果,本文提出一种多图像域人脸属性迁移方法。在生成器网络设计中,通过引入相对属性标签[18]和选择性传输单元,迁移目标图像域。利用图像域控制器和自适应实例归一化[19]融合内容特征和样式特征。在判别器网络设计中,采用双尺度判别提高人脸属性迁移的图像质量。在损失函数设计中,设计融合相对鉴别[20]与铰链损失的铰链对抗损失函数,从而提升指定图像域的整体迁移效果。

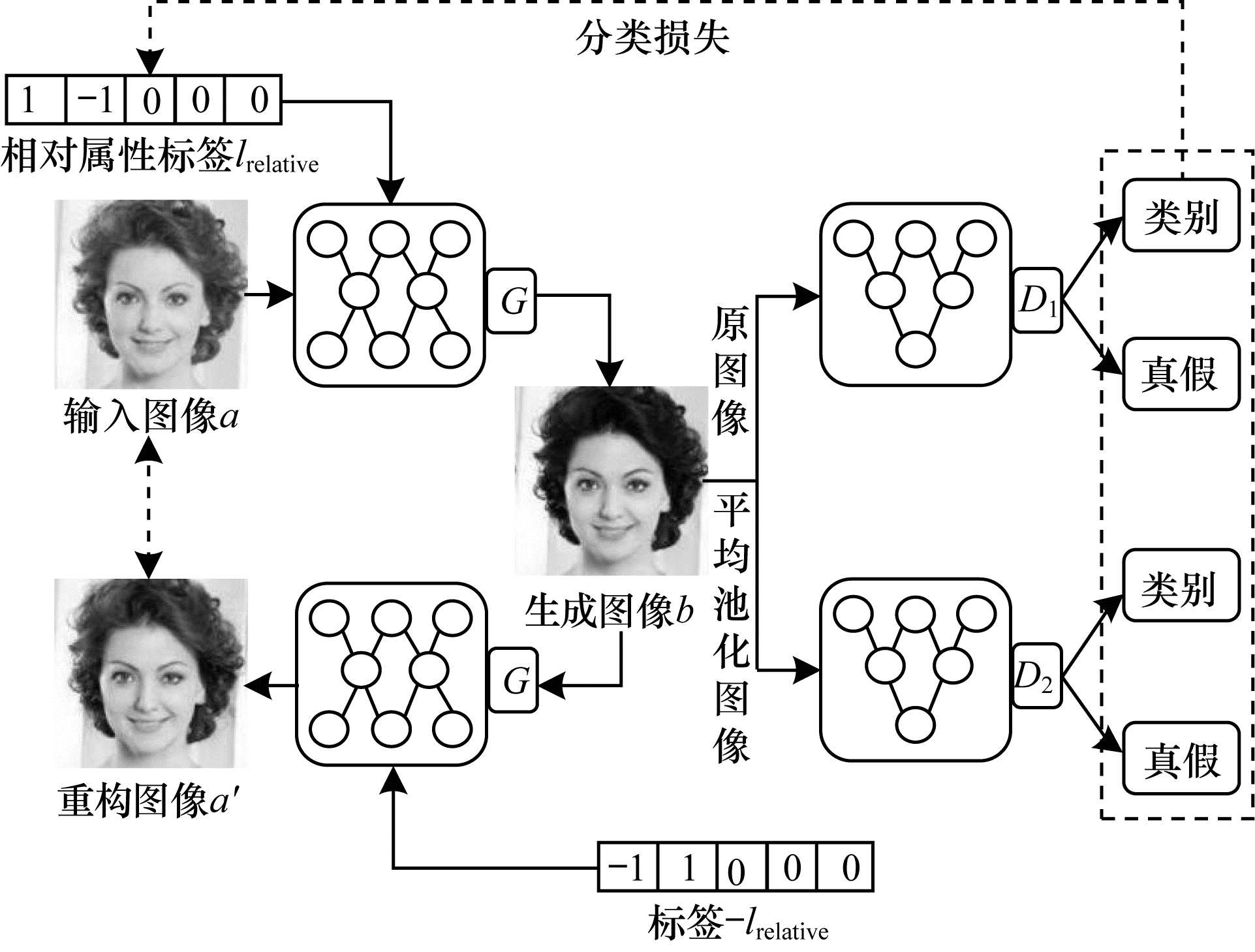

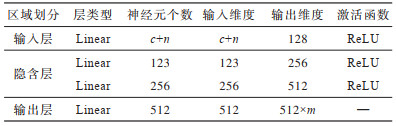

1 融合选择性传输和铰链对抗的迁移模型 1.1 整体模型人脸属性迁移任务的本质是在保证其他区域像素不变的情况下,通过修改特定部分的像素获取迁移目标图像。基于此,本文设计的多图像域人脸属性迁移整体结构由一个生成器G和两个判别器D组成,如图 1所示。生成器网络由基本网络和图像域控制器组成,其中基本网络由编码器、解码器构成,图像域控制器由多层感知机(Multilayer Perceptron,MLP)构成,主要生成目标图像的样式信息。判别器整体结构由鉴别网络和分类网络2个部分组成,真假信息由鉴别网络输出,迁移图像域类别信息由分类网络获取,如图 1所示。

|

Download:

|

| 图 1 本文模型整体结构 Fig. 1 Overall structure of the proposed model | |

从图 1可以看出,属性标签中每个位置的具体值分别表示其中的一种人脸属性图像域,为减少目标图像域和生成图像域之间的差异性,本文模型采用相对属性标签作为输入,模型的整体流程主要是将真实图像

本文模型设计了相对属性标签,通过单个生成器和双尺度判别器相互对抗,使其专注于生成目标图像域,利用对抗损失和分类损失指导生成器建立相对属性标签和生成图像域的映射,从而完成多图像域迁移任务。

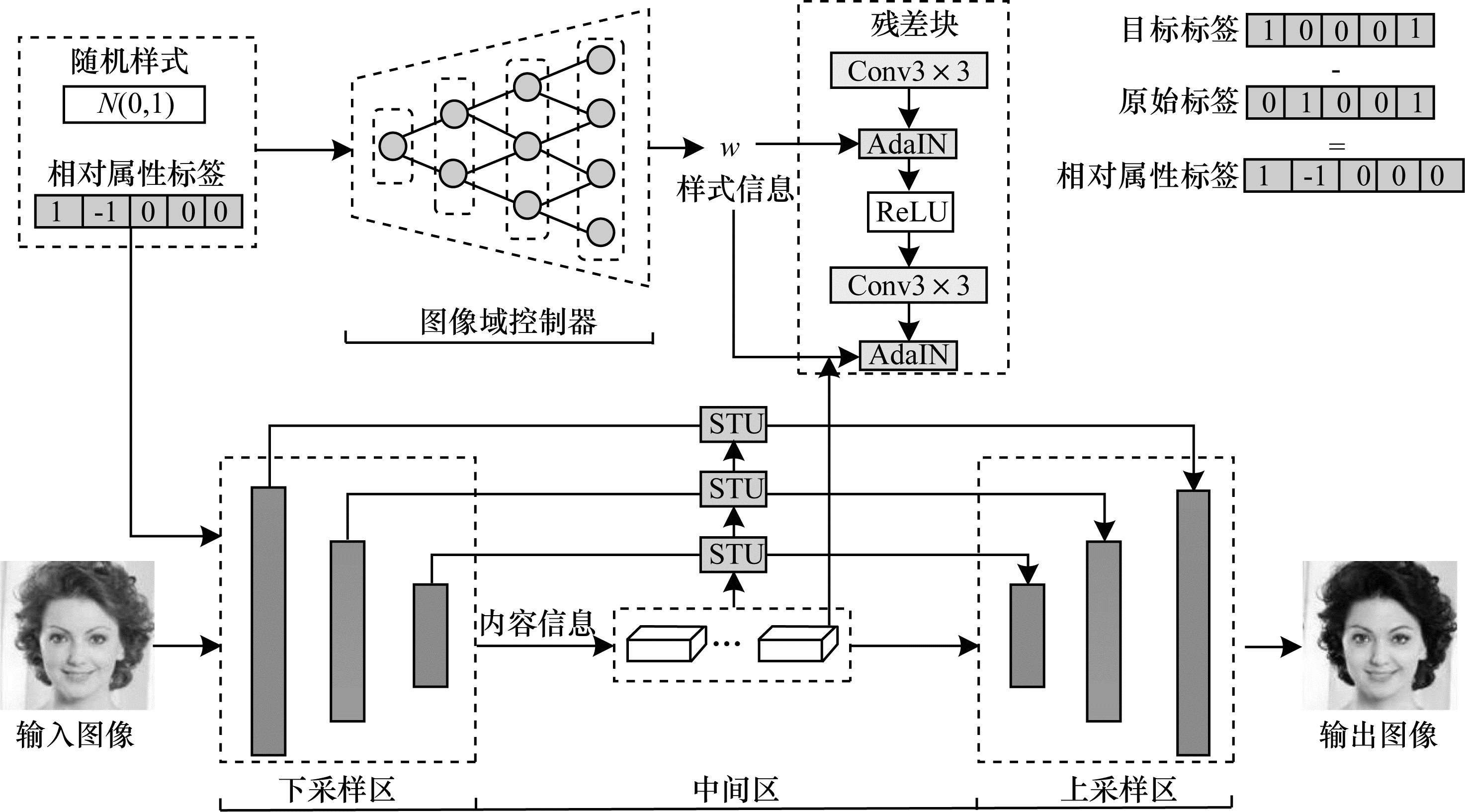

1.2 生成器模型本文生成器的整体结构由图像域控制器、上采样、中间区域、下采样和选择性传输单元5个部分组成。由MLP构成的图像域控制器将目标图像的相对属性标签和高斯分布的噪声数据迁移为图像域样式信息;由卷积神经网络组成的下采样区域提取图像的内容特征信息;由自适应实例归一化(AdaIN)残差网络块结构组成的下采样区域,融合提取的内容信息和图像域控制器生成的样式信息;STU将在下采样区域中的图像内容特征信息传输到上采样区域中;反卷积神经网络组成的上采样区域将融合的特征迁移成图像。具体结构如图 2所示。

|

Download:

|

| 图 2 融合域控制器和选择性传输单元的生成器结构 Fig. 2 Structure of generator with domain controller and selective transfer units | |

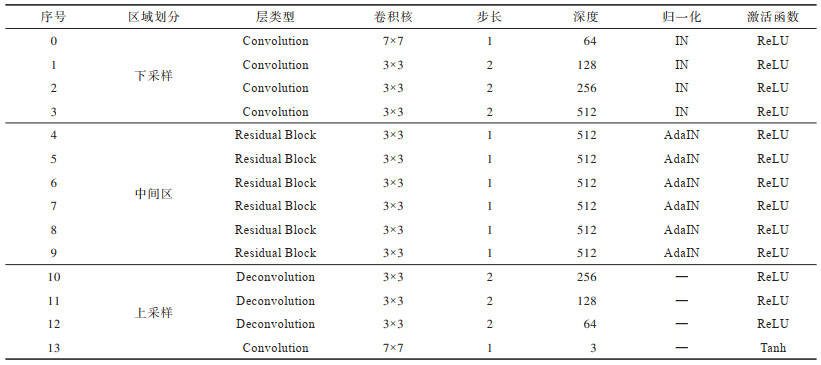

在生成器的参数设置上,除上采样输出层使用Tanh作为非线性激活函数以外,其他区域的卷积神经网络均选择ReLU作为激活函数。图像归一化处理时在下采样区域卷积层采用IN,在中间区域的残差网络块采用AdaIN,其他参数设置如表 1所示。

|

下载CSV 表 1 生成器的参数设置 Table 1 Parameter settings of generator |

采用离散形式的目标标签作为输入,一方面导致无法建立明确的迁移图像域和源图像域映射关系,另一方面造成生成图像的图像域表达形式单一。本文利用相对属性标签代替目标标签,将相对属性标签与随机的噪声数据拼接作为图像域控制器的输入。图像域控制器根据不同的随机噪声生成图 2中的目标图像域样式信息

图像域控制器结构由4层感知机网络组成,将c维随机高斯噪声数据和n维相对属性标签数据拼接后作为输入,n代表训练的属性个数,输出维度设定为残差网络深度的2倍,m代表AdaIN层数,整体结构参数设置如表 2所示。

|

下载CSV 表 2 图像域控制器的参数设置 Table 2 Parameter settings of image domain controller |

为更好地融合图像域控制器生成的样式信息和迁移图像的内容信息,本文在生成器中采用多个自适应实例归一化(AdaIN)残差网络块组成中间区,将图像域控制器的输出作为残差网络块的输入样式信息,并利用AdaIN融合图像内容特征信息和样式特征信息,以保留原图像内容信息的同时增加样式的多样性。

AdaIN[19]是基于IN的改进,将图像内容信息与样式信息的均值和标准差对齐,从而更好地融合不同的图像域信息。x表示图像内容信息,y表示样式信息,AdaIN的计算如式(1)~式(3)所示:

| $ {\mu }_{\mathrm{n}\mathrm{c}}\left(\boldsymbol{x}\right)=\frac{1}{H\times W}\sum \limits_{h=1}^{H}\sum \limits_{w=1}^{W}{\boldsymbol{x}}_{\mathrm{n}\mathrm{c}\mathrm{h}\mathrm{w}} $ | (1) |

| $ {\sigma }_{\mathrm{n}\mathrm{c}}\left(\boldsymbol{x}\right)=\sqrt{\frac{1}{H\times W}{\sum \limits_{h=1}^{H}\sum \limits_{w=1}^{W}\left({\boldsymbol{x}}_{\mathrm{n}\mathrm{c}\mathrm{h}\mathrm{w}}-{\mu }_{\mathrm{n}\mathrm{c}}\left(\boldsymbol{x}\right)\right)}^{2}+\boldsymbol{\varepsilon }} $ | (2) |

| $ \mathrm{A}\mathrm{d}\mathrm{a}\mathrm{I}\mathrm{N}\left(\boldsymbol{x}, \boldsymbol{y}\right)={\sigma }_{\mathrm{n}\mathrm{c}}\left(\boldsymbol{y}\right)\left(\frac{\boldsymbol{x}-{\mu }_{\mathrm{n}\mathrm{c}}\left(\boldsymbol{x}\right)}{{\sigma }_{\mathrm{n}\mathrm{c}}\left(\boldsymbol{x}\right)}\right)+{\mu }_{\mathrm{n}\mathrm{c}}\left(\boldsymbol{y}\right) $ | (3) |

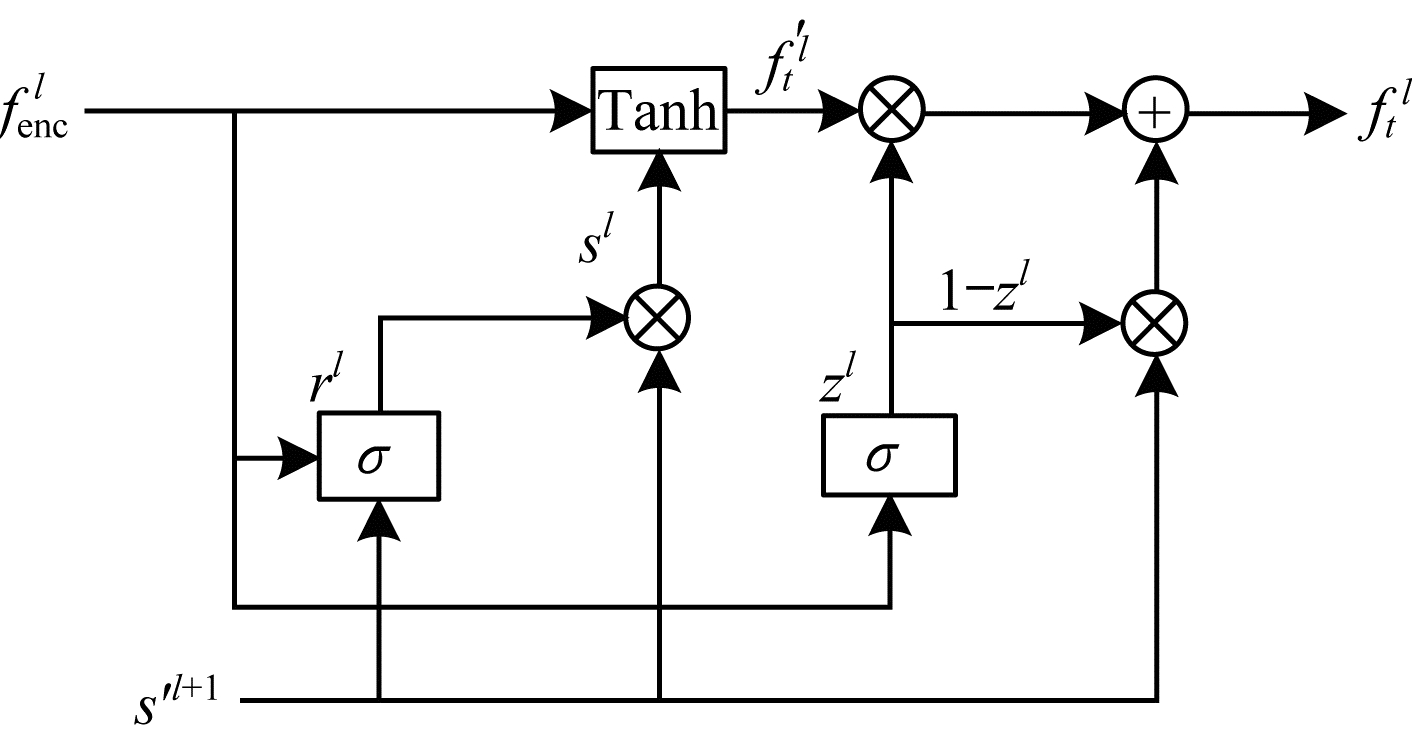

下采样的卷积操作仅通过跳跃连接将下采样提取的特征传输到上采样,难以有效地增加迁移图像域的细节特征信息。针对此问题,本文引入STU[15]将下采样提取的特征根据输入的相对属性标签选择性地传输到上采样,以形成融合特征,从而增加迁移图像域的细节信息,减少无关图像域的变化。STU是在GRU[17]基础上进行改进,结构如图 3所示。

|

Download:

|

| 图 3 选择性传输单元结构 Fig. 3 Structure of selective transfer units | |

从图 3可以看出,

| $ {\boldsymbol{s}\text{'}}^{l+1}={\boldsymbol{W}}_{t}\times \mathrm{T}\mathrm{c}\mathrm{o}\mathrm{n}\mathrm{v}\left(\left[{\boldsymbol{s}}^{l+1}, {l}_{\mathrm{r}\mathrm{e}\mathrm{l}\mathrm{a}\mathrm{t}\mathrm{i}\mathrm{v}\mathrm{e}}\right]\right) $ | (4) |

| $ {\boldsymbol{r}}^{l}=\sigma \left({\boldsymbol{W}}_{r}\times \mathrm{T}\mathrm{c}\mathrm{o}\mathrm{n}\mathrm{v}\left(\left[{\boldsymbol{f}}_{\mathrm{e}\mathrm{n}\mathrm{c}}^{l}, {\boldsymbol{s}\text{'}}^{l+1}\right]\right)\right) $ | (5) |

| $ {\boldsymbol{z}}^{l}=\sigma \left({\boldsymbol{W}}_{z}\times \mathrm{T}\mathrm{c}\mathrm{o}\mathrm{n}\mathrm{v}\left(\left[{\boldsymbol{f}}_{\mathrm{e}\mathrm{n}\mathrm{c}}^{l}, {\boldsymbol{s}\text{'}}^{l+1}\right]\right)\right) $ | (6) |

| $ {\boldsymbol{s}}^{l}={\boldsymbol{r}}^{l}\odot {\boldsymbol{s}\text{'}}^{l+1} $ | (7) |

| $ \boldsymbol{f}{\boldsymbol{\text{'}}}_{t}^{l}=\mathrm{t}\mathrm{a}\mathrm{n}\mathrm{h}\left({\boldsymbol{W}}_{h}\times \mathrm{C}\mathrm{o}\mathrm{n}\mathrm{v}\left(\left[{\boldsymbol{f}}_{\mathrm{e}\mathrm{n}\mathrm{c}}^{l}, {\boldsymbol{s}}^{l}\right]\right)\right) $ | (8) |

| $ {\boldsymbol{f}}_{t}^{l}=\left(1-{\boldsymbol{z}}^{l}\right)\odot {\boldsymbol{s}\text{'}}^{l+1}\mathrm{♁}{\boldsymbol{z}}^{l}\odot \boldsymbol{f}{\boldsymbol{\text{'}}}_{t}^{l} $ | (9) |

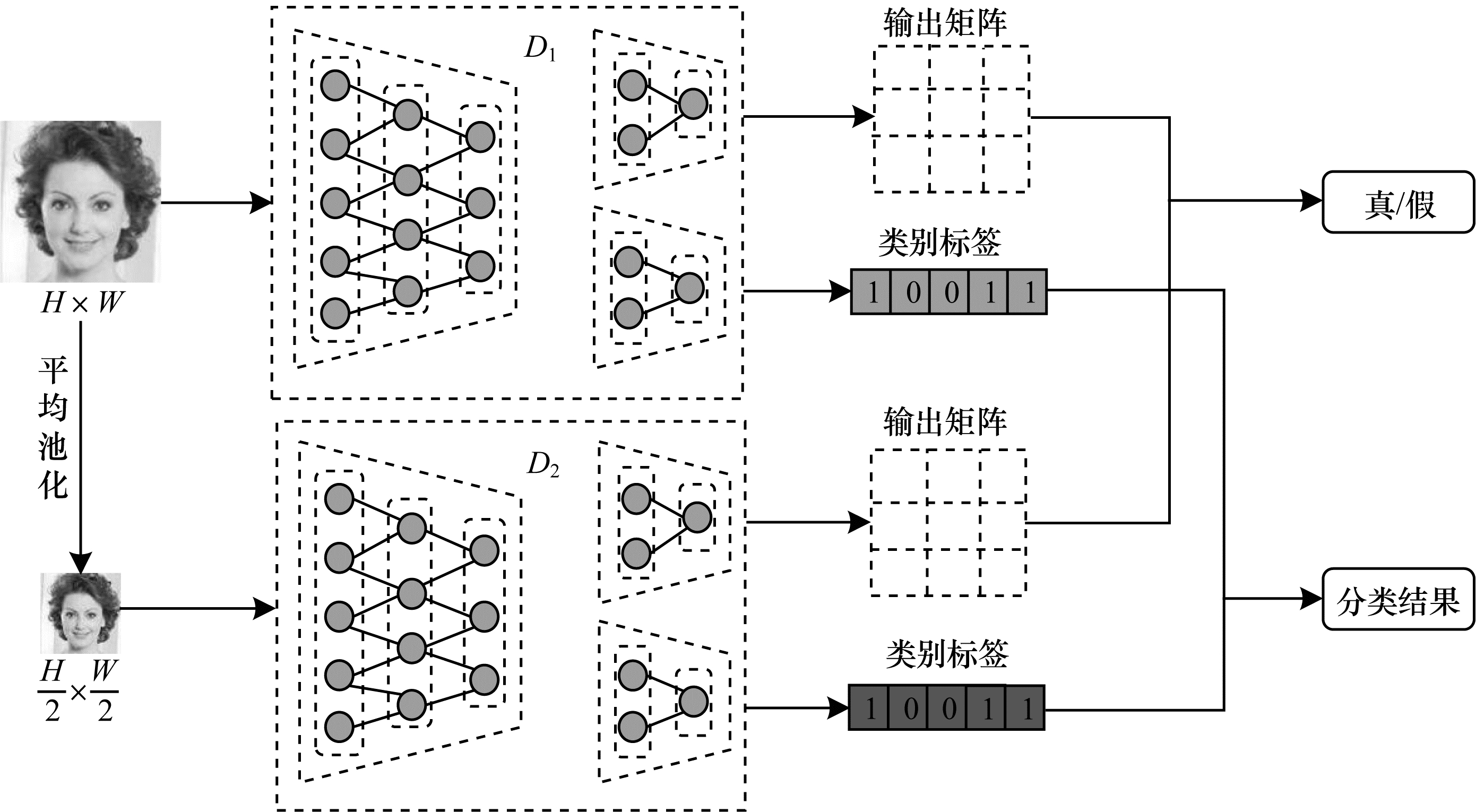

为建立明确的相对属性标签和迁移图像域之间的映射关系,本文在对输入图像真伪鉴别的基础上增加类别的判定,通过类别的分类损失引导生成器明确标签中每个位置上的数值信息与迁移目标图像域的对应关系,从而根据相对属性标签生成迁移的目标图像域。

在判别器结构设计中,判别器

| $ \begin{array}{l}{L}_{{D}_{\mathrm{s}\mathrm{r}\mathrm{c}}}={\lambda }_{1}{L}_{{D}_{\mathrm{s}\mathrm{r}\mathrm{c}}}^{1}+{\lambda }_{2}{L}_{{D}_{\mathrm{s}\mathrm{r}\mathrm{c}}}^{2}\\ {L}_{{D}_{\mathrm{c}\mathrm{l}\mathrm{s}}}={\lambda }_{1}{L}_{{D}_{\mathrm{c}\mathrm{l}\mathrm{s}}}^{1}+{\lambda }_{2}{L}_{{D}_{\mathrm{c}\mathrm{l}\mathrm{s}}}^{2}\end{array} $ | (10) |

其中:

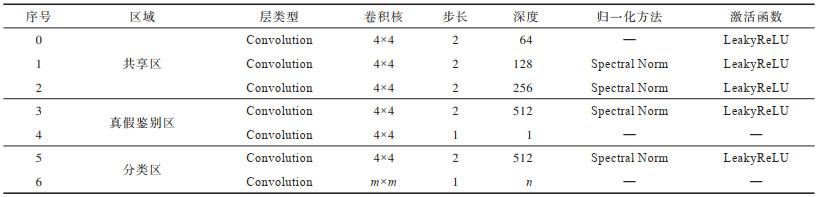

式(10)是通过协同鉴定图像真伪和类别,解决单一判别器判定准确度低的问题,双尺度判别器结构如图 4所示。判别器网络由真伪鉴定结构和图像域分类结构组成,共享0~2层网络,在真假鉴别区采用PatchGAN[3]输出真伪信息,分类区输出分类信息,具体参数设置如表 3所示。

|

Download:

|

| 图 4 双尺度判别器结构 Fig. 4 Structure of dual-scale discriminator | |

|

下载CSV 表 3 具有多分类结构的判别器参数设置 Table 3 Parameter settings of discriminator with multi-classification structure |

从表 3可以看出,除输入层和输出层以外,判别器模型均采用谱归一化(Spectral Normalization,SN)提高模型整体训练的稳定性。m为当前特征通道尺寸,如本文的输入图像尺寸为128,共享区网络有3层,则m设置为8,n为输入图像的类别标签长度,如本文训练5种属性,则n设置为5。

本文选择在不同权重比例超参数

本文所提的人脸属性迁移模型是基于STU和铰链对抗损失,通过循环一致性约束确保输入图像和迁移图像内容特征的一致性,利用分类损失指导生成器建立属性标签与生成图像的关联;同时,将相对对抗损失与铰链损失相结合以关注整体样本间的差异,从而指导人脸属性的迁移,整体损失如式(11)所示:

| $ L={L}_{\mathrm{R}\mathrm{H}\mathrm{i}\mathrm{n}\mathrm{g}\mathrm{e}\mathrm{G}\mathrm{A}\mathrm{N}}+{\lambda }_{\mathrm{r}\mathrm{e}\mathrm{c}}{L}_{\mathrm{r}\mathrm{e}\mathrm{c}}+{\lambda }_{\mathrm{i}\mathrm{d}\mathrm{t}}{L}_{\mathrm{i}\mathrm{d}\mathrm{t}}+{\lambda }_{\mathrm{c}\mathrm{l}\mathrm{s}}{L}_{\mathrm{c}\mathrm{l}\mathrm{s}} $ | (11) |

其中:

GAN的对抗损失是为了寻找在零和博弈状态下的纳什均衡解,在图像迁移任务中,即生成与原始真实图像分布相同的图像。文献[2]提出的原始GAN中损失函数如式(12)所示:

| $ \begin{array}{l}\mathrm{m}\mathrm{i}\mathrm{n}\;{L}_{\mathrm{G}\mathrm{A}\mathrm{N}}\left({D}_{X}\right)=-\left({E}_{\boldsymbol{x}\sim {P}_{\mathrm{d}\mathrm{a}\mathrm{t}\mathrm{a}}\left(\boldsymbol{x}\right)}\left[\mathrm{l}\mathrm{n}{D}_{X}\left(\boldsymbol{x}\right)\right]+\\ \;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;{E}_{Z\sim {P}_{\mathrm{d}\mathrm{a}\mathrm{t}\mathrm{a}}\left(\boldsymbol{z}\right)}\left[\mathrm{l}\mathrm{n}\left({\bf{1}}-{D}_{X}\left(G\left(\boldsymbol{z}\right)\right)\right)\right]\right)\\ \mathrm{m}\mathrm{i}\mathrm{n}\;{L}_{\mathrm{G}\mathrm{A}\mathrm{N}}\left(G\right)={E}_{\boldsymbol{x}\sim {P}_{\mathrm{d}\mathrm{a}\mathrm{t}\mathrm{a}}\left(\boldsymbol{x}\right)}\left[\mathrm{l}\mathrm{n}{D}_{X}\left(\boldsymbol{x}\right)\right]+\\ \;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;{E}_{Z\sim {P}_{\mathrm{d}\mathrm{a}\mathrm{t}\mathrm{a}}\left(\boldsymbol{z}\right)}\left[\mathrm{l}\mathrm{n}\left({\bf{1}}-{D}_{X}\left(G\left(\boldsymbol{z}\right)\right)\right)\right]\end{array} $ | (12) |

其中:

针对原始生成对抗损失未能充分利用输入数据一半是真一半是假的先验知识,本文引入相对鉴别[20]的思想,采用相对真假代替绝对真假,增大生成数据为真的概率的同时减小真实数据为真的概率。在人脸属性迁移任务中,本文通过训练真伪图像之间的间隔边界以提高生成图像的真实性。因此,本文在真假二分类过程中利用铰链损失寻找不同分布间的最大间隔,以严格决策真伪图像间的最大间隔边界[21],进而关注所有样本间的差异性,从而提升判别器真伪鉴别的能力与生成图像的真实性和质量。最终,本文将相对鉴别与铰链损失相结合,得到判别器和生成器的对抗损失如式(13)所示:

| $ \begin{array}{l}{L}_{\mathrm{R}\mathrm{H}\mathrm{i}\mathrm{n}\mathrm{g}\mathrm{e}\mathrm{G}\mathrm{A}\mathrm{N}}^{D}=\\ {E}_{\boldsymbol{x}\sim {P}_{\mathrm{d}\mathrm{a}\mathrm{t}\mathrm{a}}}\left[\begin{array}{l}\mathrm{m}\mathrm{a}\mathrm{x}\left(\mathrm{0, 1}-{D}_{\mathrm{s}\mathrm{r}\mathrm{c}}\left(\boldsymbol{x}\right)+{D}_{\mathrm{s}\mathrm{r}\mathrm{c}}\left(G\left(\boldsymbol{x}, {l}_{\mathrm{r}\mathrm{e}\mathrm{l}\mathrm{a}\mathrm{t}\mathrm{i}\mathrm{v}\mathrm{e}}\right)\right)\right)\\ +\mathrm{m}\mathrm{a}\mathrm{x}\left(\mathrm{0, 1}+{D}_{\mathrm{s}\mathrm{r}\mathrm{c}}\left(G\left(\boldsymbol{x}, {l}_{\mathrm{r}\mathrm{e}\mathrm{l}\mathrm{a}\mathrm{t}\mathrm{i}\mathrm{v}\mathrm{e}}\right)\right)-{D}_{\mathrm{s}\mathrm{r}\mathrm{c}}\left(\boldsymbol{x}\right)\right)\end{array}\right]\\ {L}_{\mathrm{R}\mathrm{H}\mathrm{i}\mathrm{n}\mathrm{g}\mathrm{e}\mathrm{G}\mathrm{A}\mathrm{N}}^{G}=\\ {E}_{\boldsymbol{x}\sim {P}_{\mathrm{d}\mathrm{a}\mathrm{t}\mathrm{a}}}\left[\begin{array}{l}\mathrm{m}\mathrm{a}\mathrm{x}\left(\mathrm{0, 1}-{D}_{\mathrm{s}\mathrm{r}\mathrm{c}}\left(G\left(\boldsymbol{x}, {l}_{\mathrm{r}\mathrm{e}\mathrm{l}\mathrm{a}\mathrm{t}\mathrm{i}\mathrm{v}\mathrm{e}}\right)\right)+{D}_{\mathrm{s}\mathrm{r}\mathrm{c}}\left(\boldsymbol{x}\right)\right)\\ +\mathrm{m}\mathrm{a}\mathrm{x}\left(\mathrm{0, 1}+{D}_{\mathrm{s}\mathrm{r}\mathrm{c}}\left(\boldsymbol{x}\right)-{D}_{\mathrm{s}\mathrm{r}\mathrm{c}}\left(G\left(\boldsymbol{x}, {l}_{\mathrm{r}\mathrm{e}\mathrm{l}\mathrm{a}\mathrm{t}\mathrm{i}\mathrm{v}\mathrm{e}}\right)\right)\right)\end{array}\right]\end{array} $ | (13) |

其中:

本文的重构损失由循环重构和自我重构组成,通过增加自我重构以保证人脸属性迁移图像内容的一致性。

2.2.1 循环重构在人脸属性迁移任务中,循环重构不仅保留原始图像的结构和内容等信息,同时还迁移指定的图像域,仅利用对抗损失无法保证生成图像与原图像结构和内容信息的一致性。为更好地建立相对属性标签和迁移图像间的映射关系,本文引入循环一致性条件约束,通过相对属性标签引导人脸属性迁移。首先原始图像

| $ {L}_{\mathrm{r}\mathrm{e}\mathrm{c}}={E}_{a\sim {P}_{\mathrm{d}\mathrm{a}\mathrm{t}\mathrm{a}}}{‖\boldsymbol{a}-G\left(G\left(\boldsymbol{a}, {l}_{\mathrm{r}\mathrm{e}\mathrm{l}\mathrm{a}\mathrm{t}\mathrm{i}\mathrm{v}\mathrm{e}}\right), -{l}_{\mathrm{r}\mathrm{e}\mathrm{l}\mathrm{a}\mathrm{t}\mathrm{i}\mathrm{v}\mathrm{e}}\right)‖}_{1} $ | (14) |

为避免无关图像域在迁移过程中发生改变,本文引入自我重构一致性约束以降低无关图像域的变化。在自我重构过程中,对于任意的真实图像

| $ {L}_{\mathrm{i}\mathrm{d}\mathrm{t}}={E}_{\boldsymbol{a}\sim {P}_{\mathrm{d}\mathrm{a}\mathrm{t}\mathrm{a}}}{‖\boldsymbol{a}-G\left(\boldsymbol{a}, 0\right)‖}_{1} $ | (15) |

其中:0为无差异属性标签。

2.3 分类损失为保持原图像域和迁移图像域的一致性,本文设计分类损失以平衡输入标签与判别器输出类别之间的差异。本文通过相对属性标签指导图像迁移,以判定生成图像中每个迁移图像域特征的类别,从而加强相对属性标签和生成图像之间的联系,并完成目标图像域的迁移。为区分不同的目标图像域,本文采用多分类任务的交叉熵作为分类损失函数。判别器和生成器的分类损失如式(16)所示:

| $ \begin{array}{l}{L}_{\mathrm{c}\mathrm{l}\mathrm{s}}^{D}={E}_{\boldsymbol{x}, {l}_{\mathrm{o}\mathrm{r}\mathrm{g}}}\left[-\mathrm{l}\mathrm{n}{D}_{\mathrm{c}\mathrm{l}\mathrm{s}}\left({l}_{\mathrm{o}\mathrm{r}\mathrm{g}}|\boldsymbol{x}\right)\right]\\ {L}_{\mathrm{c}\mathrm{l}\mathrm{s}}^{G}={E}_{\boldsymbol{x}, {l}_{\mathrm{s}\mathrm{r}\mathrm{c}}}\left[-\mathrm{l}\mathrm{n}{D}_{\mathrm{c}\mathrm{l}\mathrm{s}}\left({l}_{\mathrm{s}\mathrm{r}\mathrm{c}}|\boldsymbol{G}\left(x, {l}_{\mathrm{s}\mathrm{r}\mathrm{c}}\right)\right)\right]\end{array} $ | (16) |

其中:

本文采用的数据集CelebA[22]由202 599张人脸图片组成,总共10 177个名人,每张图片有40个二分属性标签。本文将数据集中原始大小为178×218的图像裁剪成178×178,并重新调整大小为128×128,随机选择其中1 999张作为测试数据集,其余200 600张作为训练数据集。

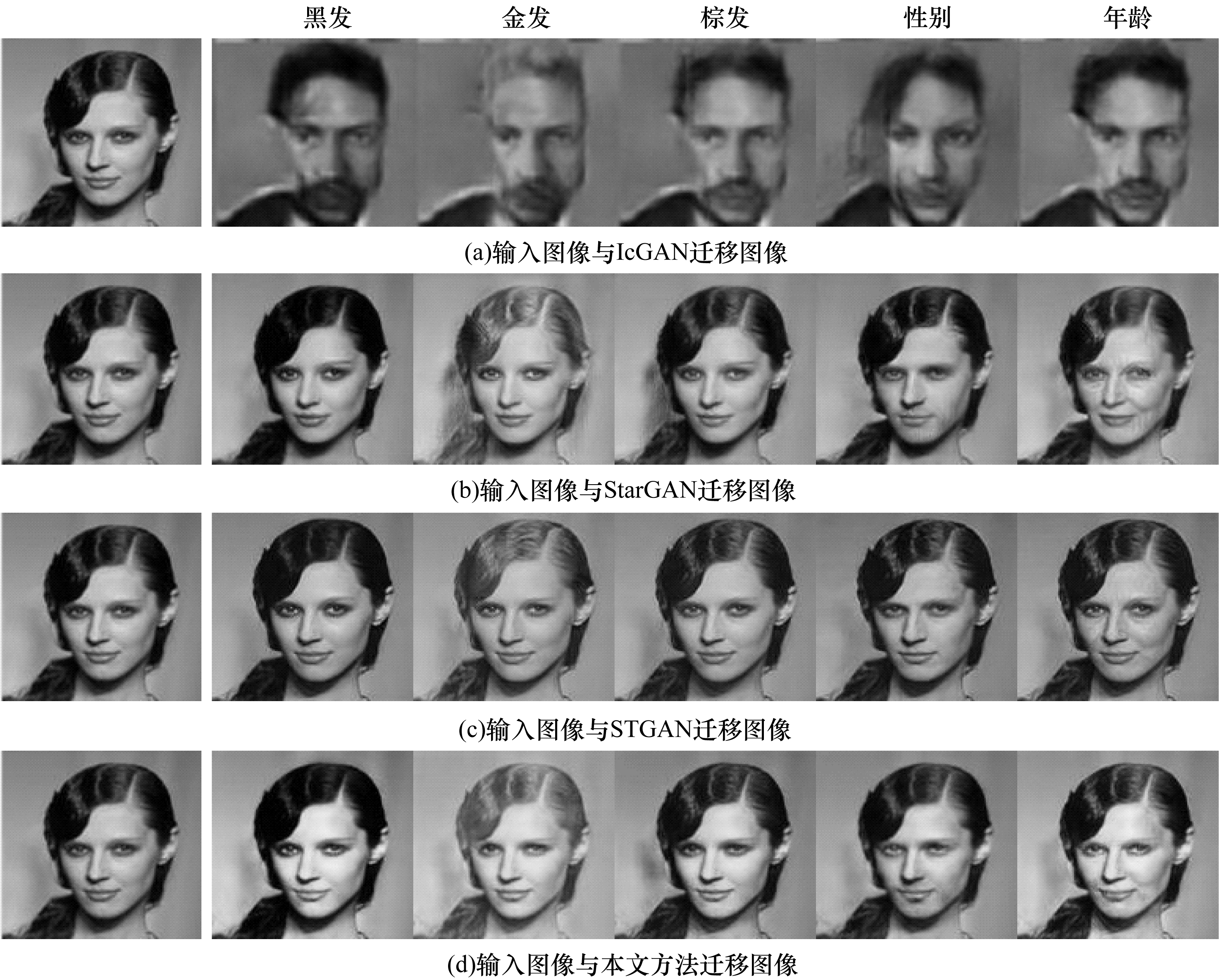

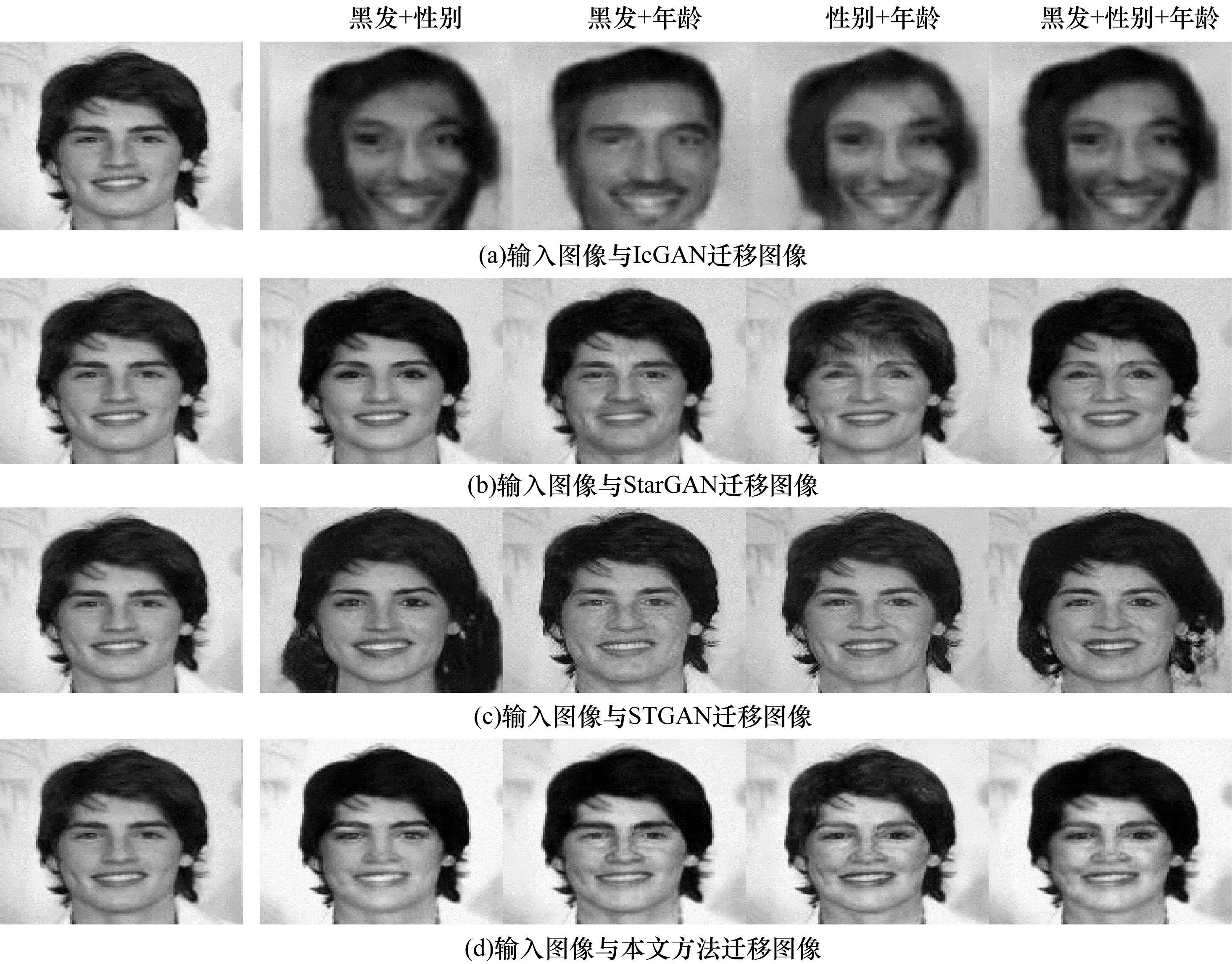

在数据集上,本文通过选取发色(黑发、金发、棕发)、性别和年龄这5种属性进行人脸属性迁移实验,并分别与采用标签训练的IcGAN、StarGAN和STGAN进行对比。本文选取发色(黑发、金发、棕发)、刘海和眼镜这5种属性完成多样性效果实验。

3.1 实验环境与训练参数设置本文实验CPU为40 Intel® Xeon® Silver 4210 CPU@2.20 GHz,31 GB;GPU为NVIDIA GeForce RTX 2080 Ti,11 GB;操作系统为Ubuntu 18.04 LTS;开发环境为PyTorch 1.7.0,python 3.6.12,CUDA 10.0.130

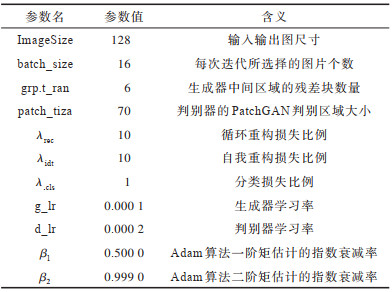

在模型参数设置上,训练集的迭代批次batch_size设置为16,生成器中间区域残差块个数设置为6;采用TTUR[23]策略提高判别器的收敛速度,生成器和判别器的学习率分别设置为0.000 1和0.000 2;在权重选择上,循环重构超参数

|

下载CSV 表 4 训练参数设置 Table 4 Training parameter settings |

本文采用分类准确率(CCA)、FID(Frechet Inception Distance)和用户调研评价(UUS)作为人脸属性迁移效果的评价指标。

1)分类准确率CCA能有效反映迁移图像域的准确性。本文利用图像分类模型对真实图像进行训练,将其得到的分类准确率作为基准值,然后根据训练好的模型对生成图像进行分类,将得到的分类准确率与基准值进行对比。准确率越高,越容易区分迁移图像的图像域,生成图像的效果越好。本文的分类模型选择Xception[24]网络,分类准确率如式(17)所示:

| $ {C}_{\mathrm{C}\mathrm{A}}=\frac{\mathrm{分}\mathrm{类}\mathrm{正}\mathrm{确}\mathrm{样}\mathrm{本}\mathrm{数}}{\mathrm{总}\mathrm{样}\mathrm{本}\mathrm{数}} $ | (17) |

2)FID能有效评估GAN生成图像质量的指标,用于度量2个图像数据集之间的相似性。本文通过将原始图像数据集和GAN生成的图像数据集拟合到Inception[25]网络,由网络对所得到的两个高斯分布之间的弗雷谢距离进行计算。FID数值越低,代表生成图像的真实性越高,迁移图像的效果越好。定义

| $ \begin{array}{l}{d}^{2}\left(({\mu }_{1}, {\sigma }_{1}), \left({\mu }_{2}, {\sigma }_{2}\right)\right)=\\ {‖{\mu }_{1}-{\mu }_{2}‖}_{2}^{2}+\mathrm{T}\mathrm{r}\left({\mu }_{1}+{\mu }_{2}+2{\left({\sigma }_{1}{\sigma }_{2}\right)}^{\frac{1}{2}}\right)\end{array} $ | (18) |

3)用户调研评价UUS能有效反映人眼对迁移图像质量的评估,是属性迁移常用的主观评价方法。从测试集随机选择M张图像输入到不同的模型,根据相同输入图像的输出图像分成M组。被评选为最佳效果图的次数越多,代表该模型的视觉效果越好,图像迁移质量越高。UUS如式(19)所示:

| $ {U}_{\mathrm{U}\mathrm{S}}=\frac{n}{N\times M} $ | (19) |

其中:n为被评为最佳效果图的次数

3.3 自适应实例归一化和选择性传输效果评估为验证自适应实例归一化和选择性传输单元对迁移效果的影响,本文在CelebA数据集上进行图像迁移实验。

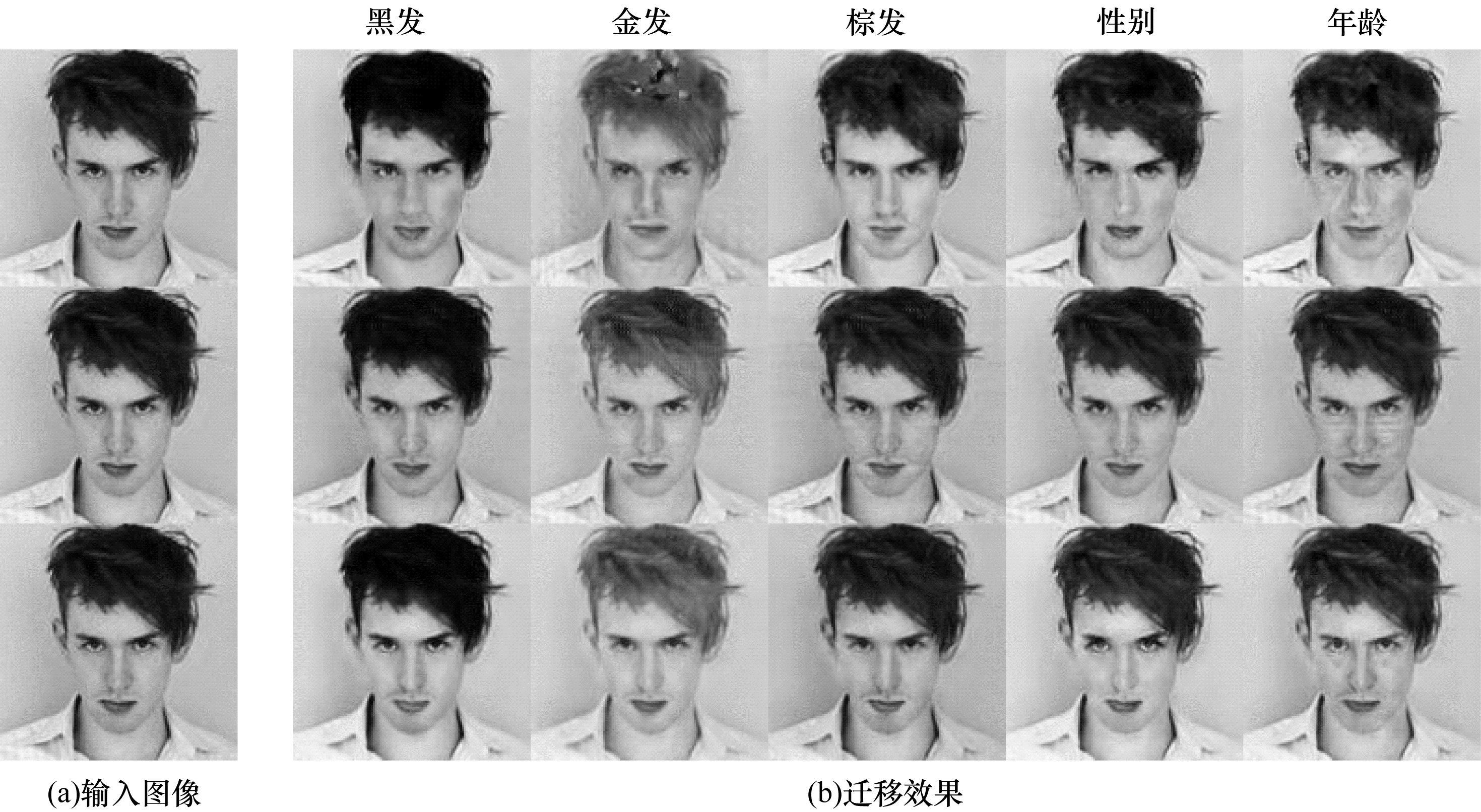

3.3.1 铰链对抗损失和选择性传输单元效果评估本文实验进行了160 000 ~200 000次迭代,当迭代次数达到200 000次时,模型处于完全收敛状态,故选择200 000次作为模型最终的迭代训练次数。

为达到最优的迁移效果,本文选择双尺度判别并选取原始图像H×W和平均池化后的图像H/2×W/2作为判别器的输入。单尺度判别因缺少细节特征的判定,导致整体迁移图像略显失真。然而多尺度判别过于强调背景的细节特征,导致整体迁移图像的背景等无关图像域变化较为明显,双尺度判别能协同鉴定输入图像的真伪及类别,以提升图像细节特征的判定准确度,提高迁移图像的质量。

为验证铰链对抗损失和选择性传输单元融合的有效性,在相同实验环境下,不同条件的实验对比结果如图 5所示。

|

Download:

|

| 图 5 不同条件下的实验结果对比 Fig. 5 Comparison of experimental results with different conditions | |

从图 5可以看出,第1行采用铰链对抗损失和基本图像生成结构的迁移效果,第2行采用原始对抗损失和选择性传输单元的迁移效果,第3行融合铰链对抗损失和选择性传输单元的迁移效果。从第1行和第3行可以看出,通过增加选择性传输单元后,在图像域特征细节上的迁移效果更加明显,如第3列转换金发属性时,融合铰链对抗损失和选择性传输单元的图像迁移效果中金发部分失真明显减少。当第5列转变为女性时,融合铰链对抗损失和选择性传输单元的背景颜色更接近输入图像;第6列在年龄增大后面部轮廓特征更加明显。从第2行和第3行可以看出,增加铰链对抗后的图像迁移效果能够有效减少无关图像域的转变,如在第2列迁移黑发属性图像域中,人物的肤色更接近输入图像的肤色;第5列转变为女性时,嘴唇的口红颜色更鲜艳以及面部轮廓也更加明显。第1行和第3行的图像迁移结果表明选择性传输单元能改进图像的细节特征;第2行和第3行的图像表明铰链对抗损失减少了无关图像域的迁移。

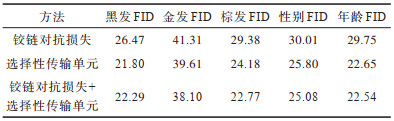

本文在不同条件下计算生成图像FID的数值,如表 5所示,加粗表示最优数据。从表 5可以看出,与铰链对抗损失相比,采用铰链对抗损失+选择性传输单元得到迁移图像域的FID平均降低了0.652,即迁移的图像域更接近真实图像;与选择性传输单元相比,采用铰链对抗损失+选择性传输单元得到迁移图像域的FID平均降低了5.228。

|

下载CSV 表 5 在不同条件下FID对比 Table 5 FID comparison under different conditions |

实验结果表明,铰链对抗损失可以充分利用输入数据一半是真一半是假的先验知识,从而提高迁移图像的真实性;选择性传输单元可以解决下采样的卷积操作存在图像细节信息缺失的问题。融合铰链对抗损失和选择性传输单元可以有效提高本文整体模型迁移图像的质量。

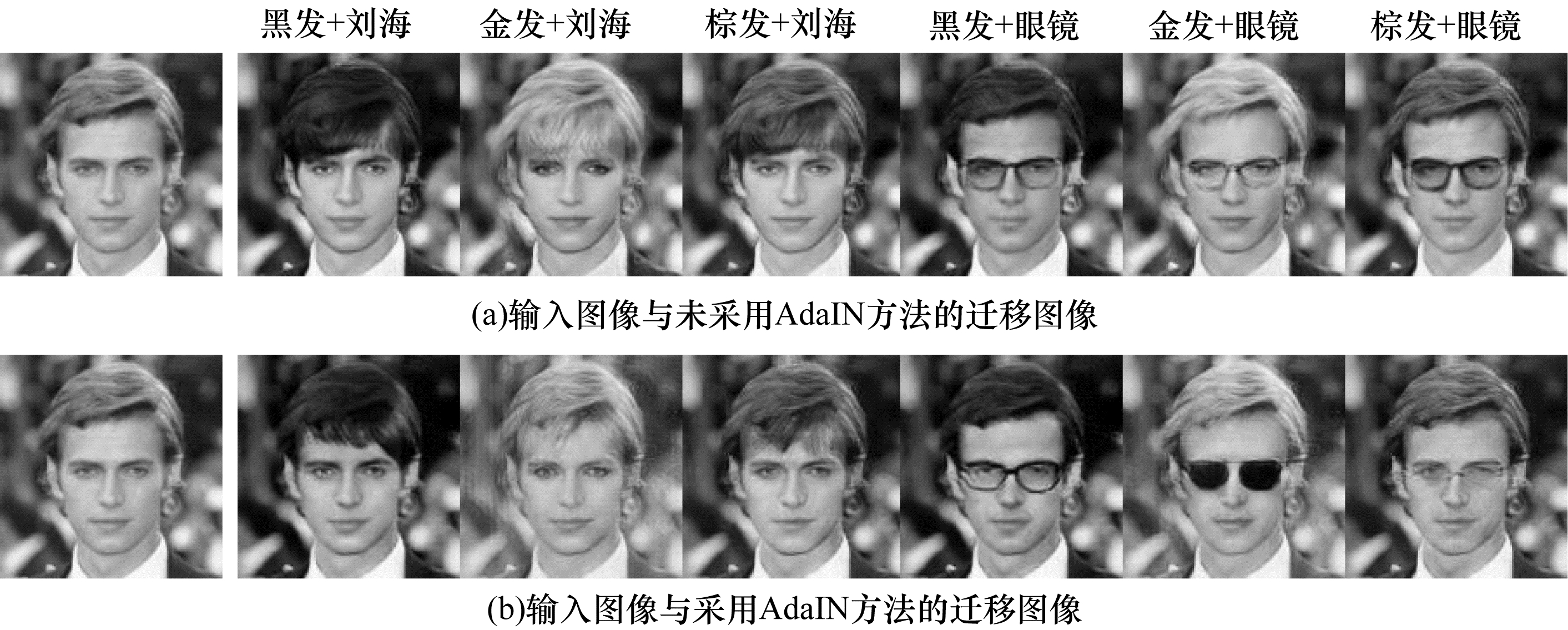

3.3.2 自适应实例归一化效果评估为评估融合域控制器和AdaIN残差网络增加迁移图像域表达方式的多样性效果,本文选取发色(黑发、金发、棕发)、眼镜和刘海属性作为训练的属性标签进行实验。在输入图像和相对属性标签不变的条件下,根据不同的随机噪声数据,输出迁移图像,从多组图像中选取具有代表性的输出图像。未采用AdaIN和采用AdaIN的实验结果对比如图 6所示。

|

Download:

|

| 图 6 本文方法未采用AdaIN和采用AdaIN的实验结果对比 Fig. 6 Experimental results comparison of the proposed method with AdaIN and without AdaIN | |

从图 6(a)可以看出,未采用AdaIN的图像迁移效果除发色变化之外,刘海比较稠密且向左下斜,镜片是颜色略深的方形,样式单一。从图 6(b)可以看出,采用融合域控制器与AdaIN后,刘海弯曲形状的斜右下样式、略微稀疏的左下斜样式,镜片轮廓上有方形的和椭圆形的,且颜色上是黑色的、白色的,均呈现多种不同的样式。

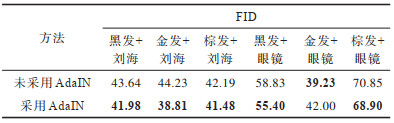

为进一步验证刘海和眼镜迁移图像多样性的质量,本文计算相对应的FID数值,如表 6所示。采用AdaIN能有效提升眼镜和刘海多种表达方式的真实性。实验结果验证融合域控制器与AdaIN的有效性,将不同的随机噪声输入到图像域控制器,能有效增加图像域样式的多样性。

|

下载CSV 表 6 本文方法未采用AdaIN和采用AdaIN的FID对比 Table 6 FID comparison of the proposed method with AdaIN and without AdaIN |

综合以上的对比实验可以得出:铰链对抗损失通过训练真伪图像的间隔边界,可以更好地提高生成图像的真实性;选择性传输单元能有效降低下采样的卷积操作对图像分辨率的影响,提高图像迁移的细节信息;融合图像域控制器与AdaIN可以实现图像域多样性的表达。

3.4 人脸属性迁移效果评估本文的图像域属性迁移模型经一次训练后,既可以完成单个属性的图像域迁移,也可以同时完成多个属性的图像域迁移。为验证本文方法在单个属性迁移和多个属性同时迁移的有效性,在相同的实验环境下,本文选取发色(黑发、金发、棕发)、性别和年龄这5种属性进行训练,与同样完成人脸属性迁移工作的IcGAN[9]、StarGAN[13]和STGAN[15]进行对比实验。

本文均复现原作者源代码进行对比:1)IcGAN,在CGAN基础上融合Z和Y编码器完成多图像域迁移工作,引入标签完成多图像域迁移任务;2)StarGAN,经过一次训练即可完成多图像域迁移任务,通过循环一致性约束和分类损失完成多图像域迁移任务;3)STGAN,经过一次训练即可完成多图像域迁移任务,在生成器的输入中加入差分属性和选择性传输单元完成图像迁移任务。

3.4.1 单属性迁移在经过一次训练完成的多图像域迁移模型中,本文分别改变输入图像单个目标图像域属性标签,以生成人脸属性迁移图像。本文选取具有代表性的生成图像进行单个属性迁移效果对比,如图 7所示。

|

Download:

|

| 图 7 不同方法的单个属性迁移效果对比 Fig. 7 Single attribute migration effects comparison among different methods | |

从图 7(a)可以看出,采用IcGAN方法将发色迁移成黑发时,出现了明显的胡子,发型也发生了转变,整体图像失真严重;从图 7(b)可以看出,采用StarGAN方法将发色迁移成金发时,斜向左的刘海发丝略微失真且不自然,迁移成男性时,唇部颜色略显苍白,面部肤色也略显暗淡。从图 7(c)和图 7(d)可以看出,采用STGAN和本文方法将发色迁移成黑发时,发色自然且发丝更加逼真;当增加图像中人物年龄时,迁移图像显示仅改变了脸上的皱纹。因此,IcGAN迁移效果中整体图像细节模糊且背景变化大,StarGAN迁移效果中部分细节不够真实,STGAN和本文方法都较好地完成了属性的迁移,整体图像显得自然、真实,无关图像域变化小。

为体现实验的公正性,本文选择10名研究生分别对5种属性的迁移效果图进行评选,迁移效果图由30组评价样本组成,每组评价样本由4张相同的测试输入图像及4种方法的迁移效果图构成,以得到

1)图像质量,轮廓边缘、头发和五官等细节清晰,整体真实的迁移图像质量最佳。

2)无关图像域变化,其他无关图像域变化少,且符合目标图像域特征的迁移图像质量最佳。

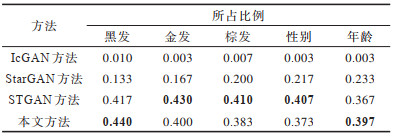

用户调研数据从300组用户问卷评估数据统计得到,每种方法在该对应属性迁移上所占的百分比如表 7所示,加粗表示最优数据。IcGAN整体迁移图像效果较差。在金发、棕发和性别迁移图像评选中,STGAN的迁移效果优于本文方法。在黑发和年龄迁移图像评选中,本文方法优于STGAN。因此,本文方法在迁移效果与生成图像质量方面相较于IcGAN和StarGAN均有提升,与STGAN效果相当。

|

下载CSV 表 7 单属性迁移的用户调研评价对比 Table 7 Comparison of user survey evaluation of single attribute migration |

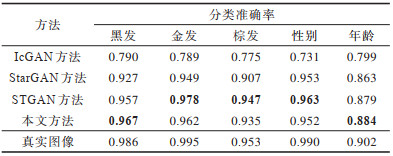

为有效地评估本文方法,本文对这4种方法输出图像的分类准确率进行对比,如表 8所示,加粗表示最优数据。本文方法比IcGAN、StarGAN的分类准确率平均提高16.3和2个百分点,与STGAN效果相当,均接近真实图像的分类准确率。

|

下载CSV 表 8 不同方法单属性迁移的分类准确率对比 Table 8 Classification accuracy comparison among different methods with single attribute migration |

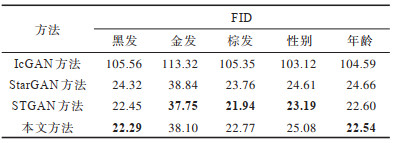

为评估这4种方法输出图像的真实性,本文计算不同方法输出图像FID的数值,对比结果如表 9所示。从表 9中可知,IcGAN迁移图像的真实性较低,本文方法的迁移效果要优于StarGAN和IcGAN,与STGAN效果相当。

|

下载CSV 表 9 不同方法单属性迁移的FID对比 Table 9 FID comparison among different methods with single attribute migration |

在经过一次训练完成的多图像域迁移模型中,本文分别改变输入图像2个或者3个目标图像域属性标签,以生成人脸属性迁移图像,选取具有代表性的输出图像进行对比,如图 8所示。

|

Download:

|

| 图 8 不同方法的多属性迁移效果对比 Fig. 8 Muti-attribute migration effects comparison among different methods | |

从图 8可以看出:IcGAN迁移的图像真实性低,无关图像域改变大;StarGAN、STGAN和本文方法都较好地完成多个属性同时迁移的任务,但StarGAN和STGAN仍然有一些无关图像域发生了改变,当性别和年龄同时转变时,StarGAN出现了较为明显的刘海;当黑发和性别同时转变时,STGAN迁移的发型显得不自然;本文方法整体迁移图像真实性更高,人脸肤色随着不同属性的迁移均发生相应的转变,随着年龄增大,目标图像域的特征更为明显;当性别和年龄同时迁移时,本文方法迁移图像中面部特征的细节清晰、自然,更接近真实图像。

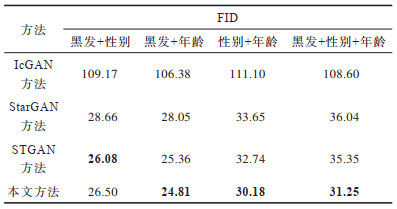

为进一步验证本文方法多属性迁移的有效性,本文计算多个属性同时迁移FID的数值,如表 10所示,加粗表示最优数据。从表中数据得知,在多个属性同时迁移的任务中,IcGAN生成的迁移图像真实性较差,STGAN生成的迁移图像要优于IcGAN和StarGAN,本文方法生成的迁移图像质量最优。

|

下载CSV 表 10 不同方法多属性迁移的FID对比 Table 10 FID comparison among different methods with multi-attributes migration |

在人脸属性迁移任务中单属性迁移与多属性迁移的主客观实验结果表明:相较于IcGAN、StarGAN,本文方法的单属性迁移图像效果能较好地保留人脸面部的细节特征信息,无关图像域改变较少,且迁移图像的真实性和质量与STGAN效果相当;相较于IcGAN、StarGAN和STGAN,本文方法的多属性迁移效果更优,能建立更加明确的多图像域映射关系。

4 结束语本文提出一种选择性传输和铰链对抗的多图像域人脸属性迁移方法。通过引入域控制器和自适应实例归一化,增加生成的人脸属性样式多样性,同时利用选择性传输单元提高迁移图像的细节和质量,设计并融合相对鉴别与铰链损失的铰链对抗损失,以减少无关图像域的迁移。实验结果表明,与StarGAN、STGAN、IcGAN方法相比,该方法迁移图像的质量更优,同时能有效增加迁移图像表达的多样性。下一步将对属性标签进行优化,以减少样式信息对属性标签的依赖,使本文模型适用于实际的应用场景。

| [1] |

XIAO T, HONG J, MA J. Elegant: exchanging latent encodings with GAN for transferring multiple face attributes[C]//Proceedings of the European Conference on Computer Vision. Berlin, Germany: Springer, 2018: 172-187.

|

| [2] |

GOODFELLOW I J, POUGET-ABADIE J, MIRZA M, et al. Generative adversarial networks[J]. Communications of the ACM, 2020, 63(11): 139-144. DOI:10.1145/3422622 |

| [3] |

ISOLA P, ZHU J Y, ZHOU T, et al. Image-to-image translation with conditional adversarial networks[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Washington D. C., USA: IEEE Press, 2017: 5967-5976.

|

| [4] |

曹仰杰, 贾丽丽, 陈永霞, 等. 生成式对抗网络及其计算机视觉应用研究综述[J]. 中国图象图形学报, 2018, 23(10): 1433-1449. CAO Y J, JIA L L, CHEN Y X, et al. Review of computer vision based on generative adversarial networks[J]. Journal of Image and Graphics, 2018, 23(10): 1433-1449. (in Chinese) |

| [5] |

HUANG H, YU P S, WANG C. An introduction to image synthesis with generative adversarial nets[EB/OL]. [2020-12-16]. https://arxiv.org/pdf/1803.04469.pdf.

|

| [6] |

UPCHURCH P, GARDNER J, PLEISS G, et al. Deep feature interpolation for image content changes[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Washington D. C., USA: IEEE Press, 2017: 6090-6099.

|

| [7] |

ZHU J Y, PARK T, ISOLA P, et al. Unpaired image-to-image translation using cycle-consistent adversarial networks[C]//Proceedings of IEEE International Conference on Computer Vision. Washington D. C., USA: IEEE Press, 2017: 2242-2251.

|

| [8] |

林泓, 任硕, 杨益, 等. 融合自注意力机制和相对鉴别的无监督图像翻译[J]. 自动化学报, 2021, 47(9): 2226-2237. LIN H, REN S, YANG Y, et al. Unsupervised image-to-image translation with self-attention and relativistic discriminator adversarial networks[J]. Acta Automatica Sinice, 2021, 47(9): 2226-2237. (in Chinese) |

| [9] |

PERARNAU G, VAN DE WEIJER J, RADUCANU B, et al. Invertible conditional gans for image editing[EB/OL]. [2021-01-16]. https://arxiv.org/pdf/1611.06355.pdf.

|

| [10] |

MIRZA M, OSINDERO S. Conditional generative adversarial nets[EB/OL]. [2021-12-16]. https://arxiv.org/pdf/1411.1784.pdf.

|

| [11] |

HUANG X, LIU M Y, BELONGIE S, et al. Multimodal unsupervised image-to-image translation[C]//Proceedings of European Conference on Computer Vision. Munich, Germany: Springer, 2018: 179-196.

|

| [12] |

LIU M Y, BREUEL T, KAUTZ J. Unsupervised image-to-image translation networks[C]//Proceedings of the 31st International Conference on Neural Information Processing Systems. New York, USA: ACM Press, 2017: 700-708.

|

| [13] |

CHOI Y, CHOI M, KIM M, et al. StarGAN: unified generative adversarial networks for multi-domain image-to-image translation[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Washington D. C., USA: IEEE Press, 2018: 8789-8797.

|

| [14] |

CHOI Y, UH Y, YOO J, et al. StarGAN v2: diverse image synthesis for multiple domains[C]//Proceedings of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Washington D. C., USA: IEEE Press, 2020: 8188-8197.

|

| [15] |

LIU M, DING Y, XIA M, et al. STGAN: a unified selective transfer network for arbitrary image attribute editing[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Washington D. C., USA: IEEE Press, 2019: 3668-3677.

|

| [16] |

HE Z, ZUO W, KAN M, et al. AttGAN: facial attribute editing by only changing what you want[J]. IEEE Transactions on Image Processing, 2019, 28(11): 5464-5478. DOI:10.1109/TIP.2019.2916751 |

| [17] |

CHUNG J, GULCEHRE C, CHO K H, et al. Empirical evaluation of gated recurrent neural networks on sequence modeling[EB/OL]. [2021-12-16]. https://arxiv.org/pdf/1412.3555.pdf.

|

| [18] |

WU P W, LIN Y J, CHANG C H, et al. Relgan: multi-domain image-to-image translation via relative attributes[C]//Proceedings of IEEE International Conference on Computer Vision. Washington D. C., USA: IEEE Press, 2019: 5914-5922.

|

| [19] |

HUANG X, BELONGIE S. Arbitrary style transfer in real-time with adaptive instance normalization[C]//Proceedings of IEEE International Conference on Computer Vision. Washington D. C., USA: IEEE Press, 2017: 1510-1519.

|

| [20] |

JOLICOEUR-MARTINEAU A. The relativistic discriminator: a key element missing from standard GAN[EB/OL]. [2020-12-16]. https://arxiv.org/pdf/1807.00734.pdf.

|

| [21] |

JOLICOEUR-MARTINEAU A, MITLIAGKAS I. Connections between support vector machines, wasserstein distance and gradient-penalty GANs[EB/OL]. [2020-12-16]. https://arxiv.org/pdf/1910.06922.pdf.

|

| [22] |

LIU Z, LUO P, WANG X, et al. Deep learning face attributes in the wild[C]//Proceedings of IEEE International Conference on Computer Vision. Washington D. C., USA: IEEE Press, 2015: 3730-3738.

|

| [23] |

HEUSEL M, RAMSAUER H, UNTERTHINER T, et al. GANs trained by a two time-scale update rule converge to a local nash equilibrium[EB/OL]. [2020-12-15]. https://arxiv.org/pdf/1706.08500.pdf.

|

| [24] |

CHOLLET F. Xception: deep learning with depthwise separable convolutions[C]//Proceedings of IEEE conference on computer vision and pattern recognition. Washington D. C., USA: IEEE Press, 2017: 1800-1807.

|

| [25] |

SZEGEDY C, VANHOUCKE V, IOFFE S, et al. Rethinking the inception architecture for computer vision[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Washington D. C., USA: IEEE Press, 2016: 2818-2826.

|

2022, Vol. 48

2022, Vol. 48