开放科学(资源服务)标志码(OSID):

同步定位与建图(Simultaneous Localization and Mapping,SLAM)由SMITH等[1]于1986年提出,通过机器人自身所搭载的多传感器获取环境信息,并估计自身位姿完成地图构建,是实现机器人在未知环境下自主定位与导航的关键。目前,单机器人SLAM技术已经具有一定的鲁棒性,且广泛应用于无人驾驶、机器人、无人机、增强现实(Augmented Reality,AR)等领域。但面对大规模环境建图要求时,全局误差会不断累积,单机器人构建地图的精度会受到影响,甚至会由于计算量过大导致建图失败。此外,在某些特定场景中,单机器人会出现意外故障,无法继续完成建图任务[2]。

随着多智能体、人工智能等理论的发展,无人机、无人车和仿人机器人等各种形状、不同能力的机器人正在被机器人研究人员们设计成能够通过相互协作或与人类合作的方式完成复杂任务的智能体。近年来,各种机器人间的合作显著增加,多机器人被广泛应用于医疗保健、仓储物流、交通系统、应急响应系统、家务劳动等领域[3]。其中,多机器人协同SLAM以多机器人系统架构为基础,为系统内每个单机器人分配任务,利用多机通信使得机器人之间相互协调配合,共同完成复杂场景下的定位建图需求。

由于单机器人SLAM在任务中的局限性以及多机器人系统表现出的较强的灵活性和适应性,使多机器人协同SLAM受到越来越多的关注。目前,国内外关于多机器人协同SLAM的研究相对单机器人SLAM较少,且多数以多机器人协同SLAM的某一关键问题研究为主,系统的相关技术研究成果较少。本文结合近年来多机器人协同SLAM的研究成果,对其实现过程中的关键问题进行总结分析,并对多机器人协同SLAM的发展趋势进行展望。

1 多机器人协同SLAM发展现状SLAM问题自提出以来到现在已经发展了三十多年,随着计算机硬件和相应传感器的快速发展,使很多SLAM算法理论得以实现。如目前单机器人常用的激光SLAM算法有Gmapping[4]、Hector[5]、Cartographer[6],视觉SLAM算法有SVO-SLAM[7]、ORB-SLAM[8]等。在单机器人SLAM算法的发展相对成熟下,研究人员们开始将研究方向转移至多机器人SLAM算法,以便迎合未来大规模场景建图导航与定位的需求。

多机器人协同SLAM实现的基础是多机器人系统。多机器人系统通常采用集中式、分布式和分布-集中式3种架构。目前,多机器人系统的相关理论研究成果较为丰富,但实际开发和应用中仍有很多问题有待解决[9]。多机器人协同SLAM关键在于如何生成全局一致性地图,其中又涉及机器人间的位姿估计、通信等问题。对于多机器人协同SLAM,目前已有一些解决方法被提出,如基于拓展卡尔曼滤波(EKF-SLAM)、基于粒子滤波(PF-SLAM)、图优化(Graph SLAM)等算法。

基于拓展卡尔曼滤波的SLAM是协同SLAM中应用最广泛的一种解决方法。2014年,SCHMIDT[10]提出基于拓展卡尔曼滤波的多机器人视觉SLAM系统,在MonoSLAM的基础上引入机器人交互观测机制,测量机器人间的相对位姿。通过拓展卡尔曼滤波不断更新状态估计,以允许多个异构机器人进行协同SLAM。2016年,PIASCO等[11]设计一种基于拓展卡尔曼滤波的传感器融合方案,从分布式的测量数据中估计所有无人机的位置和方向,完成了具有多个无人机的分布式立体视觉协同定位。但拓展卡尔曼滤波是将非线性系统线性化来估计位姿,会出现不可避免的增量误差。为了获取理想的滤波效果和减少状态估计误差,2021年,ZHOU等[12]提出一种含有遗传因子的改进拓展卡尔曼滤波算法,将当前步骤的状态更新拓展为当前和之前两个步骤的状态更新,并引入遗传因子来降低之前步骤状态更新的影响,该算法提高了拓展卡尔曼滤波的定位精度。

拓展卡尔曼滤波在更新位姿状态时需要计算雅可比矩阵,由于雅可比矩阵的计算复杂性,基于拓展卡尔曼滤波的SLAM算法无法满足实时性要求,不能生成大的环境地图。为了解决该问题,研究人员引入了不计算雅可比矩阵的粒子滤波。2002年,MONTEMERLO等[13]提出Fast SLAM算法,采用粒子滤波算法解决定位问题,采用拓展卡尔曼滤波算法解决地图创建问题,实现了实时输出栅格地图。但粒子滤波中粒子重采样的随机性会导致粒子的多样性散失,粒子耗散也随着采样次数不断加剧,进而影响地图构建精度。为了解决这一问题,2014年,TANG等[14]提出基于粒子群优化的SLAM算法,在采样前调整粒子位置,增强建议分布,提高定位精度。2021年,LIU[15]提出在标准粒子滤波中引入基于点线一致性的增量式地图构建方法,该方法保留了每个粒子中线段特征地图的假设,并对观测信息引入重要性函数。在此基础上,提取局部地图的ORB特征,寻找最佳匹配点并计算其点集的变换矩阵,从而完成高精度的地图融合,实现多机器人协同SLAM。

图优化是一种平滑的SLAM算法,可以将该算法分为前端和后端两个部分。前端以机器人位姿为顶点、位姿关系为边来构建位姿图,后端调整机器人位姿顶点来满足位姿关系边的约束。图优化SLAM通过最大后验概率估计将SLAM问题转化为最小二乘优化问题,由于先前的所有状态和观测到的数据都参与了优化[16],机器人姿态估计的精度有了明显提高。2010年,KIM等[17]通过描述多个位姿图之间的关系,提出增量式平滑和建图(Incremental Smoothing and Mapping,ISAM)算法优化不同的相对位姿图,实现多机器人协同建图。

近年来,随着人工智能的深入研究,研究人员们将深度学习与SLAM技术相结合,出现了基于深度学习的AI SLAM算法[18-19]。目前,深度学习与SLAM的结合主要体现在帧间估计[20]、闭环检测[21]和语义地图[22]3个方面。结合了深度学习的帧间估计较传统算法避免了复杂计算,更加简洁;在闭环检测方面,准确度、鲁棒性、智能化程度都比传统闭环检测方法高;融合了深度学习的语义地图丰富了地图信息,尤其是室内SLAM使物体标签化,极大地促进了机器人和环境间的交互[23]。目前主流的多机器人协同SLAM算法对比如表 1所示。

|

下载CSV 表 1 主流的多机器人协同SLAM算法对比 Table 1 Comparison of mainstream multi-robot collaborative SLAM algorithms |

目前,多机器人协同SLAM是建立在多机器人系统以及单机器人执行建图任务的基础上。因此,根据单机器人自身所搭载的传感器不同,可以将多机器人协同SLAM主要分为激光协同SLAM、视觉协同SLAM和激光视觉融合SLAM三大类。

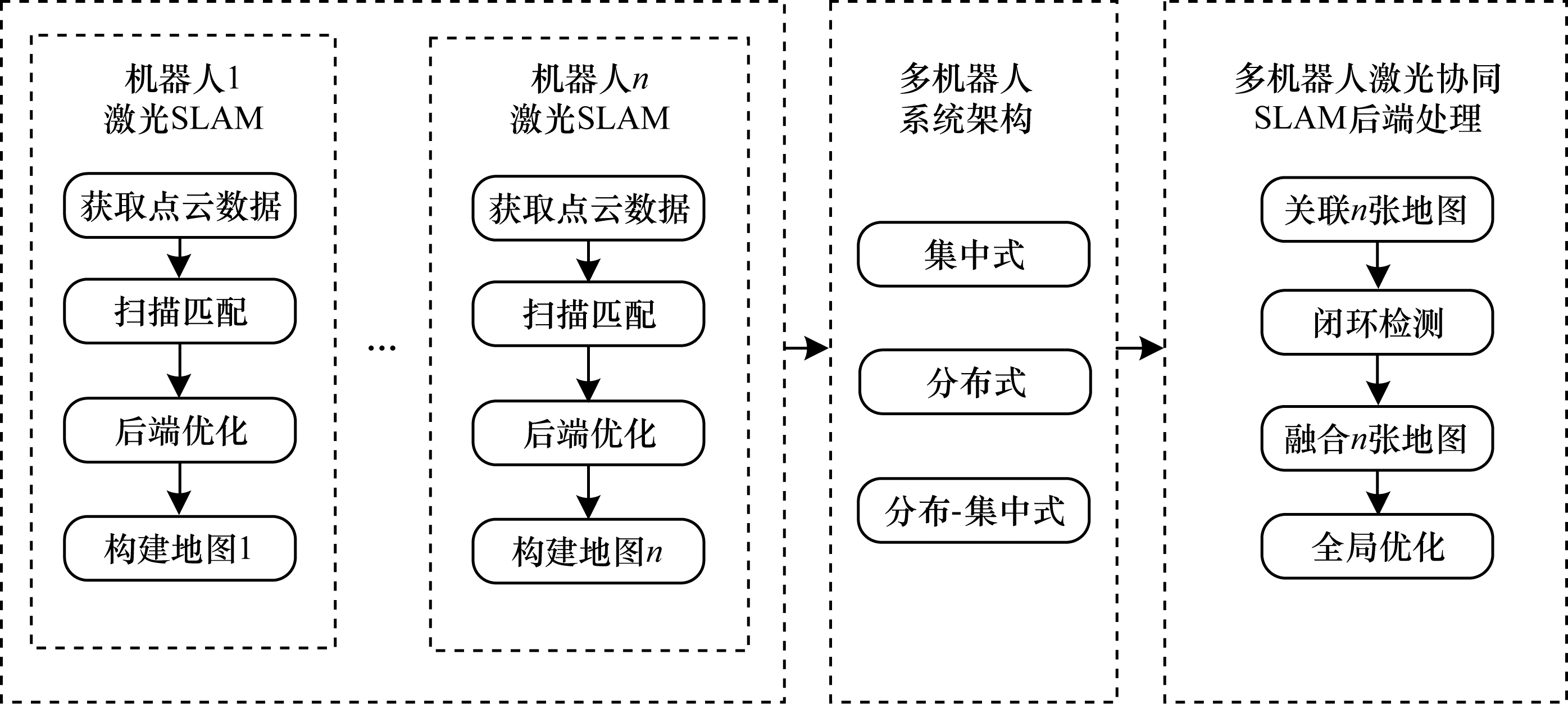

2.1 激光协同SLAM当前,多机器人激光协同SLAM框架主要基于单机器人激光SLAM进行建图任务,并保证所创建局部地图的精度。通过多机器人系统架构进行通信,对局部地图进行关联匹配,闭环检测。最终进行地图融合,并对融合后的全局地图进行优化。多机器人激光协同SLAM框架如图 1所示。

|

Download:

|

| 图 1 多机器人激光协同SLAM框架 Fig. 1 Multi-robot laser collaborative SLAM framework | |

在单机器人激光SLAM中,2D/3D激光雷达作为主要传感器。为了保证建图精度,一般还会搭载惯性测量单元(Inertial Measurement Unit,IMU)、里程计等传感器辅助激光雷达进行多传感器数据融合。通常在简单的室内场景下采用2D激光雷达,复杂的室外场景采用3D激光雷达,结合IMU计算角度信息、里程计计算位置信息来完成单机器人SLAM。

如图 1所示,可将激光SLAM主要分为扫描匹配、后端优化、闭环检测3个关键模块。扫描匹配是通过相邻帧之间的关系在已知前一帧位姿的条件下估计当前帧位姿,进而生成短时间内的位姿和地图。目前常用的扫描匹配算法有迭代最近点(Iterative Closest Point,ICP)、相关性扫描匹配(Correlation Scan Match,CSM)、正态分布变换(Normal Distribute Transformation,NDT)等[24-26]。后端优化主要是解决不可避免的局部误差累积,目前以基于滤波的优化和基于图优化的后端优化算法为主。闭环检测是对激光数据扫描匹配的相似性进行检测,判断当前所处位置是否为曾经访问过的位置,从而对当前构建的地图进行优化。目前主要有帧与帧之间检测、帧与子图之间检测、子图与子图之间检测等方法。

自1987年SMITH等[27]引出SLAM概念并基于扩展卡尔曼滤波提出EKF-SLAM算法以来,激光SLAM算法的研究便被越来越多的研究人员所关注。2016年,谷歌公司提出新的开源SLAM算法Cartographer[6],融合IMU、里程计等传感器数据,不断更新优化前端扫描匹配所创建的子图,后端加入闭环检测并对子图再次优化,得到全局地图。2020年,仇昌成[28]在谷歌公司的Cartographer算法基础上,提出基于OctoMap的多机器人SLAM算法。该算法首先保存单机器人在给定的环境中所创建的子地图序列,通过OctoMap关联算法对子图进行数据关联和子地图的闭环检测;然后选取子地图中匹配特征数量最多的变换矩阵作为单机器人之间的位姿变换,选择全局坐标系,提取多机器人的正确闭环,创建多机器人的全局优化函数;最后基于L-M算法求解全局优化函数的最优解,得到子地图之间的最优变换矩阵,通过OctoMap融合算法创建全局地图。

目前,将成熟的单机器人激光SLAM算法拓展到多个机器人来解决多机器人协同激光SLAM问题是常见的解决方案。2019年,ZHANG等[29]提出一种仅基于3D激光雷达传感器的多车协同SLAM算法。首先使单机器人通过LOAM-SLAM[30]算法生成自身局部地图;其次提取观察帧的地面特征,生成多个特征帧对两个机器人经过的相同场景进行识别;最后从所提取的相同场景区域的所有帧对中提取点云,为每个单机器人建立子图,计算位姿变换矩阵,创建全局一致性地图。

2.2 视觉协同SLAM相对于激光雷达,相机以小体积、低功耗、获取信息丰富等特点已成为SLAM问题的主要传感器之一。目前,视觉协同SLAM的主体实现框架和激光协同SLAM大致相同,主要基于单机器人视觉SLAM以及多机器人系统来完成多机器人视觉协同SLAM。多机器人视觉协同SLAM的框架如图 2所示。

|

Download:

|

| 图 2 多机器人视觉协同SLAM框架 Fig. 2 Multi-robot visual collaborative SLAM framework | |

在单机器人视觉SLAM中,相机作为主要传感器。根据不同的相机特点,可以将视觉SLAM分为仅搭载一个相机的单目视觉SLAM、搭载多个相机的立体视觉SLAM和搭载深度相机的RGB-D SLAM[31]。相对激光SLAM而言,视觉SLAM对环境的描述更为精细,但将相机作为唯一的传感器仍会受到复杂环境的影响。为了达到更好的建图与定位效果,研究人员们在视觉SLAM中也融合了IMU、里程计等传感器数据,提高了视觉SLAM在面对复杂环境时的鲁棒性[32-33]。

如图 2所示,可将视觉SLAM主要分为视觉前端、后端优化和回环检测三大部分。视觉前端主要分为直接法和特征点法,由于直接法很难匹配多机器人相机间的像素建立对应关系,因此在多机器人视觉SLAM中,视觉前端一般选择特征点法,包含特征检测与提取、特征匹配和帧间配准。目前主流的特征提取方案主要有尺度不变特征变换(Scale-Invariant Feature Transform,SIFT)、加速稳健特征(Speeded Up Robust Features,SURF)、ORB(Oriented FAST and Rotated BRIEF)特征提取[34]等。特征匹配是用来建立相邻帧之间的相同空间点线特征的对应关系,一般通过快速近似最近邻搜索库(Fast Library for Approximate Nearest Neighbors,FLANN)或K最近邻(K-Nearest Neighbors,KNN)等算法进行匹配,对于误匹配或匹配失败的特征点可以通过随机抽样一致(Random Sample Consensus,RANSAC)算法进行滤除[35]。帧间配准通过相邻帧之间配对成功的特征点来初步确定相邻帧的相对运动,通常选择迭代最近点(Iterative Closest Point,ICP)算法对帧间运动关系进行求解。

在后端优化方面,视觉SLAM一般也是基于滤波算法和基于图优化两种方法进行优化处理。由于时间和帧数的不断增加,视觉前端的累计误差也会随之增长,这将使得SLAM的效果很差,无法建立全局统一的地图。回环检测可以在当前数据和历史数据之间建立关联,通过将当前关键帧和历史所有帧进行比较,保证了在一定时间内位姿估计和所建地图的准确性。同时,这也使得多机器人协同SLAM在面临大规模地图环境时,检测时间会很长,进而导致建图效率过低等问题。在回环检测对整体SLAM效率和效果的影响问题上,有许多科研工作者设计了不同的改进算法[36-38],这对多机器人视觉协同SLAM有较大帮助。

2007年,DAVISON等[39]提出MonoSLAM算法,该算法将单目相机和拓展卡尔曼滤波优化算法相结合,该算法的提出拓展了视觉SLAM的解决方案。与激光协同SLAM相同,多机器人视觉协同SLAM的算法多数是对某种单机器人视觉SLAM算法的拓展延伸。2019年,SCHMUCK等[40]提出的CCM-SLAM多机器人协同SLAM框架便是基于单机器人的视觉SLAM算法ORB-SLAM而实现的视觉协同SLAM算法。该算法系统框架由一个服务器和若干单机器人子端构成,单机器人仅保留基本的视觉里程计,以保证能够在环境中独立建图和定位,单机器人和服务器之间通过无线网络进行通信。在通信期间,单机器人子端负责将所建立的地图信息发送至服务器端,单机器人只保存最近的N个关键帧,由服务器存储管理每个单机器人子端的历史地图信息。同时,服务器也向单机器人子端发送地图信息,以便子端重复到达某一位置时,为单机器人子端提供历史地图信息,进一步优化本地地图。最终由服务器完成相对位姿确定、地图融合、冗余检测和全局优化、生成全局一致性地图等工作。

2.3 激光视觉融合协同SLAM目前,多机器人协同SLAM多数仅利用激光或视觉数据。由于单一的激光或视觉SLAM存在一定的局限性,如激光SLAM在又长又直的长廊中或是动态变化大的环境中容易发生定位丢失,视觉SLAM对光照的依赖度较高以致于在暗处或无纹理区域无法进行工作,这使得多机器人SLAM在面对大规模动态环境时呈现出较低的效率和鲁棒性,因此将能够直接检测障碍物的激光SLAM和能够从图像中提取丰富信息的视觉SLAM相融合,以实现高性能的多机器人协同SLAM是一个较好的解决方法。

在单机器人实现激光和视觉融合SLAM算法中:2006年,NEWMAN等[41]利用SIFI特征实现闭环检测,然后触发基于激光的扫描匹配来实现SLAM,但该算法存在计算成本高的缺点;2015年,ZHANG等[42]开发了一个将视觉和激光结合的通用框架,该框架首先通过视觉里程计估计自身位姿并配准来自激光雷达获取的点云数据,再利用基于激光雷达里程计细化位姿估计和点云配准。

与单一的激光或视觉协同SLAM算法相似,多机器人融合协同SLAM是基于单机器人融合SLAM来实现的。2019年,CHEN等[43]提出一个多机器人融合SLAM算法。该算法首先将激光雷达前端获取的激光数据进行帧间扫描匹配,生成位姿图并基于滑动窗口对其优化和映射;然后将视觉所获取的信息进行闭环检测并发送闭环信号至激光雷达前端,激光数据对该视觉闭环进行判断和修正,以实现高效的环路检测和闭合;最后通过局域网使得多个机器人能够及时传输数据,将单个位姿图转换为同一坐标系下对不同机器人间的位姿图建立约束连接,通过最小二乘法对其进行优化,便得到了由多机器人构建的全局地图。

结合多机器人激光协同SLAM、多机器人视觉协同SLAM以及多机器人激光视觉融合协同SLAM的实现过程和主传感器差异,3种算法在对环境的适应性、计算量、建图质量等方面都有所不同。表 2列出了3种主传感器下多机器人协同SLAM算法的性能比较。

|

下载CSV 表 2 3种主传感器下多机器人协同SLAM算法的性能比较 Table 2 Performance comparison of multi-robot cooperative SLAM algorithms under three main sensors |

多机器人协同SLAM相对单机器人SLAM有着效率高、容错性强、精准度高等优势,但同时也面临一些问题和挑战。在多机器人协同SLAM中,单机器人在构建局部地图的同时需要整合所有可用数据来辅助自己在全局环境中进行精准定位,通过多机器人系统之间的通信进行数据关联,相互协调构建一致的全局地图。所涉及的架构选择和任务分配、相对位姿确定、通信和数据关联、地图融合和后端优化等都是多机器人协同SLAM的关键问题。

3.1 架构选择和任务分配对于多机器人协同建图,首先需要对总体任务进行了解,根据单机器人的整体性能,选择适合本次任务的多机器人系统。多机器人系统是多机器人协同SLAM的基础,多机器人系统需要根据环境约束、任务规模等因素来选择不同的架构,从而更好地实现任务分配和协同作业。目前,根据不同的控制方式,可以将多机器人系统架构分为集中式、分布式、分布-集中式3种,如图 3所示。

|

Download:

|

| 图 3 多机器人系统架构 Fig. 3 Multi-robot system architecture | |

1)集中式,通常采取服务端和客户端模式,设置计算力较高的中央控制端作为服务端,单机器人作为客户端。单机器人与中央控制端通过局域网或移动网进行通信,单机器人传输自身获取的环境信息给中央控制端,中央控制端给单机器人发布任务和其他指令。中央控制端可以根据系统中所有单机器人观测到的环境信息构建全局地图,由于所有的任务都由中央控制端处理和发布,单机器人只需完成自身SLAM问题即可,单个机器人成本低,执行效率高[44-45]。但为了保证机器人与中央控制端之间必要的数据传输,集中式要求单个机器人必须在中央控制端的通信范围内开展建图任务。随着云计算、5G通信等技术的发展,将中央控制计算单元设在云端,通过全覆盖的5G网络达到实时通信的集中式架构也正在研究中[46]。

2)分布式,该系统中的每个机器人在建立自身局部地图的同时,还可以与系统中其他机器人进行通信。在通信过程中,选择计算力较强的单机器人来融合系统中其他机器人的局部地图,从而生成全局地图[47-49]。相对集中式而言,虽然分布式系统的鲁棒性更强,不受通信范围的约束,但实际应用在多机器人协同SLAM中也更为复杂。分布式要求系统为每个拥有不同计算力的机器人分配不同任务,计算力的不同也影响到单机器人间所交流的信息量大小不一[50-51]。因此,分布式系统中两两机器人间的通信负载也不尽相同,这便要求分布式系统中的通信带宽需设置在一个合适的范围内。

3)分布-集中式,可以将系统中的机器人进行分组,在分组内采用分布式控制方式生成局部地图,之后通过中央管理模块生成全局地图。或者在通信范围内选择集中式控制方式,当超出通信范围时转换为分布式控制方式,以实现多机器人系统架构的稳定性。分布-集中式既具备集中与分布两种系统的优势,又保持了一致性[52]。在许多分布-集中式的架构中,中央管理模块承担较多的计算量,在给子端发送命令时也会将部分任务分配给单机器人来处理[53-54]。

3.2 多机通信和数据关联多机器人间的通信对多机器人协同SLAM是至关重要的,机器人之间的数据可以通过当前任务所处环境中稳定可用的通信信道进行共享处理。对某一环境而言,当前通信的带宽和覆盖范围代表着该环境下的通信质量和稳定性。因此,多机通信的带宽和覆盖范围决定了多机器人协同SLAM的质量。数据的交换共享可以是机器人与机器人(分布式)或中央控制端(集中式)之间的原始数据,如雷达、摄像头里程计等传感器直接获取的数据[55]。但在多数情况下,交换的数据信息是机器人所构建的局部地图、当前位姿等已加工数据[56],在这种情况下所交换的数据量也会成倍增长,对带宽和通信范围有了更高的要求。

目前,为解决基本的带宽需求问题,MOHANARAJAH等[57]提出在机器人间只发送压缩的关键帧和更新的关键帧位姿,GUPTA等[58]建议通过改进协议和路由的方法来满足带宽需求,MARCOTTE等[59]还提出通过机器人决策交换数据的优化算法来动态地适应当前带宽的解决方法。在现实的环境中,多机器人协同工作期间,机器人可能会出现故障、被攻击、超出通信范围等情况,从而出现网络被分割等问题。在多机器人系统SLAM中所涉及的通信延迟、中断容忍度、网络动态性、无缝切换、通信安全等问题也将在接下来的研究中进一步考虑。

数据关联一直是实现SLAM的关键问题,在多机器人协同SLAM中尤为重要。成功的数据关联需要将正确的测量和正确的状态相关联,初始化新的轨迹,检测和拒绝虚假的测量[60]。数据关联问题中一种常见的解决方案为最大似然估计[61],在给定位姿和基准标记的初始估计的情况下,计算最大似然数据关联集合,并随着机器人状态改变不断更新。另一种解决方案是概率数据关联,采用多假设的方法,保留并关联多个概率数据,形成并计算多个假设分支的得分,在多个假设分支中选择最高得分的分支[62]。

3.3 多机器人间的相对位姿在单机器人SLAM中,单机器人依据自身搭载的一系列传感器获取自身位姿,创建局部坐标系和局部地图。当单机器人进行地图更新时,由于传感器误差和环境的不确定性会造成自身位姿的不确定。在多机器人协同SLAM中,多机器人系统需要对单机器人当前所处环境及位姿进行分析,并计算多机器人系统中每个机器人的相对位姿。由于单机器人本身存在一定的位姿不确定性,再加上机器人系统中存在多个机器人,因此相对位姿的确定是非常困难的。

在解决多机器人相对位姿问题时,通常有以下两种方案:

1)依赖于机器人之间的直接相对位姿约束,假设机器人能够共享它们之间的3D点云数据,或者识别环境中的基准标记,通过雷达、摄像头等传感器对彼此的姿态进行直接观察估计[63]。在任务中与其他机器人相遇时,推测彼此在当前时间下的相对姿态并相应地更新它们的位姿估计[64]。2018年,TSOUKALAS等[65]提出在无人机顶端添加一个由17个小平面组成的菱形基准标记,该标记可以被无人机所搭载的视觉传感器所识别,进而在无人机之间优化更新相对位姿的估计。

2)依赖于机器人之间的间接相对位姿约束,当多个机器人观察到同一场景时会形成闭环约束[66]。此外,可以在不同时间多个机器人之间建立该约束,不需要机器人之间的直接视线和相遇。2018年,CHEN等[50]通过计算当前关键帧的视觉单词,并在由DBoW2构成的视觉词汇树中获取与当前关键帧相似的候选帧。对匹配度较高的候选帧进行Sim3变换,RANSAC算法迭代计算相似变换,将回环检测的思想应用于帧间匹配,进而估计相对位姿。

3.4 地图融合在多机器人协同SLAM中,单机器人在给定的任务范围内建立局部地图,协同SLAM需要将所有单机器人建立的局部地图融合起来生成全局地图。但由于每个单机器人在生成局部地图时的坐标系不统一,因此不能对局部地图直接进行合并。针对该问题通常有以下两种情况:

1)已知初始相对位姿的情况:直接利用初始位姿关系得到局部地图之间的变换关系,但该方法的误差会随着时间不断累积[67]。为了使误差尽可能最小,通过梯度下降法寻找最优变换,或者通过粒子滤波算法进行优化[68]。

2)未知初始相对位姿的情况:通过机器人计算机器人间的直接相对位姿约束,进而得到所生成局部地图之间的变换关系[69]。另外,在单机器人所生成的局部地图间进行重叠检测,寻找重叠区域,从而得到变换关系[70]。并且,基于点、线或者其他特征进行匹配,对匹配的特征进行可靠性分析,以此来计算局部地图之间的变换关系[71]。

3.5 后端优化在多机器人协同SLAM中,后端优化是极其重要的环节,主要根据多机器人协同SLAM前端所构建的相关约束,形成多机器人协同SLAM的全局误差目标函数。接着通过优化算法对目标函数求出最优解,将全局误差降至最小,并创建全局一致性地图。

根据后端优化时算法的不同,多机器人SLAM算法主要分为基于滤波器和基于图优化的算法。在基于滤波器的算法方面,2006年,ZHOU等[72]基于卡尔曼滤波对机器人的位姿和标志点信息进行滤波,提出EKF-SLAM算法来解决多机器人建图问题。由于该算法需要不断更新协方差矩阵(其计算量与特征点数量成正比)来表示机器人之间相对位姿的不确定性,当面临复杂环境时,EKF-SLAM算法的计算量会比较大。2005年,THRUN等[73]提出基于稀疏特征的扩展信息滤波算法SEIF-SLAM,采用可加性的信息矩阵替换协方差矩阵来降低多机器人SLAM的计算复杂性。2006年,HOWARD[74]在THRUN等研究基础上提出基于Rao-Blackwellised粒子滤波的多机器人SLAM算法,假设每个机器人在执行任务时至少相遇一次,相遇时测量其相对位姿,通过两个队列来记录机器人相遇前后的观测数据和运动数据并创建全局地图。但基于滤波的SLAM算法计算量比较大,特别是在复杂环境下对机器人的计算能力有较高要求。基于图优化的SLAM算法以计算量小、精准度高等优点逐渐被广大研究人员所关注。2016年,DEUTSCH等[75]提出了单机器人图优化SLAM算法获取局部位姿图,通过软件进行聚合生成全局位姿图的多机器人协同SLAM框架,该框架可以与各种SLAM算法协同工作。同年,CAMPOS等[76]将光学轨迹与机器人的度量轨迹相融合,并进行图优化,基于多机器人对水下环境进行了3D建图。2020年,BONIN-FONT等[77]提出在单个基于姿态的图中连接不同机器人在相同场景下的多条轨迹,然后通过HALOC回环检测算法在不同机器人的轨迹图像之间寻找循环闭合,并向全局图添加附加约束,基于图优化的算法实现了多机器人水下协同SLAM。

4 未来研究展望当前,对多机器人协同SLAM而言,由于发展时间稍短,其算法的成熟度仍不如单机器人SLAM。在多机器人协同SLAM的关键问题上,研究人员展开了系列研究,使多机器人协同SLAM较前些年有了一定的进步。结合目前研究现状,笔者认为多机器人协同SLAM将在以下6个方面做进一步的研究与探索:

1)异构机器人协同技术下的多种地图合并。在未知的复杂环境中,单纯地依靠一种类型的机器人俨然不能满足任务需要。如只通过无人机对地面环境进行建图时,对环境的描述是相对粗糙的,若将地面机器人与无人机相结合,其整体对环境的描述将会更加细腻。机器人多样化是多机器人的发展趋势。对于不同类型的机器人,所生成的地图类型也不尽相同,如栅格地图、拓扑地图、语义地图等。如何融合多种机器人的传感器数据和多种类型的地图,创建一致性的环境地图是多机器人协同SLAM未来要解决的关键问题。

2)多样性环境下稳定且高效的通信技术。在多机器人协同SLAM中,容错性仍是一个关键问题,持续且良好的通信保障能够有效提高协同SLAM的容错性。环境的多样性决定了通信介质的多样性,如水下环境中的高干扰和较差的信号传播条件,直接影响了通信的可靠性。如何在多样性的环境下保持良好的通信,以及在数据丢失的情况下建立高质量的地图对于多机器人协同SLAM而言是一项挑战。

3)大范围未知环境条件下的协同SLAM算法。当前,许多协同SLAM算法在创建全局一致性地图时通常是对已完成的局部地图进行融合,这导致了在特征类似或缺失的环境中算法表现较差。在地图融合的过程中考虑加入时间戳机制或一定时间内进行一次局部地图融合,有利于在动态的环境中进行SLAM。大范围环境中进行SLAM对机器人间的协调而言是具有挑战性的,尤其对于多机器人系统架构。将协同SLAM应用场景由小范围静态转变为大范围动态既是多机器人协同SLAM的发展趋势,也是一大挑战。

4)不同机器人数量的弹性变换协同技术。目前多数多机器人协同SLAM算法是在某一特定场景下执行,其机器人的数量也是提前设定好的,这样的协同SLAM算法面对不同环境时会很大程度影响整体效果和效率。因此,在设计协同SLAM算法时,考虑算法中机器人的数量可以随着环境变化而弹性增减,能够提高算法的鲁棒性和效率。

5)深度学习与语义SLAM。随着深度学习和计算机硬件的快速发展,将目标检测等算法应用在机器人上已经成为现实。将目标识别检测与语义SLAM相结合,使得机器人对环境中的物体标签化,一方面可以辅助机器人确定自身位姿,另一方面也可以加强机器人与环境中物体的交互性。

6)统一的多机器人协同SLAM性能评估技术。在多机器人协同SLAM得到越来越多科研工作者关注的情况下,协同SLAM的解决方案也在不断增长。因此,亟需选择定位建图精度、工作效率、鲁棒性等多个性能评价指标对不同算法进行客观评估。

5 结束语针对单机器人SLAM在实际应用中的局限性,本文引入多机器人协同SLAM概念并介绍其发展现状,明确多机器人协同已经成为SLAM的主要发展趋势。随着研究的不断深入,多机器人协同的关键问题逐渐被解决,异构多机器人协同和语义SLAM作为主要发展趋势,不仅能够拓展SLAM应用的空间维度,而且为机器人与环境之间的深度交互提供了新思路。但若将多机器人协同技术广泛应用于SLAM领域,则其算法细节与鲁棒性仍有待提升,因此下一步将对此进行深入研究。

| [1] |

SMITH R C, CHEESEMAN P. On the representation and estimation of spatial uncertainty[J]. The International Journal of Robotics Research, 1986, 5(4): 56-68. DOI:10.1177/027836498600500404 |

| [2] |

SAEEDI S, TRENTINI M, SETO M, et al. Multiple-robot simultaneous localization and mapping: a review[J]. Journal of Field Robotics, 2016, 33(1): 3-46. DOI:10.1002/rob.21620 |

| [3] |

RIZK Y, AWAD M, TUNSTEL E W. Cooperative heterogeneous multi-robot systems: a survey[J]. ACM Computing Surveys, 2020, 52(2): 29-31. |

| [4] |

GRISETTI G, STACHNISS C, BURGARD W. Improved techniques for grid mapping with Rao-Blackwellized particle filters[J]. IEEE Transactions on Robotics, 2007, 23(1): 34-46. DOI:10.1109/TRO.2006.889486 |

| [5] |

KOHLBRECHER S, VON STRYK O, MEYER J, et al. A flexible and scalable SLAM system with full 3D motion estimation[C]//Proceedings of IEEE International Symposium on Safety, Security, and Rescue Robotics. Washington D.C., USA: IEEE Press, 2011: 155-160.

|

| [6] |

HESS W, KOHLER D, RAPP H, et al. Real-time loop closure in 2D LIDAR SLAM[C]//Proceedings of IEEE International Conference on Robotics and Automation. Washington D.C., USA: IEEE Press, 2016: 1271-1278.

|

| [7] |

FORSTER C, PIZZOLI M, SCARAMUZZA D. SVO: fast semi-direct monocular visual odometry[C]//Proceedings of IEEE International Conference on Robotics and Automation. Washington D.C., USA: IEEE Press, 2014: 15-22.

|

| [8] |

MUR-ARTAL R, MONTIEL J M M, TARDÓS J D. ORB-SLAM: a versatile and accurate monocular SLAM system[J]. IEEE Transactions on Robotics, 2015, 31(5): 1147-1163. DOI:10.1109/TRO.2015.2463671 |

| [9] |

VALENTINI G, FERRANTE E, HAMANN H, et al. Collective decision with 100 Kilobots: speed versus accuracy in binary discrimination problems[J]. Autonomous Agents and Multi-Agent Systems, 2016, 30(3): 553-580. DOI:10.1007/s10458-015-9323-3 |

| [10] |

SCHMIDT A. Multi-robot, EKF-based visual SLAM system[M]. Berlin, Germany: Springer, 2014.

|

| [11] |

PIASCO N, MARZAT J, SANFOURCHE M. Collaborative localization and formation flying using distributed stereo-vision[C]//Proceedings of IEEE International Conference on Robotics and Automation. Washington D.C., USA: IEEE Press, 2016: 1202-1207.

|

| [12] |

ZHOU Z, WANG D Q, XU B Y. A multi-innovation with forgetting factor based EKF-SLAM method for mobile robots[J]. Assembly Automation, 2021, 41(1): 71-78. DOI:10.1108/AA-01-2020-0002 |

| [13] |

MONTEMERLO M, STENTZ A. FastSLAM: a factored solution to the simultaneous localization and mapping problem with unknown data association[C]//Proceedings of AAAI National Conference on Artificial Intelligence Edmonton Alberta. New York, USA: ACM Press, 2002: 240-248.

|

| [14] |

TANG X L, LI L M, JIANG B J. Mobile robot SLAM method based on multi-agent particle swarm optimized particle filter[J]. The Journal of China Universities of Posts and Telecommunications, 2014, 21(6): 78-86. DOI:10.1016/S1005-8885(14)60348-4 |

| [15] |

LIU W L. SLAM algorithm for multi-robot communication in unknown environment based on particle filter[J/OL]. Journal of Ambient Intelligence and Humanized Compting: 1-9[2021-07-18]. https://doi.org/10.1007/s12652-021-03020-3.

|

| [16] |

WEN W S, HSU L T, ZHANG G H. Performance analysis of NDT-based graph SLAM for autonomous vehicle in diverse typical driving scenarios of Hong Kong[J]. Sensors, 2018, 18(11): 3928. DOI:10.3390/s18113928 |

| [17] |

KIM B, KAESS M, FLETCHER L, et al. Multiple relative pose graphs for robust cooperative mapping[C]//Proceedings of IEEE International Conference on Robotics and Automation. Washington D.C., USA: IEEE Press, 2010: 3185-3192.

|

| [18] |

张金凤, 石朝侠, 王燕清. 动态场景下基于视觉特征的SLAM方法[J]. 计算机工程, 2020, 46(10): 95-102. ZHANG J F, SHI C X, WANG Y Q. SLAM method based on visual features in dynamic scene[J]. Computer Engineering, 2020, 46(10): 95-102. (in Chinese) |

| [19] |

余东应, 刘桂华, 曾维林, 等. 自适应窗隔匹配与深度学习相结合的RGB-D SLAM算法[J]. 计算机工程, 2021, 47(8): 224-233. YU D Y, LIU G H, ZENG W L, et al. RGB-D SLAM algorithm combining adaptive window interval matching and deep learning[J]. Computer Engineering, 2021, 47(8): 224-233. (in Chinese) |

| [20] |

COSTANTE G, MANCINI M, VALIGI P, et al. Exploring representation learning with CNNs for frame-to-frame ego-motion estimation[J]. IEEE Robotics and Automation Letters, 2016, 1(1): 18-25. DOI:10.1109/LRA.2015.2505717 |

| [21] |

GAO X, ZHANG T. Unsupervised learning to detect loops using deep neural networks for visual SLAM system[J]. Autonomous Robots, 2017, 41(1): 1-18. DOI:10.1007/s10514-015-9516-2 |

| [22] |

MA L N, STÜCKLER J, KERL C, et al. Multi-view deep learning for consistent semantic mapping with RGB-D cameras[C]//Proceedings of IEEE/RSJ International Conference on Intelligent Robots and Systems. Washington D.C., USA: IEEE Press, 2017: 598-605.

|

| [23] |

田野, 陈宏巍, 王法胜, 等. 室内移动机器人的SLAM算法综述[J]. 计算机科学, 2021, 48(9): 223-234. TIAN Y, CHEN H W, WANG F S, et al. Overview of SLAM algorithms for mobile robots[J]. Computer Science, 2021, 48(9): 223-234. (in Chinese) |

| [24] |

CHO H, KIM E K, KIM S. Indoor SLAM application using geometric and ICP matching methods based on line features[J]. Robotics and Autonomous Systems, 2018, 100: 206-224. DOI:10.1016/j.robot.2017.11.011 |

| [25] |

REN R K, FU H, WU M P. Large-scale outdoor SLAM based on 2D lidar[J]. Electronics, 2019, 8(6): 613. DOI:10.3390/electronics8060613 |

| [26] |

SRINARA S, LEE C M, TSAI S, et al. Performance analysis of 3D NDT scan matching for autonomous vehicles using INS/GNSS/3D LiDAR-SLAM integration scheme[C]//Proceedings of IEEE International Symposium on Inertial Sensors and Systems. Washington D.C., USA: IEEE Press, 2021: 1-4.

|

| [27] |

SMITH R, SELF M, CHEESEMAN P. Estimating uncertain spatial relationships in robotics[C]//Proceedings of 1987 IEEE International Conference on Robotics and Automation. Washington D.C., USA: IEEE Press, 1987: 850.

|

| [28] |

仇昌成. 基于三维激光点云的室内多机器人SLAM研究[D]. 苏州: 苏州大学, 2020. QIU C C. Research on indoor multi-robot SLAM based on 3D lidar point cloud[D]. Suzhou: Soochow University, 2020. (in Chinese) |

| [29] |

ZHANG Y C, CHEN L, XUANYUAN Z, et al. Three-dimensional cooperative mapping for connected and automated vehicles[J]. IEEE Transactions on Industrial Electronics, 2020, 67(8): 6649-6658. DOI:10.1109/TIE.2019.2931521 |

| [30] |

ZHANG J, SINGH S. LOAM: lidar odometry and mapping in real-time[J]. Robotics: Science and Systems, 2014, 2: 9. |

| [31] |

权美香, 朴松昊, 李国. 视觉SLAM综述[J]. 智能系统学报, 2016, 11(6): 768-776. QUAN M X, PIAO S H, LI G. An overview of visual SLAM[J]. CAAI Transactions on Intelligent Systems, 2016, 11(6): 768-776. (in Chinese) |

| [32] |

潘林豪, 田福庆, 应文健, 等. 单目相机-IMU外参自动标定与在线估计的视觉-惯导SLAM[J]. 仪器仪表学报, 2019, 40(6): 56-67. PAN L H, TIAN F Q, YING W J, et al. VI-SLAM algorithm with camera-IMU extrinsic automatic calibration and online estimation[J]. Chinese Journal of Scientific Instrument, 2019, 40(6): 56-67. (in Chinese) |

| [33] |

樊建彪, 孙剑, 樊欢欢, 等. 基于磁力计、IMU和单目视觉的自主定位方法[J]. 宇航总体技术, 2019, 3(6): 39-45. FAN J B, SUN J, FAN H H, et al. A method of autonomous localization based on magnetometer, IMU, and monocular vision[J]. Astronautical Systems Engineering Technology, 2019, 3(6): 39-45. (in Chinese) |

| [34] |

CAO L K, LING J, XIAO X H. Study on the influence of image noise on monocular feature-based visual SLAM based on FFDNet[J]. Sensors, 2020, 20(17): 4922. DOI:10.3390/s20174922 |

| [35] |

PUDCHUEN N, JITVIRIYA W. 3-D mapping and localization using RGB-D camera[C]//Proceedings of the 1st International Symposium on Instrumentation, Control, Artificial Intelligence, and Robotics. Washington D.C., USA: IEEE Press, 2019: 139-142.

|

| [36] |

DENG C G, LUO X N, ZHONG Y R. Improved closed-loop detection and Octomap algorithm based on RGB-D SLAM[C]//Proceedings of IEEE International Conference on Artificial Intelligence and Computer Applications. Washington D.C., USA: IEEE Press, 2020: 73-76.

|

| [37] |

HU Z F, QI B L, LUO Y, et al. Mobile robot V-SLAM based on improved closed-loop detection algorithm[C]//Proceedings of the 8th Joint International Information Technology and Artificial Intelligence Conference. Washington D.C., USA: IEEE Press, 2019: 1150-1154.

|

| [38] |

ZHANG Q S, XU G H, LI N. Improved SLAM closed-loop detection algorithm based on DBoW2[J]. Journal of Physics: Conference Series, 2019, 1345(4): 42094. DOI:10.1088/1742-6596/1345/4/042094 |

| [39] |

DAVISON A J, REID I D, MOLTON N D, et al. MonoSLAM: real-time single camera SLAM[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2007, 29(6): 1052-1067. DOI:10.1109/TPAMI.2007.1049 |

| [40] |

SCHMUCK P, CHLI M. CCM-SLAM: robust and efficient centralized collaborative monocular simultaneous localization and mapping for robotic teams[J]. Journal of Field Robotics, 2019, 36(4): 763-781. DOI:10.1002/rob.21854 |

| [41] |

NEWMAN P, COLE D, HO K. Outdoor SLAM using visual appearance and laser ranging[C]//Proceedings 2006 IEEE International Conference on Robotics and Automation. Washington D.C., USA: IEEE Press, 2006: 1180-1187.

|

| [42] |

ZHANG J, SINGH S. Visual-lidar odometry and mapping: low-drift, robust, and fast[C]//Proceedings of IEEE International Conference on Robotics and Automation. Washington D.C., USA: IEEE Press, 2015: 2174-2181.

|

| [43] |

CHEN H Y, HUANG H L, QIN Y, et al. Vision and laser fused SLAM in indoor environments with multi-robot system[J]. Assembly Automation, 2019, 39(2): 297-307. DOI:10.1108/AA-04-2018-065 |

| [44] |

SCHMUCK P, CHLI M. Multi-UAV collaborative monocular SLAM[C]//Proceedings of IEEE International Conference on Robotics and Automation. Washington D.C., USA: IEEE Press, 2017: 3863-3870.

|

| [45] |

MA T Y, ZHANG T, LI S P. Multi-robot collaborative SLAM and scene reconstruction based on RGB-D camera[C]//Proceedings of Chinese Automation Congress. Washington D.C., USA: IEEE Press, 2020: 139-144.

|

| [46] |

SCHMUCK P, ZIEGLER T, KARRER M, et al. COVINS: visual-inertial SLAM for centralized collaboration[C]//Proceedings of 2021 IEEE International Symposium on Mixed and Augmented Reality Adjunct. Washington D.C., USA: IEEE Press, 2021: 1-12.

|

| [47] |

LAJOIE P Y, RAMTOULA B, CHANG Y, et al. DOOR-SLAM: distributed, online, and outlier resilient SLAM for robotic teams[J]. IEEE Robotics and Automation Letters, 2020, 5(2): 1656-1663. DOI:10.1109/LRA.2020.2967681 |

| [48] |

GAO L, BATTISTELLI G, CHISCI L. Random-finite-set-based distributed multirobot SLAM[J]. IEEE Transactions on Robotics, 2020, 36(6): 1758-1777. DOI:10.1109/TRO.2020.3001664 |

| [49] |

WEN S H, CHEN J, LÜ X H, et al. Cooperative simultaneous localization and mapping algorithm based on distributed particle filter[J/OL]. International Journal of Advanced Robotic Systems: 1-7[2021-07-18]. https://doi.org/10.1177/1729881418819950.

|

| [50] |

CHEN X, LU H M, XIAO J H, et al. Distributed monocular multi-robot SLAM[C]//Proceedings of the 8th Annual International Conference on CYBER Technology in Automation, Control, and Intelligent Systems. Washington D.C., USA: IEEE Press, 2018: 73-78.

|

| [51] |

ZHANG H, CHEN X, LU H M, et al. Distributed and collaborative monocular simultaneous localization and mapping for multi-robot systems in large-scale environments[J/OL]. International Journal of Advanced Robotic Systems: 1-12[2021-07-18]. https://doi.org/10.1177/1729881418780178.

|

| [52] |

RIZK Y, AWAD M, TUNSTEL E W. Cooperative heterogeneous multi-robot systems: a survey[J]. ACM Computing Surveys, 2019, 52(2): 1-29, 31. |

| [53] |

FORSTER C, LYNEN S, KNEIP L, et al. Collaborative monocular SLAM with multiple micro aerial vehicles[C]//Proceedings of IEEE/RSJ International Conference on Intelligent Robots and Systems. Washington D.C., USA: IEEE Press, 2013: 3962-3970.

|

| [54] |

CAPPEL H F. A hierarchical multi-robot mapping architecture subject to communication constraints[D]. Austin, USA: University of Texas at Austin, 2021.

|

| [55] |

GIAMOU M, KHOSOUSSI K, HOW J P. Talk resource-efficiently to me: optimal communication planning for distributed loop closure detection[C]//Proceedings of IEEE International Conference on Robotics and Automation. Washington D.C., USA: IEEE Press, 2018: 3841-3848.

|

| [56] |

MAHDOUI N, FRÉMONT V, NATALIZIO E. Communicating multi-UAV system for cooperative SLAM-based exploration[J]. Journal of Intelligent & Robotic Systems, 2020, 98(2): 325-343. |

| [57] |

MOHANARAJAH G, USENKO V, SINGH M, et al. Cloud-based collaborative 3D mapping in real-time with low-cost robots[J]. IEEE Transactions on Automation Science and Engineering, 2015, 12(2): 423-431. DOI:10.1109/TASE.2015.2408456 |

| [58] |

GUPTA L, JAIN R, VASZKUN G. Survey of important issues in UAV communication networks[J]. IEEE Communications Surveys & Tutorials, 2016, 18(2): 1123-1152. DOI:10.1109/COMST.2015.2495297 |

| [59] |

MARCOTTE R J, WANG X P, MEHTA D, et al. Optimizing multi-robot communication under bandwidth constraints[J]. Autonomous Robots, 2020, 44(1): 43-55. |

| [60] |

NIETO J, GUIVANT J, NEBOT E, et al. Real time data association for FastSLAM[C]//Proceedings of IEEE International Conference on Robotics and Automation. Washington D.C., USA: IEEE Press, 2003: 412-418.

|

| [61] |

DOHERTY K, FOURIE D, LEONARD J. Multimodal semantic SLAM with probabilistic data association[C]//Proceedings of International Conference on Robotics and Automation. Washington D.C., USA: IEEE Press, 2019: 2419-2425.

|

| [62] |

WANG J K, ENGLOT B. Robust exploration with multiple hypothesis data association[C]//Proceedings of IEEE/RSJ International Conference on Intelligent Robots and Systems. Washington D.C., USA: IEEE Press, 2018: 3537-3544.

|

| [63] |

LEE H. One-way observation-based cooperative robot mapping[C]//Proceedings of the 16th International Conference on Automation Science and Engineering. Washington D.C., USA: IEEE Press, 2020: 900-905.

|

| [64] |

JANG Y, OH C, LEE Y, et al. Multirobot collaborative monocular SLAM utilizing rendezvous[J]. IEEE Transactions on Robotics, 2021, 37(5): 1469-1486. DOI:10.1109/TRO.2021.3058502 |

| [65] |

TSOUKALAS A, TZES A, KHORRAMI F. Relative pose estimation of unmanned aerial systems[C]//Proceedings of the 26th Mediterranean Conference on Control and Automation. Washington D.C., USA: IEEE Press, 2018: 155-160.

|

| [66] |

INDELMAN V, NELSON E, MICHAEL N, et al. Multi-robot pose graph localization and data association from unknown initial relative poses via expectation maximization[C]//Proceedings of IEEE International Conference on Robotics and Automation. Washington D.C., USA: IEEE Press, 2014: 593-600.

|

| [67] |

CHEN B F, LI S Y, ZHAO H W, et al. Map merging with suppositional box for multi-robot indoor mapping[J]. Electronics, 2021, 10(7): 815. DOI:10.3390/electronics10070815 |

| [68] |

SAEEDI S, TRENTINI M, LI H. A hybrid approach for multiple-robot SLAM with particle filtering[C]//Proceedings of IEEE/RSJ International Conference on Intelligent Robots and Systems. Washington D.C., USA: IEEE Press, 2015: 3421-3426.

|

| [69] |

LEE H, LEE S. Extended spectra-based grid map merging with unilateral observations for multi-robot SLAM[J]. IEEE Access, 2021, 9: 79651-79662. |

| [70] |

BIRK A, CARPIN S. Merging occupancy grid maps from multiple robots[J]. Proceedings of the IEEE, 2006, 94(7): 1384-1397. DOI:10.1109/JPROC.2006.876965 |

| [71] |

FERRÃO V T, VINHAL C D N, DA CRUZ G. An occupancy grid map merging algorithm invariant to scale, rotation and translation[C]//Proceedings of Brazilian Conference on Intelligent Systems. Washington D.C., USA: IEEE Press, 2017: 246-251.

|

| [72] |

ZHOU X S, ROUMELIOTIS S I. Multi-robot SLAM with unknown initial correspondence: the robot rendezvous case[C]//Proceedings of IEEE/RSJ International Conference on Intelligent Robots and Systems. Washington D.C., USA: IEEE Press, 2006: 1785-1792.

|

| [73] |

THRUN S, LIU Y F. Multi-robot SLAM with sparse extended information filers[M]. Berlin, Germany: Springer, 2005.

|

| [74] |

HOWARD A. Multi-robot simultaneous localization and mapping using particle filters[J]. The International Journal of Robotics Research, 2006, 25(12): 1243-1256. |

| [75] |

DEUTSCH I, LIU M, SIEGWART R. A framework for multi-robot pose graph SLAM[C]//Proceedings of IEEE International Conference on Real-time Computing and Robotics. Washington D.C., USA: IEEE Press, 2016: 567-572.

|

| [76] |

CAMPOS R, GRACIAS N, RIDAO P. Underwater multi-vehicle trajectory alignment and mapping using acoustic and optical constraints[J]. Sensors, 2016, 16(3): 387. |

| [77] |

BONIN-FONT F, BURGUERA A. Towards multi-robot visual graph-slam for autonomous marine vehicles[J]. Journal of Marine Science and Engineering, 2020, 8(6): 437. DOI:10.3390/jmse8060437 |

2022, Vol. 48

2022, Vol. 48