2. 昆明理工大学 云南省人工智能重点实验室, 昆明 650500

2. Yunnan Key Laboratory of Artificial Intelligence, Kunming University of Science and Technology, Kunming 650500, China

开放科学(资源服务)标志码(OSID):

汉越跨语言新闻事件检索任务是指用户将包含事件信息的汉语查询句输入检索系统后,检索系统为用户返回一系列与查询句中事件信息相关的越南语新闻文档。目前主流的跨语言信息检索系统采用查询翻译方法[1]、文档翻译方法[2]或中间语言翻译方法[3]。其中,查询翻译方法首先将查询句翻译成候选文档所使用语言下的查询句,然后使用翻译后的查询句对候选文档进行检索排序。因为该方法只翻译查询句,翻译难度较低且正确率高,所以在跨语言信息检索任务中最常使用。

目前主流的检索模型有基于特征的检索模型[4]和基于神经网络的检索模型[5]。

基于特征的检索模型由于依赖于人工寻找特征且找到的特征数量有限,导致模型参数量较少,使得模型泛化能力降低,因此,其相较于基于神经网络的检索模型在完成检索任务时表现较差。但是,有一些基于特征的检索模型在融合实体语义信息后性能会得到较大提升,包括利用实体标注进行文本表示的检索模型[6]、多排序特征的检索模型[7]、基于查询句与文档间实体连接的检索模型[8]以及基于知识图谱实现查询句和文档软匹配的检索模型[9],这些模型均是通过融合实体语义信息来提高检索性能。

基于神经网络的检索模型又可分为基于表示的检索模型和基于交互的检索模型。基于表示的检索模型[10]在初始阶段对查询句和文档单独进行处理,然后使用神经网络分别编码,得到各自的文本表征并进行相似度计算,最后将文本表征的相似度作为查询和文档的相似度得分,根据相似度得分对文档进行排序。这种基于表示的检索模型在最后阶段才会利用文本表征计算查询与文档间的相似度,模型的效果过于依赖文本表征的质量,并且会丢失对模型效果有正向作用的句法和词法等基础的文本特征。基于交互的检索模型[11]在开始阶段就计算查询句与文档之间的词级别的语义相似度作为基础的交互特征,并在交互特征的基础上进一步抽取层次交互特征,得到查询句与文档交互固定维度的表示,最后通过计算相似度对文档进行打分排序。由于基于交互的检索模型尽可能早地将查询句和文档进行了交互,捕获到了查询句与文档之间相对更基础的特征,因此检索效果相较于基于表示的检索模型提升显著。

基于交互的检索模型利用神经网络和词级交互信息学习相对复杂的排序模型,其在开放域的检索任务上性能优于基于特征的检索模型和基于表示的检索模型。然而,在汉越跨语言新闻事件检索任务中包含事件描述的候选文档中含有大量新闻事件领域内特有的事件实体[12],如人名、地名、组织机构名、特定政治概念名等事件实体。目前,事件实体的语义信息能否融入基于交互的检索模型中来提高汉越跨语言新闻事件检索模型排序的性能尚不明确,并且在事件检索任务中,一篇候选文档中可能包含多个事件,这会干扰事件查询句和包含该事件信息的候选文档匹配的性能。以越南语候选文档中的事件描述“Tổng Giám đốc Tổ chức Y tế thế giới(WHO)Tedros có bài phát biểu mừng năm mới,sự kiện xảy ra trong năm 2020 sẽ cung cấp bài học và lưu ý khi bước vào năm 2021,điều quan trọng nhất là Chính phủ phải tăng ngân sách cho y tế công cộng,bao gồm cung cấp tài chính cho mọi người có được vắc-xin COVID-19.”为例,该描述中包含3种不同的事件,分别为:“Tedros có bài phát biểu mừng năm mới”,中文解释为“Tedros发表新年演讲”;“phủ phải tăng ngân sách cho y tế công cộng”,中文解释为“政府必须增加公共卫生预算”;“tài chính cho mọi người có được vắc-xin COVID-19”,中文解释为“资助所有人获得COVID-19疫苗”。假定用户对“Tedros发表新年演讲”这一事件感兴趣,用户输入的查询句可能是“Tedros biểu năm mới”,在查询句与候选文档进行排序匹配时,其余2种事件会增加噪声,扩大匹配的事件范围,降低查询句与候选文档匹配的准确度,影响检索模型的性能。

一篇候选文档中可能包含多个事件,为了能在候选文档中准确地找到与查询句中提及的事件相关的事件范围,每个事件均有相应的事件触发词,在事件查询句中也有事件触发词的情况下,可以将事件触发词作为分类不同事件的依据。例如“Tedros发表新年演讲”事件中的触发词为“biểu”。本文提出一个融入事件实体知识的基于交互的汉越跨语言新闻事件检索模型。对汉语查询句进行翻译后,利用无监督标注方法PredPatt[13]识别查询句与候选文档中的事件触发词划分候选文档事件范围,利用事件实体、事件触发词和多语言知识图谱获得查询句与事件范围中事件实体的语义知识表示。在此基础上,使用基于交互的检索排序模型并融入事件实体的语义知识表示,对查询句和文档进行匹配排序,从而提升模型检索性能。

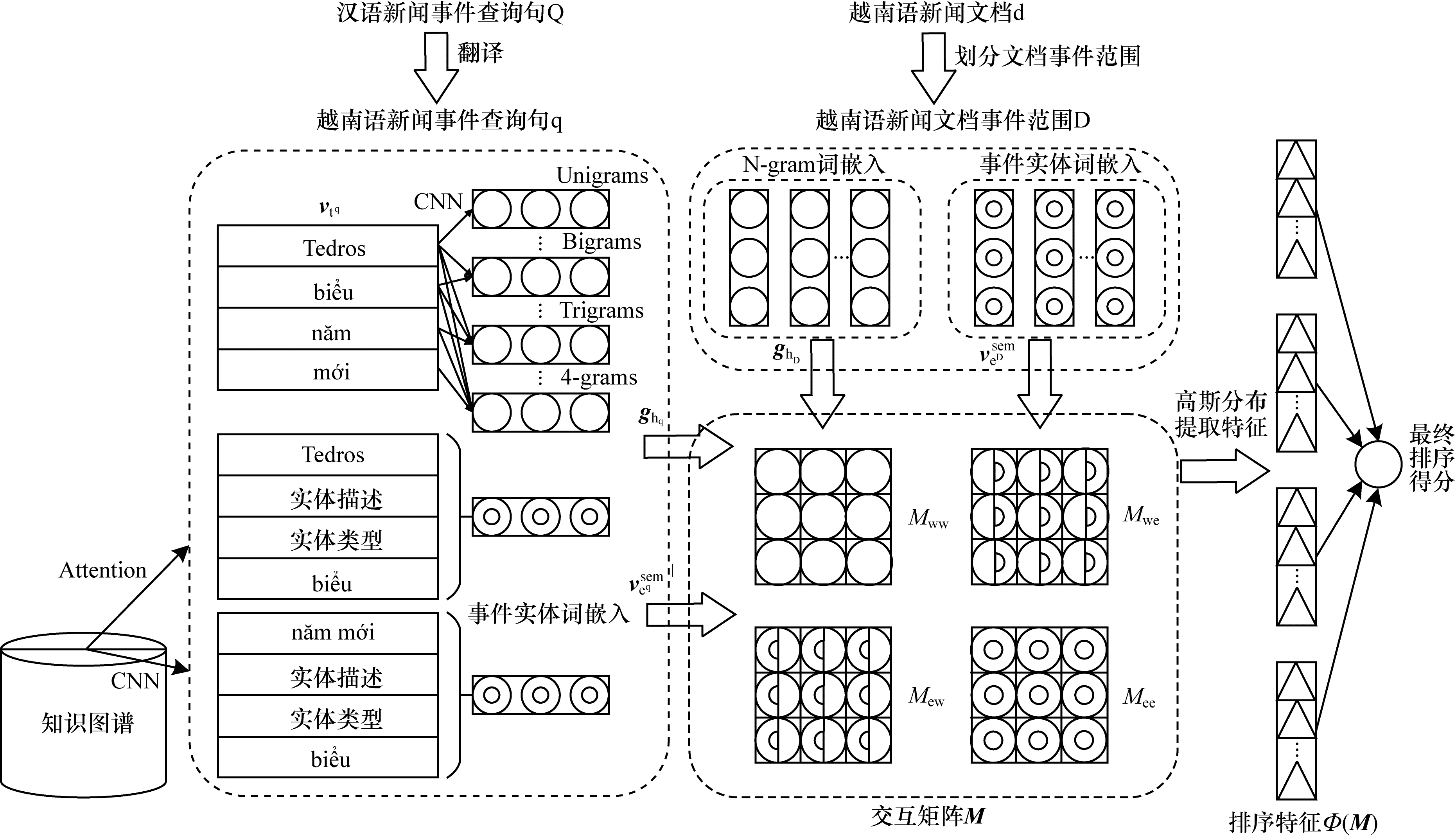

1 本文汉越跨语言新闻事件检索模型 1.1 模型结构本文构建一个融入事件实体知识的汉越跨语言新闻事件检索模型,模型结构如图 1所示。其中,查询句为汉语事件查询句,候选文档为越南语新闻文档。首先将汉语查询句翻译为越南语查询句;然后识别出翻译后的查询句与越南语文档中的事件触发词,并基于文档中的事件触发词对文档划分事件范围;之后使用越南语事件实体识别方法[12]识别出查询句与文档事件范围中的事件实体,进而基于多语言知识图谱和事件触发词对事件实体的语义进行扩充;最后使用基于交互的检索模型框架分别提取查询句中的词和文档事件范围中的词、查询句中的词和文档事件范围中扩充后的事件实体、查询句中扩充后的事件实体和文档事件范围中的词以及查询句中扩充后的事件实体和文档事件范围中扩充后的事件实体交互所产生的排序特征,根据排序特征计算查询句与文档最终的排序得分。

|

Download:

|

| 图 1 融入事件实体知识的汉越跨语言新闻事件检索模型结构 Fig. 1 Structure of Chinese-Vietnamese cross-language news event retrieval model incorporating event entity knowledge | |

汉越跨语言新闻事件检索首先面临的问题是汉越之间存在的语言隔阂对检索造成的阻碍。目前,跨语言新闻事件检索研究中最常用的方法是查询翻译方法,即先使用现有的翻译工具将事件查询句的语言翻译为候选新闻文档所用语言,再利用翻译后的事件查询句进行事件检索。因此,本文通过现有的翻译工具将汉语事件查询句Q翻译为越南语事件查询句q。

1.3 文档事件范围检测单个候选新闻文档中包含多个事件,若对整个文档与事件查询句进行匹配,会产生较大的匹配误差。因此,对于每个文档d,本文使用PredPatt方法识别d中所有的事件触发词

本文利用越南语事件实体识别方法识别出查询句q与文档事件范围D中的事件实体,并在多语言知识图谱ConceptNet[14]中找到其对应的实体类型和实体描述,融入本文模型。事件触发词位于2个实体之间并连接2个事件实体,可以表征事件实体之间的关系。本文使用PredPatt识别出查询句与文档事件范围中的事件触发词,并融入事件触发词本身的语义信息。最终,事件实体的语义表示包含以下4种大小为

1)实体词嵌入

将实体词e通过词嵌入层

| $ {\mathit{\boldsymbol{v}}}_{\mathrm{e}}^{\mathrm{e}\mathrm{m}\mathrm{b}}=\mathrm{E}\mathrm{m}{\mathrm{b}}_{\mathrm{e}}\left(\mathrm{e}\right) $ | (1) |

2)实体描述词嵌入

通过ConceptNet找到实体词e对应的包含

| $ {\mathit{\boldsymbol{g}}}_{\mathrm{e}}^{j}=\mathrm{r}\mathrm{e}\mathrm{l}\mathrm{u}({\mathit{\boldsymbol{W}}}_{\mathrm{C}\mathrm{N}\mathrm{N}}\cdot {\mathit{\boldsymbol{V}}}_{\mathrm{w}}^{j:j+h}+{\mathit{\boldsymbol{b}}}_{\mathrm{C}\mathrm{N}\mathrm{N}}) $ | (2) |

其中:

将卷积后的结果通过最大池化层得到实体描述词向量

| $ {\mathit{\boldsymbol{v}}}_{\mathrm{e}}^{\mathrm{d}\mathrm{e}\mathrm{s}}=\mathrm{m}\mathrm{a}\mathrm{x}({\mathit{\boldsymbol{g}}}_{\mathrm{e}}^{1}, {\mathit{\boldsymbol{g}}}_{\mathrm{e}}^{2}, \cdots , {\mathit{\boldsymbol{g}}}_{\mathrm{e}}^{j}, \cdots , {\mathit{\boldsymbol{g}}}_{\mathrm{e}}^{m}) $ | (3) |

3)实体类型词嵌入

通过ConceptNet发现实体词e隶属于

| $ {\mathit{\boldsymbol{v}}}_{{f}_{j}}=\mathrm{E}\mathrm{m}{\mathrm{b}}_{\mathrm{u}}\left(\mathrm{e}\right) $ | (4) |

然后使用注意力机制将

| $ {\mathit{\boldsymbol{v}}}_{\mathrm{e}}^{\mathrm{t}\mathrm{y}\mathrm{p}\mathrm{e}}=\sum\limits_{j}^{n}{a}_{j}{\mathit{\boldsymbol{v}}}_{{f}_{j}} $ | (5) |

其中:

| $ {a}_{j}=\frac{\mathrm{e}\mathrm{x}\mathrm{p}\left({P}_{j}\right)}{\sum\limits_{l}^{n}\mathrm{e}\mathrm{x}\mathrm{p}\left({P}_{l}\right)}, {P}_{j}=\left(\sum\limits_{i}{\mathit{\boldsymbol{W}}}_{\mathrm{b}\mathrm{o}\mathrm{w}}{\mathit{\boldsymbol{v}}}_{{t}_{i}}\right)\cdot {\mathit{\boldsymbol{v}}}_{{f}_{j}} $ | (6) |

4)触发词嵌入

通过PredPatt方法识别出查询句或文档事件范围中的事件触发词

| $ {\mathit{\boldsymbol{v}}}_{\mathrm{t}\mathrm{r}\mathrm{g}}^{\mathrm{e}\mathrm{m}\mathrm{b}}=\mathrm{E}\mathrm{m}{\mathrm{b}}_{\mathrm{t}\mathrm{r}\mathrm{g}}\left({\mathrm{t}}_{\mathrm{t}\mathrm{r}\mathrm{g}}\right) $ | (7) |

通过线性层对上述4种词嵌入进行融合,得到事件实体最终的语义表示,计算公式如式(8)所示:

| $ {\mathit{\boldsymbol{v}}}_{\mathrm{e}}^{\mathrm{s}\mathrm{e}\mathrm{m}}={\mathit{\boldsymbol{v}}}_{\mathrm{e}}^{\mathrm{e}\mathrm{m}\mathrm{b}}+{\mathit{\boldsymbol{W}}}_{\mathrm{e}}({\mathit{\boldsymbol{v}}}_{\mathrm{e}}^{\mathrm{d}\mathrm{e}\mathrm{s}}\mathrm{\oplus}{\mathit{\boldsymbol{v}}}_{\mathrm{e}}^{\mathrm{t}\mathrm{y}\mathrm{p}\mathrm{e}}\mathrm{\oplus}{\mathit{\boldsymbol{v}}}_{\mathrm{t}\mathrm{r}\mathrm{g}}^{\mathrm{e}\mathrm{m}\mathrm{b}}{)}^{\mathrm{{\rm T}}}+{\mathit{\boldsymbol{b}}}_{\mathrm{e}} $ | (8) |

其中:

本文使用基于交互的检索模型作为融合越南语事件实体知识的模型框架,对于单个查询句q和单个文档事件范围D,基于交互的检索模型通过建立两者之间的词级交互矩阵[16],使用q与D之间的词向量相似度来衡量q与D之间的相似度。

基于交互的排序模型首先将q与D中的每个词

| $ {\mathit{\boldsymbol{v}}}_{\mathrm{t}}=\mathrm{E}\mathrm{m}{\mathrm{b}}_{\mathrm{w}}\left(\mathrm{t}\right) $ | (9) |

然后基于得到的查询词向量和文档词向量生成交互矩阵M,其中每一个元素

| $ {M}^{ij}=\mathrm{c}\mathrm{o}\mathrm{s}({\mathit{\boldsymbol{v}}}_{{\mathrm{t}}_{i}^{\mathrm{q}}}, {\mathit{\boldsymbol{v}}}_{{\mathrm{t}}_{j}^{\mathrm{D}}}) $ | (10) |

本文借鉴XIONG等[17]提出的基于词与实体交互的匹配模型。该模型首先利用词袋模型处理查询句与文档中的词与标注好的实体,然后使用已有的不同排序模型(如BM25[18]、TF-IDF[19]等)分别计算查询词与文档词的排序得分、查询词与文档实体的排序得分、查询实体与文档词的排序得分和查询实体与文档实体的排序得分,最后将这4种排序得分作为特征融入模型,计算最终的查询句与文档的排序得分。然而,该模型的特征提取效果过度依赖于已有的检索排序模型且提取过程繁琐。考虑到这一点,本文在汉越跨语言新闻事件检索这一特定任务中,使用交互矩阵

将q与D中的每个词通过词嵌入层

| $ {\mathit{\boldsymbol{g}}}_{{\mathrm{h}}_{q}}^{i}=\mathrm{r}\mathrm{e}\mathrm{l}\mathrm{u}({\mathit{\boldsymbol{W}}}_{\mathrm{C}\mathrm{N}\mathrm{N}}\cdot {\mathit{\boldsymbol{V}}}_{{\mathrm{T}}^{\mathrm{q}}}^{i:i+{h}_{\mathrm{q}}}+{\mathit{\boldsymbol{b}}}_{\mathrm{C}\mathrm{N}\mathrm{N}}) $ | (11) |

其中:

同理,得到代表长度为

因此,

| $ \begin{array}{l}{M}_{\mathrm{w}\mathrm{w}}^{ij}=\mathrm{c}\mathrm{o}\mathrm{s}({\mathit{\boldsymbol{g}}}_{{h}_{\mathrm{q}}}^{i}, {\mathit{\boldsymbol{g}}}_{{h}_{\mathrm{D}}}^{j}), {M}_{\mathrm{e}\mathrm{e}}^{ij}=\mathrm{c}\mathrm{o}\mathrm{s}({\mathit{\boldsymbol{v}}}_{{\mathrm{e}}_{i}^{\mathrm{q}}}^{\mathrm{s}\mathrm{e}\mathrm{m}}, {\mathit{\boldsymbol{v}}}_{{\mathrm{e}}_{j}^{\mathrm{D}}}^{\mathrm{s}\mathrm{e}\mathrm{m}})\\ {M}_{\mathrm{e}\mathrm{w}}^{ij}=\mathrm{c}\mathrm{o}\mathrm{s}({\mathit{\boldsymbol{v}}}_{{\mathrm{e}}_{i}^{\mathrm{q}}}^{\mathrm{s}\mathrm{e}\mathrm{m}}, {\mathit{\boldsymbol{g}}}_{{h}_{\mathrm{D}}}^{j}), {M}_{\mathrm{w}\mathrm{e}}^{ij}=\mathrm{c}\mathrm{o}\mathrm{s}({\mathit{\boldsymbol{g}}}_{{h}_{\mathrm{q}}}^{i}, {\mathit{\boldsymbol{v}}}_{{\mathrm{e}}_{j}^{\mathrm{D}}}^{\mathrm{s}\mathrm{e}\mathrm{m}})\end{array} $ | (12) |

交互矩阵

| $ {K}_{k}\left({M}_{\mathrm{w}\mathrm{w}}\right)=\sum\limits_{j}exp(-\frac{{M}_{\mathrm{w}\mathrm{w}}^{ij}-{\mu }_{k}}{2{\delta }_{k}^{2}}) $ | (13) |

其中:

将

| $ \mathit{\boldsymbol{ \boldsymbol{\varPhi} }}\left(\mathit{\boldsymbol{M}}\right)=\mathit{\boldsymbol{\varphi }}\left({M}_{\mathrm{1, 1}}\right)\mathrm{\oplus}\cdots \mathrm{\oplus}\mathit{\boldsymbol{\varphi }}\left({M}_{{h}_{\mathrm{q}}, {h}_{\mathrm{D}}}\right)\mathrm{\oplus}\cdots \mathrm{\oplus}\mathit{\boldsymbol{\varphi }}\left({M}_{\mathrm{e}, \mathrm{e}}\right) $ | (14) |

每一个

| $ \mathit{\boldsymbol{\varphi }}\left({M}_{{h}_{\mathrm{q}}, {h}_{\mathrm{D}}}\right)=\mathit{\boldsymbol{\varphi }}\left({M}_{\mathrm{w}{\mathrm{w}}^{{h}_{\mathrm{q}}, {h}_{\mathrm{D}}}}\right)\mathrm{\oplus}\mathit{\boldsymbol{\varphi }}\left({M}_{\mathrm{e}{\mathrm{w}}^{1, {h}_{\mathrm{D}}}}\right)\mathrm{\oplus}\mathit{\boldsymbol{\varphi }}\left({M}_{\mathrm{w}{\mathrm{e}}^{{h}_{\mathrm{q}}, 1}}\right) $ | (15) |

本文在得到最终排序特征

| $ f(\mathrm{q}, \mathrm{D})=\mathrm{t}\mathrm{a}\mathrm{n}\mathrm{h}\left({\mathit{\boldsymbol{\omega }}}_{\mathrm{r}}^{\mathrm{{\rm T}}}\mathit{\boldsymbol{ \boldsymbol{\varPhi} }}\right(\mathit{\boldsymbol{M}})+{\mathit{\boldsymbol{b}}}_{\mathrm{r}}) $ | (16) |

其中:

由于一个文档d中含有

| $ \begin{array}{l}f(\mathrm{q}, \mathrm{d})=\mathrm{m}\mathrm{a}\mathrm{x}\left(\mathrm{t}\mathrm{a}\mathrm{n}\mathrm{h}({\mathit{\boldsymbol{\omega }}}_{\mathrm{r}}^{\mathrm{{\rm T}}}\mathit{\boldsymbol{ \boldsymbol{\varPhi} }}{\left(\mathit{\boldsymbol{M}}\right)}_{x}+{\mathit{\boldsymbol{b}}}_{\mathrm{r}})\right)\\ x\in \{\mathrm{1, 2}, \cdots , f\}\end{array} $ | (17) |

其中,

最后,通过优化如下所示的合页损失函数[24]对模型进行训练:

| $ l=\sum\limits_{\mathrm{q}}\sum\limits_{{\mathrm{d}}^{+}, {\mathrm{d}}^{-}\in {\mathrm{G}}_{\mathrm{q}}^{+, -}}\mathrm{m}\mathrm{a}\mathrm{x}(\mathrm{0, 1}-f(\mathrm{q}, {\mathrm{d}}^{+})+f(\mathrm{q}, {\mathrm{d}}^{-}\left)\right) $ | (18) |

其中:

本文通过反向传播优化模型参数,在此过程中,对实体词词嵌入、实体描述词嵌入、实体类型词嵌入、触发词词嵌入、词级交互和特征提取进行联合学习。

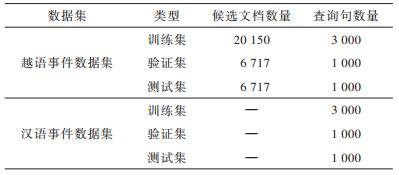

2 实验结果与分析 2.1 实验数据和实验参数设置本文实验使用的汉越双语新闻数据集包含汉语数据集和越南语数据集,其中,汉语数据集用于构建汉语事件查询句,越南语数据集用于构建越南语候选文档。为了对比本文模型在越南语单语新闻事件检索任务和汉越跨语言新闻事件检索任务中的性能差异,利用越南语数据集人工构建与汉语事件查询句数量相同的越南语事件查询句。查询句与文档的相关性标签由人工标注,1表示相关,0表示不相关。实验中用到的汉语和越南语数据集中查询句子数与候选文档数的详细统计信息如表 1所示。

|

下载CSV 表 1 数据集中查询句与候选文档数量 Table 1 Number of query sentences and candidate documents in the data set |

在本文实验中:窗口大小

在实验中使用NDCG[25](Normalized Discounted Cumulative Gain)和MAP[26](Mean Average Precision)作为评价指标。

| $ \mathrm{D}\mathrm{C}\mathrm{G}@k=\sum\limits_{i=1}^{k}\frac{{2}^{{r}_{i}}-1}{\mathrm{l}\mathrm{b}(1+i)} $ | (19) |

| $ \mathrm{N}\mathrm{D}\mathrm{C}\mathrm{G}@k=\frac{\mathrm{D}\mathrm{C}\mathrm{G}@k}{\mathrm{i}\mathrm{d}\mathrm{e}\mathrm{a}\mathrm{l}\mathrm{D}\mathrm{C}\mathrm{G}@k} $ | (20) |

| $ \mathrm{A}\mathrm{P}=\frac{1}{R}\times \sum\limits_{I=1}^{R}\frac{I}{\mathrm{p}\mathrm{o}\mathrm{s}\mathrm{i}\mathrm{t}\mathrm{i}\mathrm{o}\mathrm{n}\left(I\right)} $ | (21) |

其中:k表示k个文档的集合;

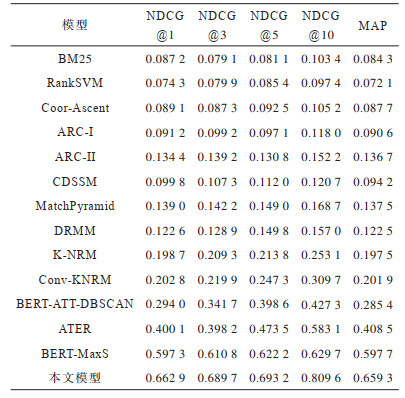

将本文模型与基线模型进行比较,验证本文方法的有效性。基线模型分为基于特征和基于神经网络2类。基于特征的检索模型包括RankSVM[27]和Coor-Ascent[28]2种排序学习模型以及基于词的无监督检索模型BM25;基于神经网络的检索模型包括ARC-I[29]、ARC-II[29]、CDSSM[10]、MatchPyramid[30]、DRMM[31]、K-NRM[32]、Conv-KNRM、BERT-ATT-DBSCAN[33]、ATER[34]和BERT-MaxS[34],其中,ARC-I、CDSSM、BERT-ATT-DBSCAN和ATER是基于表示的检索模型,ARC-II、MatchPyramid、DRMM、K-NRM、Conv-KNRM和BERT-MaxS模型是基于交互的检索模型。

1)RankSVM模型将文档检索排序问题转化为文档对的分类问题,然后针对此分类问题利用SVM模型[35]进行求解。

2)Coor-Ascent是一种用于无约束优化问题的常见优化方法。该模型在检索过程中通过一系列的一维搜索来求解最终的多元目标函数。

3)BM25模型是在融合TF-IDF特征的基础上计算查询句与文档相关性的模型,其先计算每个查询词与文档的相关度,再将得到的所有的词与文档的相关度进行加权求和,最后计算出最终的查询句与文档之间的相关度值。

4)ARC-I模型使用CNN来进行文本匹配,其先将查询句和文档表示成2个定长的向量,再将2个向量拼接成一个向量整体,最后把向量整体输入多层感知器中,多层感知器的输出结果即为查询句与文档的匹配得分。

5)ARC-II模型是ARC-I模型的扩展,其先将查询句与文档表示成向量,利用滑动窗口来选取词向量组,将词向量组作为一个固定单元进行卷积,将卷积后的结果作为查询句与文档相互作用的初步向量表示,再对其进行多次卷积和池化操作,最后将结果送入多层感知器中得到查询句与文档之间的匹配得分。

6)CDSSM模型先将查询句与文档中的每一个词表征为词向量的形式,对设定的滑动窗口内的词向量进行卷积进而生成一个短语向量表示,再对短语向量表示进行池化操作。因为滑动窗口可以动态选取不同词向量,获取到句子中单词顺序信息,所以该模型能够对查询句与文档间的匹配关系进行更完整的描述。

7)MatchPyramid模型构建查询句与文档间的匹配矩阵,使用卷积操作提取匹配矩阵中的特征,进而利用这些特征计算查询句与文档间的相似度。

8)DRMM模型选取查询句中的一个词,将该词与文档中所有的词分别构成词组对,对于每一个词组对,使用余弦距离计算其相似度。该模型利用计算出的不同相似度构建直方图,因而可以有效区分查询句与文档之间相似的程度。

9)K-NRM模型先将查询句和文档转化为向量形式,利用查询句向量和文档向量构建交互矩阵M,再引入K个核函数,通过核函数池化的方式计算查询句与文档的相似程度。

10)Conv-KNRM模型相较于K-NRM模型,在进行核函数池化之前,分别利用滑动窗口对查询句向量和文档向量进行卷积操作,得到新的特征向量。在此基础上,对于查询句和文档的新特征向量,两两进行余弦相似度计算形成交互矩阵M。最后,使用K个核函数池化的方式计算出查询句与文档的相似程度。

11)BERT-ATT-DBSCAN模型先将查询句和文档分别利用加入注意力机制的BERT[36]模型转换为向量形式,再利用DBSCAN聚类算法对查询句向量与文档向量进行聚类得到向量簇,通过计算查询句向量簇与文档向量簇的余弦相似度找到与查询句相关联的文档集合。

12)ATER模型使用BM25算法计算出查询句与文档的相关度值,并使用BERT模型将查询句和文档分别转换为向量形式,利用编码器-解码器架构计算出查询句与文档之间的相关度值。在此基础上,将2种相关度值进行加权求和,得到查询句与文档最终的相关度得分。

13)BERT-MaxS模型使用BM25模型计算查询句与文档的相关度值,并将文档切分为句子集合并分别与查询句进行拼接,使用基于BERT的排序模型计算查询句与每个文档句的相关度值。在此基础上,取最高相关度值与BM25算法计算得出的相关度值进行加权求和,得到查询句与文档最终的相关度得分。

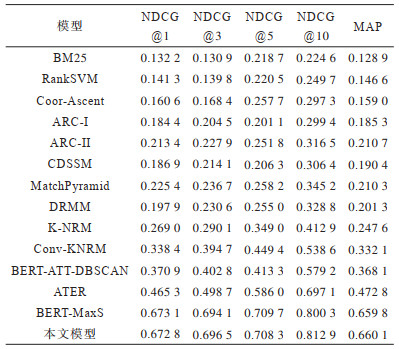

在查询句为越南语事件查询句的情况下,对越南语候选文档进行检索排序。比较本文模型与基线模型在越南语数据集上检索性能的差异,实验结果如表 2所示。

|

下载CSV 表 2 在越南语数据集上的越南语单语新闻事件检索性能 Table 2 Retrieval performance of Vietnamese monolingual news events on Vietnamese data set |

从表 2的对比结果可以看出,本文模型检索性能优于其他检索模型。其中,基于神经网络的检索模型性能均优于基于特征的检索模型,相较于传统的BM25检索模型获得大幅度提升,在NDCG@1、NDCG@3、NDCG@5、NDCG@10和MAP评价指标上分别提升0.540 6、0.565 6、0.489 6、0.588 3和0.531 2。与Conv-KNRM模型相比,本文模型在NDCG@1、NDCG@3、NDCG@5、NDCG@10和MAP评价指标上分别提升98.82%、76.46%、57.61%、50.93%、98.77%,原因是本文在将Conv-KNRM作为检索模型框架的基础上,把事件实体的分布式表示作为外部知识融入排序过程中,不仅进行查询句与文档间词与词之间的匹配,而且增加了查询句与文档之间的词与事件实体的匹配、事件实体与事件实体的匹配,同时利用事件触发词划定文档中的事件范围,缩小了查询句与文档匹配的空间,提升了匹配效率。与基线模型中性能最佳的BERT-MaxS相比,虽然BERT-MaxS在NDCG@1和NDCG@5指标上均略高于本文模型,但该检索模型是基于BERT模型构建的,模型训练所需数据量较大,模型参数较多,完成一次检索过程的时间复杂度较高。

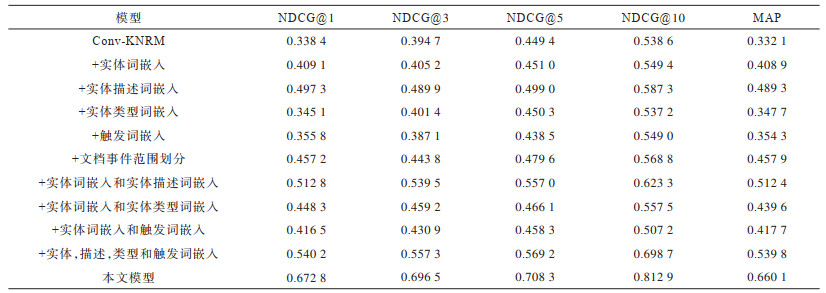

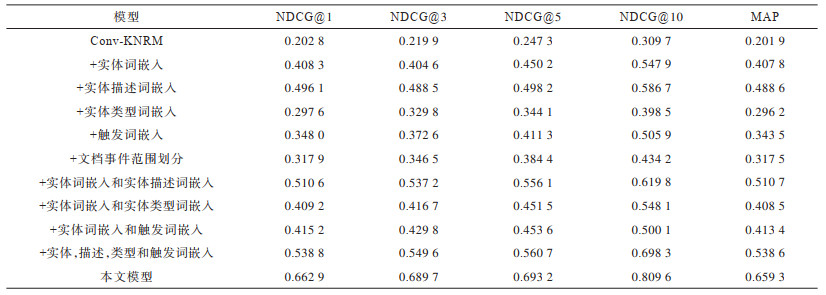

为探究事件实体知识的不同部分对模型检索性能的影响,进行越南语单语新闻事件检索的消融实验,在以下4种情况下对比检索性能:1)检索模型Conv-KNRM;2)在Conv-KNRM基础上分别加入4种词嵌入(实体词嵌入、实体描述词嵌入、实体类型词嵌入和触发词嵌入);3)在Conv-KNRM基础上划分文档事件范围;4)在Conv-KNRM基础上两两加入4种词嵌入。消融实验结果如表 3所示。

|

下载CSV 表 3 在越南语数据集上的消融实验结果 Table 3 Ablation experiment result on Vietnamese data set |

从表 3中可以看出:

1)在4种词嵌入类型中,实体描述词嵌入对于模型检索性能的提升最大,在融入实体描述词嵌入后,模型相较于Conv-KNRM在MAP评价指标上提升了0.157 2。

2)在只融入实体类型词嵌入的情况下,模型相较于Conv-KNRM在MAP评价指标上只提升0.015 6;但是在同时融入实体词嵌入和实体类型词嵌入的情况下,模型相较于Conv-KNRM在MAP评价指标上提升了0.107 5。由此可见,相较于只融入实体类型词嵌入的情况,只有把实体类型词嵌入和其他词嵌入一同融入时,模型性能才得到较大提升。

3)融入4种词嵌入(实体词嵌入、实体类型词嵌入、实体描述词嵌入和触发词嵌入)后模型的MAP评价指标相较于Conv-KNRM提升0.207 7,充分证明了通过知识图谱和事件触发词找到并融合成的事件实体语义表示可以有效提升查询句与文档的匹配性能。

4)在只对文档划分事件范围后,模型的MAP评价指标相较于Conv-KNRM提升0.125 8。

5)相较于同时融入4种词嵌入后的模型,本文模型在NDCG@1、NDCG@3、NDCG@5、NDCG@10和MAP评价指标上均提升较高。由此可见,对文档划分事件范围后,可以缩小模型匹配的空间,大幅提升模型性能。

在查询句为汉语事件查询句的情况下,对越南语候选文档进行检索排序。比较本文模型与基线模型在汉越双语新闻数据集上的检索性能,实验结果如表 4所示。

|

下载CSV 表 4 在汉越双语新闻数据集上的汉越跨语言新闻事件检索性能 Table 4 Retrieval performance of Chinese-Vietnamese cross-language news events on Chinese-Vietnamese bilingual news data set |

从表 4中可以看出:各模型检索性能相较于越南语单语新闻事件检索性能均有所降低。这是因为模型性能受所使用的翻译工具影响,翻译工具的翻译质量不高,会导致翻译生成的越南语事件查询句并不完全符合越南语正常的语法和句式表达。对于所有对比基线模型,翻译生成的越南语事件查询句质量低的情况严重影响了模型的检索性能。相较于只在越南语数据集上的NDCG@1、NDCG@3、NDCG@5、NDCG@10和MAP评价指标:RankSVM分别降低0.067 0、0.059 9、0.135 1、0.152 3和0.074 5;Conv-KNRM分别降低0.135 6、0.174 8、0.202 1、0.228 9和0.130 2;而本文模型性能降低相对较少,分别仅降低0.009 9、0.006 8、0.015 1、0.003 3和0.000 8。这是因为本文模型依赖于使用多语言知识图谱和事件触发词生成事件实体的语义知识表示,进而进行查询句与文档的词与词之间、词与事件实体之间和事件实体与事件实体之间的匹配排序。而事件实体往往可以被翻译工具翻译正确,从而降低了词与事件实体之间和事件实体与事件实体之间的匹配排序误差,因此,本文模型受翻译工具翻译质量的影响较小,能够较好地进行汉越跨语言新闻事件检索排序。

为探索查询句的翻译操作是否会影响事件实体知识的不同部分对模型检索性能所产生的促进作用,在汉越跨语言新闻事件检索时,对本文模型进行消融实验。实验设置与越南语单语新闻事件检索的消融实验设置相同,实验结果如表 5所示。

|

下载CSV 表 5 在汉越双语新闻数据集上的消融实验结果 Table 5 Ablation experiment result on Chinese-Vietnamese bilingual news data set |

从表 5中可以看出:经过查询句翻译之后,事件实体知识的各部分依然可以对模型的检索性能产生促进作用;在4种词嵌入类型中,实体描述词嵌入对于模型检索性能的提升最大,在融入实体描述词嵌入后,本文模型相较于Conv-KNRM在NDCG@1、NDCG@3、NDCG@5、NDCG@10和MAP评价指标上分别提升0.293 3、0.268 6、0.250 9、0.277 0和0.286 7。

3 结束语本文通过融入事件实体知识,提出一种新的汉越跨语言新闻事件检索模型。将汉语查询句翻译为越南语查询句并识别出候选文档中的事件触发词,基于触发词对文档划分事件范围,同时识别查询句中的事件触发词并使用事件实体识别方法识别出事件范围和查询句中的事件实体,基于知识图谱和触发词得到事件实体的知识表示,将事件实体知识融入基于交互的排序学习算法中对候选文档进行排序。实验结果表明,本文模型在汉越双语新闻数据集上相较于对比的基线模型取得了最佳的跨语言新闻事件检索效果。但是本文模型在汉越双语新闻数据集上的检索性能相较于其在越南语数据集上的检索性能有所降低,原因在于模型检索的性能受到所使用翻译工具的翻译性能的限制。同时,其在查询句与文档匹配排序的过程中未考虑查询句中的事件触发词与文档中的事件触发词的歧义对查询句和文档匹配过程所造成的影响。后续将通过融入双语词典或引入双语词向量空间来辅助提升翻译工具的翻译效果,并且探索如何在查询句和文档匹配阶段进行事件触发词消歧,从而进一步提升模型匹配的性能。

| [1] |

GIANG L T, HUNG V T, PHAP H C, et al. Building structured query in target language for Vietnamese-English cross language information retrieval systems[J]. International Journal of Engineering Research and Technolgy, 2015, 4(4): 146-151. |

| [2] |

ELAYEB B, BOUNHAS I. Arabic cross-language information retrieval: a review[J]. ACM Transactions on Asian and Low-Resource Language Information Processing, 2016, 15(3): 1-44. |

| [3] |

RAHIMI R, MONTAZERALGHAEM A, SHAKERY A. An axiomatic approach to corpus-based cross-language information retrieval[J]. Information Retrieval Journal, 2020, 23(3): 191-215. DOI:10.1007/s10791-020-09372-2 |

| [4] |

PASSALIS N, TEFAS A. Entropy optimized feature-based bag-of-words representation for information retrieval[J]. IEEE Transactions on Knowledge and Data Engineering, 2016, 28(7): 1664-1677. DOI:10.1109/TKDE.2016.2545657 |

| [5] |

YAN R, SONG Y, WU H. Learning to respond with deep neural networks for retrieval-based human-computer conversation system[C]//Proceedings of the 39th International ACM SIGIR Conference on Research and Development in Information Retrieval. New York, USA: ACM Press, 2016: 55-64.

|

| [6] |

XIONG C Y, CALLAN J, LIU T Y. Bag-of-entities representation for ranking[C]//Proceedings of 2016 ACM International Conference on the Theory of Information Retrieval. New York, USA: ACM Press, 2016: 181-184.

|

| [7] |

DALTON J, DIETZ L, ALLAN J. Entity query feature expansion using knowledge base links[C]//Proceedings of the 37th International ACM SIGIR Conference on Research and Development in Information Retrieval. New York, USA: ACM Press, 2014: 365-374.

|

| [8] |

LIU X T, FANG H. Latent entity space: a novel retrieval approach for entity-bearing queries[J]. Information Retrieval Journal, 2015, 18(6): 473-503. DOI:10.1007/s10791-015-9267-x |

| [9] |

ENSAN F, BAGHERI E. Document retrieval model through semantic linking[C]//Proceedings of the 10th ACM International Conference on Web Search and Data Mining. New York, USA: ACM Press, 2017: 181-190.

|

| [10] |

SHEN Y L, HE X D, GAO J F, et al. A latent semantic model with convolutional-pooling structure for information retrieval[C]//Proceedings of the 23rd ACM International Conference on Information and Knowledge Management. New York, USA: ACM Press, 2014: 101-110.

|

| [11] |

DAI Z Y, XIONG C Y, CALLAN J, et al. Convolutional neural networks for soft-matching N-grams in ad-hoc search[C]//Proceedings of the 11th ACM International Conference on Web Search and Data Mining. New York, USA: ACM Press, 2018: 126-134.

|

| [12] |

薛振宇, 线岩团, 余正涛, 等. 融合词典与对抗迁移的越南语事件实体识别[J]. 计算机工程, 2022, 48(3): 107-114, 145. XUE Z Y, XIAN Y T, YU Z T, et al. Vietnamese event entity recognition combining dictionary and adversarial transfer[J]. Computer Engineering, 2022, 48(3): 107-114, 145. (in Chinese) |

| [13] |

ZHANG S, RUDINGER R, VAN DURME B. An evaluation of PredPatt and Open IE via stage 1 semantic role labeling[C]//Proceedings of the 12th International Conference on Computational Semantics. Washington D. C., USA: IEEE Press, 2017: 1-5.

|

| [14] |

RODOSTHENOUS C, LYDING V, SANGATI F, et al. Using crowdsourced exercises for vocabulary training to expand conceptnet[C]//Proceedings of the 12th Language Resources and Evaluation Conference. Marseille, France: European Language Resources Association, 2020: 307-316.

|

| [15] |

ZHANG Y, JIN R, ZHOU Z H. Understanding bag-of-words model: a statistical framework[J]. International Journal of Machine Learning and Cybernetics, 2010, 1(1/2/3/4): 43-52. |

| [16] |

陈鑫, 李伟康, 洪宇, 等. 面向问句复述识别的多卷积自交互匹配方法研究[J]. 中文信息学报, 2019, 33(10): 99-108, 118. CHEN X, LI W K, HONG Y, et al. A multi-convolution self-interaction method for question paraphrase identification[J]. Journal of Chinese Information Processing, 2019, 33(10): 99-108, 118. (in Chinese) |

| [17] |

XIONG C Y, CALLAN J, LIU T Y. Word-entity duet representations for document ranking[C]//Proceedings of the 40th International ACM SIGIR Conference on Research and Development in Information Retrieval. New York, USA: ACM Press, 2017: 763-772.

|

| [18] |

KADHIM A I. Term weighting for feature extraction on Twitter: a comparison between BM25 and TF-IDF[C]//Proceedings of International Conference on Advanced Science and Engineering. Washington D. C., USA: IEEE Press, 2019: 124-128.

|

| [19] |

KIM S W, GIL J M. Research paper classification systems based on TF-IDF and LDA schemes[J]. Human-Centric Computing and Information Sciences, 2019, 9(1): 1-21. DOI:10.1186/s13673-018-0162-5 |

| [20] |

CAO S, LU W, ZHOU J, et al. cw2vec: learning Chinese word embeddings with stroke n-gram information[C]//Proceedings of the AAAI Conference on Artificial Intelligence. [S. l. ]: AAAI Press, 2018: 5053-5061.

|

| [21] |

HOFSTÄTTER S, REKABSAZ N, EICKHOFF C, et al. On the effect of low-frequency terms on neural-IR models[C]//Proceedings of the 42nd International ACM SIGIR Conference on Research and Development in Information Retrieval. New York, USA: ACM Press, 2019: 1137-1140.

|

| [22] |

SUN Y F. A comparative evaluation of string similarity metrics for ontology alignment[J]. Journal of Information and Computational Science, 2015, 12(3): 957-964. DOI:10.12733/jics20105420 |

| [23] |

杨晋吉, 胡波, 王欣明, 等. 一种知识图谱的排序学习个性化推荐算法[J]. 小型微型计算机系统, 2018, 39(11): 2419-2423. YANG J J, HU B, WANG X M, et al. Personalized recommendation algorithm for learning to rank by knowledge graph[J]. Journal of Chinese Computer Systems, 2018, 39(11): 2419-2423. (in Chinese) |

| [24] |

RAZZAK I, KHAN T M. One-class support tensor machines with bounded hinge loss function for anomaly detection[C]//Proceedings of International Joint Conference on Neural Networks. Washinton D. C., USA: IEEE Press, 2020: 1-8.

|

| [25] |

JIN X B, GENG G G, XIE G S, et al. Approximately optimizing NDCG using pair-wise loss[J]. Information Sciences, 2018, 453: 50-65. DOI:10.1016/j.ins.2018.04.033 |

| [26] |

GROS D, HABERMANN T, KIRSTEIN G, et al. Anaphora resolution: analysing the impact on mean average precision and detecting limitations of automated approaches[J]. International Journal of Information Retrieval Research, 2018, 8(3): 33-45. DOI:10.4018/IJIRR.2018070103 |

| [27] |

PENG L, LU G Q. Research on query term expansion based on RankSVM and LDA model[J]. Journal of Physics: Conference Series, 2020, 1684(1): 1-10. |

| [28] |

SAYED M F, OARD D W. Jointly modeling relevance and sensitivity for search among sensitive content[C]//Proceedings of the 42nd International ACM SIGIR Conference on Research and Development in Information Retrieval. New York, USA: ACM Press, 2019: 615-624.

|

| [29] |

HU B, LU Z, LI H, et al. Convolutional neural network architectures for matching natural language sentences[C]//Proceedigns of NIPS'14. Montreal, Canada: Neural Information Processing Systems Foundation, 2014: 2042-2050.

|

| [30] |

TANG Z L, LI J. Jointly considering Siamese network and MatchPyramid network for text semantic matching[J]. IOP Conference Series: Materials Science and Engineering, 2019, 490: 1-10. |

| [31] |

GUO J F, FAN Y X, AI Q Y, et al. A deep relevance matching model for ad-hoc retrieval[C]//Proceedings of the 25th ACM International Conference on Information and Knowledge Management. New York, USA: ACM Press, 2016: 55-64.

|

| [32] |

XIONG C Y, DAI Z Y, CALLAN J, et al. End-to-end neural ad-hoc ranking with kernel pooling[C]//Proceedings of the 40th International ACM SIGIR Conference on Research and Development in Information Retrieval. New York, USA: ACM Press, 2017: 55-64.

|

| [33] |

曹旭友, 周志平, 王利, 等. 基于BERT+ATT和DBSCAN的长三角专利匹配算法[J]. 信息技术, 2020, 44(3): 1-5, 12. CAO X Y, ZHOU Z P, WANG L, et al. Yangtze River delta patent matching algorithm based on BERT+ATT and DBSCAN[J]. Information Technology, 2020, 44(3): 1-5, 12. (in Chinese) |

| [34] |

胡澔. 基于BERT的神经排序模型研究[D]. 武汉: 华中师范大学, 2020. HU H. Research on BERT-based neural ranking models[D]. Wuhan: Central China Normal University, 2020. (in Chinese) |

| [35] |

周艳平, 李金鹏, 宋群豹. 一种基于SVM及文本密度特征的网页信息提取方法[J]. 计算机应用与软件, 2019, 36(10): 251-255, 261. ZHOU Y P, LI J P, SONG Q B. A Web page information extraction method based on SVM and text density features[J]. Computer Applications and Software, 2019, 36(10): 251-255, 261. (in Chinese) |

| [36] |

DEVLIN J, CHANG M W, LEE K, et al. BERT: pre-training of deep bidirectional transformers for language understanding[EB/OL]. [2021-06-10]. https://arxiv.org/abs/1810.04805.

|

2022, Vol. 48

2022, Vol. 48