b. 大连大学 通信与网络重点实验室, 辽宁 大连 116622

b. Key Laboratory of Communication and Network, Dalian University, Dalian, Liaoning 116622, China

在未来空战中, 无人机(Unmanned Aerial Vehicle, UAV)集群作战将是重要的作战形式之一, 针对其高动态、网络拓扑结构多变等特性, 采用分布式网络结构可提高无人机集群网络的抗毁性。此外, 实现信息安全、可靠传输是其完成任务的关键, 确保无人机之间的可靠通信, 将成为一项重要的研究内容[1]。

近年来, 如何有效对抗智能性干扰与提高通信安全已成为研究热点[1]。在抗干扰技术研究中, 认知抗干扰算法已成为研究热点方向之一[2], 该算法可归纳为如下两类:一类是基于强化学习理论[3]进行可用信道的选择, 主动规避干扰信道, 从而实现频域抗干扰。文献[4]提出基于协作Q学习(Q-Learning, QL)的信道选择算法, 该算法可提高数据传输成功率, 但当状态空间规模较大时, 其面临维数灾难的问题[5-6]。针对该问题, 文献[7]提出将深度Q网络(DQN)在线学习算法应用于信道选择。当信道数量较多时, 文献[8-9]利用演员-评论家(Actor-Critic, AC)算法进行信道选择, 但是该算法存在方差较大以及稳定性较差的问题。另一类是基于博弈论的方法[10-12], 根据敌我双方的竞争关系, 建立功率域抗干扰博弈模型, 通过求解博弈均衡得到最佳传输功率, 实现从功率上压制干扰信号以达到抗干扰的目的。以上算法均是仅从单个频域或者功率域角度考虑, 针对智能性干扰攻击的灵活性较差[13]。

为提高网络抗智能干扰的能力, 本文将功率域和频域抗干扰方法相结合, 基于优势演员-评论家(Advantage Actor-Critic, A2C)[14]与Stackelberg博弈(Stackelberg Game, SG), 提出一种多域联合认知抗干扰(Multiple Domain Joint Cognitive Anti-Jamming, MDJC-AJ)算法。该算法将可用信道探索问题转化为序贯决策问题, 由感知到的环境频谱状态进行信道选择。根据设定的干扰容忍双阈值将信道干扰程度分为严重、中度与轻微3个等级, 并对处于中度干扰等级的信道建立功率域斯塔克伯格博弈模型, 通过求解博弈均衡得到最佳传输功率。与此同时, 本文采用簇头协助决策方式来协助簇内信道决策成功率较低的节点, 以提高网络整体感知环境的准确性与干扰信道决策成功率。

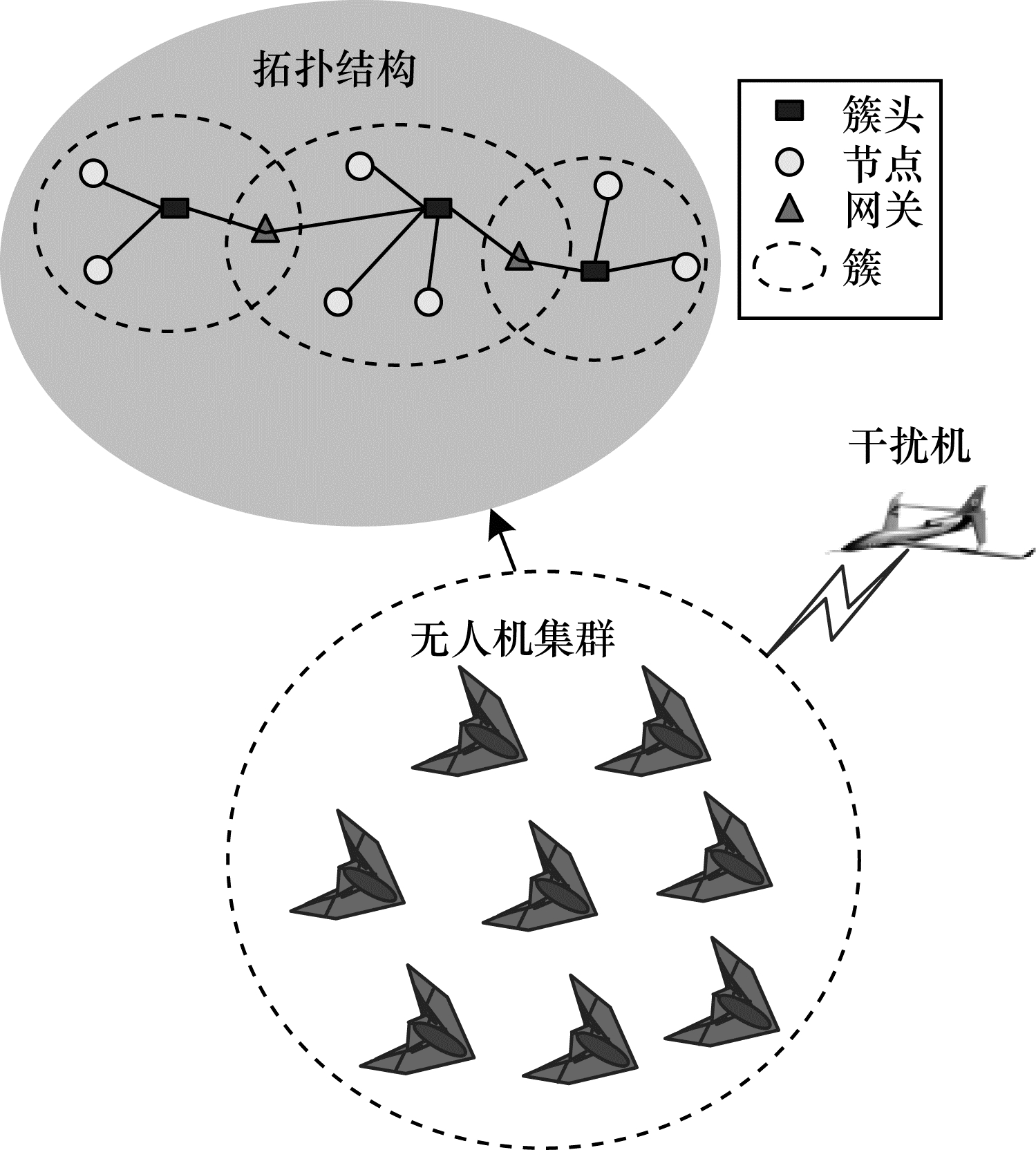

1 无人机集群网络模型无人机集群网络采用层次结构的移动Ad-Hoc网络, 当无人机的数量大于6架时, 适合采用分层式结构[15]。无人机集群网络对抗智能干扰机示意图如图 1所示。

|

Download:

|

| 图 1 无人机集群网络对抗智能干扰机示意图 Fig. 1 Schematic diagram of UAV cluster network resist intelligent jammer | |

假设网络中干扰机为J, 干扰机个数为1, 节点总数为NS, 分簇数M=NS/NC, NC为簇内节点个数, 节点i的簇内邻节点个数C-i⊂ΩS, 其中, ΩS为网络节点集合。假设簇头具有较高的等级, 数据处理能力最强, 其在簇内则充当局部控制中心的角色, 簇间节点通过所在簇的簇头转发数据进行通信。

2 多域联合认知抗干扰算法 2.1 基于A2C的频域抗干扰算法信道选择过程可建模为马尔可夫决策过程[16], 由四元组(S, A, R, λ)来描述, 其中, S为状态空间, A为动作空间, 累计奖励函数

在t时刻, 且无干扰机时, 节点i接收信号的信干噪比(Signal to Interference-plus Noise Ratio, SINR)为γNJ(t), 存在干扰机时, SINR为γYJ(t), 可表示为:

| $ {{\gamma _{NJ}}(t) = \frac{{g_S^iP_S^i(t)}}{{P_S^{ - i}(t) + \varepsilon }}} $ | (1) |

| $ {{\gamma _{YJ}}(t) = \frac{{g_S^i(t)P_S^i(t)}}{{{g_J}(t){P_J}(t) + P_S^{ - i}(t) + \varepsilon }}} $ | (2) |

其中, PSi(t)为节点i的传输功率, PJ(t)为干扰机J的干扰功率, gSi(t)、gJ分别为节点i和干扰机J的信道增益,

假设网络通信总带宽为W, 将其均分为K个子信道b, 则有

| $ {{r_S}(t) = {{\tilde b}_k}(t){\rm{lb}}(1 + {\gamma _{NJ}}(t))} $ | (3) |

| $ {r_J^i(t) = {{\tilde b}_k}(t){\rm{lb}}(1 + {\gamma _{YJ}}(t))} $ | (4) |

其中,

抗干扰通信的目标是确保信息安全以及可靠传输, 将即时奖励Rt定义为通信安全容量Cseci[17], 可表示为:

| $ C_{{\rm{sec}}}^i = {[r_S^i(t) - r_J^i(t)]^ + } $ | (5) |

其中, [·]+=max{0, ·}, 即时奖励Rt=Cseci。

2.1.2 状态空间与动作空间假设环境状态空间S为节点i的前一时刻感知频谱 bt-1, 则时刻t的状态st可表示为:

| $ {s_t} = {\mathit{\boldsymbol{b}}_{t - 1}},{s_t} \in S $ | (6) |

节点根据观测状态st和即时奖励Rt进行信道选择, 将动作空间定义为可选信道, 则有A={1, 2, …, K}, 且其对应于信道索引。信道选择过程可描述为:在t时刻, 节点由状态st选择信道at=k∈A, 并获得即时奖励Cseci。

2.1.3 基于优势演员-评论家的频域抗干扰算法AC算法是由行动者(Actor)与评论家(Critic)组成的强化学习算法, 其中, Actor负责更新策略, Critic负责更新动作值函数。与AC算法相比, A2C算法通过引入基线能够降低学习过程中的方差, 以较准确的动作值指导策略更新, 可带来更好的求解效果。在实际应用中真实价值很难得到, 一般采用函数近似法对价值和动作函数进行参数化, 利用神经网络等机器学习算法求解, 求解过程如下:

1) 对于Critic而言, 其目标是通过不断地更新参数θ, 使得值函数Vθ(s)更加逼近真实的累计奖励值Cseci(s), 即:

| $ {\theta ^*} = \mathop {{\rm{ argmin }}}\limits_\theta \left\{ {\frac{1}{2}{{(C_{{\rm{sec}}}^i + \lambda C_{{\rm{sec}}}^i({s^\prime }) - {V_\theta }(s))}^2}} \right\} $ | (7) |

2) 对于Actor而言, 其目标是通过不断地更新参数w, 使得其尽可能得到好的策略πw(s, a), 即:

| $ {w^*} = \mathop {{\rm{ argmax }}}\limits_w \left\{ {\sum\limits_{s \in S} d (s)\sum\limits_{a \in A} {{\pi _w}} (s,a)C_{{\rm{sec}}}^i(s)} \right\} $ | (8) |

其中, d(s)对应起始状态s。

3) 在每一步更新中, Actor根据当前状态s和策略πw(s, a), 执行动作a并转到下一状态s′, 得到即时奖励Cseci。Critic根据真实奖励和之前标准下的评分Cseci+λCseci(s′)来修正评价标准, 使得估计价值更加逼近真实奖励值。

为增加模型探索能力, 在模型目标函数中加入策略的熵正则化项, 其可衡量概率策略分布的不确定性, 且其值越大说明模型具有更好的多样性[18-19]。Actor网络的参数w基于策略梯度下降的计算方法为:

| $ \begin{array}{l} w \leftarrow w + \alpha \sum\limits_t {{\nabla _w}} {\rm{lb}} {\pi _w}(s,a)\underbrace {(C_{{\rm{sec}}}^i(s) - {V_\theta }(s))}_{{\rm{优势函数的估计}}} + \\ {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} \eta {E_s}[{\nabla _w}{H^\pi }(s)] \end{array} $ | (9) |

其中,

| $ \theta \leftarrow \theta + \beta \sum\limits_t \partial \left[ {\frac{1}{2}{{(C_{{\rm{sec}}}^i(s) - {V_\theta }(s))}^2}} \right]/\partial \theta $ | (10) |

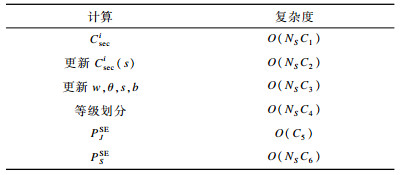

通过A2C算法决策出各信道干扰情况后, 根据给定信道干扰容忍双阈值PJth1sec与PJth2sec将干扰功率划分为严重、中度与轻微3个等级, 信道干扰等级判定规则如表 1所示。

|

下载CSV 表 1 信道干扰等级判定规则 Table 1 Decision rule of channel jamming level |

在2.1节的基础上, 当上一时刻所用信道在当前时刻被判决为等级2时, 则对该信道建立功率域SG模型, 并通过求解Stackelberg均衡(Stackelberg Equilibrium, SE)得到最佳传输功率, 实现功率域抗干扰。

假设网络中的节点为领导者, 干扰机为跟随者, 参与者的行动受功率约束。定义博弈模型为Gs, j=〈{ΩS, J}, {PS, PJ}, {US, UJ}〉, 其中, PS和PJ分别为节点和干扰机的传输功率, US与UJ分别为节点与干扰机的效用函数。以节点作为领导者, 并假定其可精确估计出干扰功率, 而干扰机对节点的功率估计存在观测误差[10], 且观测误差为

| $ U_S^i(P_S^i,P_S^{ - i},{P_J}) = {\gamma _{YJ}} - L_S^iP_S^i $ | (11) |

其中, LSiPSi为节点i的通信代价。

干扰机J的效用函数可表示为:

| $ {U_J}(P_S^i,P_S^{ - i},{P_J}) = - {\hat \gamma _{YJ}} + L_S^i\hat P_S^i - {L_J}{P_J} $ | (12) |

其中, LJPJ为干扰代价,

求解SE是博弈理论的重要内容。当处于SE状态时, 节点可得到保证本身损失最小的传输功率, 而干扰机可得到最佳的干扰功率。本文利用逆向归纳法求解SE, 并定义功率约束下的SE为(PSSE, PJSE), 且PSSE、PJSE分别表示为:

| $ {P_S^{{\rm{SE}}} = \mathop {{\rm{ arg}}{\kern 1pt} {\rm{max }}}\limits_{0 \le {P_S} \le P_S^{{\rm{Max}}}} {U_S}(P_S^i,P_S^{ - i},{P_J})} $ | (13) |

| $ {P_J^{{\rm{SE}}} = \mathop {{\rm{arg}}{\kern 1pt} {\rm{max}}}\limits_{0 \le {P_J} \le P_J^{{\rm{Max}}}} {U_J}(\hat P_S^i,\hat P_S^{ - i},{P_J})} $ | (14) |

其中, PSMax、PJMax分别为节点最大传输功率与干扰机最大干扰功率, PSSE、PJSE分别为节点最佳传输功率与干扰机最佳干扰功率。

PJSE的求解过程如下:

1) 考虑一般情况, 基于式(12),

2) 考虑极端情况, 有以下2种情况:

(1) 相比阻断节点间的信息传输, 干扰机本身的损失更低, 此时干扰机的PJSE=PJMax。

(2) 相比阻断节点间的信息传输, 干扰机本身的损失更大, 此时PJSE=0, 则求得PJSE为:

| $ P_J^{{\rm{SE}}} = \left\{ {\begin{array}{*{20}{l}} {0,\hat P_S^i \le {L_J}(\hat P_S^{ - i} + {\varepsilon ^2})/(g_S^i{g_J})}\\ {P_J^{{\rm{Max}}},\hat P_S^i \ge {L_J}{{(P_J^{{\rm{Max}}}{g_J} + \hat P_S^{ - i} + \varepsilon )}^2}/(g_S^i{g_J})}\\ {{{\hat P}_J} = \left( {\sqrt {g_S^i{g_J}P_S^i/{L_J}} - \varepsilon - \hat P_S^{ - i}} \right)/{g_J},{\rm{ 其他 }}} \end{array}} \right. $ | (15) |

PSSE的求解过程如下:

假设对节点i而言, 其认为干扰机的观测不存在误差, 即

| $ \begin{array}{l} {U_S}\left( {P_S^i,P_S^{ - i},{P_J}} \right) = \\ \left\{ \begin{array}{l} \frac{{g_S^i}}{{\left( {\varepsilon + P_S^{ - i}} \right)}} - L_S^i,P_S^i \le \frac{{{\varepsilon ^2} + P_S^{ - i}}}{{g_S^i{g_J}}}\\ \left( {\frac{{g_S^i}}{{P_J^{{\rm{Max}}}{g_J} + P_S^{ - i} + \varepsilon }} - L_S^i} \right)P_S^i,P_S^i \ge \frac{{{L_J}{{\left( {P_J^{{\rm{Max}}}{g_J} + P_S^{ - i} + \varepsilon } \right)}^2}}}{{\left( {g_S^i{g_J}} \right)}}\\ \sqrt {\frac{{g_S^iP_S^i{L_J}}}{{{g_J}}}} - L_S^iP_S^i,{\rm{ 其他 }} \end{array} \right. \end{array} $ | (16) |

假设函数

1) LSi>gSi/(ε+PS-i):US(PSi, PS-i, PJ)关于PSi递减, 此时PSSE=0。

2)

3)

| $ P_S^{{\rm{SE}}} = \left\{ {\begin{array}{*{20}{l}} {0,L_S^i > \frac{{g_S^i}}{{\varepsilon + P_S^{ - i}}}}\\ {\frac{{g_S^i{L_J}}}{{4{g_J}L{{_S^i}^2}}}\frac{{g_S^i}}{{\varepsilon + P_S^{ - i} + P_J^{{\rm{Max}}}}} < L_S^i < \frac{{g_S^i}}{{\varepsilon + P_J^{{\rm{Max}}}}}}\\ {P_S^{{\rm{Max}}},L_S^i < \frac{{g_S^i}}{{\varepsilon + P_S^{ - i} + P_J^{{\rm{Max}}}}}} \end{array}} \right. $ | (17) |

综上所述, 本文提出的MDJC-AJ算法实现过程描述如下:

输入 训练数据

输出 最优策略的估计πθ*, 接收信号的信干噪比γ

1) 初始化。Cseci(0)=0, 最大迭代次数Nit, 网络参数θ←0, w←0, 学习率α与β, 折扣因子λ, 熵正则化系数η, 干扰容忍阈值PJth1sec与PJth2sec。

2) 迭代更新。对每个智能体(节点/簇头), 每幕执行以下操作:

(1) 采样:根据状态s和动作b得到采样值Cseci和下一个状态s′, 数据存储E←{s, b, Cseci, s′}。

(2) 执行:利用πθ(·|s′)得到动作b′。

(3) 通信安全容量:Cseci(s)←Cseci+λCseci(s′)。

(4) 策略更新:基于式(9), 更新策略网络参数w。

(5) 价值更新:基于式(10), 更新策略网络参数θ。

(6) 更新状态与动作:s←s′, b←b′。

(7) 信道选用策略:判断前一时刻被选信道在当前时刻的干扰等级, 当等级为3时, 最佳传输功率为0, 奖励函数Cseci(s)=0时, 则转至(1)采样操作; 当等级为2时, 建立功率域博弈模型, 由式(17)得到最佳传输功率; 当等级为1时, 则保持使用当前信道。

3) 直至达到最大迭代次数Nit, 结束。

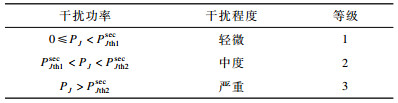

2.3 算法复杂度分析参考文献[12], 本文对MDJC-AJ算法的复杂度进行分析, 结果如表 2所示。

|

下载CSV 表 2 MDJC-AJ算法复杂度分析 Table 2 Complexity analysis of MDJC-AJ algorithm |

本文算法的运算复杂度分析描述如下:

1) 对于单个节点i或簇头, 获得观测状态和得到采样值Cseci的复杂度为O(Ci), C1为与采样过程相关的常数, 所有的节点运算复杂度为O(NSC1), 该部分对应算法迭代更新中的步骤1。

2) 对于单个节点, 根据策略πθ(·|s′), 在每个状态下执行相应动作得到奖励值的复杂度为O(C2), C2为与策略类型相关的常数, 所有节点的运算复杂度为O(NSC2), 该部分对应算法迭代更新中的步骤2、步骤3。

3) 对于单个节点, 基于式(9)、式(10), 更新参数w、θ以及状态s、动作b, 运算复杂度为O(C3), C3为与每幕的时间步长或收敛迭代次数相关的常数, 所有节点的运算复杂度为O(NSC3), 该部分对应算法迭代更新中的步骤4~步骤6。

4) 对于单个节点, 根据阈值进行等级划分, 运算复杂度为O(C4), C4为与阈值个数相关的常数, 所有节点的运算复杂度为O(NSC4)。

5) 干扰机最佳干扰功率运算复杂度为O(C5), C5为与式(15)相关的常数。

6) 对单个节点, 根据式(17)计算节点最佳传输功率运算复杂度为O(C6), C6为常数, 所有节点的运算复杂度为O(NSC6)。

通过以上分析, 可得到MDJC-AJ算法的总运算复杂度为:

| $ \begin{array}{*{20}{l}} {{C_{{\rm{ sum }}}} = {N_{it}}(O({N_S}{C_1}) + O({N_S}{C_2}) + O({N_S}{C_3}) + }\\ {{\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} O({N_S}{C_4}) + O({C_5}) + O({C_6}))} \end{array} $ | (18) |

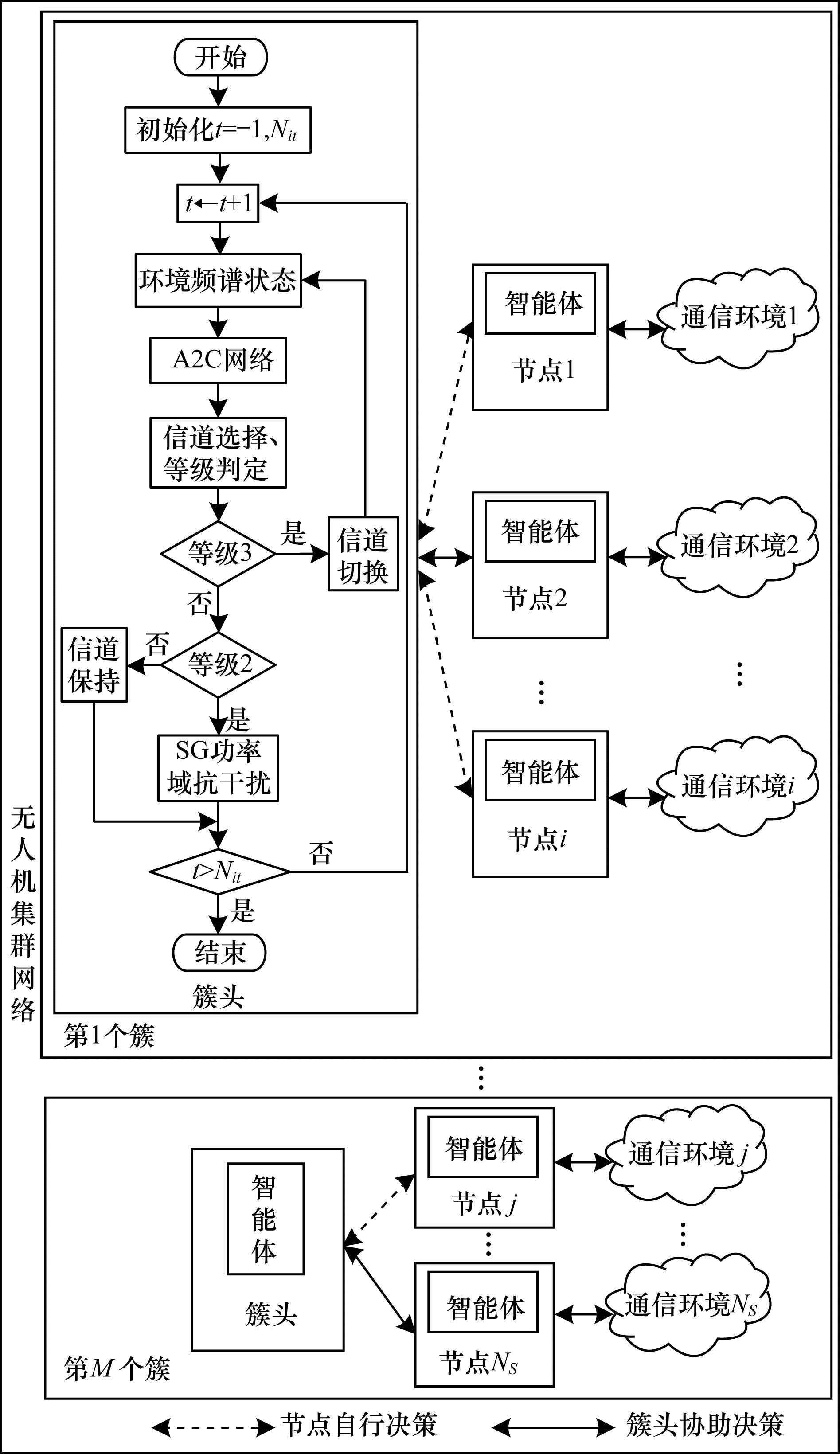

由于实际环境态势的多变性以及信息的局部性, 存在单个节点局部频谱感知能力有限的问题, 为此引入簇头协助从节点决策方法。基于簇头协助的无人机集群网络抗干扰示意图如图 2所示。

|

Download:

|

| 图 2 基于簇头协助的无人机集群网络抗干扰示意图 Fig. 2 Schematic diagram of UAV cluster network anti-jamming based on cluster head assistance | |

簇头协助从节点决策方法可描述为:各节点进行局部环境感知与信道决策时, 若某节点所得结果无法达到期望值, 则向簇头发出Help信息, 簇头收到求助信息后, 则向其传输无干扰信道数据信息, 使其能够进行可靠通信。需要说明的是, 所有节点和簇头均采用MDJC-AJ算法进行抗干扰。为了不失一般性, 图 2中仅详细说明第一个簇头内部抗干扰算法的实现流程。

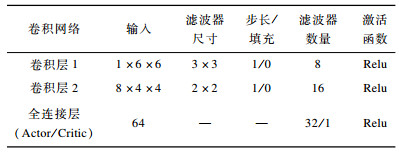

3 实验仿真与分析为验证本文所提算法的有效性, 实验选用卷积神经网络来拟合值函数和策略函数。仿真环境为Intel®CoreTM i7-4790 CPU@3.60 GHz四核八线程处理器, 采用Pytorch1.2.0深度学习框架与Matlab2018a仿真平台。

仿真条件设置为:每幕训练时长T=5 000, 每个时间步长Δt=0.1 s, 每100幕为一个训练周期, 总共设有10个仿真周期, 经验池容量大小为E=10 000。设定信道个数K=32, 并将状态空间重塑为6×6的排列作为网络输入。为确保Critic有足够的时间计算奖励值, Critic网络学习率β=0.02, Actor网络学习率α=0.005, 惩罚系数η=0.3, 干扰功率阈值PJth1sec=0.5、PJth2sec=6。

Actor网络与Critic网络基本一致, 不同的是最后的全连接层[20]。Actor网络输出维度为32×1, 对应32个待选信道, Critic的输出维度为1, 用于计算Actor所获奖励。网络结构参数设置如表 3所示。

|

下载CSV 表 3 网络结构参数设置 Table 3 Parameter setting of network structure |

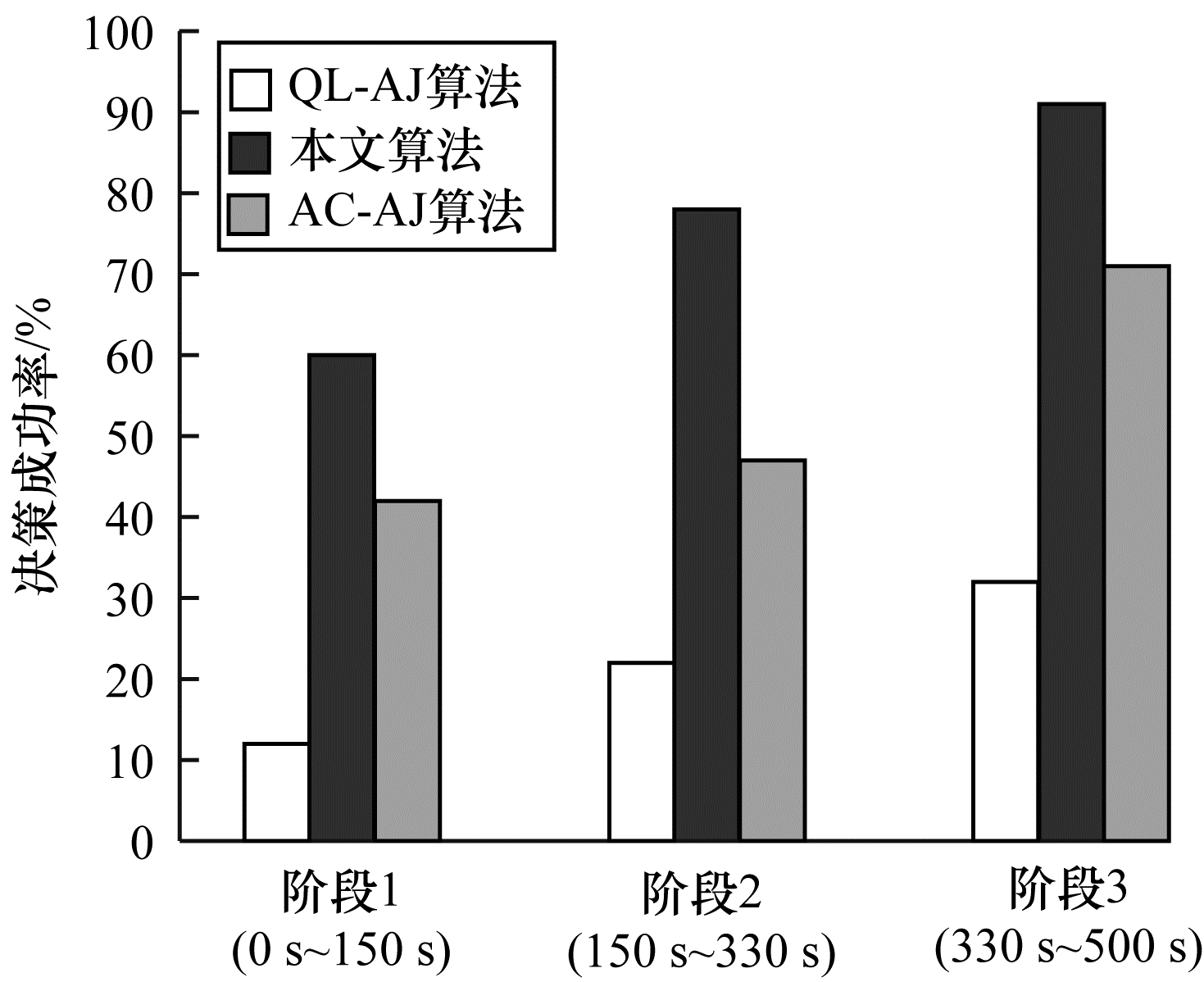

仿真1 为验证本文所提算法的信道选择性能, 考虑干扰机采用智能性干扰, 即不同时间段干扰机干扰的信道和功率均不同, 为便于分析将环境状态的时变点分别设在tchange=1 500和tchange=3 300, 网络中节点个数为4, 编队及所选簇头已最优。实验对文献[4]Q学习抗干扰(QL-AJ)算法、文献[8]演员-评论家抗干扰(AC-AJ)算法与本文算法的信道干扰情况决策成功率进行比较, 结果如图 3所示。从图 3可以看出, 在各个阶段内, 相比QL-AJ算法与AC-AJ算法, 本文所提MDJC-AJ算法的信道干扰情况决策成功率更高。

|

Download:

|

| 图 3 3种算法的干扰信道情况决策成功率 Fig. 3 Channel decision success rate of jamming situation with three algorithms | |

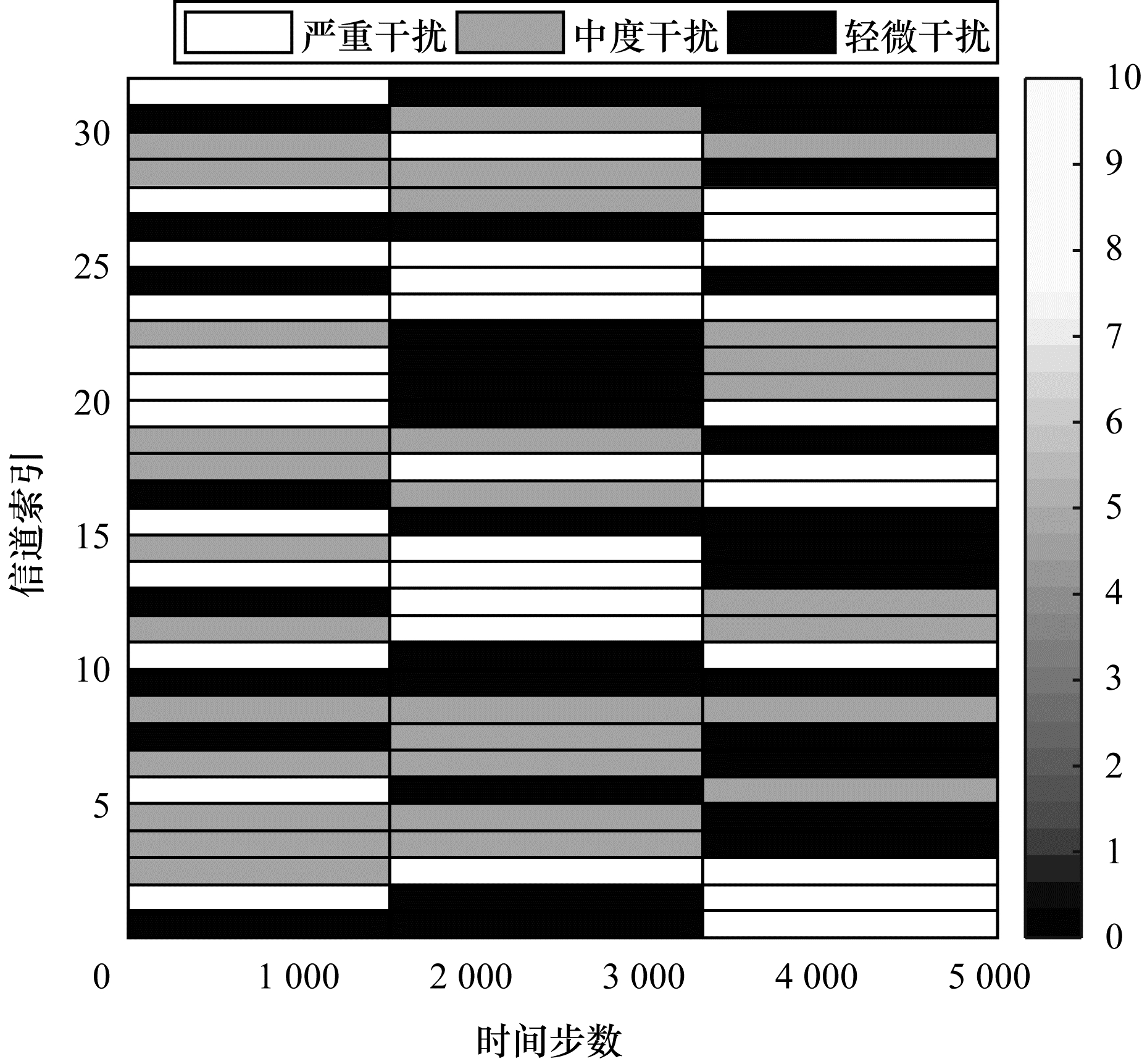

为进一步说明MDJC-AJ算法在智能性干扰情况下信道决策有效性, 由仿真所得信道干扰情况判决结果, 如图 4所示。从图 4可以看出, MDJC-AJ算法在决策出可用信道索引情况下, 对信道干扰功率情况进行判决, 可为功率域抗干扰提供依据。

|

Download:

|

| 图 4 MDJC-AJ算法对信道干扰情况判定结果 Fig. 4 Decision result of channel jamming situation by MDJC-AJ algorithm | |

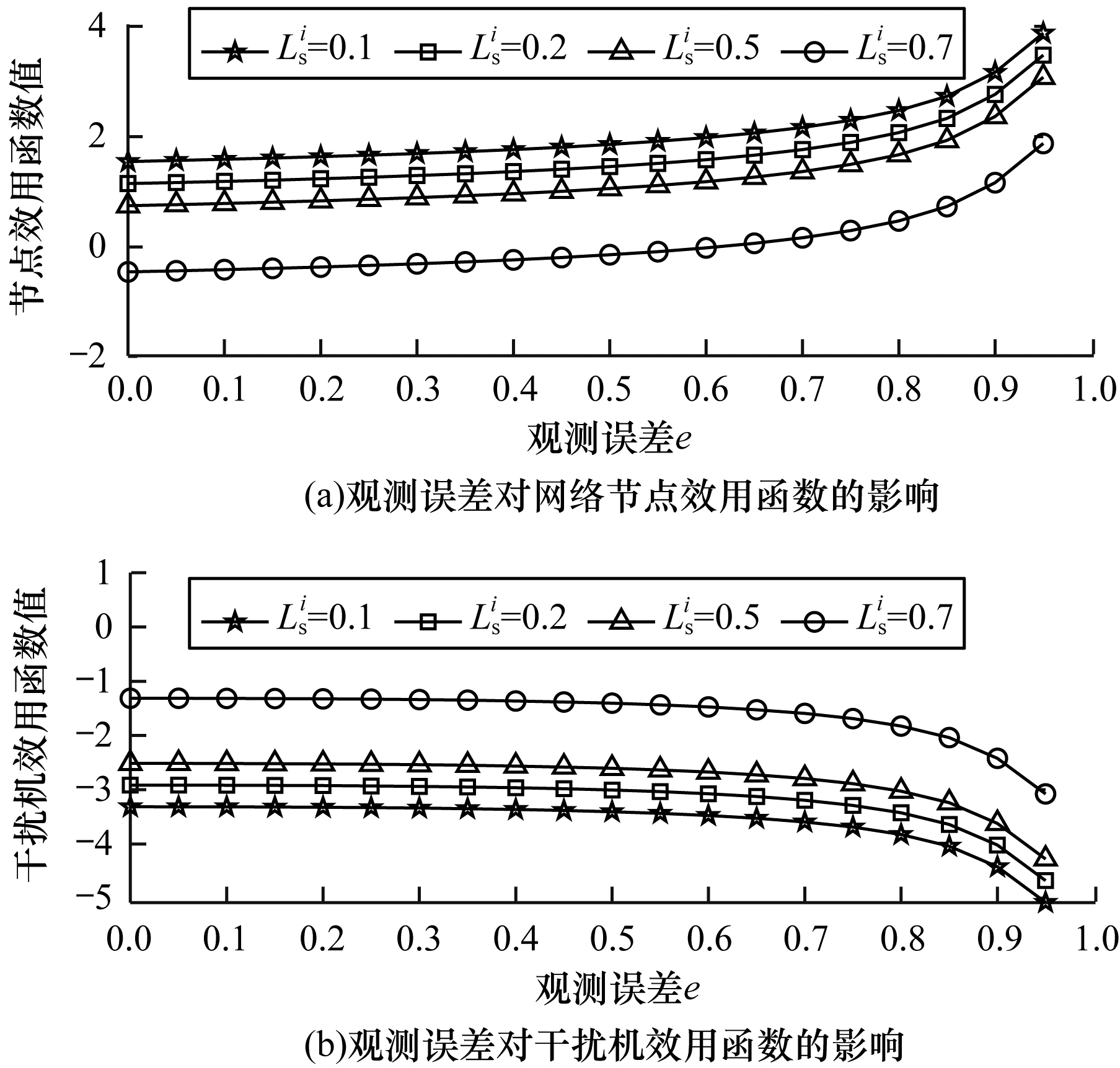

仿真2 考虑干扰机观测误差, 实验对干扰机偏离SE对节点效用函数及其自身效用函数的影响进行研究, 以检验网络的抗干扰性能。仿真参数设置为:通信信道增益gSi=0.7、gS-i=0.2, 干扰机损耗系数LJ=0.4, 节点i传输功率与干扰机干扰功率分别为PSi=12、PJ=10。为实现方便, 将簇内邻节点对节点i的互干扰功率均设为常数PS-i=2, 噪声功率ε=0.5, 节点损耗系数为LSi=[0.1, 0.2, 0.3, 0.7]。干扰机观测误差e对节点效用函数之和

|

Download:

|

| 图 5 观测误差e对网络节点与干扰机效用函数的影响 Fig. 5 Influence of observation error e on utility function of network node and jammer | |

从图 5可以看出, 随着干扰机观测误差e的增加, 节点效用函数之和呈现递增趋势, 然而干扰机的效用函数呈现递减趋势。这是因为随着观测误差的增加, 使得干扰机最佳传输功率偏离SE, 导致其效用函数减小, 干扰机观测误差等效于削弱了干扰机干扰的强度, 而这将有利于提高节点效用函数, 使其通信性能提升。

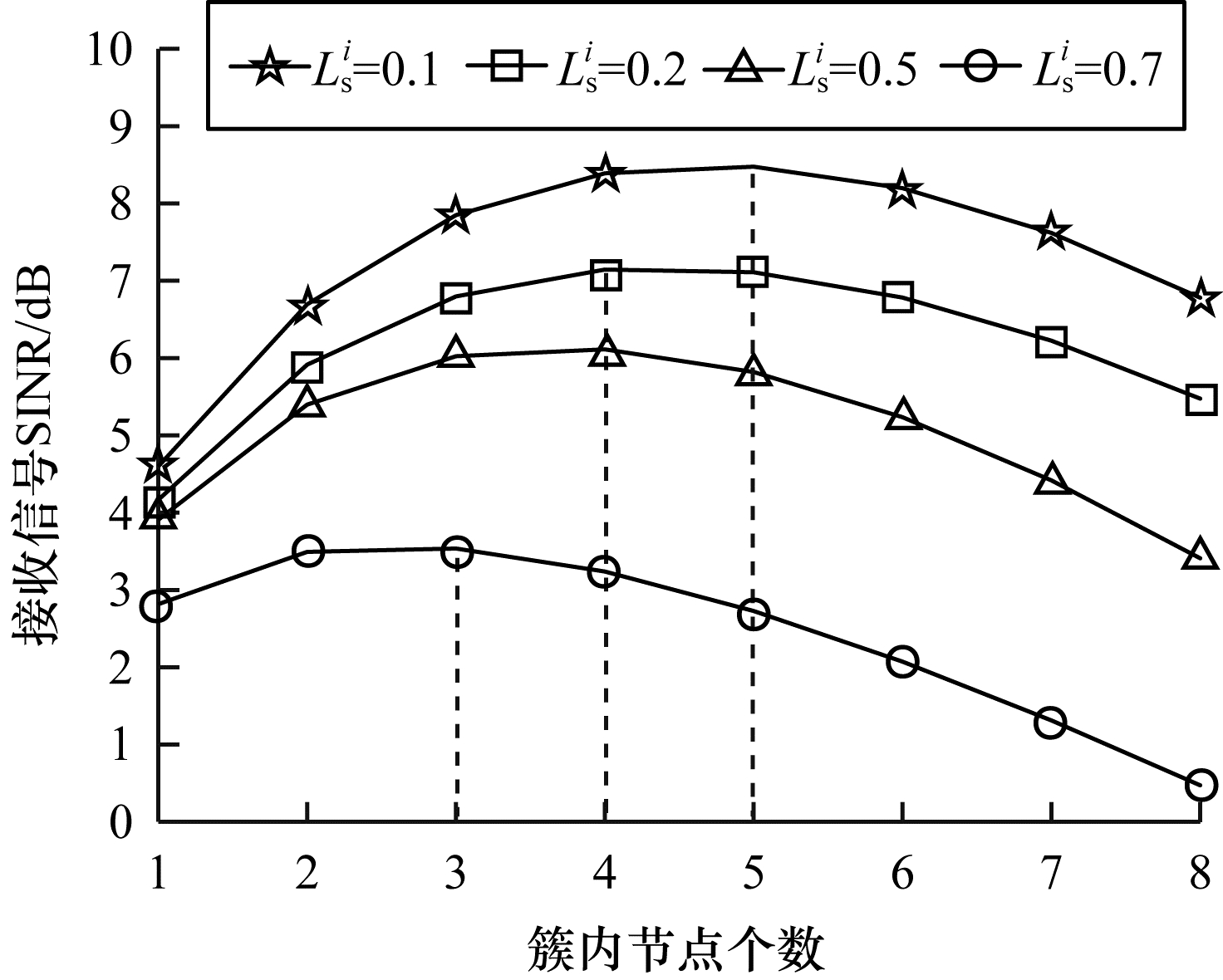

簇内节点个数对接收信号的SINR的影响如图 6所示。

|

Download:

|

| 图 6 簇内节点数对整体接收信号SINR的影响 Fig. 6 Influence of the number of nodes in a cluster on the overall received signal SINR | |

从图 6可以看出, 随着节点数的增加, 接收信号的SINR呈现先增大后减小的趋势。这是由于随着簇内节点数的增加, 节点之间的互干扰不断增加, 使得单个节点接收信号的SINR降低, 进而导致簇内各节点接收信号的SINR降低。此外, 在不同的节点损耗系数LSi=[0.1, 0.2, 0.3, 0.7]下, 簇内节点数存在一个最佳个数, 分别对应最佳簇内节点的个数为NC=[5, 4, 4, 3], 在一定程度上可为无人机集群网络簇的划分提供有益参考。

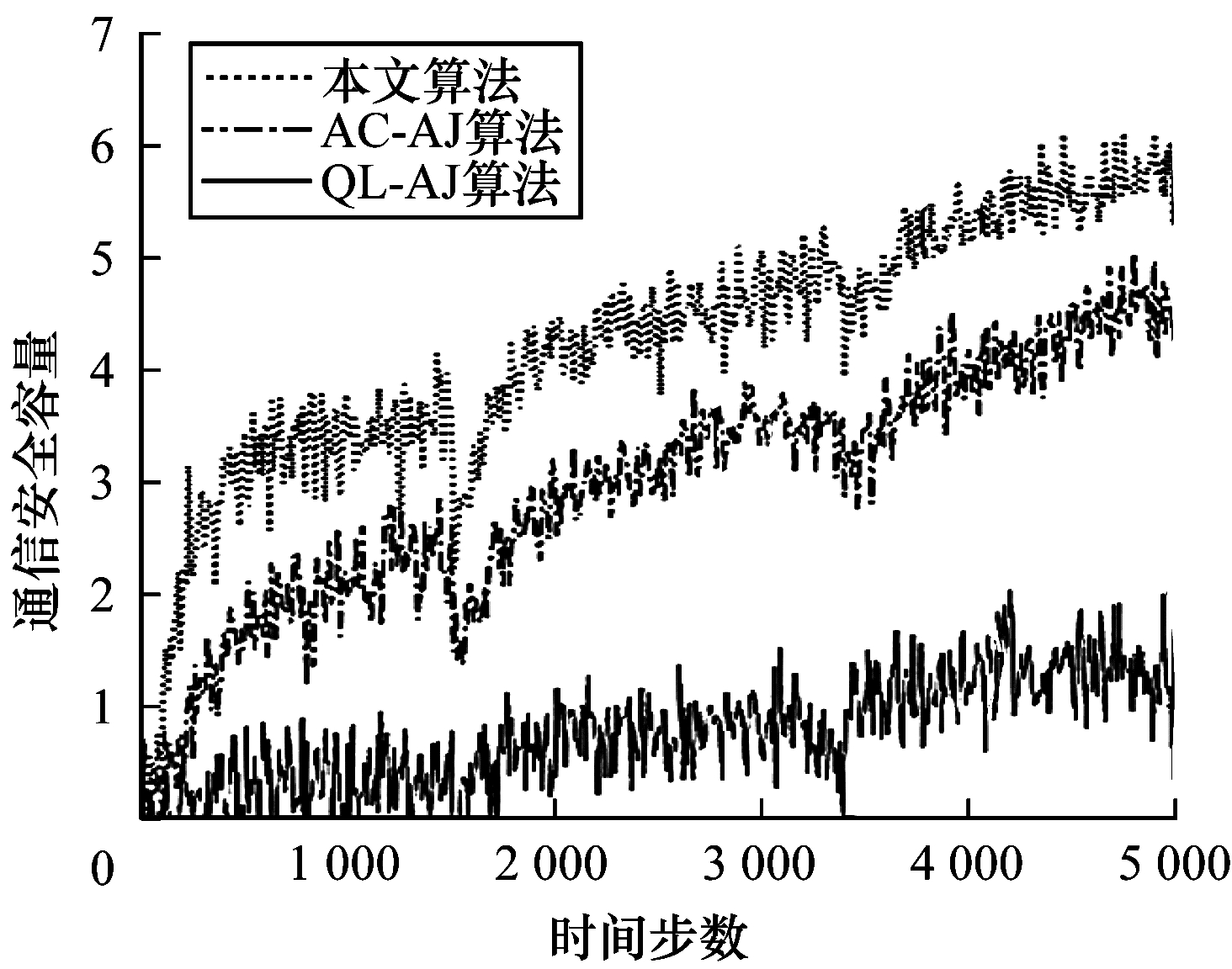

仿真3 实验比较了QL-AJ算法、AC-AJ算法与本文算法的抗智能干扰性能, 如图 7所示。从图 7可以看出, 在3种不同算法下, 网络通信安全容量均随着训练时间的增加而不断提高, 且与QL-AJ算法、AC-AJ算法相比, 本文算法的网络通信安全容量更高。值得注意的是, 在3个阶段的突变点, 上述3种算法得到的通信安全容量均骤减, 之后恢复, 然而本文算法较其他2种算法恢复的更快, 其原因是:由于状态空间和动作空间较大, QL-AJ算法遍历Q表所有状态的计算量庞大, 算法收敛较慢; 同时, AC算法利用卷积神经网络强大的计算能力, 相比QL算法提高了近4倍的计算速度; 另外, 相比于AC-AJ算法, 本文算法能够降低学习过程的方差, 算法稳定性好、收敛更快, 且通过联合功率域抗干扰减少信道切换的时间, 同时提高了接收信号SINR, 从而得到的通信安全容量更高。

|

Download:

|

| 图 7 3种算法的抗智能性干扰性能对比 Fig. 7 Comparison of anti-intelligence-jamming performance of three algorithms | |

为进一步说明本文算法的稳健性, 定义单个状态s的均方值误差表示为近似值函数Vθ(s)与真实Cseci(s)差的平方, 并记作VE :

| $ \overline {{\rm{VE}}} = \sqrt {\frac{1}{{|S|}}\sum\limits_{s \in S} {{{\left[ {C_{{\rm{sec}}}^i(s) - {V_\theta }(s)} \right]}^2}} } $ | (19) |

其中, | S |为系统状态个数。

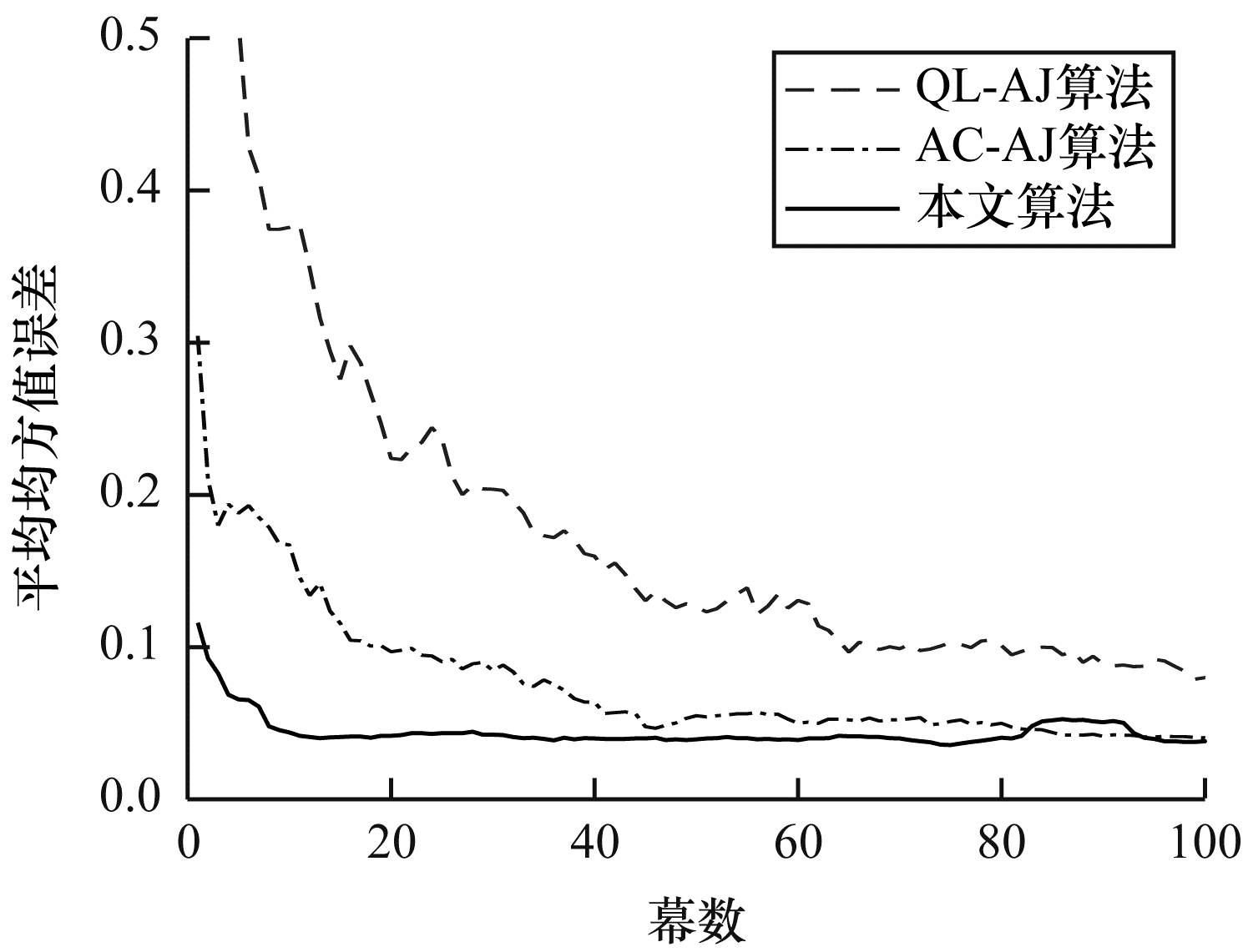

为验证所提方法算法收敛性能, 实验对比了QL-AJ算法、AC-AJ算法与本文算法的收敛情况。10个仿真周期的平均均方值误差如图 8所示。从图 8可以看出, 本文算法在经过10幕左右后已经收敛, 比其他2种算法的收敛性能好, 且得到的平均均方值误差更小。

|

Download:

|

| 图 8 3种算法的平均均方值误差变化曲线 Fig. 8 Average mean square error change curves of three algorithms | |

针对无人机集群网络对抗智能性干扰能力较弱的问题, 本文提出一种MDJC-AJ算法。该算法基于A2C频域算法, 利用感知到的频谱状态信息进行信道选择, 以提高算法的收敛速度与信道决策成功率, 并在此基础上, 根据得到的功率干扰等级, 利用功率域进行抗干扰, 以减少信道切换时间、提高接收信号SINR。通过仿真对比QL-AJ算法与AC-AJ算法, 说明本文所提MDJC-AJ算法的整体抗干扰性能较好。同时, 本文采用簇头协助的方法进一步改善网络的抗干扰性能。后续将考虑实际物理场景中存在不完全观测信息的情况, 开展基于贝叶斯博弈理论的抗干扰方法研究, 以满足实际工程需要。

| [1] |

GUPTA L, JAIN R, VASZKUN G. Survey of important issues in UAV communication networks[J]. IEEE Communications Surveys & Tutorials, 2016, 18(2): 1123-1152. |

| [2] |

LI Haitao, LUO Jiawei, LIU Changjun. Selfish bandit-based cognitive anti-jamming strategy for aeronautic swarm network in presence of multiple jammer[J]. IEEE Access, 2019, 7: 30234-30243. DOI:10.1109/ACCESS.2019.2896709 |

| [3] |

LIN Yu, WANG Tianyu. UAV-assisted emergency communica-tions:an extended multi-armed bandit perspective[J]. IEEE Communications Letters, 2019, 23(5): 938-941. DOI:10.1109/LCOMM.2019.2906194 |

| [4] |

SLIMENI F, CHTOUROU Z, SCHEERS B, et al. Cooperative Q-learning based channel selection for cognitive radio networks[J]. Wireless Networks, 2019, 25(7): 4161-4171. DOI:10.1007/s11276-018-1737-9 |

| [5] |

MNIH V, KAVUKCUOGLU K, SILVER D, et al. Human-level control through deep reinforcement learning[J]. Nature, 2015, 518(7540): 529-533. DOI:10.1038/nature14236 |

| [6] |

SILVER D, HUANG A, MADDISON C J, et al. Mastering the game of go with deep neural networks and tree search[J]. Nature, 2016, 529(7587): 484-489. DOI:10.1038/nature16961 |

| [7] |

WANG S X, LIU H P, GOMES P H, et al. Deep reinforcement learning for dynamic multichannel access in wireless networks[J]. IEEE Transactions on Cognitive Communications and Networking, 2018, 4(2): 257-265. DOI:10.1109/TCCN.2018.2809722 |

| [8] |

BHOWMIK M, MALATHI P. Spectrum sensing in cognitive radio using actor-critic neural network with krill herd-whale optimization algorithm[J]. Wireless Personal Communications, 2019, 105(1): 335-354. DOI:10.1007/s11277-018-6115-5 |

| [9] |

WEI Y F, YU F R, SONG M, et al. User scheduling and resource allocation in HetNets with hybrid energy supply:an actor-critic reinforcement learning approach[J]. IEEE Transactions on Wireless Communications, 2018, 17(1): 680-692. DOI:10.1109/TWC.2017.2769644 |

| [10] |

XIAO Liang, CHEN Tianhua, LIU Jinliang, et al. Anti-jamming transmission stackelberg game with observation errors[J]. IEEE Communications Letters, 2015, 19(6): 949-952. DOI:10.1109/LCOMM.2015.2418776 |

| [11] |

AHMED I K, FAPOJUWO A O. Stackelberg equilibria of an anti-jamming game in cooperative cognitive radio networks[J]. IEEE Transactions on Cognitive Communications and Networking, 2018, 4(1): 121-134. |

| [12] |

XU Yifan, REN Guochun, CHEN Jin, et al. A one-leader multi-follower Bayesian-stackelberg game for anti-jamming transmission in UAV communication networks[J]. IEEE Access, 2018, 6: 21697-21709. DOI:10.1109/ACCESS.2018.2828033 |

| [13] |

JIA Luliang, XU Yuhua, SUN Youming, et al. A multi-domain anti-jamming defense scheme in heterogeneous wireless networks[J]. IEEE Access, 2018, 6: 40177-40188. DOI:10.1109/ACCESS.2018.2850879 |

| [14] |

PARISI S, TANGKARATT V, PETERS J, et al. TD-regularized actor-critic methods[J]. Machine Learning, 2019, 108(8/9): 1467-1501. |

| [15] |

TINNIRELLO I, BIANCHI G, XIAO Y. Refinements on IEEE 802.11 distributed coordination function modeling approaches[J]. IEEE Transactions on Vehicular Tech-nology, 2010, 59(3): 1055-1067. DOI:10.1109/TVT.2009.2029118 |

| [16] |

NAPARSTEK O, COHEN K. Deep multi-user reinforcement learning for distributed dynamic spectrum access[J]. IEEE Transactions on Wireless Communications, 2019, 18(1): 310-323. DOI:10.1109/TWC.2018.2879433 |

| [17] |

FANG Xiaojie, ZHANG Ning, ZHANG Shan, et al. On physical layer security:weighted fractional Fourier transform based user cooperation[J]. IEEE Transactions on Wireless Communications, 2017, 16(8): 5498-5510. DOI:10.1109/TWC.2017.2712158 |

| [18] |

HAARNOJA T, ZHOU A, ABBEEL P, et al.Soft actor-critic: off-policy maximum entropy deep reinforcement learning with a stochastic actor[EB/OL].[2019-11-01].https://arxiv.org/abs/1801.01290.

|

| [19] |

O'DONOGHUE B, MUNOS R, KAVUKCUOGLU K, et al.PQG: combining policy gradient and Q-learning[EB/OL].[2019-11-01].https://deepmind.com/research/publicatio ns/pgq-combining-policy-gradient-and-q-learning.

|

| [20] |

MAO H Z, NETRAVALI R, ALIZADEH M.Neural adaptive video streaming with pensieve[C]//Proceedings of the Conference of the ACM Special Interest Group on Data Communication.New York, USA: ACM Press, 2017: 197-210.

|

2020, Vol. 46

2020, Vol. 46