2. 西安中科星图空间数据技术有限公司, 西安 710000

2. Xi'an Zhongkexingtu Space Data Technology Co., Ltd, Xi'an 710000, China

开放科学(资源服务)标志码(OSID):

高分遥感影像是现代交通体系的重要载体,而路网提取技术是近些年来逐渐发展成熟的一门独立学科,其在高分遥感影像中的应用价值主要体现在车辆导航、智能交通、地图绘制、城市规划等诸多领域。同时也给自然灾害预警、灾后重建、军事目标打击等相关场景提供有效的参考,对经济、政治、地理、军事等方面具有不可替代的意义[1-2]。

但随着遥感技术的不断革新,测量精度已经达到亚米级,分辨率也已经突破分米(dm)级别,并且有进一步发展的趋势。伴随而来的是地物背景信息的细节更加丰富,非道路信息如植被阴影、车辆流动、高楼建筑遮挡、人流流动等作为干扰噪声十分繁杂,造成目标信息提取难度增加,即道路信息识别难度加大。另外,在路网识别过程中不同质地的道路会呈现出不同的光谱特性[3],还可能出现同谱异物或同物异谱的现象;当前道路提取绝大多数都采用半自动化方式,加上算法自身鲁棒性较差、传统方法识别精度较低、过程繁琐等一系列问题,都给路网提取带来较大的挑战。

目前,以卷积神经网络(Convolutional Neural Network,CNN)为典型代表的深度学习理论,在图像分类[4-5]及目标检测[6-7]等领域均表现出巨大的发展潜力。深度学习作为近来比较热门的研究方法,其在高分影像道路智能化提取领域的实际应用也取得了长足的发展。文献[8]提出CNN训练大样本数据集的线性整合卷积算法,该算法可以预测像素区域为道路的概率,同时为每个像素点分配标记标签来判断是否为道路区域,适用场景为道路边缘轮廓较粗糙的影像。文献[9]以地面材质不同的分类为依据,提出一种弱监督的提取算法,该算法利用Deep Lab构建学习网络,由ResNet网络结构负责测试稳定性,最后根据条件随机场(Conditional Random Field,CRF)修复边界,在滑动窗口利用光谱角度距离连接相邻路段。文献[10]提出一种改进型graphcut道路检测算法,该算法能够利用Orchard-Boumand聚类算法聚类道路和非道路像素点,构建Gibbs能量惩罚函数中的区域项,继而使用maxflow算法对生成的权重图进行分割,提取出道路信息。从上述方法的提取效果来看,较之前有大幅度提升,其准确性、鲁棒性、适应性也较传统方法有明显改善。

高分遥感影像道路提取问题的关键在于识别影像中相关联的道路像素特征信息。然而,在一些实际的应用场景中,常会因非道路关联像素点的干扰,即受前景道路像素点与背景非道路像素点在量级上存在巨大差距的困扰,这种情况导致很难建立起一种高效的道路分割模型。

D-LinkNet[11]模型架构在中心区域加入了空洞卷积层[12],这样能够最大程度地增大感受野的范围及促进多尺度特征融合,同时不会造成特征图分辨率的损失,尽量保留道路的空间细节信息。本文将D-LinkNet应用于高分遥感影像道路提取研究,并依据影像中道路的特征对模型做出改进措施,提升该网络模型在高分遥感影像中道路的分割精度。

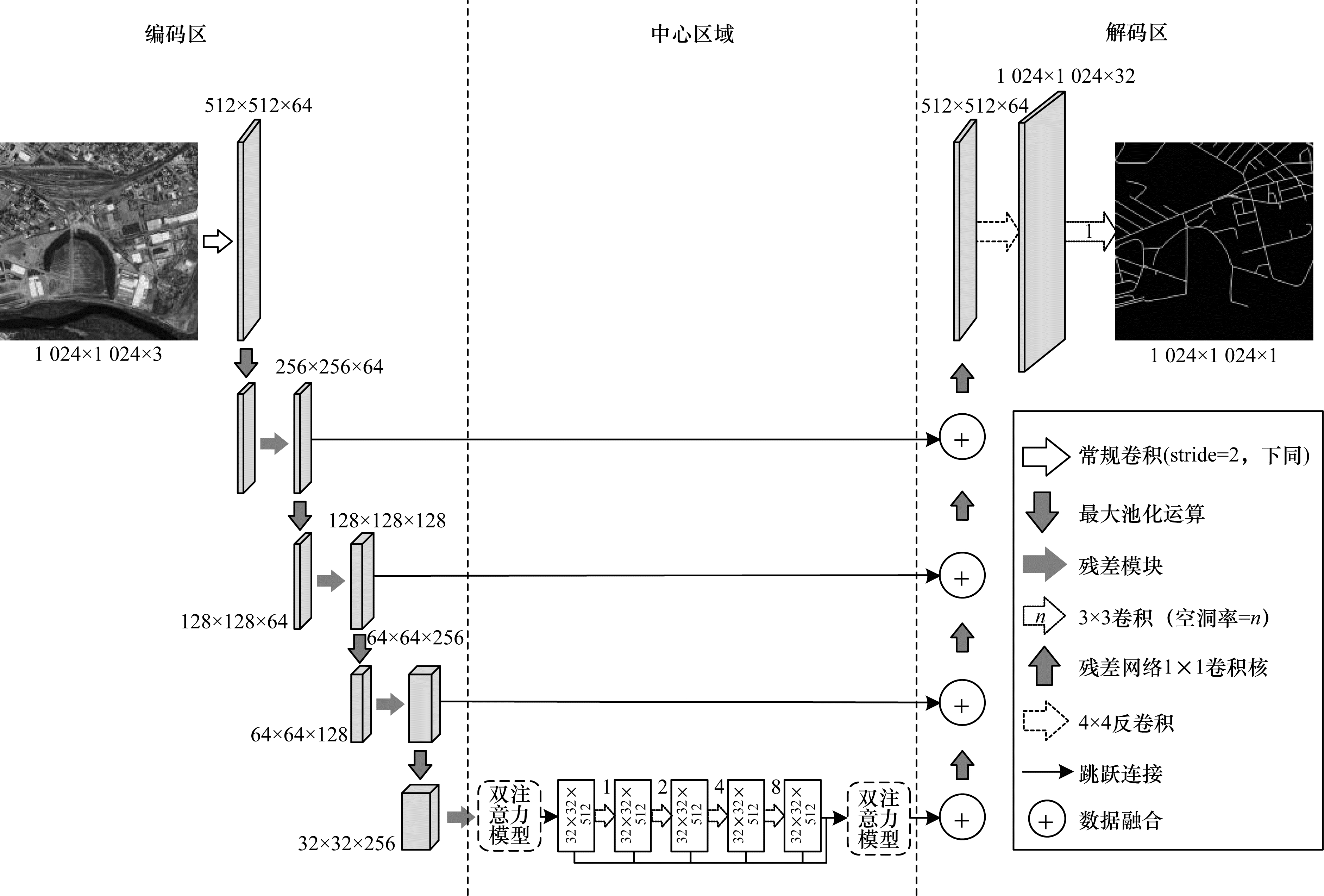

1 高分遥感影像道路提取模型 1.1 D-LinkNet网络模型D-LinkNet网络模型是北京邮电大学模式识别实验室在2018年的CVPR(Computer Vision and Pattern Recognition)全球卫星图像道路提取竞赛(DeepGlobe Road Extraction Challenge)项目中取得最高分数脱颖而出的模型。本文D-LinkNet网络架构是由残差网络构建的编码区、中心区域以及解码区3个部分组成。

该模型以LinkNet作为基本框架,采用一种Encoder-Decoder的架构。该模型的主要思想是:编码区将道路信息编码到特征信息上;解码区将编码的道路特征信息映射到空间中进行分割。由于在中心区域加入卷积层的基础上,网络本身并未增加学习参数,大幅降低了训练的难度。对于道路提取任务,D-LinkNet增加中心区域的空洞卷积层能进一步识别道路特征点信息的感受野。空洞卷积层相对于LinkNet中池化层的优势是在保证特征图分辨率的同时,不会丢失空间信息。

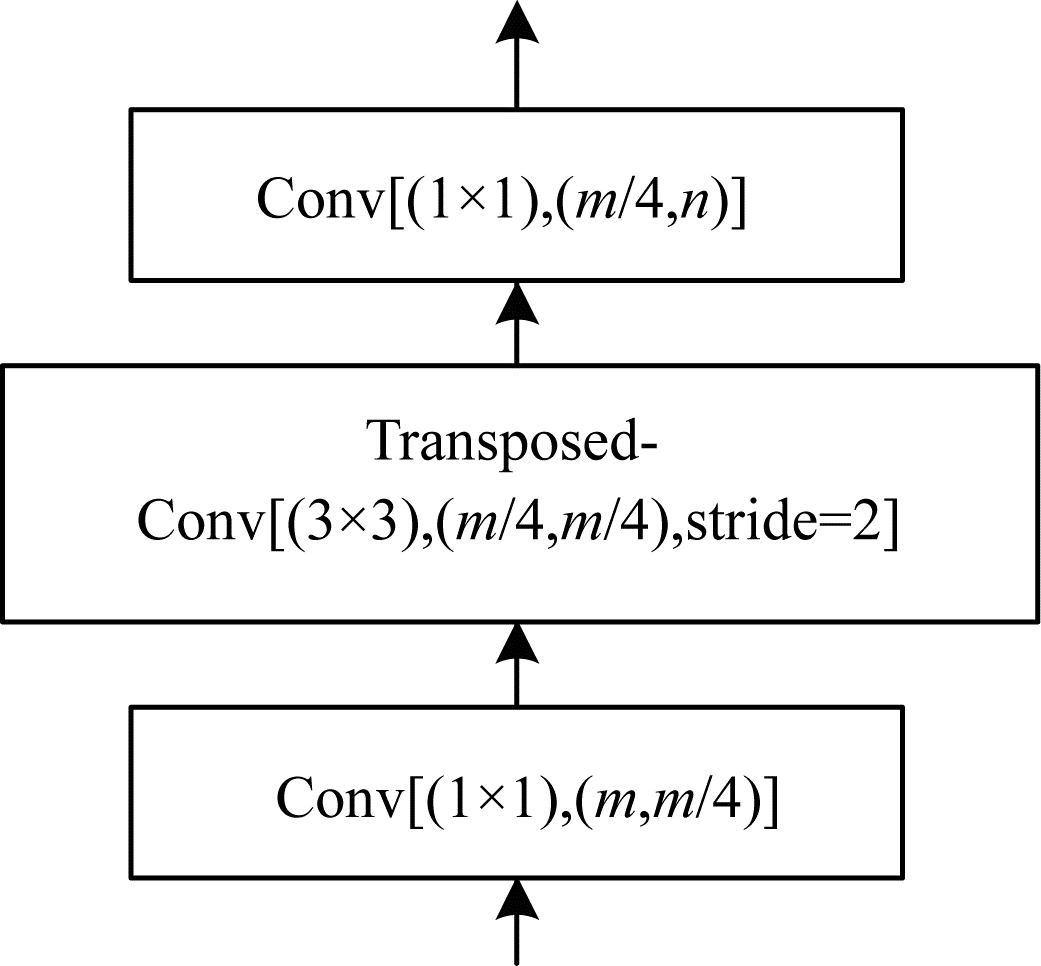

编码区是由1个尺寸为7×7、stride=2的初始卷积模块和4个残差模块组成。残差模块使用ResNet34作为预训练网络结构,采用跳跃连接的方式增强区域块的泛化表征能力。中心区域的核心部分是空洞卷积层模块,该模块是一种串、并联并存的连接方式。另外,本文在原有结构的基础上嵌入channel-spatial双注意力模块,精准地捕获道路特征信息。解码区采用一种残差网络的瓶颈连接结构[13],该结构利用1×1的卷积核来提升网络的计算效率,如图 1所示,最后利用转置卷积上采样将边长变为原来的32倍,还原为原始图像的尺寸。本文构建的改进D-LinkNet网络结构如图 2所示。

|

Download:

|

| 图 1 残差网络瓶颈结构1×1卷积核 Fig. 1 Residual network bottleneck structure 1×1 convolution kernel | |

|

Download:

|

| 图 2 用于道路提取的改进D-LinkNet网络 Fig. 2 Improved D-LinkNet network for road extraction | |

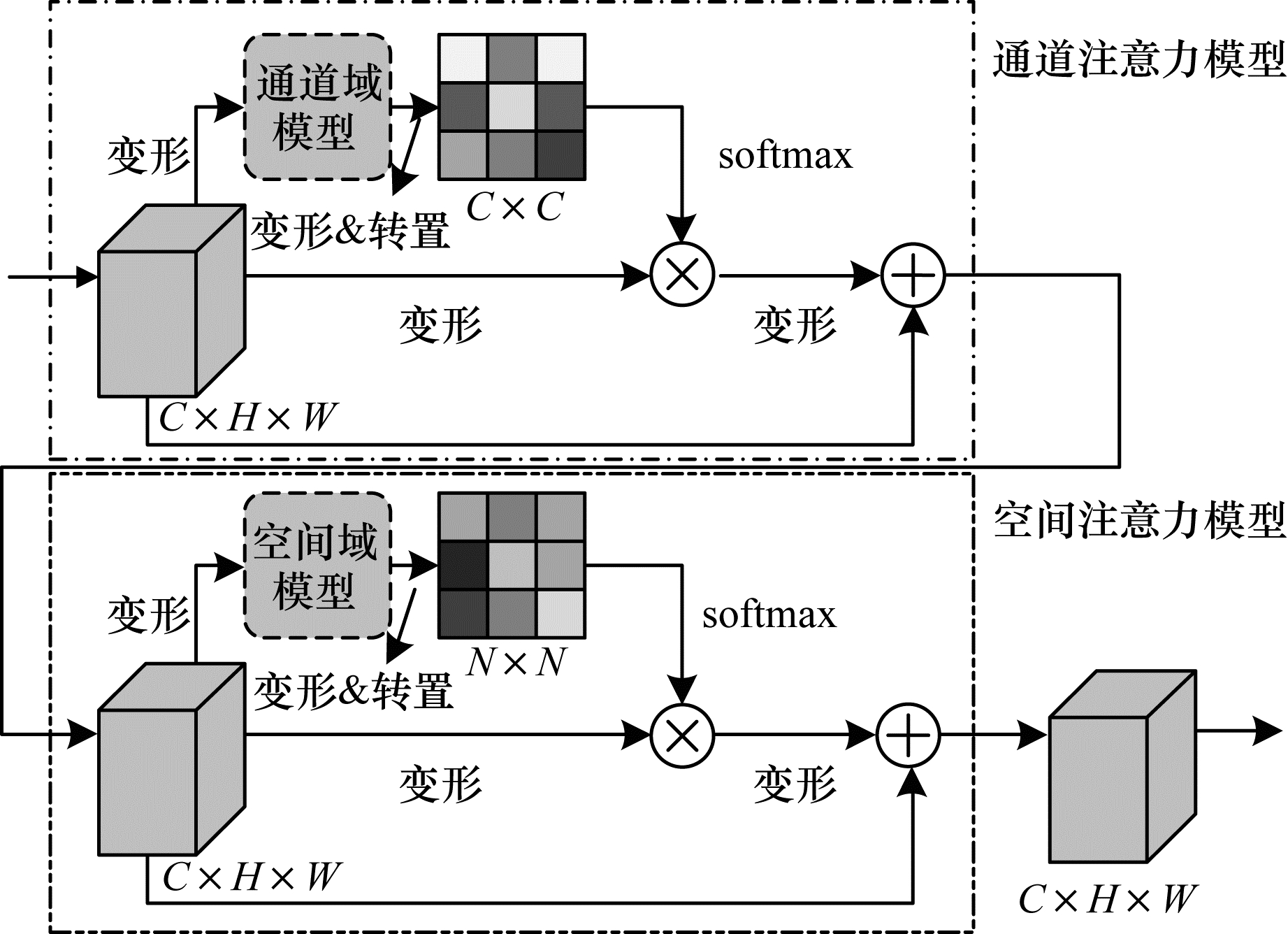

在神经网络中引入注意力机制的目的在于通过对重要的特征进行加权处理,来增强有效层的特征。对于本文而言,引入注意力机制的作用是从复杂的背景干扰信息中检测出条状道路轮廓。神经网络主要是通过掩码这一桥梁搭建注意力机制。掩码的实现原理是通过一层新的权重分布层,将图像中的重要的目标特征信息标注出来,网络再通过学习及训练获取标注后的图片道路区域,从而形成注意力。注意力机制的优势在于能够依据梯度算子的前向传播及后向反馈能力,通过训练来学习图像中的注意力权重参数。本文提出一种综合注意力通道域[14]、空间域[15]组合形式的新型通道-空间双注意力域机制,并且对加入的新型注意力模块展开详细的说明。

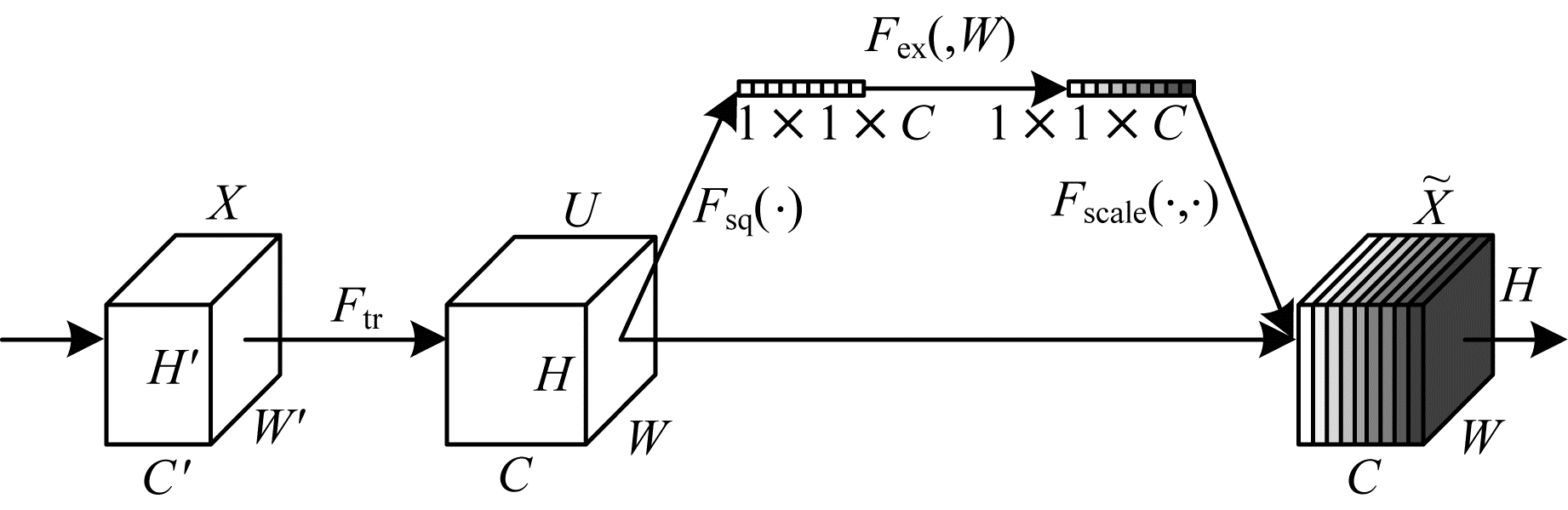

1.2.1 通道域注意力通道域注意力机制的设计思路类似于信号与系统分析的傅里叶变换。任意连续信号均可由正弦波的不同权重的线性组合表示,而这一时域信号经时频变换可转换成频域信号的形式。同样,每张图像均可由(R,G,B)三通道表示。图像经过n个卷积核的卷积运算,得到n通道的矩阵(H,W,n)。这个过程将图像的特征信息分配到n个卷积核上,从而生成n通道的特征图。通过对不同通道赋予不同权重的大小,体现相应相关度特征信息的通道。

为学习每个输出通道的不同权重,继而得出相对应相关度的道路信息,此处使用一种挤压-激励模型结构来完成道路通道域信息的提取,图 3所示为通道域注意力模型。其中

|

Download:

|

| 图 3 通道域注意力模型 Fig. 3 Channel domain attention model | |

挤压过程是一个全局平均池化的运算:

| $ {z}_{c}={F}_{\mathrm{s}\mathrm{q}}\left({u}_{c}\right)=\frac{\mathit{1}}{H\times W}\sum \limits_{i=1}^{H}\sum \limits_{j=1}^{W}{u}_{c}(i, j) $ | (1) |

其中:

| $ s={F}_{\mathrm{e}\mathrm{x}}(z, W)=\sigma \left(\right(g(z, W))=\sigma ({W}_{2}\delta \left({W}_{1}z\right)) $ | (2) |

其中:

| $ {\tilde{\boldsymbol{x}}}_{c}={F}_{\mathrm{s}\mathrm{c}\mathrm{a}\mathrm{l}\mathrm{e}}({u}_{c}, {s}_{c})={u}_{c}\cdot {s}_{c} $ | (3) |

其中:

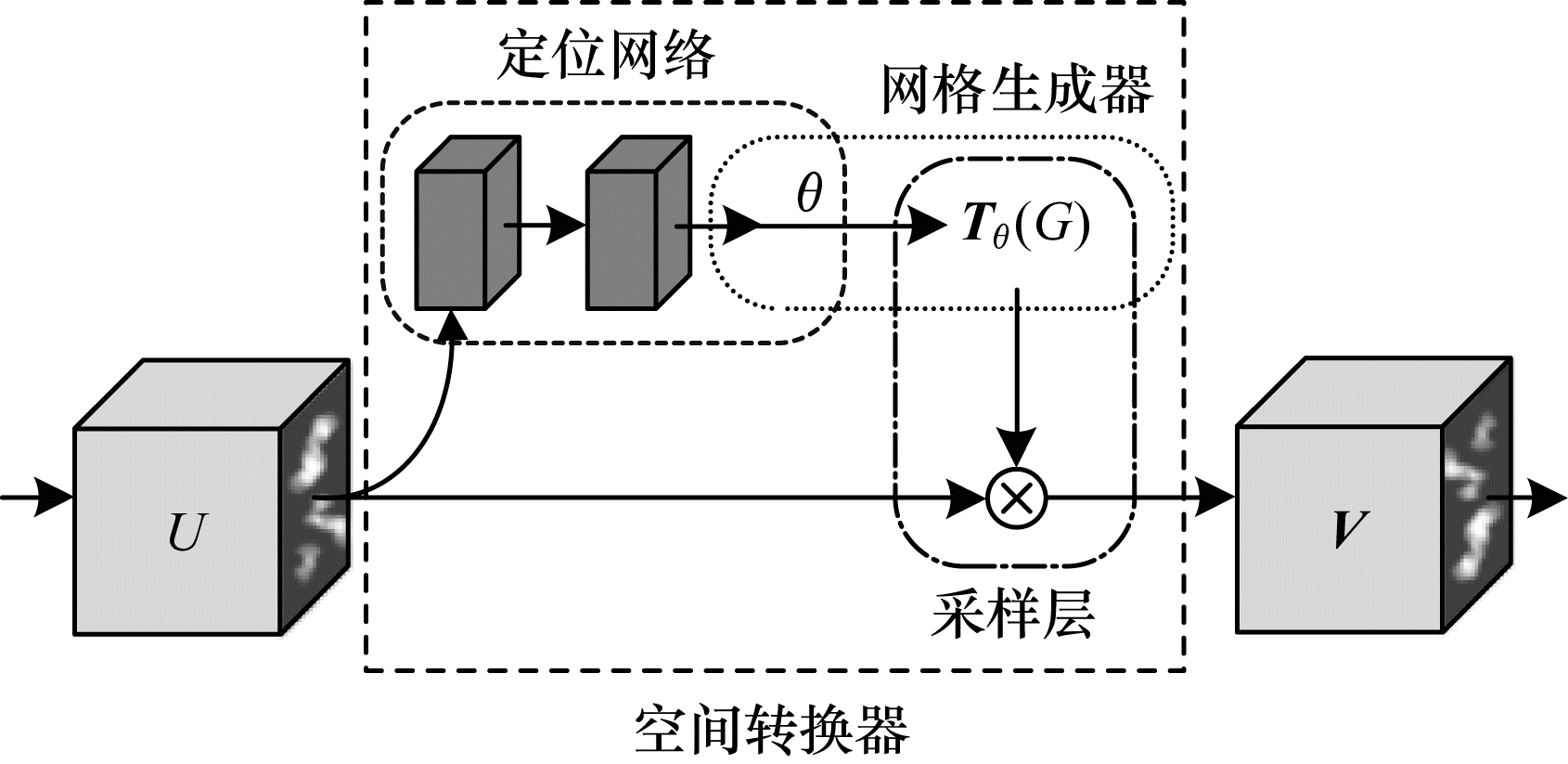

空间域注意力机制是通过空间转换器模块,将原始图像的空间信息做相应的空间信息转换,提取出重要的道路信息。空间域注意力模型如图 4所示。

|

Download:

|

| 图 4 空间域注意力模型 Fig. 4 Spatial domain attention model | |

空间域注意力机制设计思路是通过学习图像中道路信息,经过训练使得空间转换器能够在复杂条件下通过旋转、聚焦、缩放的手段将道路信息以框盒的形式提取出来。输入

| $ \left[\begin{array}{ccc}\begin{array}{c}{\theta }_{11}\\ {\theta }_{21}\end{array}& \begin{array}{c}{\theta }_{12}\\ {\theta }_{22}\end{array}& \begin{array}{c}{\theta }_{13}\\ {\theta }_{23}\end{array}\end{array}\right]={\boldsymbol{{ T}}}_{\theta }\left({G}_{i}\right){\left(\begin{array}{c}{x}_{i}^{t}\\ {y}_{i}^{t}\\ 1\end{array}\right)}^{-1}=\left(\begin{array}{c}{x}_{i}^{s}\\ {y}_{i}^{s}\end{array}\right){\left(\begin{array}{c}{x}_{i}^{t}\\ {y}_{i}^{t}\\ 1\end{array}\right)}^{-1} $ | (4) |

其中:

| $ \begin{array}{l}{\boldsymbol{V}}_{i}^{c}=\sum \limits_{n}^{H}\sum \limits_{m}^{W}{U}_{nm}^{c}{k}^{2}({x}_{i}^{8}-m;{\varPhi }_{x})({y}_{i}^{8}-n;{\varPhi }_{y})\\ {\forall }_{i}\in \left[1\cdots H'W'\right], {\forall }_{c}\in \left[\mathrm{1, 2}, \cdots , C\right]\end{array} $ | (5) |

其中:

本文提出的空间-通道双注意力机制集中了以上2种注意力域的优势,能够同时实现学习道路特征通道权重参数对所需道路通道的增强,又能在复杂环境下,通过多种手段完成对道路信息的标注提取。

该网络的设计思路是受DANet双注意力网络结构的启发[16],采用级联的连接方式,可以依次在空间域和通道域捕获道路信息的全局特征依赖,利用前者建立通道的相关性,后者来学习空间域特征信息的相关性,如图 5所示。

|

Download:

|

| 图 5 通道-空间域模型 Fig. 5 Model of channel-spatial domain | |

对每张尺寸为

| $ {x}_{ij}=\frac{\mathrm{e}\mathrm{x}\mathrm{p}({A}_{i}·{A}_{j})}{\sum \limits_{i=1}^{C}\mathrm{e}\mathrm{x}\mathrm{p}({A}_{i}·{A}_{j})} $ | (6) |

其中:

| $ {\boldsymbol{E}}_{\boldsymbol{i}}=\beta \sum \limits_{i=\mathit{1}}^{C}{x}_{ij}{A}_{j}+{A}_{i} $ | (7) |

其中:

| $ {x}_{ij}'=\frac{\mathrm{e}\mathrm{x}\mathrm{p}({B}_{i}·{C}_{j})}{\sum \limits_{i=1}^{C}\mathrm{e}\mathrm{x}\mathrm{p}({B}_{i}·{C}_{j})} $ | (8) |

| $ {\boldsymbol{E}}_{i}'=\alpha \sum \limits_{i=\mathit{1}}^{C}{S}_{ij}'{D}_{j}+{D}_{i} $ | (9) |

其中:

在深度学习图像识别领域,构建损失函数最常用的2种方式是交叉熵损失[17]和折页损失[18]。交叉熵损失是一种逻辑斯蒂回归模型,而折页损失是一种支持向量机(SVM)模型[19-20]。这2种损失通常被当作是构建损失函数优化分割网络必不可少的元素。作为网络输出的最后的网络层,通常是以交叉熵损失为主。二值交叉熵(Binary Cross Entropy,BCE)损失函数能够使输出预测最大程度上与真实样本相符,满足“最大熵原则”优化网络输出;DICE系数损失(DICE Coefficient Loss,DICE)是一种集合相似度度量的函数,用于衡量2个样本间的相似度。2种损失的梯度不同,DICE损失的梯度为

| $ {L}_{\mathrm{D}-\mathrm{L}\mathrm{i}\mathrm{n}\mathrm{k}}=\mu \left[\frac{2\times \sum \limits_{i=1}^{N}\left|{P}_{i}\bigcap \mathrm{G}{\mathrm{T}}_{i}\right|}{\sum \limits_{i=1}^{N}(\left|{P}_{i}\right|+\left|\mathrm{G}{\mathrm{T}}_{i}\right|)}\right]+\\ \lambda \left[\sum \limits_{i=1}^{N}\mathrm{B}\mathrm{C}\mathrm{E}\mathrm{L}\mathrm{o}\mathrm{s}\mathrm{s}({P}_{i}, \mathrm{G}{\mathrm{T}}_{i})\right] $ | (10) |

| $ \begin{array}{l}\mathrm{B}\mathrm{C}\mathrm{E}\mathrm{L}\mathrm{o}\mathrm{s}\mathrm{s}(P, \mathrm{G}\mathrm{T})=\\ -\sum \limits_{i=1}^{W}\sum \limits_{j=1}^{H}\left[g{t}_{ij}\cdot \mathrm{l}\mathrm{o}{\mathrm{g}}_{a}{p}_{ij}+(1-g{t}_{ij})\cdot \mathrm{l}\mathrm{o}{\mathrm{g}}_{a}(1-{p}_{ij})\right]\end{array} $ | (11) |

其中:

D-LinkNet分割网络结构是采用backbone-head的骨架结构,直接利用线性插值上采样的操作。它是一种端到端的神经网络架构,没有冗杂的学习参数,不需要大量的冗余计算,这样就可以直接将注意力模块加入到D-LinkNet网络中。另外,将注意力机制引入到神经网络中,通常是Encoder-Attention-Decoder的形式,因此只需对图 2中心区域做出改进。但又由于该网络中有上采样层,因此注意力模型的位置需要经过实验对比来获取最佳的植入位置,如图 6所示,虚框A、B部分为注意力模块。

|

Download:

|

| 图 6 改进D-LinkNet结构 Fig. 6 Structure of improved D-LinkNet | |

在图 6所示的改进D-LinkNet结构框架中,注意力模块A左侧连接的是将预训练好的ResNet34作为编码器,充分激活网络的表征能力。中心区域的5条分支路加入空洞卷积运算模块。所谓的空洞卷积本质就是一种特殊的“池化”运算。相对于普通的池化过程,空洞卷积的优点是在不损耗特征信息情况下,能够增大感受野的范围,从而输出更多的信息。图中灰色箭头表示神经网络的深度,5条支路的深度依次为4、3、2、1、0(0代表恒等映射),感受野的尺寸依次为15、7、3、1、0。该结构能在不损失分辨率的条件下完成特征多深度、多尺寸的融合,采用特征层“堆叠”的特征融合方式,无后处理运算过程。之后加入1×1的卷积层进行特征融合。最后通过用于归一化的Sigmoid函数及ReLU激活函数获得与输入图像分辨率相同像素级的道路预测概率图。根据设定的阈值最终得到遥感影像道路分割预测的二值图像。

2 实验结果与分析为验证本文提出的高分遥感影像道路提取方法的准确性与有效性,针对改进D-LinkNet模型内部不同超参数权重比比值的设定,进行一系列的横向对比实验。另外,对于改进模型外部而言,对当前主流的道路分割方法进行纵向对比实验,直观展现本文改进的网络与当前主流经典网络道路预测效果的对比。

2.1 数据集本文是在开源的数据集Massachusetts Road Datasets上进行实验。该数据集是美国马萨诸塞州2 600 km×2 600 km范围内的地面遥感影像数据,这其中的地物信息主要涵盖城市、郊区以及农村地区的道路分布。该数据集总共有1 171张尺寸为1 500像素×1 500像素的遥感图像,空间分辨率为1 m(1 m/pixel)。其中包含1 108张训练数据集(完整的图像有706张,其余402张均有不同严重程度的缺失)、49张测试集以及14张验证集。本文的训练样本选择经清洗后的训练集及验证集共720张遥感图像作为训练数据。

2.2 实验环境及方法为对本文提出改进网络模型的道路分割预测效果做出客观的评价与对比,所有实验均在相同软、硬件环境下进行。

软件环境:操作系统为内存为64 GB的CentOS7.2;深度学习框架为Pytorch1.5;编程环境为Python3.5。

硬件环境:CPU型号为Intel® Xeon® E5-2650 v4 @2.20 GHz,GPU为Tesla P100。

参数设置:动量参数为0.9,batchsize设定为8,学习率调整3次,初始值为0.001的SGD更新梯度优化算法。训练过程总共迭代90轮,分别于训练的第30、50、70轮分别对学习率更新1次,学习率分别为0.000 1、0.000 01、0.000 001。其中,在初始学习率下迭代10 098/8×30=37 868次,后面3种学习率均迭代10 098/8×20=25 245次,所以整个训练过程总共迭代37 868+25 245×3=113 603次。

2.3 图像预处理在数据集训练之前,首先需要对图像进行预处理。受限于GPU内存的运算能力,对每张1 500像素×1 500像素的图像进行切分。切块大小为512×512,切块后的训练集总共包含10 098幅图像,验证集包含441张图像。另外,在训练过程中对数据进行了简单的增强,包括随机翻转和随机裁剪,随机裁剪大小为480像素×480像素的图像。本文使用的Massachusetts Road Datasets道路与背景的像素占比分别为5%和95%。此处采用一种占比倒数加权的方法来解决两类像素点占比不平衡的问题。

2.4 评价指标实验采用精确率P(Precision)、召回率R(Recall)、F1-score、平均交并比(Mean Intersection over Union,mIoU)4项评价指标,作为评价本文道路分割效果的参考依据,分别定义如下:

| $ P=\frac{{T}_{\mathrm{T}\mathrm{P}}}{{T}_{\mathrm{T}\mathrm{P}}+{F}_{\mathrm{F}\mathrm{P}}} $ | (12) |

| $ R=\frac{{T}_{\mathrm{T}\mathrm{P}}}{{T}_{\mathrm{T}\mathrm{P}}+{F}_{\mathrm{F}\mathrm{N}}} $ | (13) |

| $ {F}_{1-\mathrm{s}\mathrm{c}\mathrm{o}\mathrm{r}\mathrm{e}}=2\times \frac{P\times R}{P+R} $ | (14) |

| $ {m}_{\mathrm{m}\mathrm{I}\mathrm{o}\mathrm{U}}=\frac{1}{k+\mathit{1}}\sum \limits_{i=0}^{k}\frac{\sum \limits_{i=0}^{k}{p}_{ii}}{\sum \limits_{j=0}^{k}{p}_{ij}+\sum \limits_{j=0}^{k}({p}_{ji}-{p}_{ii})} $ | (15) |

其中:TP表示真正列,实际道路像素被预测为道路像素;FP表示假正例,非道路像素被预测为道路像素;FN表示假反例,非道路信息被预测成非道路信息;另外2种评价指标F1与mIoU是图像分割中常见的2项评价指标;

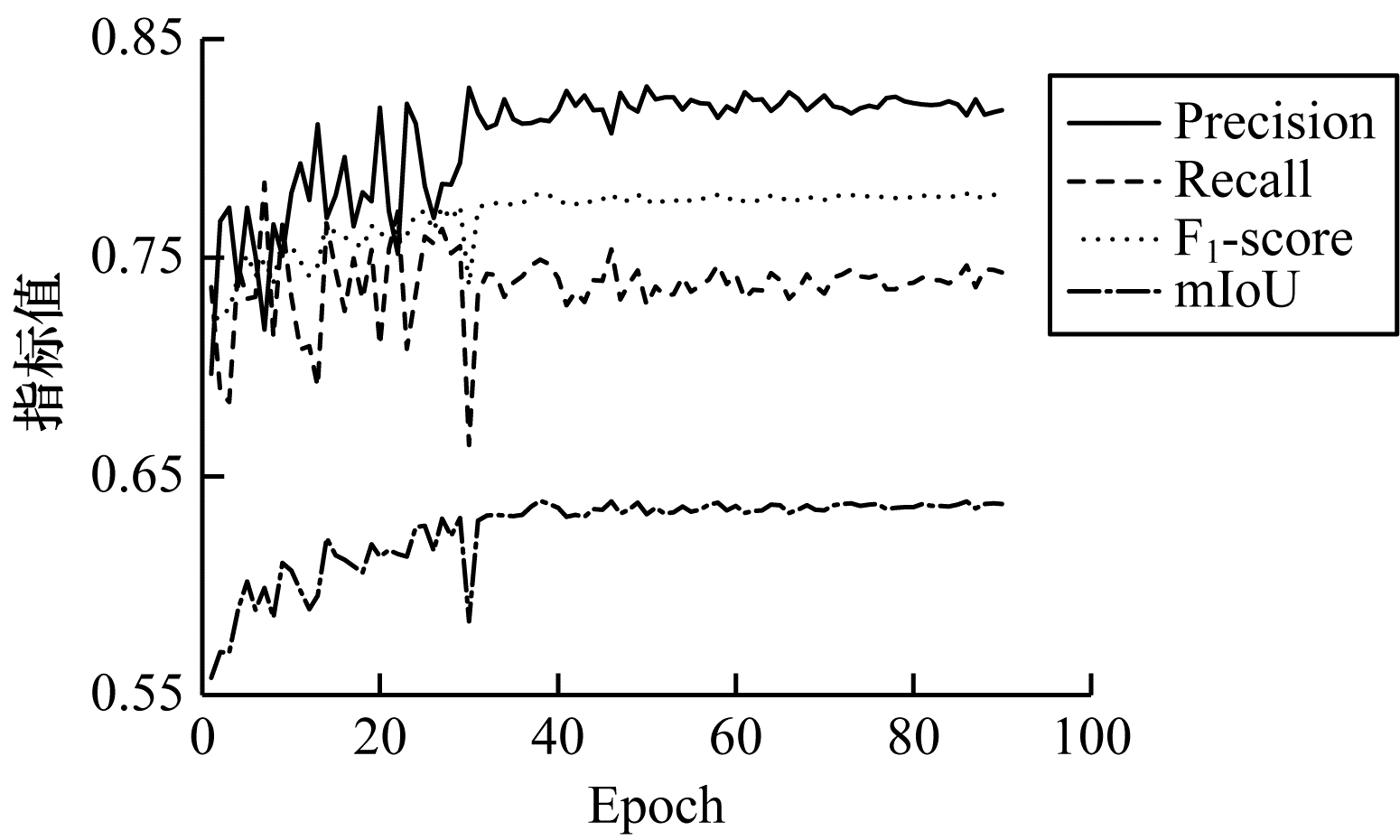

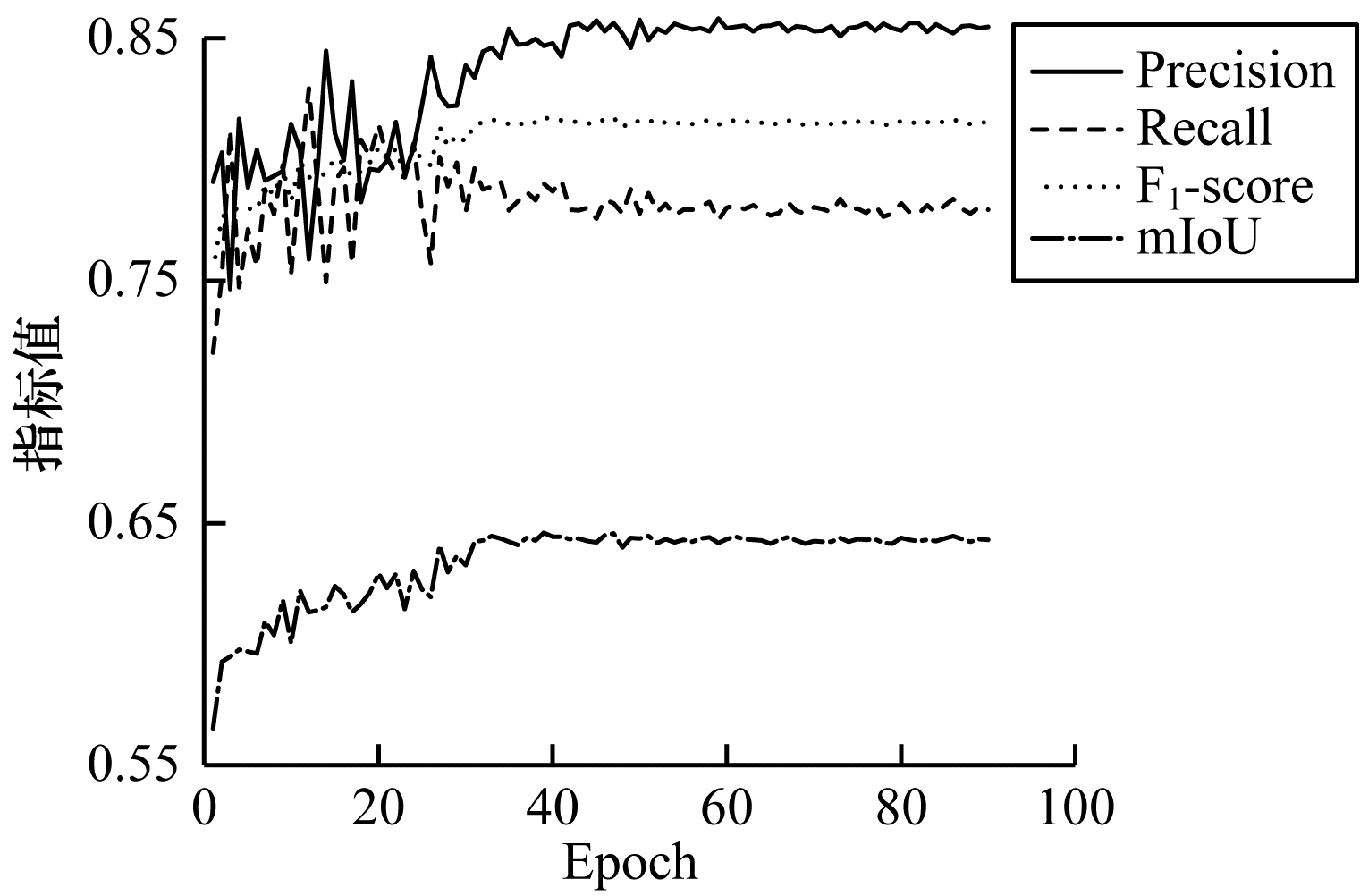

图 7和图 8所示分别为经过90轮迭代,D-LinkNet和本文提出的改进D-LinkNet各项评价指标随迭代次数变化的折线图。

|

Download:

|

| 图 7 D-LinkNet各项评价指标迭代折线图 Fig. 7 Iteration line diagram of D-LinkNet each evaluation index | |

|

Download:

|

| 图 8 改进D-LinkNet各项评价指标迭代折线图 Fig. 8 Iterative line diagram of improve D-LinkNet evaluation index | |

从图 7和图 8可以看出,当各项指标趋于稳定之后,本文改进的网络均高于原始网路。其中:精确率由原来的0.817 3增长到0.854 9;召回率由之前的0.743 3增长到0.779 3;F1-score从0.778 6增长到0.815 4;mIoU从0.637 4增长到0.663 1。4项指标分别约增长了3.8、3.6、3.7和2.6个百分点。不难得出,改进后网络的道路分割性能较之前有显著改善,预测效果明显提升。

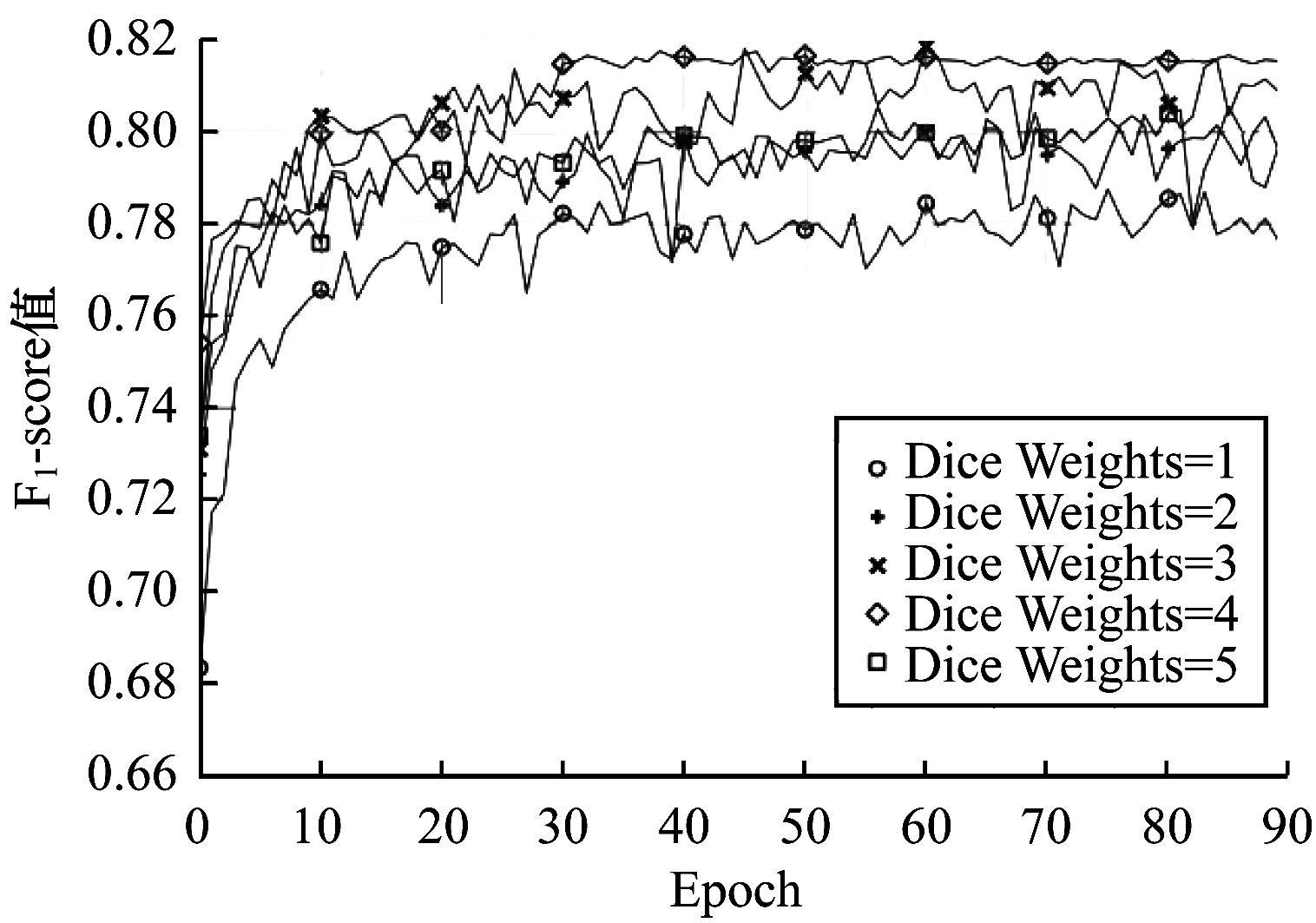

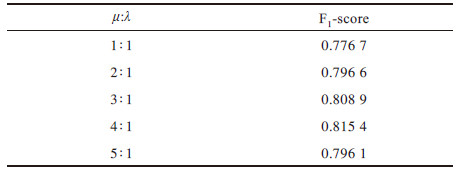

2.6 损失函数超参数权重实验对于式(10)中DICE+BCE损失设定的超参数权重比值,固定

如图 9所示,本文设定的5种超参数权重比的F1-score会随着迭代轮次的增加呈现上升的趋势。通过对比可以发现,当没有设定超参数权重(即权重比为1∶1)时,F1-score的分数最低,经过90轮迭代的取值仅为0.776 7;而当权重比为4∶1时,其F1-score的分数最高,达到0.815 4。并且,该权重比下网络的预测性能处于较为稳定的状态。5种超参数权重比的性能对比如表 1所示。

|

Download:

|

| 图 9 不同权重比的F1-socre迭代折线图 Fig. 9 F1-score iteration line graph of different weight ratio | |

|

下载CSV 表 1 不同超参数权重比的性能对比 Table 1 Performance comparison of different super parameter weight ratio |

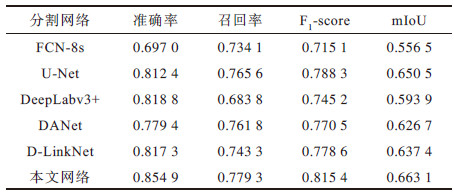

为进一步验证本文提出网络的准确性与有效性,选取FCN-8s、U-Net[21]、DeepLabv3+[22]、DANet[16]和D-LinkNet5种用于道路分割的经典网络与本文提出的网络进行实验对比。

FCN-8s网络模型共包含13个卷积层、2个转置卷积层和5个池化层。在训练过程中为实现模型的稳定性及收敛性,适当降低网络的振幅及调整学习参数,加快网络的收敛速度,以提升网络模型的准确性和高效性。U-Net网络模型能够利用拼接技术进行道路特征信息的融合,加宽网络的深度,强化道路特征信息,其在道路提取任务中表现得更为出色,准确率也更高。该模型在下采样过程中,每张图像后面复用2个3×3的卷积层,每个卷积层后包含1个非线性ReLU层,第2个复用的卷积层后有1个尺寸为2×2的最大池化层。上采样过程使用1个反卷积层,后面复用2个3×3的卷积层和非线性层。在网络的最后一层添加1个1×1的卷积层,将特征向量映射到输出分割的道路图像上。DeepLabv3+网络模型添加了空洞卷积层,卷积核尺寸为3×3,扩张率为2。另外,卷积层后紧接着添加1个ReLU层、1个BN层以及1个1×1的卷积层,目的是降低道路提取过程中的运算量,提高模型的效率。DANet网络模型是将含通道的特征图与其本身转置相乘,利用一个softmax层做归一化处理,再与原始特征图的转置相乘,最终将道路信息映射到原始特征图上,输出道路提取后的相关性信息。表 2所示为不同分割网络经过90轮训练迭代的各项评价指标数据对比。

|

下载CSV 表 2 不同道路分割网络评价指标对比 Table 2 Evaluation indexes comparison of different road segmentation networks |

当前几种热门的经典网络与本文提出网络的道路预测图如图 10所示。由图 10(c)~到图 10(h)结合表 2可知,FCN-8s、DeepLabv3+以及DANet的道路分割效果及评价指标较差,而U-Net与D-LinkNet的分割效果较为理想。本文以D-LinkNet为基础框架,进行一系列的改进措施,增强了网络道路像素点的识别能力。实验结果表明,本文提出的改进D-LinkNet网络在高分遥感影像道路提取任务中的表现相对于分割网络更具有优势。

|

Download:

|

| 图 10 本文网络与经典网络的道路预测图 Fig. 10 Road prediction diagram of this paper network and classic network | |

本文在D-LinkNet分割网络的基础上,针对高分影像道路提取中出现的“虚检”“漏检”“误检”问题,提出改进的D-LinkNet网络模型。在原始分割网络的基础上引入channel-spatial双注意力机制,同时基于原始的DICE+BCE损失对其进行改进,构建一种超参数权重损失,并按照先验比例设定超参数权重,通过实验得出最佳的超参数权重比。实验结果表明,本文提出的改进D-LinkNet网络模型在Massachusetts Road Datasets上的表现要优于原始D-LinkNet分割网络。下一步将围绕模型的优化算法对网络模型的分割性能进行优化,尝试使用当前较主流Adam等优化算法提升网络的运算效率。另外,对于模型主干架构的轻量化也是今后的研究方向。

| [1] |

XIONG S, LI L M, HUANG Y Q. Unstructured road detection based on wavelet transform and K-means[J]. Computer Engineering, 2014, 40(2): 158-161. (in Chinese) 熊思, 李磊民, 黄玉清. 基于小波变换和K-means的非结构化道路检测[J]. 计算机工程, 2014, 40(2): 158-161. DOI:10.3969/j.issn.1000-3428.2014.02.034 |

| [2] |

WANG W, YANG N, ZHABF Y, et al. A review of road extraction from remote sensing images[J]. Journal of Traffic and Transportation Engineering, 2016, 3(3): 271-282. |

| [3] |

HEROLD M, ROBERTS D. Spectral characteristics of asphalt road aging and deterioration: implications for remote-sensing applications[J]. Applied Optics, 2005, 44(20): 4327-4334. DOI:10.1364/AO.44.004327 |

| [4] |

XU R, TAO Y, LU Z, et al. Attention-mechanism-containing neural networks for high-resolution remote sensing image classification[J]. Remote Sensing, 2018, 10(10): 1602-1611. DOI:10.3390/rs10101602 |

| [5] |

WANG M L, WANG G, GUO X X, et al. Remote sensing image fusion based on cross-layer copy connection convolutional neural network[J]. Journal of Jilin University Science Edition, 2020, 58(4): 913-922. (in Chinese) 王明丽, 王刚, 郭晓新, 等. 基于跨层复制连接卷积神经网络的遥感图像融合[J]. 吉林大学学报(理学版), 2020, 58(4): 913-922. |

| [6] |

ZAIMBASHI A, LI J. Tunable adaptive target detection with kernels in colocated MIMO radar[J]. IEEE Transactions on Signal Processing, 2020, 1(1): 1-15. |

| [7] |

CORONA E, ALENY G, GABAS A, et al. Active garment recognition and target grasping point detection using deep learning[J]. Pattern Recognition, 2018, 74: 629-641. DOI:10.1016/j.patcog.2017.09.042 |

| [8] |

LI P, ZANG Y, WANG C. Road network extraction via deep learning and line integral convolution[C]//Proceedings of the 36th IEEE International Geoscience and Remote Sensing Symposium. Washington D.C., USA: IEEE Press, 2016: 1599-1602.

|

| [9] |

XIA W, ZHONG N, GENG D, et al. A weakly supervised road extraction approach via deep convolutional nets based image segmentation[C]//Proceedings of IEEE International Workshop on Remote Sensing with Intelligent Processing. Washington D.C., USA: IEEE Press, 2017: 1-5.

|

| [10] |

DONG P, SHI F K. A road detection method based on small UAV aerial image[J]. Computer Engineering, 2015, 41(12): 36-39. (in Chinese) 董培, 石繁槐. 基于小型无人机航拍图像的道路检测方法[J]. 计算机工程, 2015, 41(12): 36-39. DOI:10.3969/j.issn.1000-3428.2015.12.007 |

| [11] |

ZHOU L C, ZHANG C, WU M. D-LinkNet: LinkNet with pretrained encoder and dilated convolution for high resolution satellite imagery road extraction[C]//Proceedings of the 31st IEEE/CVF Conference on Computer Vision and Pattern Recognition. Washington D.C., USA: IEEE Press, 2018: 182-186.

|

| [12] |

CHEN L C, ZHU Y K, PAPANDREOU G, et al. Encoder-decoder with atrous separable convolution for semantic image segmentation[C]//Proceedings of European Conference on Computer Vision. Berlin, Germany: Springer, 2018: 833-851.

|

| [13] |

HE K M. Deep residual learning for image recognition[C]//Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition. Washington D.C., USA: IEEE Press, 2016: 770-778.

|

| [14] |

HU J, SHEN L, SUN G. Squeeze-and-excitation networks[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Washington D.C., USA: IEEE Press, 2018: 7132-7141.

|

| [15] |

JADERBERG M, SIMONYAN K, ZISSERMAN A. Spatial transformer networks[C]//Proceedings of IEEE ANIPSʼ17. Washington D.C., USA: IEEE Press, 2015: 2017-2025.

|

| [16] |

FU J, LIU J, TIAN H J. Dual attention network for scene segmentation[C]//Proceedings of 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Washington D.C., USA: IEEE Press, 2019: 3146-3154.

|

| [17] |

YU C Q, WANG J B, PENG C, et al. BiSeNet: bilateral segmentation network for real-time semantic segmentation[C]//Proceedings of the 15th European Conference on Computer Vision. Washington D.C., USA: IEEE Press, 2018: 334-349.

|

| [18] |

HAN X Y, WANG R D. Computation of credit portfolio loss distribution by a cross entropy method[J]. Journal of Applied Mathematics and Computing, 2016, 52(1/2): 287-304. |

| [19] |

COX D R. The regression analysis of binary sequences[J]. Journal of the Royal Statistical Society, 1958, 20(2): 215-232. |

| [20] |

CORTES C, VAPNIK V. Support-vector networks[J]. Machine Learning, 1995, 20(3): 273-297. |

| [21] |

RONNEBERGER O, FISCHER P, BROX T. U-net: convolutional networks for biomedical image segmentation[C]//Proceedings of the 18th International Conference on Medical Image Computing and Computer-Assisted Intervention. Washington D.C., USA: IEEE Press, 2015: 234-241.

|

| [22] |

WANG J Q, LI J S, ZHOU H C, et al. A typical element extraction method of remote sensing image based on Deeplabv3+ and CRF[J]. Computer Engineering, 2019, 45(10): 260-265, 271. (in Chinese) 王俊强, 李建胜, 周华春, 等. 基于Deeplabv3+与CRF的遥感影像典型要素提取方法[J]. 计算机工程, 2019, 45(10): 260-265, 271. |

| [23] |

FU J, LIU J, TIAN H J. Dual attention network for scene segmentation[C]//Proceedings of 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Washington D.C., USA: IEEE Press. 2019: 3146-3154.

|

2021, Vol. 47

2021, Vol. 47