2. 江苏省媒体设计与软件技术重点实验室, 江苏 无锡 214122

2. Jiangsu Key Laboratory of Media Design and Software Technology, Wuxi, Jiangsu 214122, China

开放科学(资源服务)标志码(OSID):

随着深度学习等新型机器学习技术的出现,人工智能受到广泛关注,计算机视觉作为其中的热点研究方向,已经在算法、实际应用等方面取得了丰富的成果[1-2]。然而,目前人工智能算法的适应能力和人类认知仍然存在较大的差距,亟需更为深入地研究人类视觉认知系统对感知信号的处理模式,发展形成更深刻的视觉认知计算理论。

无人驾驶作为最受期待的实际应用场景之一,在感知周围环境的基础上,完成对车辆驾驶的行为决策[3]。在众多科技公司中,以特斯拉为代表的智能驾驶汽车公司已将具有智能决策功能的车辆进行量产化。然而,当面对外界障碍物干扰时,基于视觉传感器的智能驾驶系统无法正常地进行感知和决策,最终导致自动驾驶汽车伤亡事故[4],这与人类在复杂场景中感知外界信息并做出正确决策的能力存在很大的差距[5]。本文从人类视觉和无人驾驶技术的应用出发,以拓扑性质和空间拓扑关系为主要实验视角,探讨人眼视觉的认知过程。

拓扑性质知觉理论回答了认知神经科学领域“视觉处理从哪里开始”的基本问题,即视觉系统优先发生大范围的拓扑性质感知[6]。其中,“优先”有两个严格的含义:第一,由拓扑性质决定的整体组织是知觉局部几何性质的基础;第二,拓扑性质感知发生的时间早于局部几何性质的感知[6]。在任意拓扑变换下保持不变的性质称为拓扑性质。拓扑性质涉及连通性、孔的数量和内外部关系等[6-7],本文主要研究人眼视觉对于包含“孔”的对象物体的拓扑性质。

针对三维空间情形,需要进一步考虑空间中物体运动所伴随的空间拓扑关系变化[8]。EGENHOFER等提出了一种用边界交集的成分来描述对象间或区域间拓扑关系的方法。边界交集成分指的是两个区域边界相交的部分,这些相交的部分包含不同的维数、有界性等,可以详细表示两个自身属性复杂的对象间的空间拓扑关系[8]。拓扑关系作为空间中的基本关系,是空间推理研究的基本问题之一,因此,研究对象间的空间拓扑关系在人眼视觉认知过程中起到重要作用。

本文提出一种针对人眼视觉运动认知特性的实验分析方法。实验系统基于Unity3D引擎平台,结合Logitech G29驾驶设备、HTC VIVE虚拟现实头戴显示器等相关设备的构建,通过响应面分析方法设计实验研究不同拓扑复杂度和空间拓扑关系,结合虚拟现实实验系统中的具体实现场景,依据无感反馈中的实时眼动跟踪数据——眼动轨迹,研究在不同维度的场景中人眼视觉对于物体不同运动变化情形的认知响应特性。轨迹图作为眼动追踪数据可视化的一种标准输出形式,可以准确表征受试者的交互意图和视觉认知过程,表达出“所见即所得”的客观实验结果,从而提高视觉认知研究的准确性[9]。

1 视知觉研究背景 1.1 视觉注意选择机制视觉系统作为一个选择性的信息加工系统,在任何认知过程中视觉注意优先选择有限的外界信息进行加工。在早期视觉注意力选择机制的作用下,人们可以快速地从复杂环境中找到认知的对象,并将该对象信息传递至大脑皮层处进行处理和分析[10]。影响视觉注意选择的因素大致分为两种:一种是在指定的认知任务或主观意图下,只有与任务相关的刺激对象才会被注意;另外一种是视觉场景中的凸显刺激,即具有显著特征的刺激才能无意识地吸引视觉注意,这也称为“注意捕获”。在这两种视觉因素的影响下,注意选择机制包含两种方式的视觉信息加工过程:自下而上和自上而下的加工机制[10]。自下而上的注意选择机制是以显著刺激为驱动,其认知对象是基于人眼所观察到的刺激信息[11]。相关刺激信息的加工过程涵盖三方面递进阶段,即获取刺激对象的相关信息、合成完整的图案以及最后的模式匹配。在递进过程中,注意力不断增加,有用信息在持续的加工和筛选下,传递至大脑皮层进行分析,无用信息即视觉没有注意到的信息则会流失。然而,通常情况下都是大脑向下传达指令信息,视觉注意在该目标导向下发生自上而下的信息加工机制,进而人眼不断搜索相近信息的刺激对象。

近年来,计算机视觉在显著性对象检测方面取得了非常大的进步,主要分为两条研究路线:人眼注视预测和显著对象检测。人眼注视预测是通过检测人眼注视轨迹从而估计个体对当前场景中感兴趣的区域。显著性对象检测主要是检测出场景中容易吸引人们注意(显著特征)的对象并将其从背景中分割出来[13]。本文以人眼注视预测为主要研究路线,通过眼动追踪技术探索人眼视知觉对于刺激对象不同拓扑复杂度和空间拓扑关系的认知特性。

1.2 拓扑性质知觉理论对于拓扑复杂度和空间拓扑关系的研究,都涉及到一个重要的概念,即拓扑概念。在任意拓扑变换下保持不变的性质称为拓扑性质[14],拓扑性质是图形整体结构中的一类特殊性质,是各种几何性质中最为稳定的性质。我国著名认知科学家陈霖提出的拓扑性质知觉理论表明,在人类视知觉过程中,物体全局拓扑性质优先被视觉系统感知,其次才会感知到亮度、运动等局部特征。拓扑性质涉及空间连通性、孔的数量和内外关系等[14]。

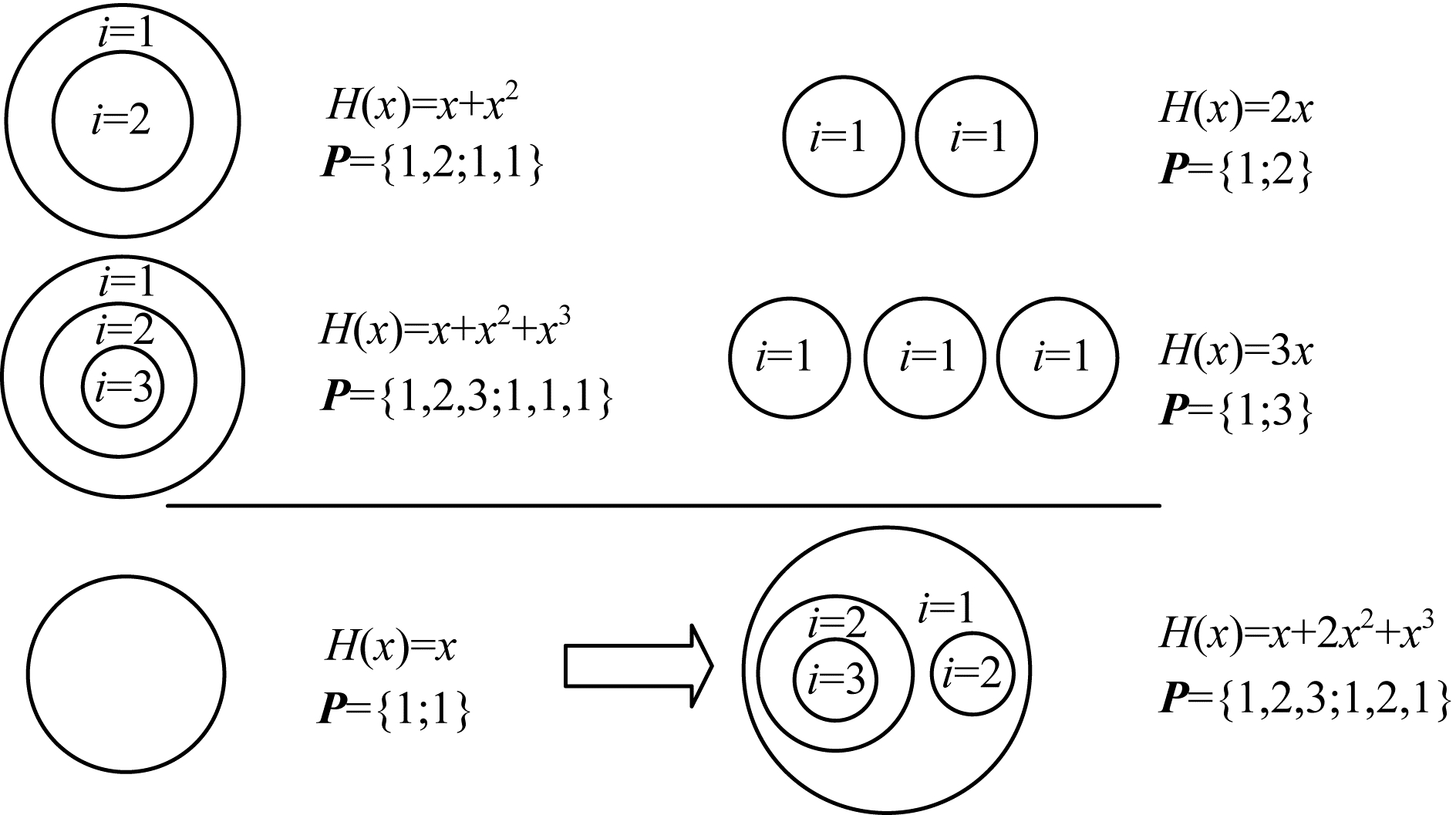

人类视觉在背景空间中优先注意具有大范围拓扑性质的物体正是因为孔的拓扑特性。图形-地面组织的包围性的Gelstalt行列式,在数学语言中就是孔的拓扑特性。将完整的图形对象视为一种模式,接触边界的区域被认为是“孔的边界”,而没有接触边界的区域被认为是“孔”。此外,还可利用拓扑描述符和拓扑孔函数来描述图形的简化结构中所包含的拓扑特性[7]。

本文采用的拓扑孔函数表达形式如下:

| $ H\left(x\right)=\sum\limits _{i=1}^{n}{b}_{i}{x}^{i} $ | (1) |

其中:

以图 1为例,右下角所示图形的拓扑孔函数表示为

|

Download:

|

| 图 1 孔函数和拓扑描述符示意图 Fig. 1 Schematic diagram of hole functions and topological descriptors | |

综上所述,孔函数和拓扑描述符之间有着密切的关联,都可以用来描述物体的拓扑特性。其中,总和

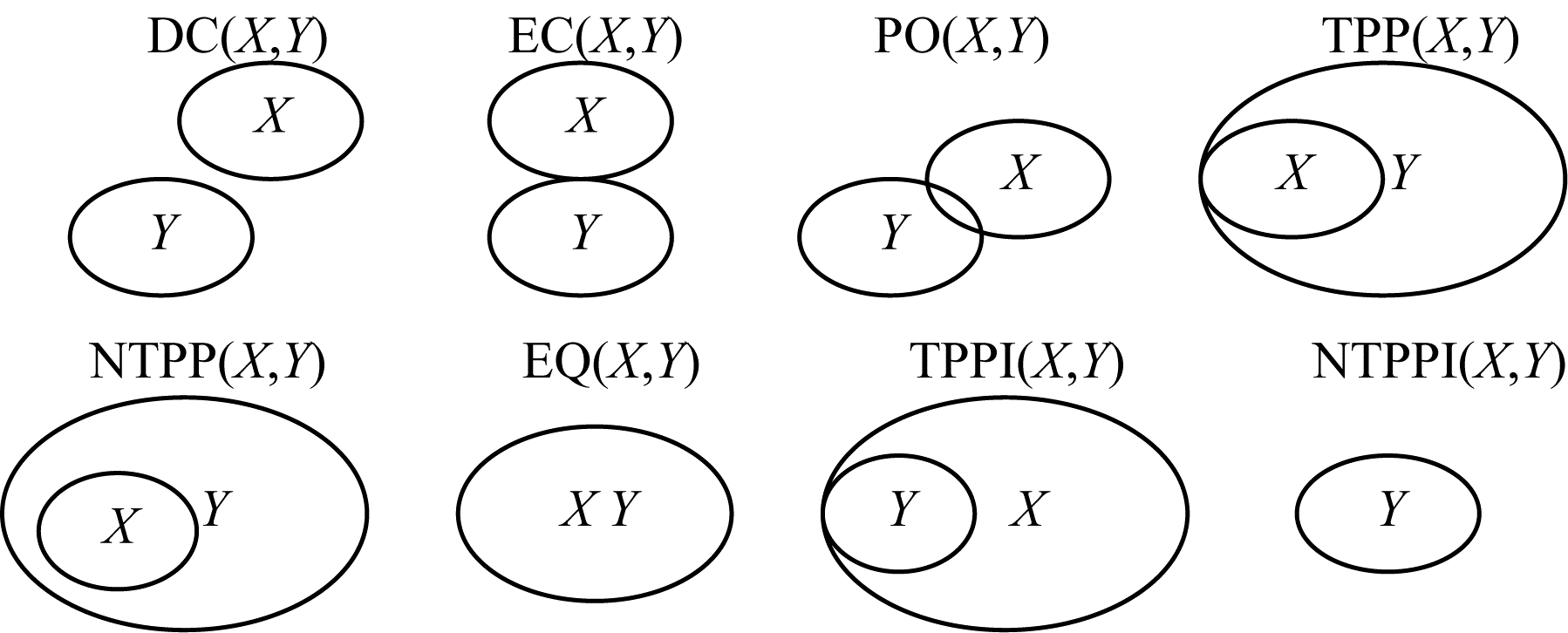

人类生活的空间是一个三维立体空间,物体间的空间关系和物体本身的属性同样重要,对于拓扑关系的研究在空间关系中占有重要的指导地位。空间拓扑关系是指拓扑变换(平移、旋转、缩放等)下的拓扑不变量,是空间关系的一种[15]。空间拓扑关系表示方法包含定性表示、定量表示、定性与定量结合表示三类,其中定性表示是在更高层次上抽象空间对象及关系描述[15],由于空间存在一些复杂且不确定性的问题,表示和推理空间关系普遍采用定性的方法。拓扑关系作为最基本的空间关系,可以产生定性差异,空间对象拓扑关系的定性研究主要分为两条路线:确定性区域间拓扑关系的研究和不确定性区域的表示及其分析方法的研究,本文以确定性区域间的空间拓扑关系为主要研究路线。确定性区域指的是空间对象隐含着的边界确定性。RCC形式化模型是目前相关研究中最具有代表性的模型之一,该模型的目的是对空间对象的拓扑关系进行分类,对数量大、复杂度高的空间对象拓扑关系进行合理化的分类,通过形式化描述模型分析出有限空间拓扑关系[16]。本文主要介绍RCC模型中最具代表性的RCC-8关系集[16],如图 2所示。RCC-8关系集包含不连接(DC)、外部连接(EC)、部分交叠(PO)、正切真部分(TPP)、非正切真部分(NTPP)、相等(EQ)、反正切真部分(TPPI)和反非正切真部分(NTPPI)。本文主要基于TPP空间拓扑关系和NTPP空间拓扑关系进行实验,通过控制图中物体X的平移方式,即运动状态,进而实现这两种空间拓扑关系间的转变。

|

Download:

|

| 图 2 区域间的RCC-8关系 Fig. 2 RCC-8 relationships between areas | |

空间推理是指利用空间理论和人工智能技术对空间对象进行建模、描述和表示,并据此对空间对象间的空间关系进行定性或定量分析和处理的过程[17]。目前,空间推理被广泛应用于机器人导航、高级视觉、工程设计、智能驾驶的常识性推理等方面,同时也是人工智能领域的一个研究热点[18]。

2 眼动追踪视觉注意实验方法 2.1 实验目的依据上文讨论,现有的视觉拓扑研究大多集中在二维空间中,对于日常生活中的具体应用还未广泛地进行研究。相对地,日常驾驶环境下人类对于刺激对象的视觉拓扑认知过程的相关实验研究鲜有报道。本文拟通过虚拟现实视觉行为实验,以眼动跟踪数据作为主要的视觉认知分析数据集,进而探索日常驾驶环境中人眼视觉注意对于刺激对象的运动认知特性。

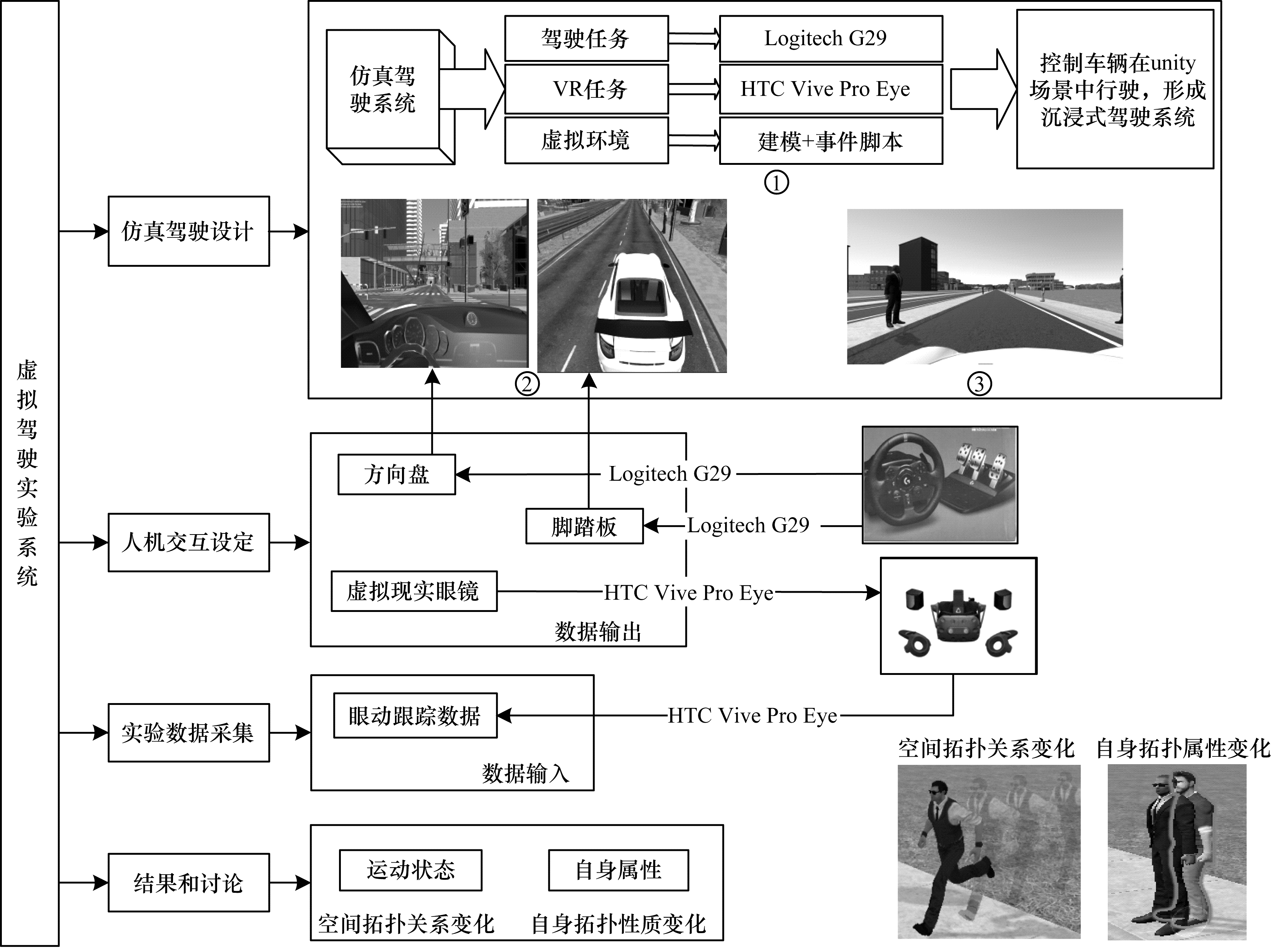

2.2 实验框架本文设计的仿真驾驶认知实验结合了虚拟现实[19]和人机交互两大主流技术,并根据驾驶认知系统的不同功能划分为4个模块,即仿真驾驶设计模块、人机交互设定模块、被试的认知响应眼动跟踪数据采集模块以及结果讨论模块,不同模块之间通过接口参数和场景界面完成信息的传递。

仿真驾驶设计模块是整个实验系统的核心,包含本文实验方法的三条主要路线,即虚拟环境的制作、VR任务的呈现以及仿真驾驶任务的实现,如图 3中①部分所示。实验全程在沉浸式虚拟现实环境下进行,虚拟环境使用游戏引擎Unity2019.4.26f1和C#进行编程[20],运行于Windows 10 Home电脑,配置为64位操作系统、Intel Core i9-10850K,3.6 GHz、32 GB RAM和NVIDIA GeForce RTX 3070显卡。VR任务使用HTC-Vive来呈现,这是一种6自由度VR系统,由一个头戴显示器和两个手持控制器组成。虚拟环境中的眼动跟踪数据是使用HTC Vive Pro Eye中内置的眼动仪Tobii进行采集的。Tobii的精度估计为0.5°~1.1°,采样频率为120 Hz。仿真驾驶任务使用罗技G29来实现,驾驶员的操作由罗技G29设备采集并送入Unity场景下模拟车辆的动态系统。实验的具体设计如图 3中②和③部分所示,包含相关事物模型的搭建,涉及城市街道中的建筑物、街道、指示牌和树木等,以及驾驶车辆的内部结构和外形设计等。

|

Download:

|

| 图 3 视觉注意认知虚拟实验系统 Fig. 3 Virtual experiment system of visual attention cognition | |

人机交互设定模块和实验数据采集模块是对上述驾驶实验设计框架的细节性解释,描述的是实验内容的具体实现方式:将Logitech G29中的方向盘和脚踏板外界驾驶设备作为虚拟场景中汽车的响应输入设备,当真实环境中的驾驶者操作相关驾驶设备时,Unity3D场景下的虚拟车辆运行相同的行驶状态。整个驾驶实验过程是基于HTC Vive Pro Eye虚拟现实头戴显示器进行的,以虚拟现实眼镜作为主视角的视觉输出设备,从而实现沉浸式的汽车驾驶[21]。

实验数据的采集利用眼动追踪技术,即通过记录眼动轨迹并从中提取诸如注视点个数、注视时间、眼跳距离及瞳孔大小等数据,从而研究个体的内在认知过程[22]。本文利用HTC Vive Pro Eye中与Vobling AB共同研发的眼动追踪数据分析工具Tobii眼动仪[21],在虚拟环境中提取到被试实验过程中的实时眼动追踪数据,并且将该数据进行可视化处理[23-24],利于本文后续过程中的实验结果分析。最后的结果和讨论模块,主要在空间拓扑关系(运动状态变化)和拓扑性质(自身属性变化)这两种变化下对人类视觉注意认知过程存在的认知特性进行相关讨论。

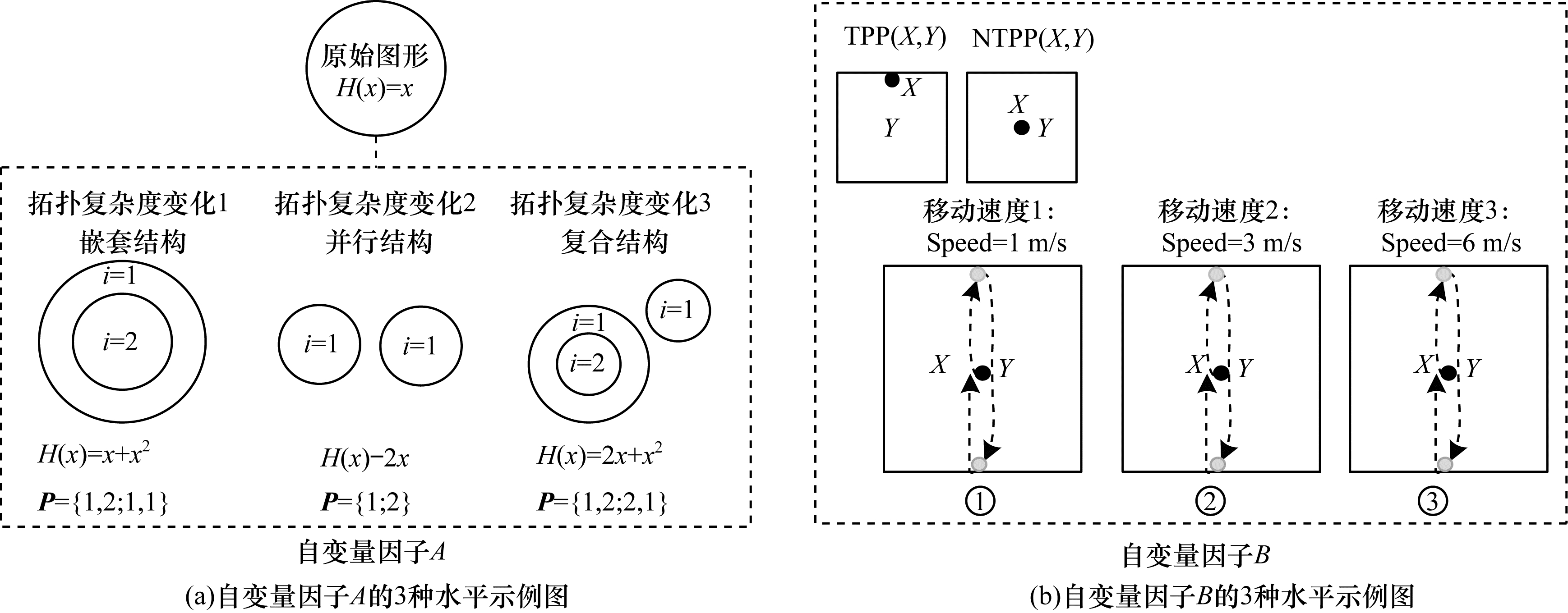

2.3 实验内容实验主要测试在二维图形认知环境和三维驾驶行为认知环境下,对象自身拓扑性质、对象间的空间拓扑关系与人眼视觉注意的相关认知关系,其中包含自变量因子

基于上文中拓扑复杂度和空间拓扑关系的相关描述内容,设计如图 4所示的实验思路。

|

Download:

|

| 图 4 自变量因子A和自变量因子B的3种水平示例图 Fig. 4 Diagram of an example of three levels of independent variable factor A and independent variable factor B | |

图 4(a)显示了主要的自变量因子

图 4(b)显示了空间拓扑关系的设计思路,左上角图形标识了TPP和NTPP两种空间拓扑关系,这两种空间拓扑关系之间的转化通过对象

据以上实验思路,本文基于Unity3D引擎平台设计在二维空间中人眼视觉对于动态拓扑变化和运动状态变化的认知实验。在正式实验之前,需要对被试进行预实验流程,主要是让被试了解整个实验过程。正式实验程序如图 5所示,实验中呈现的图形分为标准图形(只有1种:正方形)和13个刺激图形(标准图形有2类:拓扑变化图形和运动状态变化图形)。首先向被试呈现标准图形,紧接着呈现一对刺激图形,包含拓扑性质变化和运动状态变化两种刺激,当前流程图中显示的是拓扑复杂度变化1和移动速度3两种刺激,需要再次恢复成标准图形利于放松眼部运动。整个过程共呈现13项注意认知项目,每个项包含一对刺激图形,如图 5右上角所示,其中包含拓扑变化和运动状态变化,两种变化发生的位置左右随机出现,最后呈现结束画面。标准图形在头戴显示器中的显示时间是5 s,单个刺激图形的显示时间是1 s,整个二维图形认知实验用时约2 min。

|

Download:

|

| 图 5 二维图形认知实验过程 Fig. 5 Two-dimensional graphic cognitive experiment process | |

为了将2.3.1节中描述的二维空间中简单图形的认知实验思路应用于三维空间,基于人类的日常驾驶活动,本文设计三维空间中的仿真驾驶行为认知实验。将陈霖的拓扑性质知觉理论和空间拓扑关系应用于三维空间中的日常驾驶活动,实验思路如图 6所示,其中,①展示的是空间拓扑关系的转换过程,通过对象

|

Download:

|

| 图 6 三维空间驾驶行为认知场景 Fig. 6 Cognitive scene of driving behavior in three-dimensional space | |

在三维空间驾驶行为认知实验中,基于Unity3D引擎进行实验场景的搭建及自变量因子的设置,如图 6右上角图片所示。被试被放置在一个模拟城市街道的小轿车中,街道中包含建筑物、车辆和行人等,其中路边的行人状态包含正常静态站立状态、发生自身拓扑属性变化的状态(刺激)以及发生运动状态变化的状态(刺激)。被试需要在执行正常驾驶任务的前提下注意路边出现的刺激对象,并且用视觉注视来进行定位。在12项注意认知项目中,8项同时出现两种刺激对象(自身拓扑属性改变的刺激对象和运动状态改变的刺激对象),2项仅出现运动状态改变的刺激对象,2项仅出现拓扑属性改变的刺激对象。

虚拟场景中的驾驶任务是由被试借助外部Logitech驾驶模拟器组件完成的,将罗技驾驶模拟器中的G29方向盘、汽车踏板作为虚拟驾驶的数据输入设备,通过采集G29力反馈方向盘及踏板的启动、转向、加速踏板和制动踏板,将实时获得的驾驶速度和方向盘转角等驾驶数据信息传输至Unity3D平台下控制车辆行驶的相关代码中,从而控制场景中虚拟车辆的相应行驶状态。为了提供更好的驾驶体验效果,本文将车辆的行驶速度控制在50 km/h以下,整个三维驾驶认知实验用时约为2 min。

上文设计的两个认知实验均要求被试在全程配戴虚拟现实眼镜的条件下进行,实验开始后播放相应的视觉认知实验场景。同时,利用HTC Vive Pro Eye中集成的眼动追踪工具,实现全程同步记录受试者发生视觉认知时的眼部轨迹数据,通过分析被试的眼动跟踪数据,探讨人眼视觉注意的认知优先特性。

3 实验结果与分析实验中使用HTC Vive Pro Eye虚拟现实头戴显示器中的眼动集成工具,被试在佩戴虚拟现实眼镜进行实验的同时,眼镜内置的眼动监测设备可以捕捉双眼实时的运动轨迹。实验通过改写眼动监测的相关代码,将实时监测到的眼动轨迹数据存储至工程文本文件中,从而有利于本文对实验数据的对比分析以及眼动轨迹在场景中的再现。实验主要通过眼动轨迹了解视觉认知的总体情况,本文在测试的总样本中选取20个眼动跟踪标准样本数作为实验结果分析的依据。在每个被试进行实验之前,均要求重新校准眼动追踪,即被试眼睛按照屏幕中显示的校准点进行移动从而执行校准过程。然后运行Unity3D引擎,通过VR眼镜呈现不同的实验场景,并同时采集被试在场景中的一系列眼动注视点

二维图形认知实验和三维驾驶运动认知实验均采用响应面分析方法对实验变量进行有效设计和分析,Design-Expert是一款专业的响应面数据分析软件,包含实验设计、实验分析和实验优化功能[25],本文主要利用实验设计功能,通过随机生成的变量水平,设计场景中相对应的刺激变量。

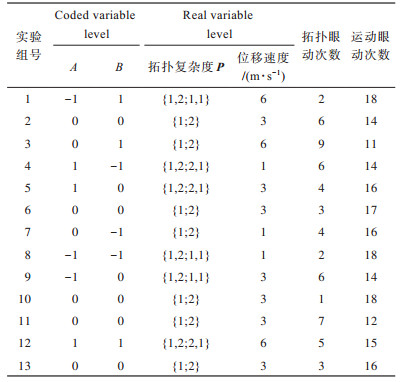

二维图形认知实验设计及结果如表 1所示,Central Composite实验设计分为13个实验组别,分别包含自变量因子A和自变量因子B,其中,Coded variable level是Design-Expert软件设计的随机实验数值,表示每个变量因子有3种水平(-1、0、1),Real variable level是变量的不同水平,在实验场景中所对应的实际状态,自变量因子A的3种水平,分别对应拓扑复杂度变化1、拓扑复杂度变化2和拓扑复杂度变化3,自变量因子B的3种水平分别对应3种运动速度(移动速度1、移动速度2、移动速度3)。最后在选定的20个被试样本中,分别统计同时出现这两个变量时,被试的眼动跟踪轨迹优先发生在拓扑性质变化的次数和发生在运动状态变化的次数。

|

下载CSV 表 1 二维图形认知实验中变量因子A和变量因子B的水平和相应的眼动次数 Table 1 Levels of variable factor A and variable factor B and corresponding number of eye movements in two-dimensional figure cognition experiment |

从表 1中可以看出,在13组随机实验中,20个被试优先识别拓扑变化的次数分别是2、6、9、6、4、3、4、2、6、1、7、5、3,优先识别运动状态变化的次数分别是18、14、11、14、16、17、16、18、14、18、12、15、16。运动状态的眼动次数明显多于拓扑变化的眼动次数,显然,当呈现不同拓扑复杂度的拓扑性质变化和不同速度的运动状态变化时,被试普遍优先发生运动状态的注意捕获。

同样,可以将记录在工程文本文件中的眼动跟踪数据还原绘制在驾驶实验场景中,并对场景中出现的13组刺激图形下的不同被试眼动轨迹分布进行对比分析。随机选取单个被试的眼动跟踪数据,并将其还原绘制在二维图形认知场景中,二维图形认知实验眼动轨迹对比结果如图 7所示(彩色效果见《计算机工程》官网HTML版)。其中:白色球体表示被试优先识别的对象;红色球体表示被试的眼睛注视位置。

|

Download:

|

| 图 7 一组二维图形实验眼动轨迹对比结果 Fig. 7 Comparison results of eye movement trajectories of one group of two-dimensional graphics experiment | |

在当前选取的一组眼动轨迹数据中,剔除干扰数据,有效眼动轨迹数据有13组,共包含508个。其中被试优先注意到运动对象的眼动组次有11组,只有2组眼动轨迹优先出现在拓扑属性变化的刺激对象上,并且出现在运动刺激对象上的眼动注视数据有487个,注视在拓扑属性刺激对象上的数据有21个。通过眼动轨迹数据和结果图的对比可以明显看出,当发生拓扑属性变化的刺激图形和发生运动状态变化的刺激图形同时出现在场景中时,被试的眼动注视点优先且主要集中在运动状态变化的刺激对象上。

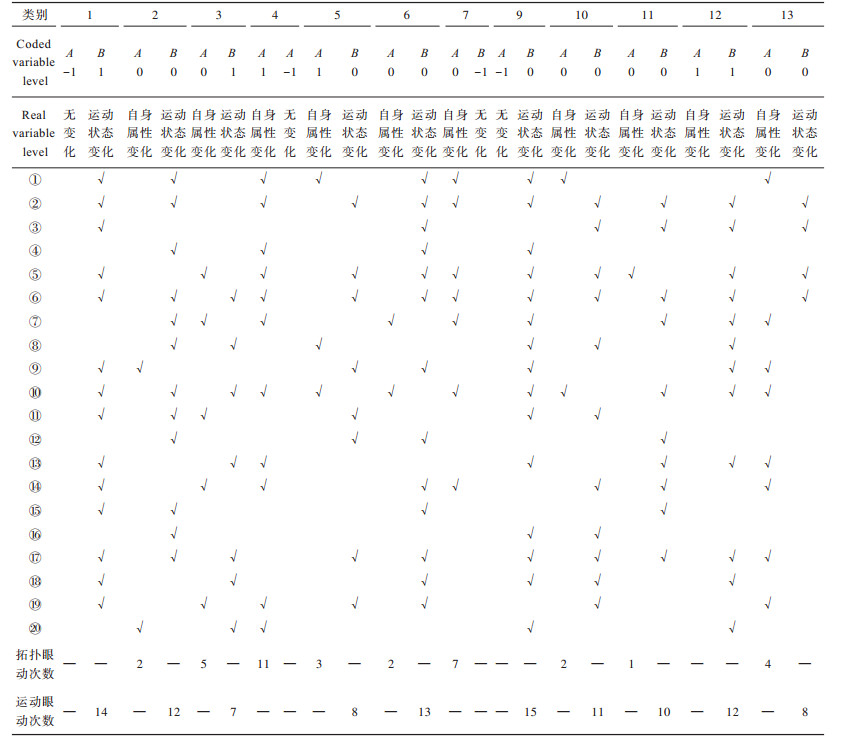

三维驾驶环境下的认知响应实验结果如表 2所示,Central Composite实验设计与二维图形认知实验基本相同,区别在于:变量因子A的3种水平(-1、0、1)分别对应实际场景中的无变化、自身属性变化,变量因子B的3种水平(-1、0、1)分别对应无变化、运动状态变化。由于当变量水平是-1时均无变化发生,因此隐藏了表中第8组数据(-1,-1)的表示。表 2中①~⑳分别表示实验中的20个被试者,根据采集每个被试者的眼动轨迹数据,眼动注视点优先出现在哪种变量上,即优先注意到哪种变化的发生,在该变量下进行勾选。可以清晰地从表中看出,多数被试都优先发生了运动状态的认知,并且20个被试优先识别拓扑变化的次数分别是2、5、3、2、2、1、4,优先识别运动状态变化的次数分别是12、7、8、13、11、10、12、8。通过对比分析可知,当拓扑性质变化和运动状态变化同时出现时,运动状态的变化更容易引起视觉发生注意捕获。

|

下载CSV 表 2 三维驾驶认知实验中变量因子A和变量因子B的水平和相应的眼动次数 Table 2 Levels of variable factor A and variable factor B and corresponding number of eye movements in three-dimensional driving cognitive experiment |

同样,随机选取单个被试的眼动跟踪数据,并将其还原绘制在驾驶场景中,三维驾驶实验眼动轨迹对比如图 8所示(彩色效果见《计算机工程》官网HTML版)。采集的被试眼动跟踪数据实际上代表眼球注视点在三维空间中的不同位置坐标

|

Download:

|

| 图 8 一组三维驾驶实验眼动轨迹对比结果 Fig. 8 Comparison result of eye movement trajectories in one group of three-dimensional driving experiment | |

在选取的一组眼动轨迹数据中,剔除了干扰数据,有效眼动轨迹数据有12组,共包含37个,其中被试优先注意到运动对象的眼动组次有10组,只有2组眼动轨迹优先出现在拓扑属性变化的刺激对象上,并且眼动注视点出现在运动对象上的数据共有29个,出现在自身拓扑属性上的数据共有8个。可以明显看出,在被试正常驾驶状态下时,其眼动注视点优先且主要集中在发生运动状态变化的刺激对象上,并且注视点多处于运动对象的腿部位置。

上述实验结果表明,通过定性和定量的数据分析,配合恰当的眼动跟踪轨迹图,可以真实地还原被试的认知过程。由此也可以分析发现,对于刺激对象运动状态的注意捕获优先发生在人眼视觉认知过程的早期阶段。

4 结束语本文对拓扑性质知觉理论和空间拓扑关系进行研究,基于虚拟现实仿真、人机交互、响应面分析、眼动跟踪等技术设计二维空间图形认知实验和三维空间驾驶行为认知实验分析方法,从而探索自身属性的拓扑性质变化和运动状态的空间拓扑关系变化在人眼视觉注意认知过程中的优先性。多角度的眼动跟踪数据可视化结果表明,在视觉认知过程中,相比运动对象自身拓扑性质的变化,人眼视觉优先识别对象运动状态相关的大范围空间拓扑关系的变化,这一结论在人工智能技术推动计算机实时感知和智能决策的同时,丰富了智能技术安全可靠的理论依据内容,为可信人工智能技术下的智能驾驶研究提供了驾驶视觉注意预测计算模式新思路。

| [1] |

VOULODIMOS A, DOULAMIS N, DOULAMIS A, et al. Deep learning for computer vision: a brief review[J]. Computational Intelligence and Neuroscience, 2018, 2018: 1-13. |

| [2] |

余京蕾. 浅谈计算机视觉技术进展及其新兴应用[J]. 北京联合大学学报, 2020, 34(1): 63-69. YU J L. A study on the progress of computer vision and its newly developing applications[J]. Journal of Beijing Union University, 2020, 34(1): 63-69. (in Chinese) DOI:10.16255/j.cnki.ldxbz.2020.01.010 |

| [3] |

CHEN Q P, XIE Y F, GUO S F, et al. Sensing system of environmental perception technologies for driverless vehicle: a review of state of the art and challenges[J]. Sensors and Actuators A: Physical, 2021, 319: 1-10. |

| [4] |

MA Y F, WANG Z Y, YANG H, et al. Artificial intelligence applications in the development of autonomous vehicles: a survey[J]. IEEE/CAA Journal of Automatica Sinica, 2020, 7(2): 315-329. DOI:10.1109/JAS.2020.1003021 |

| [5] |

VELLINGA N E. From the testing to the deployment of self-driving cars: legal challenges to policymakers on the road ahead[J]. Computer Law & Security Review, 2017, 33(6): 847-863. |

| [6] |

HE L, ZHOU K, ZHOU T, et al. Topology-defined units in numerosity perception[J]. Proceedings of the National Academy of Sciences of the United States of America, 2015, 112(41): 5647-5655. |

| [7] |

PENG P, YANG K F, LUO F Y, et al. Saliency detection inspired by topological perception theory[J]. International Journal of Computer Vision, 2021, 129(8): 2352-2374. DOI:10.1007/s11263-021-01478-4 |

| [8] |

WANG C Y, SHAO F J, ZHANG Z M, et al. Mining the features of spatial adjacency relationships to improve the classification of high resolution remote sensing images based on complex network[J]. Applied Soft Computing, 2021, 102: 1-10. |

| [9] |

黄龙, 徐富明, 胡笑羽. 眼动轨迹匹配法: 一种研究决策过程的新方法[J]. 心理科学进展, 2020, 28(9): 1454-1461. HUANG L, XU F M, HU X Y. Scanmatch: a new method for studying decision-making process[J]. Advances in Psychological Science, 2020, 28(9): 1454-1461. (in Chinese) |

| [10] |

王海燕, 黄雅梅, 陈默, 等. 图标视觉搜索行为的ACT-R认知模型分析[J]. 计算机辅助设计与图形学学报, 2016, 28(10): 1740-1749. WANG H Y, HUANG Y M, CHEN M, et al. Analysis of cognitive model in icon search behavior based on ACT-R model[J]. Journal of Computer-Aided Design & Computer Graphics, 2016, 28(10): 1740-1749. (in Chinese) DOI:10.3969/j.issn.1003-9775.2016.10.016 |

| [11] |

肖锋, 冯飞, 田鹏辉. 复杂场景下融合深度信息的显著区域匹配[J]. 计算机工程, 2017, 43(5): 248-254, 260. XIAO F, FENG F, TIAN P H. Salient region matching fused with depth information in complex scenes[J]. Computer Engineering, 2017, 43(5): 248-254, 260. (in Chinese) DOI:10.3969/j.issn.1000-3428.2017.05.040 |

| [12] |

刘扬, 杨伟, 郑逢斌. 视觉选择性注意的认知神经机制与显著性计算模型[J]. 小型微型计算机系统, 2014, 35(3): 584-589. LIU Y, YANG W, ZHENG F B. Cognitive neural mechanisms and saliency computational model of visual selective attention[J]. Journal of Chinese Computer Systems, 2014, 35(3): 584-589. (in Chinese) DOI:10.3969/j.issn.1000-1220.2014.03.029 |

| [13] |

徐芳, 刘晶红, 曾冬冬, 等. 基于视觉显著性的无监督海面舰船检测与识别[J]. 光学精密工程, 2017, 25(5): 1300-1311. XU F, LIU J H, ZENG D D, et al. Detection and identification of unsupervised ships and warships on sea surface based on visual saliency[J]. Optics and Precision Engineering, 2017, 25(5): 1300-1311. (in Chinese) |

| [14] |

朱滢. 陈霖的拓扑性质知觉理论[J]. 心理科学, 2005, 28(5): 1031-1034, 1030. ZHU Y. Chen Lin's theory of topological perception[J]. Psychological Science, 2005, 28(5): 1031-1034, 1030. (in Chinese) DOI:10.3969/j.issn.1671-6981.2005.05.002 |

| [15] |

陈占龙, 叶文. 复杂面实体拓扑关系的精细化模型[J]. 测绘学报, 2019, 48(5): 630-642. CHEN Z L, YE W. The precise model of complex planar objects' topological relations[J]. Acta Geodaetica et Cartographica Sinica, 2019, 48(5): 630-642. (in Chinese) |

| [16] |

虞强源, 刘大有, 谢琦. 空间区域拓扑关系分析方法综述[J]. 软件学报, 2003, 14(4): 777-782. YU Q Y, LIU D Y, XIE Q. A survey of analysis methods of topological relations between spatial regions[J]. Journal of Software, 2003, 14(4): 777-782. (in Chinese) |

| [17] |

高勇, 刘瑜, 邬伦, 等. 移动点对象与参考地物空间拓扑关系[J]. 计算机工程, 2007, 33(22): 57-59. GAO Y, LIU Y, WU L, et al. Spatial topological relations between moving points and reference features[J]. Computer Engineering, 2007, 33(22): 57-59. (in Chinese) |

| [18] |

雒海东, 宫海彦, 耿生玲. 一种复杂区域层次定性空间推理方法[J]. 计算机应用与软件, 2018, 35(10): 245-251. LUO H D, GONG H Y, GENG S L. A reasoning method of hierarchical qualitative space for complex region[J]. Computer Applications and Software, 2018, 35(10): 245-251. (in Chinese) |

| [19] |

HAMILTON D, MCKECHNIE J, EDGERTON E, et al. Immersive virtual reality as a pedagogical tool in education: a systematic literature review of quantitative learning outcomes and experimental design[J]. Journal of Computers in Education, 2021, 8(1): 1-32. |

| [20] |

SZALAI M, VARGA B, TETTAMANTI T, et al. Mixed reality test environment for autonomous cars using Unity 3D and SUMO[C]//Proceedings of the 18th World Symposium on Applied Machine Intelligence and Informatics. Washington D.C., USA: IEEE Press, 2020: 73-78.

|

| [21] |

MÜLLER L M, MANDON K, GLIESCHE P, et al. Visualization of eye tracking data in Unity3D[C]//Proceedings of the 19th International Conference on Mobile and Ubiquitous Multimedia. New York, USA: ACM Press, 2020: 343-344.

|

| [22] |

程时伟, 孙凌云. 眼动数据可视化综述[J]. 计算机辅助设计与图形学学报, 2014, 26(5): 698-707. CHENG S W, SUN L Y. A survey on visualization for eye tracking data[J]. Journal of Computer-Aided Design & Computer Graphics, 2014, 26(5): 698-707. (in Chinese) |

| [23] |

张欧平, 丁志刚, 彭娟春. 组合型人眼识别方法及其应用[J]. 计算机工程, 2011, 37(9): 223-225. ZHANG O P, DING Z G, PENG J C. Integrated method for eye recognition and its application[J]. Computer Engineering, 2011, 37(9): 223-225. (in Chinese) |

| [24] |

HUNG J C, WANG C C. Exploring the website object layout of responsive Web design: results of eye tracking evaluations[J]. The Journal of Supercomputing, 2021, 77(1): 343-365. |

| [25] |

GUNST R F, MYERS R H, MONTGOMERY D C. Response surface methodology: process and product optimization using designed experiments[J]. Technometrics, 1996, 38(3): 285. |

2022, Vol. 48

2022, Vol. 48